Как узнать, когда сайт появится в поисковиках ? Почему сайт не отображается в поисковике Яндекс

Вы можете задаваться вопросом: почему я сделал сайт, а поисковики всё равно не видят его?

Давайте разберемся, что можно сделать.

Содержание поста

- 1 Начнем с простого: сайт полностью скрыт

- 1.1 1. Убедитесь, что поисковик знает о сайте

- 1.2 2. Проверьте файл robots.txt

- 1.3 3. Сайт может быть под фильтром

- 2 От простого к сложному: не все страницы в поиске

- 2.1 4. Неуникальные тексты

- 2.2 5. Страницы-дубликаты

- 3 Итог

Начнем с простого: сайт полностью скрыт

Если ваш сайт отсутствует в поиске и вы хотите разобраться, почему так происходит, начните с причин, которые проще всего проверить.

1. Убедитесь, что поисковик знает о сайте

Индексация наступает естественным образом, когда поисковик сам приходит на ваш сайт по ссылкам с других ресурсов.

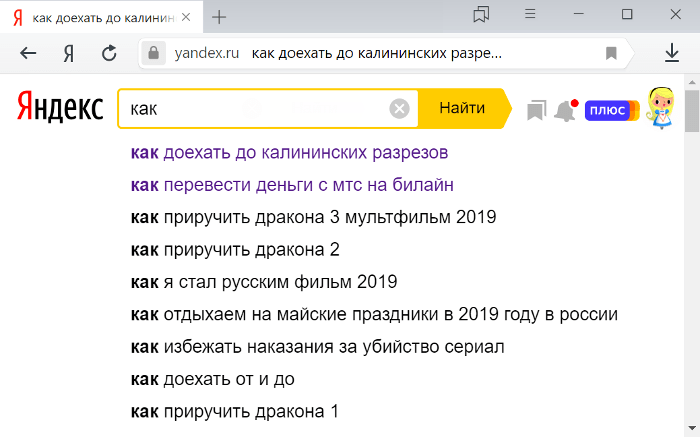

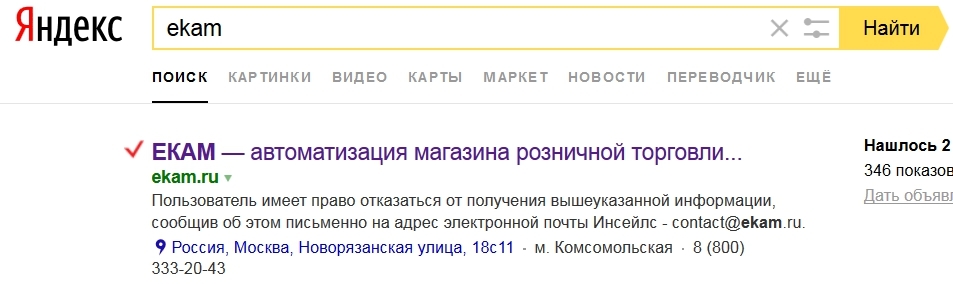

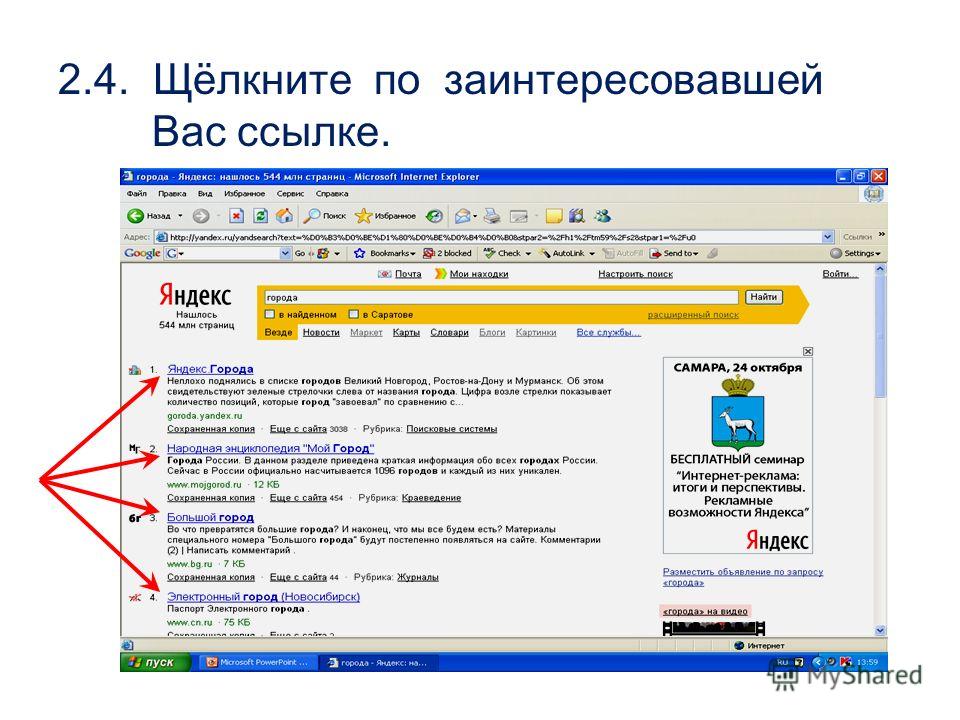

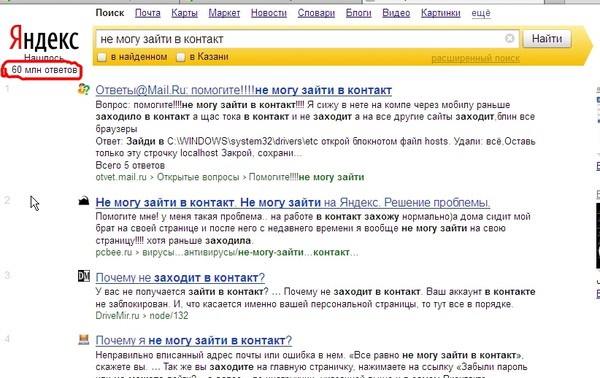

Зайдите в поисковую систему Яндекс или Google и введите в стройку поиска site:https://promoexpert.pro (вместо нашего сайта введите свой). Если выдача поиска показала страницы вашего сайта, то он проиндексирован.

Если по запросу site: в выдаче есть страницы с вашего сайта — сайт сканируетсяА можно прямым текстом сказать: «пора индексировать мой сайт!». Это делается для каждого поисковика в отдельности с помощью соответствующего сервиса:

- Сообщите Яндексу о новом сайте после регистрации в «Яндекс Вебмастер».

- Добавьте ваш сайт в сервис «Google для веб-мастеров».

Это очень полезные ресурсы. Вы сможете не только отправить запрос на индексацию сайта, но и следить за этим процессом, получать уведомления об ошибках, а также советы по улучшению технической стороны сайта.

Рекомендуем завести аккаунты и в том, и в другом сервисе.

Подпишитесь на телеграм-канал «Промо Эксперт» с Евгением Летовым

Делимся опытом в интернет-рекламе, показываем

кейсы, веселим через мемы. Публикуем бесплатные

Публикуем бесплатные

инструкции для самостоятельного продвижения.

Сообщаем о вебинарах, семинарах и конференциях.

Подписаться на канал

2. Проверьте файл robots.txt

Файл robots.txt (размещается в корневом каталоге вашего сайта: site.ru/robots.txt) предназначен для того, чтобы давать инструкции роботам-индексаторам из поисковых систем.

С его помощью вы можете скрыть страницы вашего сайта от индексации (например, личный кабинет, корзину покупателя и другие).

Однако если вы видите в robots.txt строки:

User-agent: * Disallow: /

— значит роботам запрещено посещать ваш сайт.

Дело в том, что веб-студии запрещают поисковикам заходить на ещё неготовый сайт — чтобы он был скрыт от поиска. Ведь лучше, если люди придут смотреть на готовый проект, чем на стройку. Намерения — благие.

Затем этот файл просто забывается (а иногда — оставляется из обиды и «вредности»). Заказчик не может понять, в чем же он ошибся при продвижении сайта. При этом посещаемость сайта формируется только с «визиток».

При этом посещаемость сайта формируется только с «визиток».

Срочно удалите этот файл, если он содержит только эти строки. Затем отправьте запрос на индексацию сайта из пункта 1, чтобы сайт начал отображаться в поисковиках.

Подпишитесь на телеграм-канал «Промо Эксперт» с Евгением Летовым

Делимся опытом в интернет-рекламе, показываем

кейсы, веселим через мемы. Публикуем бесплатные

инструкции для самостоятельного продвижения.

Сообщаем о вебинарах, семинарах и конференциях.

Подписаться на канал

3. Сайт может быть под фильтром

Возможно, ваш сайт по каким-то причинам попал под фильтры поисковой системы.

Если на сайт наложен стандартный фильтр (покупные ссылки, плохие тексты), то это легко узнать в разделе «Безопасность и нарушения» в Яндекс Вебмастере.

Если вы видите такую картину как на рисунке ниже, то нужен глубокий анализ. На рисунке мы видим падение трафика с поисковиков примерно в 4 раза. Раз трафик упал с обоих поисковиков — скорее всего, это не фильтр. А что-то не так с сайтом.

А что-то не так с сайтом.

Сначала нужно установить на какие страницы сайта был трафик. В системе статистики посмотрите раздел «Страницы входа» в периоде, когда трафик был в пике. Затем, если вы удалили эти страницы или стерли с них тексты, нужно всё восстановить. Как узнать, что было на старых страницах? Через Вебархив.

Если ничего непонятно — делегируйте анализ нам. Заполните форму ниже для краткого бесплатного аудита. Или читайте далее.

Подпишитесь на телеграм-канал «Промо Эксперт» с Евгением Летовым

Делимся опытом в интернет-рекламе, показываем

кейсы, веселим через мемы. Публикуем бесплатные

инструкции для самостоятельного продвижения.

Сообщаем о вебинарах, семинарах и конференциях.

Подписаться на канал

От простого к сложному: не все страницы в поиске

Теперь о случаях, которые требуют больше внимания. Что делать, если сайт лишь частично показывается в результатах?

4.

Неуникальные тексты

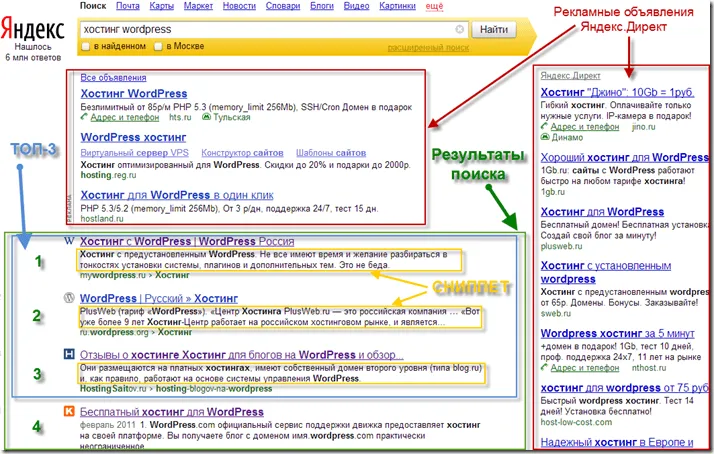

Неуникальные текстыЯндекс может наложить санкции за плохой контент. Источник Яндекс Помощь.

Чужой текст на вашем сайте

За слишком «жадное» заимствования (плагиат) поисковик может наложить санкции и исключить из выдачи.

Для разных типов текстов поисковыми системами допускается разная уникальность:

- новости и описания одинаковых товаров могут иметь уникальность порядка 50%,

- другие тексты (особенно описание услуг) должны быть уникальными на 80-90%.

Если вы заказываете тексты, проверяйте их уникальность. Например, с помощью сервиса text.ru.

Ваш текст на чужом сайте (защищаемся от Яндекса)

Google относительно добросовестно следит за авторством текстов, а Яндекс может поставить сайт плагиатора выше, чем сайт настоящего автора — обидно.

Нужно как-то объяснить Яндексу, что автор — вы.

Есть несколько способов:

- Отправить свой текст с помощью формы «Оригинальные тексты» (раздел «Содержание сайта») в Яндекс Вебмастере.

- Сделать копию публикации в социальной сети Google Plus — чтобы зафиксировать дату (помогает в общении с техподдержкой Яндекса).

- Записать CD или распечатать тексты и отправить себе на почту с уведомлением — чтобы также зафиксировать дату (может помочь даже на суде, если вскрыть конверт прямо там).

Подпишитесь на телеграм-канал «Промо Эксперт» с Евгением Летовым

Делимся опытом в интернет-рекламе, показываем

кейсы, веселим через мемы. Публикуем бесплатные

инструкции для самостоятельного продвижения.

Сообщаем о вебинарах, семинарах и конференциях.

Подписаться на канал

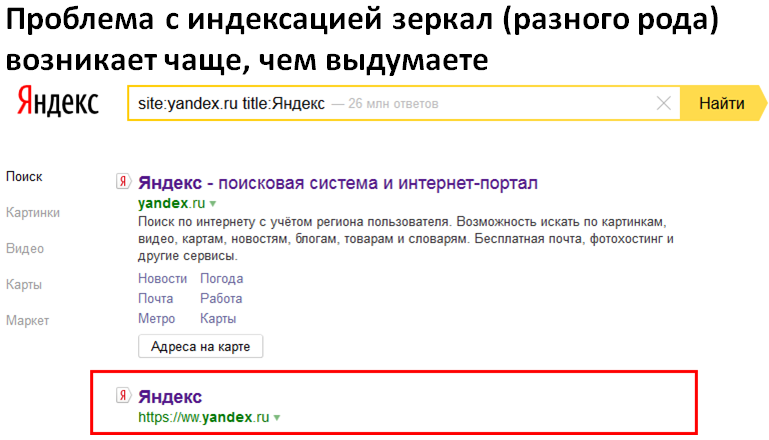

5. Страницы-дубликаты

Когда одному и тому же пользовательскому запросу релевантно больше 1 страницы, мы ставим поисковую систему перед выбором: какую страницу показать?

Поисковик разрубает этот «гордиев узел» — он выбрасывает обе страницы из выдачи. Так что с «растеканием релевантности» нужно бороться.

Как можно проверить сайт на наличие страниц-дубликатов?

- Если страниц мало, сделайте список страниц и их заголовков.

Обратите внимание на дублирующиеся значения в заголовках. Скорее всего, это и есть дубликаты. - Если страниц много (платный способ), воспользуйтесь специальным сервисом (например, SaitReport.ru).

Система SaitReport определяет дублирование контента на сайте.

После того, как вы их найдете, задайте сайту более четкую структуру. Помните, на запрос пользователя должна отвечать 1 страница (не более).

Подпишитесь на телеграм-канал «Промо Эксперт» с Евгением Летовым

Делимся опытом в интернет-рекламе, показываем

кейсы, веселим через мемы. Публикуем бесплатные

инструкции для самостоятельного продвижения.

Сообщаем о вебинарах, семинарах и конференциях.

Подписаться на канал

Итог

Мы рассмотрели 5 самых распространенных причин того, почему сайт может пропасть из поисковой выдачи.

Одинаковых сайтов нет. Каждый случай требует индивидуального подхода.

Если вы испытываете затруднения с сайтом, оставьте заявку. Мы свяжемся с вами и подскажем, как решить проблему. Это бесплатно

Мы свяжемся с вами и подскажем, как решить проблему. Это бесплатно

руководитель отдела продаж

Почему страницы исключены из поиска

Страницы сайта могут пропадать из результатов поиска Яндекса по нескольким причинам. Чтобы узнать, по какой именно причине страница исключена, перейдите в Вебмастер на страницу Индексирование → Страницы в поиске и выберите Исключённые страницы. Подробно о блоке Исключённые страницы

| Причина исключения страницы | Решение |

|---|---|

| Страница признана малоценной или маловостребованной | Алгоритм принял решение не включать страницу в поиск, поскольку у нее мало шансов оказаться востребованной пользователями. Так может произойти, например, если страница не содержит контента, дублирует уже известные роботу страницы или ее контент не вполне отвечает интересам пользователей. Это автоматический регулярный процесс, поэтому решение алгоритма может измениться. Подробно в разделе Малоценные или маловостребованные страницы. |

| Ошибка при загрузке или обработке страницы роботом — если ответ сервера содержал HTTP-статус 3XX, 4XX или 5XX | Выявить ошибку поможет инструмент Проверка ответа сервера. Если страница доступна для робота, проверьте, что:

|

| Индексирование страницы запрещено в файле robots.txt или с помощью метатега с директивой noindex | Удалите запрещающие директивы. Если вы самостоятельно не размещали запрет в файле robots. Также проверьте, не было ли блокировки доменного имени в связи с истечением срока регистрации. |

| Страница перенаправляет робота на другие страницы | Убедитесь, что исключенная страница действительно должна перенаправлять пользователей. Для этого используйте инструмент Проверка ответа сервера. |

| Страница дублирует содержание другой страницы | Если страница определена как дубль по ошибке, следуйте указаниям в разделе Дублирование страниц. |

| Страница не является канонической | Проверьте, что страницы действительно должна перенаправлять робота на URL, указанный в атрибуте rel=»canonical». |

| Сайт признан неглавным зеркалом | Если сайты объединены в группу по ошибке, следуйте рекомендациям в разделе Расклейка зеркал сайта. |

| На сайте обнаружены нарушения | Чтобы проверить это, перейдите в Вебмастере на страницу Диагностика → Безопасность и нарушения. |

Робот продолжает посещать исключенные из поиска страницы, а специальный алгоритм проверяет вероятность их показа в выдаче перед каждым обновлением поисковой базы. Таким образом, страница может появится в поиске в течение двух недель после того, как робот узнает о ее изменении.

Если вы устранили причину удаления страницы, отправьте страницу на переобход. Так вы сообщите роботу об изменениях.

Нажмите, чтобы решить проблему

Заголовки, которые запрашивает робот у сервера, отличаются от заголовков, запрашиваемых браузером. Поэтому исключенные страницы могут открываться в браузере корректно.

Если страница исключена из поиска из-за ошибки при ее загрузке, она исчезнет из списка исключенных только в том случае, если при новом обращении робота станет доступна.

Проверьте ответ сервера по интересующему вас URL. Если ответ содержит HTTP-статус 200 OK, дождитесь нового посещения робота.

Проверьте ответ сервера по интересующему вас URL. Если ответ содержит HTTP-статус 200 OK, дождитесь нового посещения робота.она недоступна для робота в течение некоторого времени;

на нее не ссылаются другие страницы сайта и внешние источники.

На странице правильно заполнены метатеги description, Keywords и элемент title, страница соответствует всем требованиям. Почему она не в поиске?

Алгоритм проверяет на страницах сайта не только наличие всех необходимых тегов, но и уникальность, полноту материала, его востребованность и актуальность, а также многие другие факторы. При этом метатегам стоит уделять внимание. Например, метатег description и элемент title могут создаваться автоматически, повторять друг друга.

При этом метатегам стоит уделять внимание. Например, метатег description и элемент title могут создаваться автоматически, повторять друг друга.

Если на сайте большое количество практически одинаковых товаров, которые отличаются только цветом, размером или конфигурацией, они тоже могут не попасть в поиск. В этот список можно также добавить страницы пагинации, подбора товара или сравнений, страницы-картинки, на которых совсем нет текстового контента.

Страницы, которые отображаются как исключенные, в браузере открываются нормально. Что это значит?

Это может происходить по нескольким причинам:

В списке «Исключенные страницы» показываются страницы, которых уже нет на сайте. Как их удалить?

На странице Страницы в поиске, в списке Исключенные страницы, отображаются страницы, к которым робот обращался, но не проиндексировал (это могут быть уже несуществующие страницы, если ранее они были известны роботу).

Страница удаляется из списка исключенных, если:

Наличие и количество исключенных страниц в сервисе не должно влиять на положение сайта в результатах поиска.

Чтобы ваш вопрос быстрее попал к нужному специалисту, уточните тему:

Страницы с разным содержанием могут считаться дублями, если отвечали роботу сообщением об ошибке (например, на сайте была установлена заглушка). Проверьте, как отвечают страницы сейчас. Если страницы отдают разное содержимое, отправьте их на переобход — так они смогут быстрее вернуться в результаты поиска.

Проверьте, как отвечают страницы сейчас. Если страницы отдают разное содержимое, отправьте их на переобход — так они смогут быстрее вернуться в результаты поиска.

Чтобы избежать исключения страниц из поиска в случае кратковременной недоступности сайта, настройте HTTP-код ответа 503.

Исключение страниц из поиска не является ошибкой со стороны сайта или индексирующего робота: исключаются страницы, которые пользователи не смогут обнаружить по запросам, поэтому их исключение не должно повлиять на видимость проиндексированных страниц сайта. Подробно см. в разделе Малоценные или маловостребованные страницы.

Напишите в службу поддержки, если:

страницы занимали высокие позиции в результатах поиска до момента их исключения;

позиции сайта после исключения страниц существенно понизились;

количестве переходов из поисковой системы значительно сократилось после исключения страниц.

Заполнить форму

Отличия поисковых систем: Google, Bing, Yandex и другие

Сэм Марсден

SEO и контент-менеджер

Давайте делиться

| 5 минут чтения

Теперь, когда мы рассмотрели основы работы поисковых систем, стоит воспользоваться этой возможностью, чтобы разобрать некоторые ключевые различия между некоторыми из основных поисковых систем: Google, Bing, Yandex и Baidu.

- Google — Google был запущен в 1998 году, и если вы не жили на другой планете, вы знаете, что Google на сегодняшний день является наиболее широко используемой поисковой системой с точки зрения объема поиска и является основным направлением для больше всего в поисковой оптимизации (SEO).

- Bing — Bing, принадлежащий Microsoft, запущен в 2009 году и занимает второе место в мире по объему поиска.

- Яндекс – Популярная поисковая система в России и крупнейшая технологическая компания в России.

- Baidu — доминирующая поисковая система, используемая в Китае, и 4-й по популярности сайт согласно рейтингу Alexa 500.

Теперь, когда вы знаете, что есть в ландшафте поисковых систем, давайте рассмотрим несколько областей, в которых они различаются.

Индексация устройств

Компания Google делает шаг к индексации, ориентированной на мобильные устройства, при которой они будут использовать мобильную версию контента сайта для ранжирования страниц с этого сайта, а не версию для ПК.

В 2018 году Google также планирует выпустить обновление скорости страницы для мобильных устройств, что означает, что скорость страницы станет фактором ранжирования в мобильном поиске.

Кристи Олсон, глава отдела евангелизации поиска Bing в Microsoft, заявила, что у них нет планов по развертыванию мобильного индекса, аналогичного Google.

Яндекс начал помечать страницы, оптимизированные для мобильных устройств, в своем индексе с ноября 2015 года, а в 2016 году внедрил алгоритм для мобильных устройств.

Алгоритм для мобильных устройств под кодовым названием считались удобными для мобильных устройств и удалялись из результатов поиска, но было заявлено, что такие страницы потенциально не будут иметь такого заметного рейтинга для пользователей поиска, использующих мобильные устройства.

«Реализация Владивостока не означает, что веб-страницы, не оптимизированные для мобильных устройств, теперь исчезнут из результатов поиска, но их позиция в SERPS может различаться в зависимости от того, выполняет ли пользователь поиск на своем мобильном или настольном компьютере»,

Результаты мобильного поиска Baidu существенно различаются в зависимости от того, считается ли страница удобной для мобильных устройств. Также стоит отметить, что Baidu использует транскодирование для преобразования веб-страниц, не оптимизированных для мобильных устройств, в страницы, созданные Baidu для мобильных устройств.

Обратные ссылки как сигнал ранжирования

Google фокусируется на качестве обратных ссылок, а не на их объеме, согласно эмпирическим и неподтвержденным данным.

Раньше считалось, что объем обратных ссылок был ключевым сигналом ранжирования, что приводило к получению большого количества низкокачественных ссылок с компаниями, покупающими обратные ссылки в ссылочных фермах и сетях.

Bing использует информацию об обратных ссылках почти так же, как и Google, в соответствии с их рекомендациями для веб-мастеров, а также в отдельных отчетах.

Руководство Bing для веб-мастеров гласит:

«Дело в том, что Bing хочет видеть качественные ссылки, ведущие на ваш сайт. Часто даже нескольких качественных внешних ссылок с надежных веб-сайтов достаточно, чтобы повысить ваш рейтинг. Как и в случае с контентом, когда дело доходит до ссылок, качество важнее всего».

Яндекс перестал использовать данные обратных ссылок в своих алгоритмах ранжирования в определенных вертикалях с 2014 года.

Примерно через год данные обратных ссылок были повторно введены в их алгоритмы, и теперь они предоставляют следующее предупреждение об использовании купленных ссылок, предназначенных для продвижения поиска. рейтинги:

«Публикация SEO-ссылок на других сайтах для продвижения собственного сайта.

К таким ссылкам относятся, в частности, ссылки, которые покупаются через биржи ссылок и агрегаторы».

Известно, что, подобно Google и Bing, Яндекс ищет качественные релевантные ссылки из авторитетных источников, но сами по себе обратные ссылки не являются решающим фактором ранжирования.

Baidu ценит обратные ссылки с веб-сайтов из Китая гораздо больше, чем с иностранных сайтов. Сообщается, что Baidu отстает от других основных поисковых систем в отношении обнаружения ссылочного спама.

Тактика ссылочного спама по-прежнему эффективна для повышения рейтинга в результатах поиска Baidu и поэтому продолжает использоваться для продвижения китайских веб-сайтов.

Социальные сети как фактор ранжирования

Google официально не использует социальные сети в качестве фактора ранжирования. Мэтт Каттс объяснил, что это связано с трудностями понимания социальной идентичности, а также с тем, что Google хочет избежать использования данных, которые могут быть неполными или вводящими в заблуждение.

Bing , с другой стороны, использует социальные сигналы как часть своих алгоритмов. Их рекомендации для веб-мастеров гласят:

«Если вы влиятельны в обществе, это приводит к тому, что ваши подписчики широко делятся вашей информацией, что, в свою очередь, приводит к тому, что Bing видит эти положительные сигналы. Эти положительные сигналы могут повлиять на ваше органическое ранжирование в долгосрочной перспективе».

Яндекс , похоже, получает некоторые ранжирующие сигналы из социальных сетей, по крайней мере, согласно неподтвержденным сообщениям.

Судя по отчетам, Baidu не использует социальные сигналы в своих алгоритмах ранжирования. Однако часто существует сильная корреляция между сайтами, занимающими видное место в Baidu, и активными учетными записями в социальных сетях.

Далее: Бюджет сканирования

Сэм Марсден

SEO и контент-менеджер

Сэм Марсден — бывший менеджер Lumar по поисковой оптимизации и контенту, а в настоящее время — руководитель отдела SEO в Busuu. Сэм регулярно выступает на маркетинговых конференциях, таких как SMX и BrightonSEO, и является автором отраслевых изданий, таких как Search Engine Journal и State of Digital.

Сэм регулярно выступает на маркетинговых конференциях, таких как SMX и BrightonSEO, и является автором отраслевых изданий, таких как Search Engine Journal и State of Digital.

Не воюйте с Яндексом

Даниил Монин, один из наставников акселератора 404 Hub, Санкт-Петербург и SEO-специалист более 10 лет, писал о продвижении контентных сайтов.

Вечная битва добра и зла всегда означает поочередное господство каждого из них. Даже в сказках, хотя добро традиционно побеждает зло, темные силы всегда имеют свои моменты триумфа. Для поисковых систем этим злом часто являются веб-мастера.

Этим объясняется появление все более требовательных и изощренных фильтров, улучшенных алгоритмов сортировки, появление новых групп факторов, позволяющих поисковым системам с большей точностью определять, достоин ли ваш сайт занимать видное место, или достоин ли он быть отфильтрованным, а затем получает нищету поискового трафика.

В прошлом году у нас с известным представителем Google состоялся диалог, который, наконец, дал мне силы высказать свое мнение — «SEO-специалисты для них лишь простая временная преграда на пути к идеальной селекции результатов поиска» .

Но так ли совершенны эти фильтры? А алгоритмы – безошибочны? И неужели больше нет уловок, которые можно использовать для того, чтобы искусственно выдвинуть проект в топ?

Достаточно взглянуть на результаты поиска Google после использования низкокомпетентного ключевого слова — очевидно, что «злая» сторона все еще в пути. Да, времена изменились – «дорвеи» в профилях форумов уже в прошлом, МФА в его классическом виде (минимальный дизайн, все для повышения CTR) практически исчезли, а найти грязный сайт с множество некачественных ссылок через высококомпетентные поисковые запросы. Зато появились дорвеи на публичных серверах, в том числе и на ютубе, МФА теперь притворяется «информационным порталом», только после изменения дизайна. И ссылки до сих пор продаются и покупаются, несмотря на расхожее мнение, что «Яндекс» больше не считает ссылки».

Итак, какие факторы сейчас наиболее важны при работе над продвижением «белого» информационного проекта?

Мы будем рассматривать «информационный проект» как сайт, наполненный статьями, который предлагает пользователю некоторую информацию, которая действительно может быть полезной, а не «купить окна ПВХ недорого Москва».

Натуральный здоровый трафик часто намного дешевле, потому что он хуже в смысле конверсии, а существующие сейчас предложения не покрывают почти 5% всей семантики.

Это, по сути, информационный сайт: место, где люди могут (и должны) наткнуться с помощью информационного поискового запроса.

Время, когда для успеха нужно было только купить много дешевых ссылок, увеличить статистический вес сайта и наполнить тексты своими ключевыми словами, уже ушло в прошлое. В нашем случае с белыми информационными сайтами наибольшую ценность имеет, по сути, поведение пользователя — как на странице результатов поиска, так и на вашем ресурсе.

Например, посетитель зашел на ваш сайт и через несколько секунд ушел — понял, что ничего интересного для него нет, возвращается на страницу результатов поиска — такой плохой результат для вас. С другой стороны, если он читает какие-то статьи, проходит по нескольким внутренним ссылкам, читает больше статей на других страницах и, наконец, оставляет какие-то комментарии — это хороший результат.

Более того, если он добавит ваш сайт в закладки, расскажет о нем в личном блоге и в соцсетях, набрав много лайков – это блестящий результат!

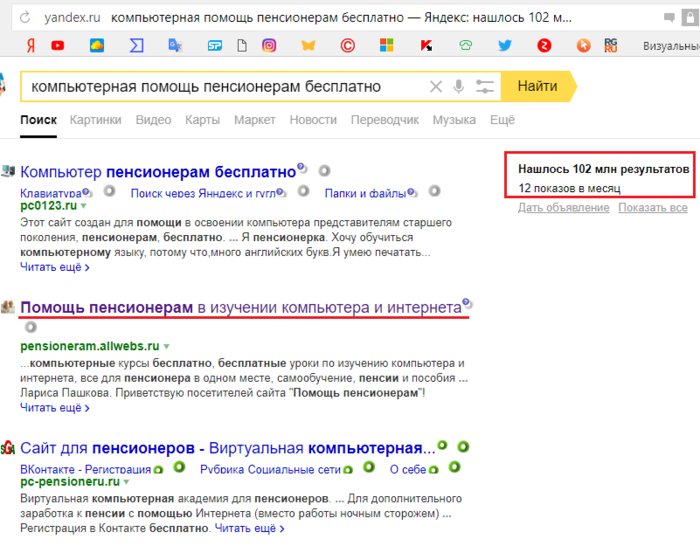

Раньше в Яндексе было десять важных групп факторов классификации (хост, URL, регион, ссылка…). Теперь самым важным фактором является поведенческий фактор (также называемый фактором удовлетворенности посетителей), который косвенно влияет на пожилых людей.

Например, вы поставили лайк — повышен социальный фактор. Вы проводите полчаса на сайте, где прочитали много статей и написали 20 комментариев — улучшился поведенческий фактор. Затем вы оставляете ссылку на сайт в своем блоге — связующий фактор. И так далее.

Но как удовлетворить посетителя, просмотревшего уже не один десяток страниц ваших конкурентов? Как сделать свой сайт источником информации? Как сохранить его?

Ответ очень простой и слишком неоригинальный. Возможно, многие из веб-мастеров уже слышали ответ «Платона Щукина» — по его словам, мы должны развивать сайт, стремясь сделать его более полезным для реальных людей. И если мы сделаем это правильно, нам не будут страшны ни «мощные» конкуренты, ни периодические всплески в поисковой выдаче.

И если мы сделаем это правильно, нам не будут страшны ни «мощные» конкуренты, ни периодические всплески в поисковой выдаче.

Давайте рассмотрим на примере, как заставить пользователя отдать предпочтение именно вашему сайту, а не тысячам конкурирующих проектов. Например, было принято решение создать информационный сайт о строительстве.

На этапе планирования необходимо поставить себя на место пользователя – и сделать это нужно до того, как вы приступите к разработке дизайна и проектированию.

Что интересно пользователю, стремящемуся «переделать ванную комнату самому»? Вроде бы ответ логичный:

- Он хочет понять, какие общие параметры говорят о реформе ванной комнаты;

- Он хочет знать, какой вариант проще, дешевле, лучше и почему;

- Он хочет увидеть, что он получит в конце;

- Он хочет научиться делать эту переделку.

Несмотря на логичный ответ, «Яндекс» предложит вам десятки сайтов, не совсем ориентированных на ответы на эти вопросы.

Пишите больше

Пишите больше, чем ваши конкуренты. Забудьте о странных конструкциях слов, которые вы получили от какого-то сервиса SEO-статистики. Забудьте о БМ-25 и TF/IDF. Текст должен быть красивым и интересным для чтения вам, тогда, скорее всего, он будет интересен и кому-то еще.

Ответить на вопросы

Несколько лет назад я участвовал в создании десятков ужасных веб-сайтов МИД. Каждая из них была заточена под очень узкую бизнес-нишу, например, мотоциклетные шлемы, выпускаемые определенной маркой (к тому же эта марка не пользовалась особой популярностью). Основная идея таких веб-сайтов заключалась в принуждении щелкнуть баннер AdSense, потому что мой посетитель просто не мог найти никакой полезной информации на моем веб-сайте, поэтому единственный вариант, который у него был, — уйти, нажав на рекламу, связанную со шлемами, о которых был мой сайт. Я активно использовал этот простой прием, создавая страницы, которые содержали много ключевого слова «обзор», помещая его в заголовки, в тексты, рассказывая своим посетителям, как круто читать отзывы о «шлемах марки x», и так далее.

Основная идея таких веб-сайтов заключалась в принуждении щелкнуть баннер AdSense, потому что мой посетитель просто не мог найти никакой полезной информации на моем веб-сайте, поэтому единственный вариант, который у него был, — уйти, нажав на рекламу, связанную со шлемами, о которых был мой сайт. Я активно использовал этот простой прием, создавая страницы, которые содержали много ключевого слова «обзор», помещая его в заголовки, в тексты, рассказывая своим посетителям, как круто читать отзывы о «шлемах марки x», и так далее.

Раньше работало. В начале поведенческих факторов, когда никто не знал, насколько плохи «вход на страницу = выход со страницы» и «время, проведенное на странице = 10 секунд». Все мои проекты МФА были успешными, но я уже знал, что очень скоро мне придется изменить свою стратегию.

Забота о пользователе

Не пытайтесь заставить посетителя понять основные моменты вашей статьи, которая даже не разбита на абзацы. Используйте соответствующие заголовки и подзаголовки, а также списки навигации, чтобы упростить понимание того, что будет обсуждаться позже. Используйте такие начальные слова, как – «Интересная часть о…», «стоит рассмотреть…», выделяя их из общего содержания.

Используйте такие начальные слова, как – «Интересная часть о…», «стоит рассмотреть…», выделяя их из общего содержания.

Предлагайте разные типы контента

Не всем хочется внимательно читать текст. Кроме того, есть несколько категорий людей, которые различаются по типу восприятия — одни через звук, другие через визуал и т. д. Многие поисковые запросы требуют разного типа контента внутри: текст, фото, видео. На некоторых участках наличия мелкого изображения явно недостаточно. Например, возвращаясь к реформам, если вы хотите отремонтировать свой забор, и делаете это впервые – вас будет интересовать тысяча мелочей. Если в статье есть десятки качественных фотографий, которые можно увеличить, то это, безусловно, сильный положительный фактор.

Не раздражайте своих гостей рекламой

Старайтесь не называть своих посетителей «трафиком» — в первую очередь они настоящие люди. У них есть свои интересы, потребности и мысли. Очевидно, что эти отвратительные дешевые объявления с неприятными изображениями принесут вам доход, но действительно ли это то, что вам нужно? Конечно, любой проект должен приносить прибыль, но этого ли вы на самом деле хотите? Ваш выбор, получать стабильную прибыль или дрожать от страха после каждого обновления «Яндекса»? Также не стоит исходить из того, что «больше текстового блока — лучше». Сделайте свои тесты, посмотрите CTR, CPM, соберите оптимальное количество блоков и их формат. Чтобы оценить полезность вашего сайта, попросите друзей посетить его. Конечно, скорее всего, вам скажут, что все в порядке, но всегда есть вероятность, что кто-то из них обратит внимание на то, что раньше не приходило вам в голову.

Очевидно, что эти отвратительные дешевые объявления с неприятными изображениями принесут вам доход, но действительно ли это то, что вам нужно? Конечно, любой проект должен приносить прибыль, но этого ли вы на самом деле хотите? Ваш выбор, получать стабильную прибыль или дрожать от страха после каждого обновления «Яндекса»? Также не стоит исходить из того, что «больше текстового блока — лучше». Сделайте свои тесты, посмотрите CTR, CPM, соберите оптимальное количество блоков и их формат. Чтобы оценить полезность вашего сайта, попросите друзей посетить его. Конечно, скорее всего, вам скажут, что все в порядке, но всегда есть вероятность, что кто-то из них обратит внимание на то, что раньше не приходило вам в голову.

И не продавайте ссылки!

Этот вид заработка начал бурно развиваться после запуска Sape. И в этот момент это сработало. Это работает и сейчас. И это будет работать какое-то время в будущем.

Но на каждый меч есть щит, так же как на каждый щит можно найти меч.

txt, обратитесь к хостинг-провайдеру или регистратору доменного имени для выяснения подробностей.

txt, обратитесь к хостинг-провайдеру или регистратору доменного имени для выяснения подробностей.