Кодирование символов : кодовая страница, ASCII

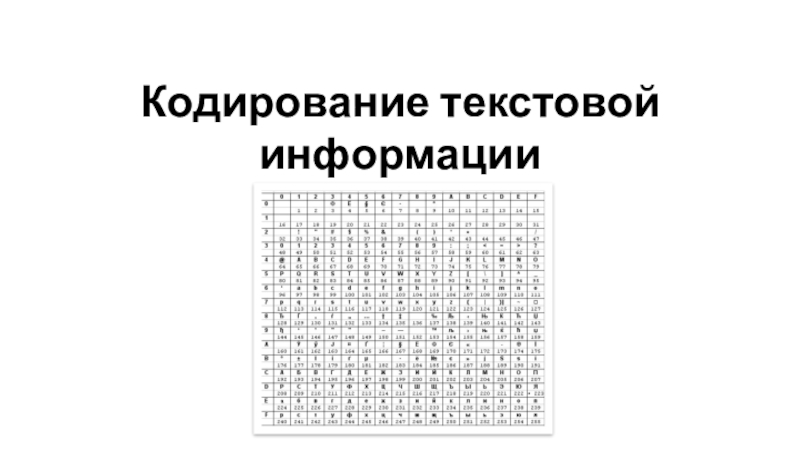

Кодировка символов (часто называемая также кодовой страницей) – это набор числовых значений, которые ставятся в соответствие группе алфавитно-цифровых символов, знаков пунктуации и специальных символов.

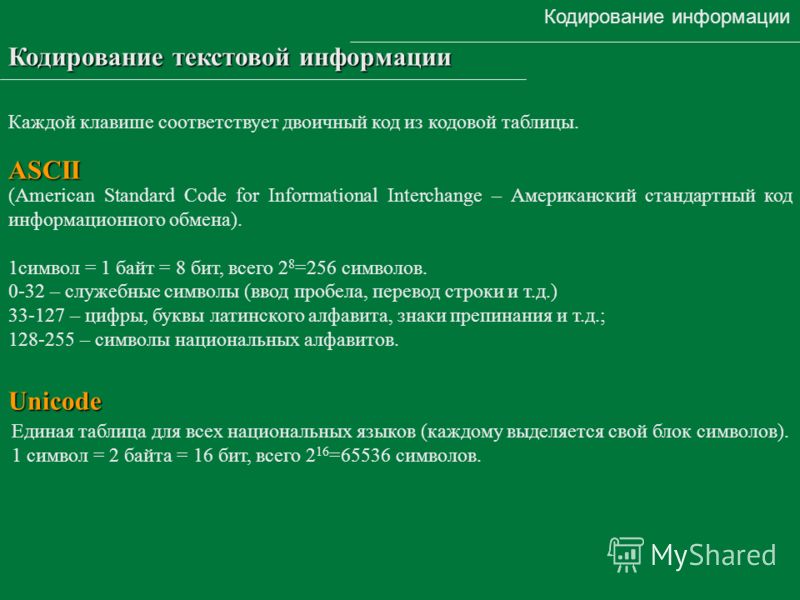

Для кодировки символов в Windows используется таблица ASCII (American Standard Code for Interchange of Information).

В ASCII первые 128 символов всех кодовых страниц состоят из базовой таблицы символов. Первые 32 кода базовой таблицы, начиная с нулевого, размещают управляющие коды.

| Символ | Код | Клавиши | Значение |

| nul | 0 | Ctrl + @ | Нуль |

| soh | 1 | Ctrl + A | Начало заголовка |

| stx | 2 | Ctrl + B | Начало текста |

| etx | 3 | Ctrl + C | Конец текста |

| eot | 4 | Ctrl + D | Конец передачи |

| 5 | Ctrl + E | Запрос | |

| ack | 6 | Ctrl + F | Подтверждение |

| bel | 7 | Ctrl + G | Сигнал (звонок) |

| bs | 8 | Ctrl + H | Забой (шаг назад) |

| ht | 9 | Ctrl + I | Горизонтальная табуляция |

| lf | 10 | Ctrl + J | Перевод строки |

| vt | 11 | Ctrl + K | Вертикальная табуляция |

| ff | 12 | Ctrl + L | Новая страница |

| cr | 13 | Ctrl + M | Возврат каретки |

| so | 14 | Ctrl + N | Выключить сдвиг |

| si | 15 | Ctrl + O | Включить сдвиг |

| dle | 16 | Ctrl + P | Ключ связи данных |

| dc1 | 17 | Ctrl + Q | Управление устройством 1 |

| dc2 | 18 | Ctrl + R | Управление устройством 2 |

| dc3 | 19 | Ctrl + S | Управление устройством 3 |

| dc4 | 20 | Ctrl + T | Управление устройством 4 |

| nak | 21 | Ctrl + U | Отрицательное подтверждение |

| syn | 22 | Ctrl + V | Синхронизация |

| etb | 23 | Ctrl + W | Конец передаваемого блока |

| can | 24 | Ctrl + X | Отказ |

| em | 25 | Ctrl + Y | Конец среды |

| sub | 26 | Ctrl + Z | Замена |

| esc | 27 | Ctrl + [ | Ключ |

| fs | 28 | Ctrl + \ | Разделитель файлов |

| gs | 29 | Ctrl + ] | Разделитель группы |

| rs | 30 | Ctrl + ^ | Разделитель записей |

| us | 31 | Ctrl + _ | Разделитель модулей |

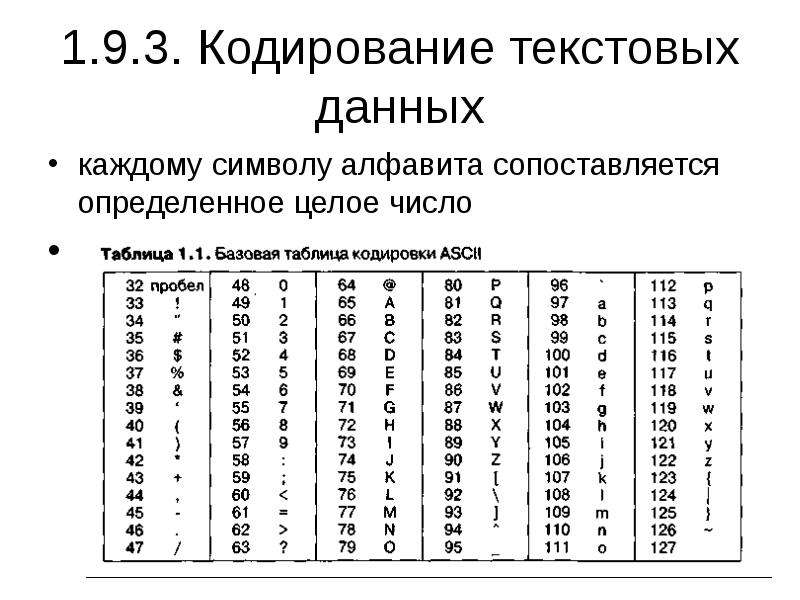

Базовая таблица кодировки ASCII

| 32 пробел | 48 0 | 64 @ | 80 P | 96 ` | 112 p |

| 33 ! | 49 1 | 65 A | 81 Q | 97 a | 113 q |

| 34 “ | 50 2 | 66 B | 82 R | 98 b | 114 r |

| 35 # | 51 3 | 67 C | 83 S | 99 c | 115 s |

| 36 $ | 52 4 | 68 D | 84 T | 100 d | 116 t |

| 37 % | 53 5 | 69 E | 85 U | 101 e | 117 u |

| 38 & | 54 6 | 70 F | 86 V | 102 f | 118 v |

| 39 ‘ | 55 7 | 71 G | 87 W | 103 g | 119 w |

| 40 ( | 56 8 | 72 H | 88 X | 104 h | 120 x |

| 41 ) | 57 9 | 73 I | 89 Y | 105 i | 121 y |

| 42 * | 58 : | 74 J | 90 Z | 106 j | 122 z |

| 43 + | 59 ; | 75 K | 91 [ | 107 k | 123 { |

| 44 , | 60 < | 76 L | 92 \ | 108 l | 124 | |

| 45 — | 61 = | 77 M | 93 ] | 109 m | 125 } |

46 . | 110 n | 126 ~ | |||

| 47 / | 63 ? | 79 O | 95 _ | 111 o | 127 |

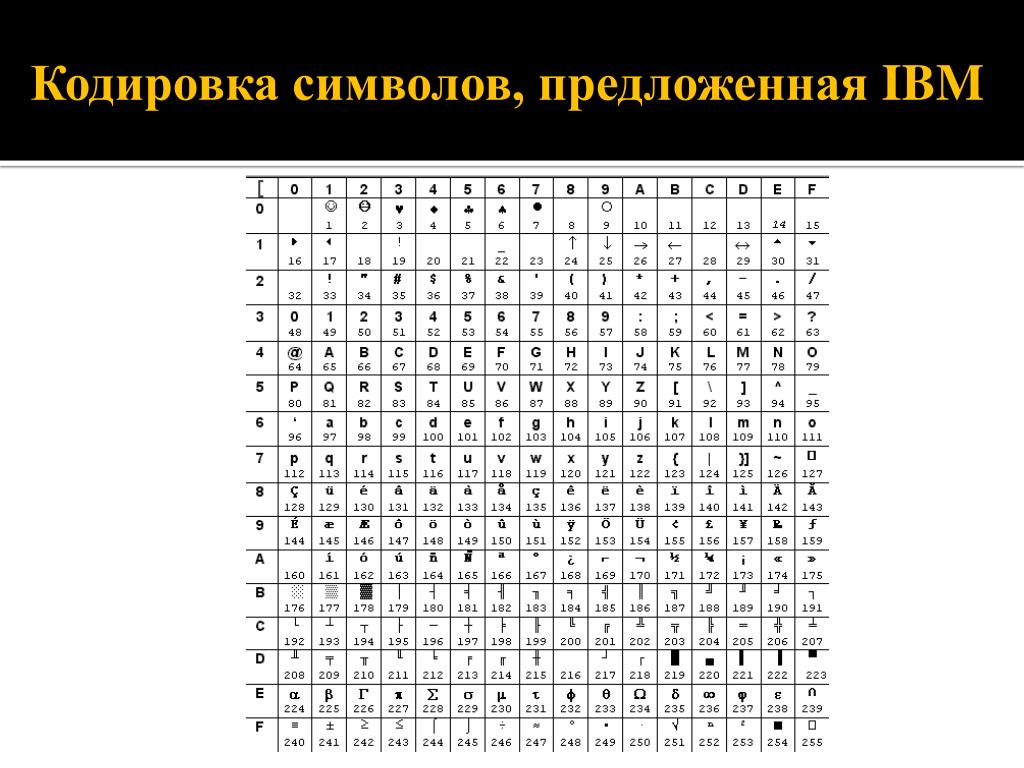

Символы с номерами от 128 до 255 представляют собой таблицу расширения и варьируются в зависимости от набора скриптов, представленных кодировкой символов. Набор символов таблицы расширения различается в зависимости от выбранной кодовой страницы:

1251 – кодовая страница Windows

| 128 Ђ | 144 Ђ | 160 | 176 ° | 192 А | 208 Р | 224 а | 240 р |

| 129 Ѓ | 145 ‘ | 161 Ў | 177 ± | 193 Б | 209 С | 225 б | 241 с |

| 130 ‚ | 146 ’ | 162 ў | 178 I | 194 В | 210 Т | 226 в | 242 т |

| 131 ѓ | 147 “ | 163 J | 179 i | 195 Г | 211 У | 227 г | 243 у |

| 132 „ | 148 ” | 164 ¤ | 180 ґ | 196 Д | 212 Ф | 228 д | 244 ф |

| 133 … | 149 • | 165 Ґ | 181 μ | 197 Е | 213 Х | 229 е | 245 х |

| 134 † | 150 – | 166 ¦ | 182 ¶ | 198 Ж | 214 Ц | 230 ж | 246 ц |

| 135 ‡ | 151 — | 167 § | 183 · | 215 Ч | 231 з | 247 ч | |

| 136 € | 152 □ | 168 Ё | 184 ё | 200 И | 216 Ш | 232 и | 248 ш |

| 137 ‰ | 153 ™ | 169 © | 185 № | 201 Й | 217 Щ | 233 й | 249 щ |

| 138 Љ | 154 љ | 170 Є | 186 є | 202 К | 218 Ъ | 234 к | 250 ъ |

| 139 < | 155 > | 171 « | 187 » | 203 Л | 219 Ы | 235 л | 251 ы |

| 140 Њ | 156 њ | 172 ¬ | 188 j | 204 М | 220 Ь | 236 м | 252 ь |

| 141 Ќ | 157 ќ | 173 | 189 S | 205 Н | 221 Э | 237 н | 253 э |

| 142 Ћ | 158 ћ | 174 ® | 190 s | 206 О | 222 Ю | 238 о | 254 ю |

| 143 Џ | 159 џ | 175 Ï | 191 ї | 207 П | 223 Я | 239 п | 255 я |

866 – кодовая страница DOS

| 128 А | 144 Р | 160 а | 176 ░ | 192 └ | 208 ╨ | 224 р | 240 ≡Ё |

| 129 Б | 145 С | 161 б | 177 ▒ | 193 ┴ | 209 ╤ | 225 с | 241 ±ё |

| 130 В | 146 Т | 162 в | 178 ▓ | 194 ┬ | 210 ╥ | 226 т | 242 ≥ |

| 131 Г | 147 У | 163 г | 179 │ | 195 ├ | 211 ╙ | 227 у | 243 ≤ |

| 132 Д | 148 Ф | 164 д | 180 ┤ | 196 ─ | 212 ╘ | 228 ф | 244 ⌠ |

| 133 Е | 149 Х | 165 е | 181 ╡ | 197 ┼ | 213 ╒ | 229 х | 245 ⌡ |

| 134 Ж | 150 Ц | 166 ж | 182 ╢ | 198 ╞ | 230 ц | 246 ¸ | |

| 135 З | 151 Ч | 167 з | 183 ╖ | 199 ╟ | 215 ╫ | 231 ч | 247 » |

| 136 И | 152 Ш | 168 и | 184 ╕ | 200 ╚ | 216 ╪ | 232 ш | 248 ° |

| 137 Й | 153 Щ | 169 й | 185 ╣ | 201 ╔ | 217 ┘ | 233 щ | 249 · |

| 138 К | 154 Ъ | 170 к | 186 ║ | 202 ╩ | 218 ┌ | 234 ъ | 250 ∙ |

| 139 Л | 155 Ы | 171 л | 187 ╗ | 203 ╦ | 219 █ | 235 ы | 251 √ |

| 140 М | 156 Ь | 172 м | 188 ╝ | 204 ╠ | 220 ▄ | 236 ь | 252 ⁿ |

| 141 Н | 157 Э | 173 н | 189 ╜ | 205 ═ | 221 ▌ | 237 э | 253 ² |

| 142 О | 158 Ю | 174 о | 190 ╛ | 206 ╬ | 222 ▐ | 238 ю | 254 ■ |

| 143 П | 159 Я | 175 п | 191 ┐ | 207 ╧ | 223 ▀ | 239 я | 255 |

Русские названия основных спецсимволов:

| Символ | Название |

| ` | гравис, кавычка, обратный машинописный апостроф |

| ` | гравис, кавычка, обратный машинописный апостроф |

| ~ | тильда |

| ! | восклицательный знак |

| @ | эт, коммерческое эт, «собака» |

| # | октоторп, решетка, диез |

| $ | знак доллара |

| % | процент |

| ^ | циркумфлекс, знак вставки |

| & | амперсанд |

| * | астериск, звездочка, знак умножения |

| ( | левая открывающая круглая скобка |

| ) | правая закрывающая круглая скобка |

| — | минус, дефис |

| _ | знак подчеркивания |

| = | знак равенства |

| + | плюс |

| [ | левая открывающая квадратная скобка |

| ] | правая закрывающая квадратная скобка |

| { | левая открывающая фигурная скобка |

| } | правая закрывающая фигурная скобка |

| ; | точка с запятой |

| : | двоеточие |

| ‘ | машинописный апостроф, одинарная кавычка |

| « | двойная кавычка |

| , | запятая |

. | точка |

| / | слэш, косая черта, знак дроби |

| < | левая открытая угловая скобка, знак меньше |

| > | правая закрытая угловая скобка, знак больше |

| \ | обратный слэш, обратная косая черта |

| | | вертикальная черта |

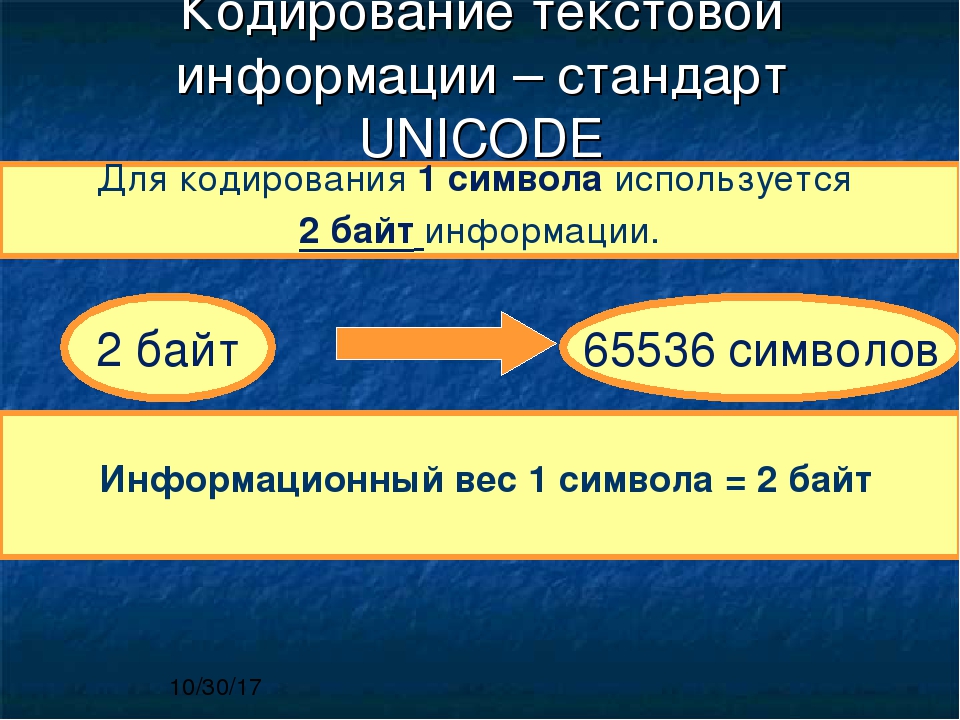

Кодировка UNICODE

Юникод (Unicode) — стандарт кодирования символов, позволяющий представить знаки практически всех письменных языков. Стандарт предложен в 1991 году некоммерческой организацией «Консорциум Юникода».

В Unicode используются 16-битовые (2-байтовые) коды, что позволяет представить 65536 символов.

Применение стандарта Unicode позволяет закодировать очень большое число символов из разных письменностей: в документах Unicode могут соседствовать китайские иероглифы, математические символы, буквы греческого алфавита, латиницы и кириллицы, при этом становится ненужным переключение кодовых страниц.

Для представления символьных данных в кодировке Unicode используется символьный тип wchar_t.

| ASCII | UNICODE |

| char | wchar_t |

| 1 байт | 2 байта |

Тип кодировки задается в свойствах проекта Microsoft Visual Studio:

Многобайтовая кодировка предполагает использование кодировки ASCII.

При этом при построении проекта используется директива условной компиляции, переопределяющая тип TCHAR:

#ifdef _UNICODE

typedef wchar_t TCHAR;

#else

typedef char TCHAR;

#endif

Для перекодирования строки в формат Unicode без изменения кодировки файла используется макроопределение

_T(«строка»)

Прототип макроса содержится в файле tchar.h.

Назад: Представление данных и архитектура ЭВМ

Кодирование текстовой информации — Кодирование информации

Кодирование текстовой информации

Одна и та же информация может быть представлена (закодирована) в нескольких

формах. C появлением компьютеров возникла необходимость кодирования всех видов

информации, с которыми имеет дело и отдельный человек, и человечество в целом.

Но решать задачу кодирования информации человечество начало задолго до

появления компьютеров. Грандиозные достижения человечества — письменность и

арифметика — есть не что иное, как система кодирования речи и числовой

информации. Информация никогда не появляется в чистом виде, она всегда как-то

представлена, как-то закодирована.

C появлением компьютеров возникла необходимость кодирования всех видов

информации, с которыми имеет дело и отдельный человек, и человечество в целом.

Но решать задачу кодирования информации человечество начало задолго до

появления компьютеров. Грандиозные достижения человечества — письменность и

арифметика — есть не что иное, как система кодирования речи и числовой

информации. Информация никогда не появляется в чистом виде, она всегда как-то

представлена, как-то закодирована.

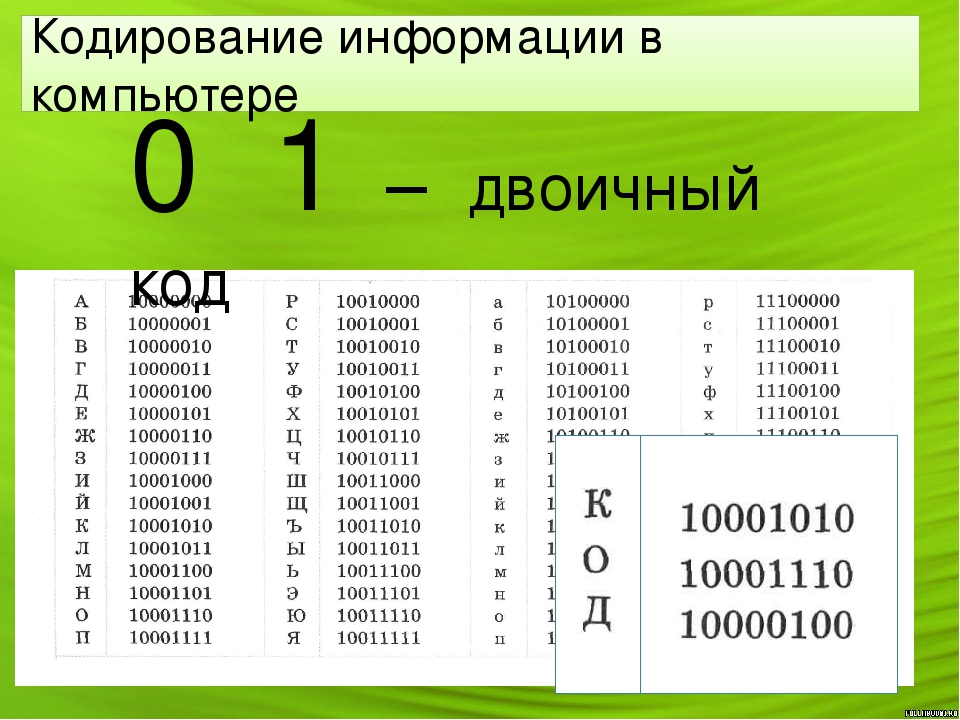

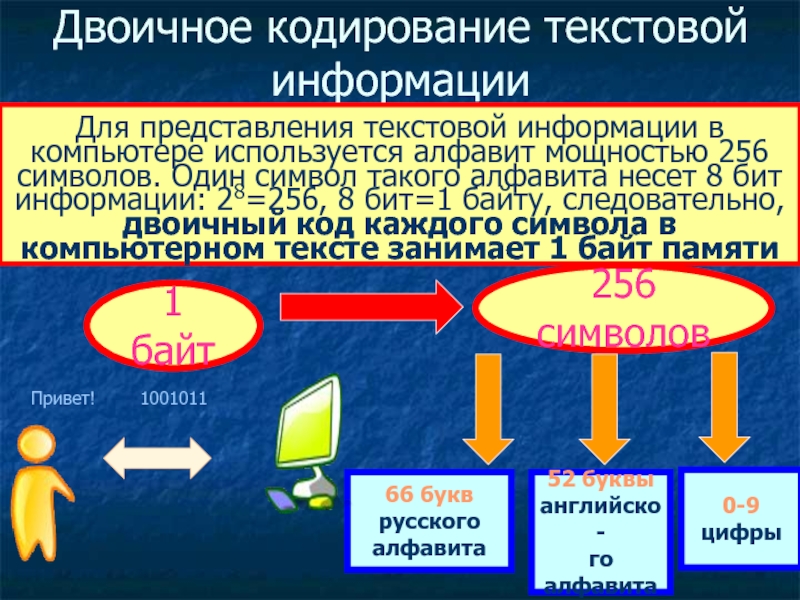

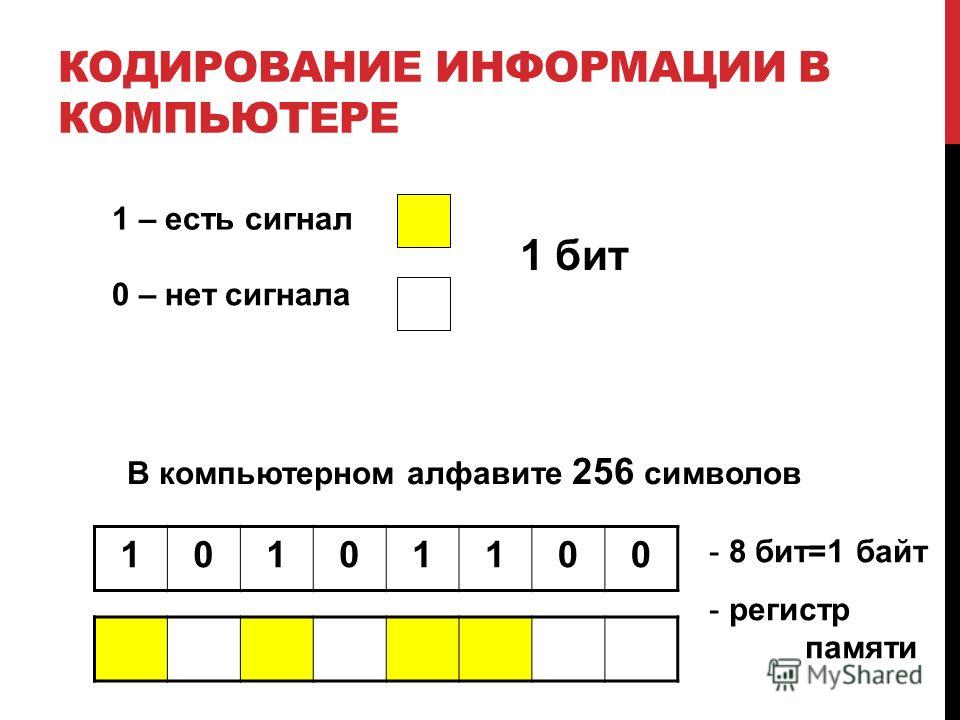

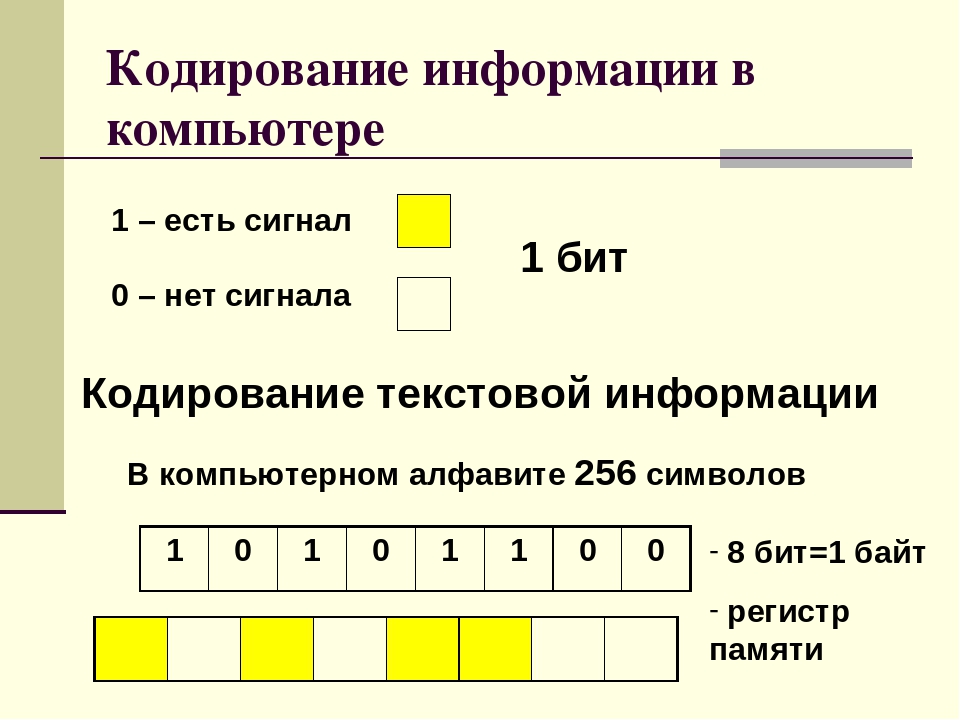

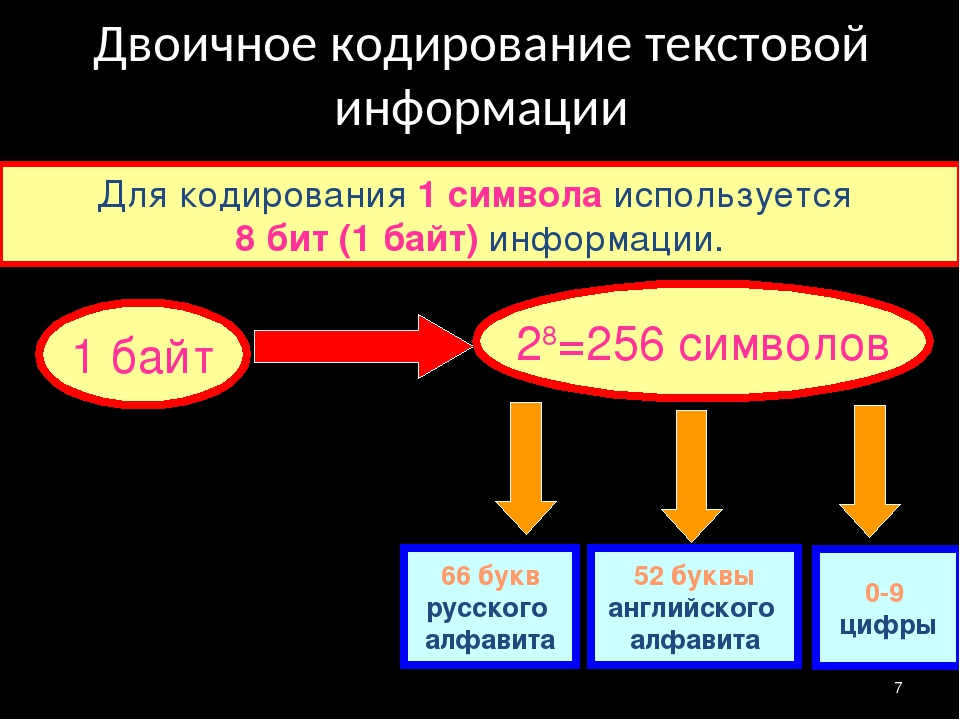

Двоичное кодирование – один из распространенных способов представления информации. В вычислительных машинах, в роботах и станках с числовым программным управлением, как правило, вся информация, с которой имеет дело устройство, кодируется в виде слов двоичного алфавита.

Начиная с конца 60-х годов, компьютеры все больше стали использоваться для

обработки текстовой информации, и в настоящее время основная доля персональных

компьютеров в мире (и большая часть времени) занята обработкой именно текстовой

информации. Все эти виды информации в компьютере представлены в двоичном коде,

т. е. используется алфавит мощностью два (всего два символа 0 и 1). Связано это

с тем, что удобно представлять информацию в виде последовательности

электрических импульсов: импульс отсутствует (0), импульс есть (1).

Все эти виды информации в компьютере представлены в двоичном коде,

т. е. используется алфавит мощностью два (всего два символа 0 и 1). Связано это

с тем, что удобно представлять информацию в виде последовательности

электрических импульсов: импульс отсутствует (0), импульс есть (1).

Такое кодирование принято называть двоичным, а сами логические последовательности нулей и единиц — машинным языком.

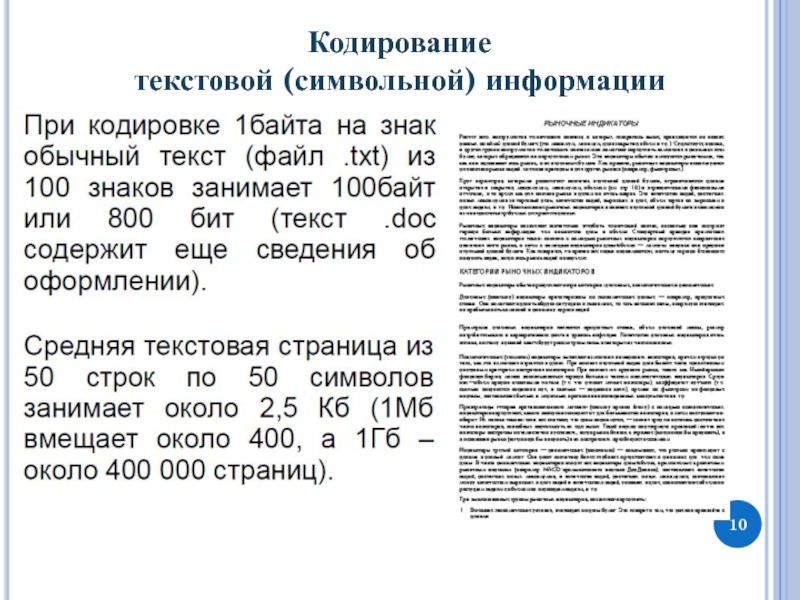

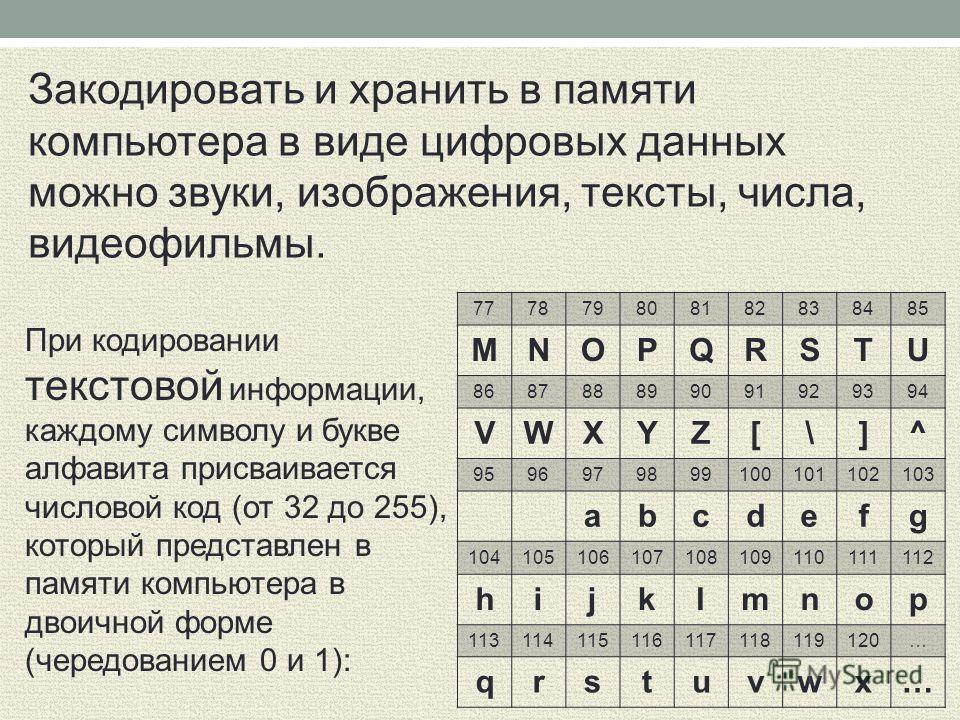

С точки зрения ЭВМ текст состоит из отдельных символов. К числу символов принадлежат не только буквы (заглавные или строчные, латинские или русские), но и цифры, знаки препинания, спецсимволы типа «=», «(«, «&» и т.п. и даже (обратите особое внимание!) пробелы между словами.

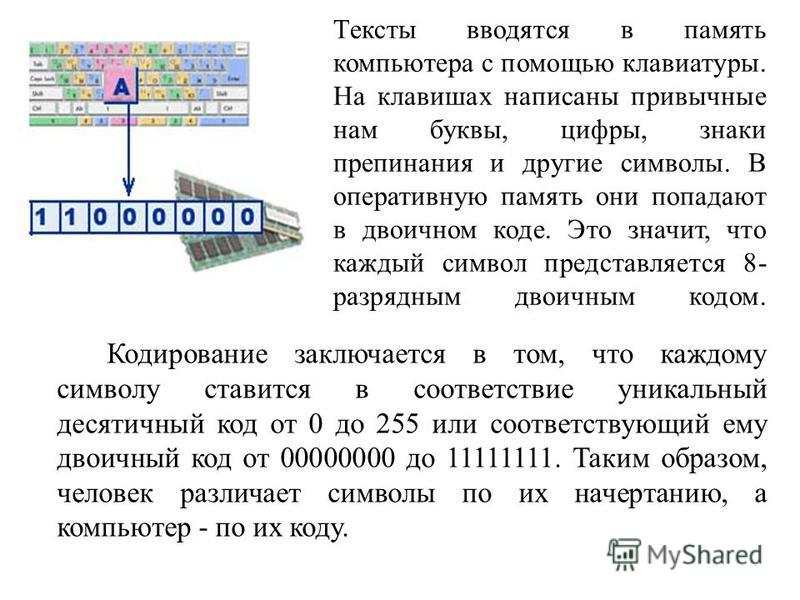

Тексты вводятся в память компьютера с помощью клавиатуры. На клавишах

написаны привычные нам буквы, цифры, знаки препинания и другие символы. В

оперативную память они попадают в двоичном коде. Это значит, что каждый символ

представляется 8-разрядным двоичным кодом.

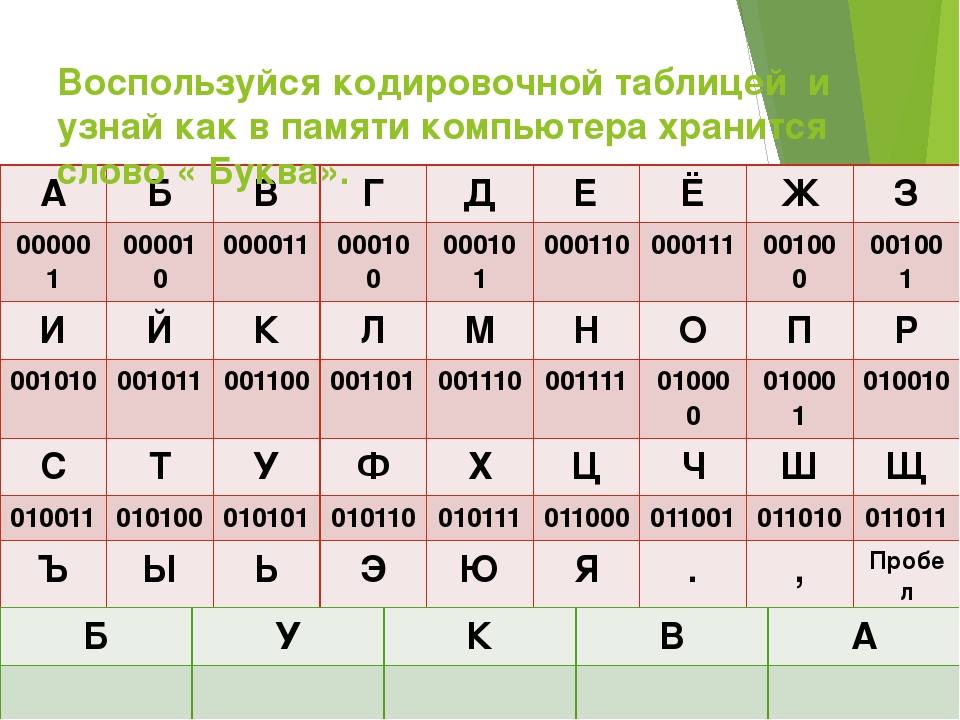

Рис.1 Представление символа в виде двоичного кода.

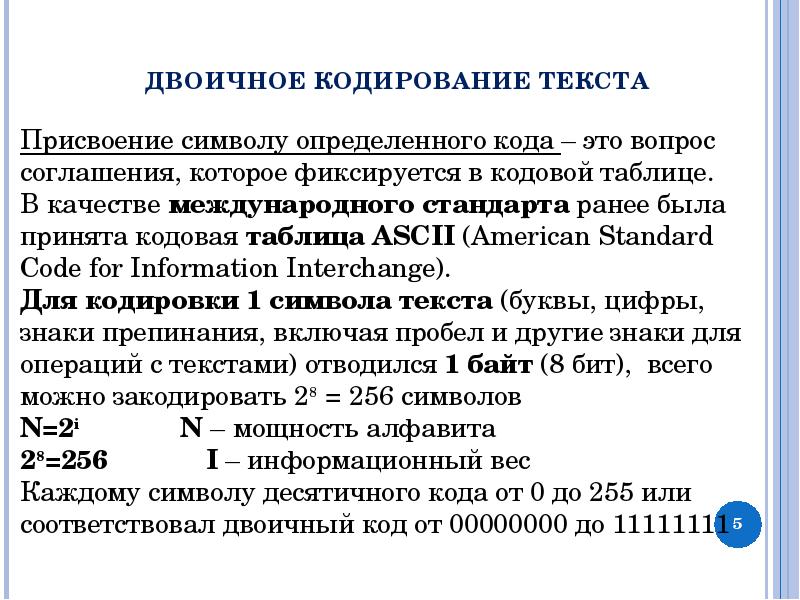

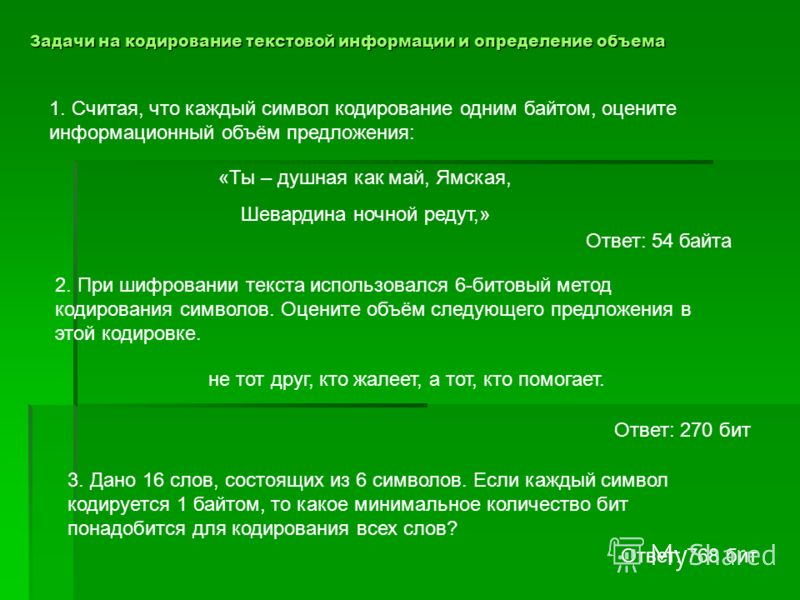

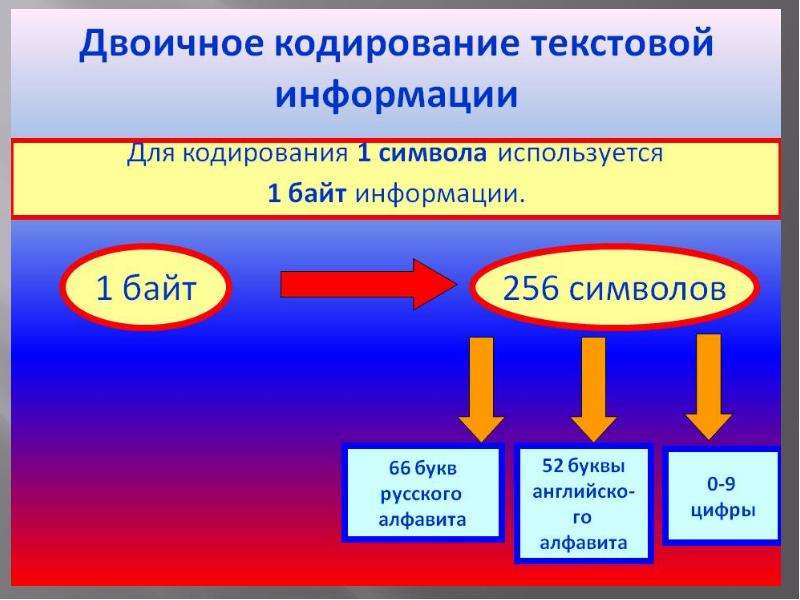

Традиционно для кодирования одного символа используется количество информации, равное 1 байту, т. е. I = 1 байт = 8 бит. При помощи формулы, которая связывает между собой количество возможных событий К и количество информации I, можно вычислить сколько различных символов можно закодировать (считая, что символы — это возможные события): К = 2I = 28 = 256, т. е. для представления текстовой информации можно использовать алфавит мощностью 256 символов.

Такое количество символов вполне достаточно для представления текстовой информации, включая прописные и строчные буквы русского и латинского алфавита, цифры, знаки, графические символы и пр.

Кодирование заключается в том, что каждому символу ставится в соответствие

уникальный десятичный код от 0 до 255 или соответствующий ему двоичный код от

00000000 до 11111111. Таким образом, человек различает символы по их

начертанию, а компьютер — по их коду.

Удобство побайтового кодирования символов очевидно, поскольку байт — наименьшая адресуемая часть памяти и, следовательно, процессор может обратиться к каждому символу отдельно, выполняя обработку текста. С другой стороны, 256 символов – это вполне достаточное количество для представления самой разнообразной символьной информации.

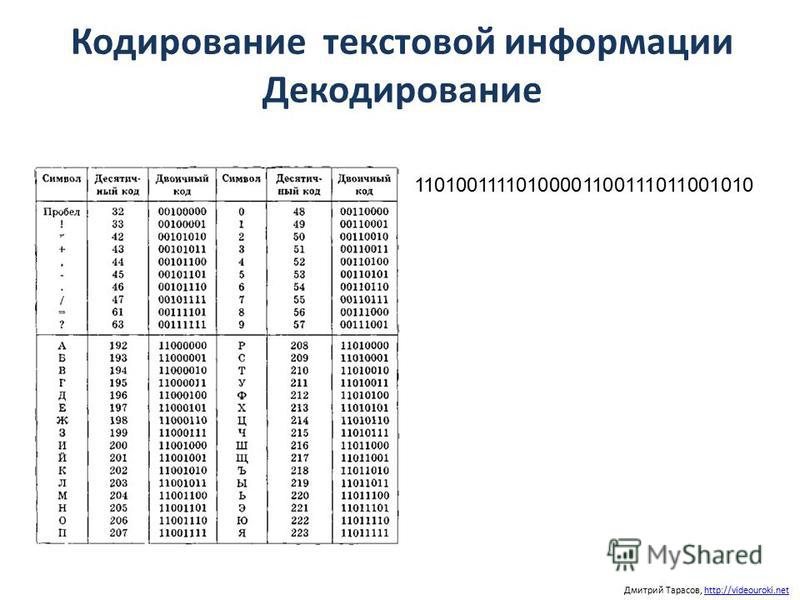

В процессе вывода символа на экран компьютера производится обратный процесс — декодирование, то есть преобразование кода символа в его изображение. Важно, что присвоение символу конкретного кода — это вопрос соглашения, которое фиксируется в кодовой таблице.

Теперь возникает вопрос, какой именно восьмиразрядный двоичный код поставить в соответствие каждому символу. Понятно, что это дело условное, можно придумать множество способов кодировки.

Все символы компьютерного алфавита пронумерованы от 0 до 255. Каждому

номеру соответствует восьмиразрядный двоичный код от 00000000 до 11111111. Этот

код просто порядковый номер символа в двоичной системе счисления.

Этот

код просто порядковый номер символа в двоичной системе счисления.

Виды таблиц кодировок

Таблица, в которой всем символам компьютерного алфавита поставлены в соответствие порядковые номера, называется таблицей кодировки.

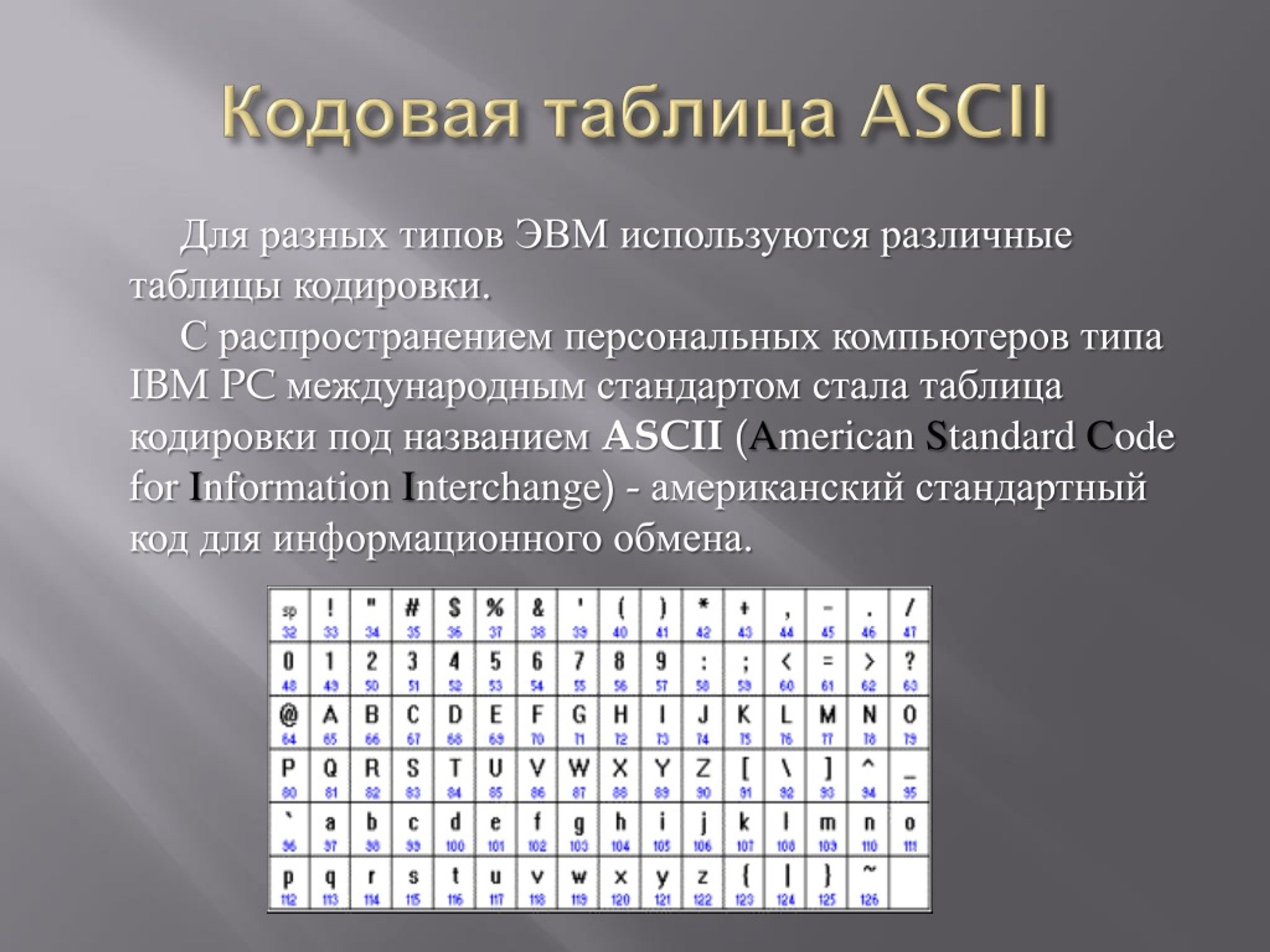

Для разных типов ЭВМ используются различные таблицы кодировки.

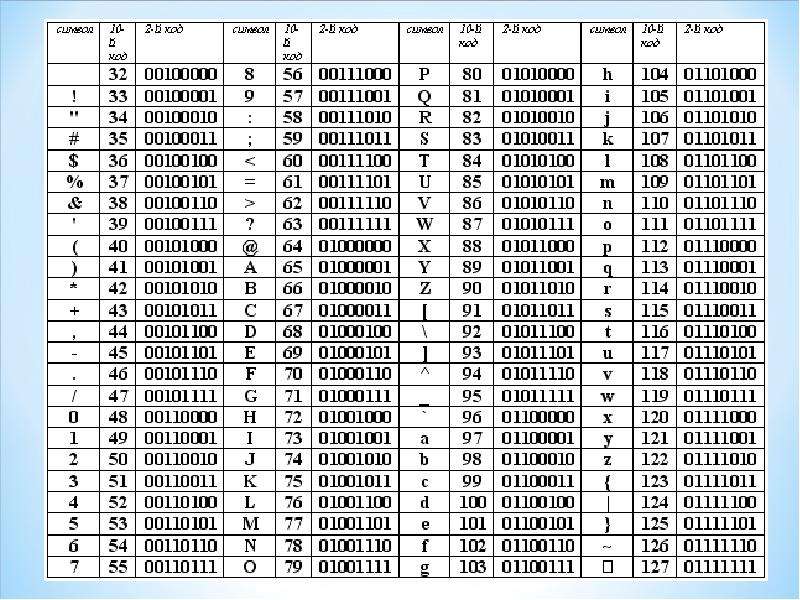

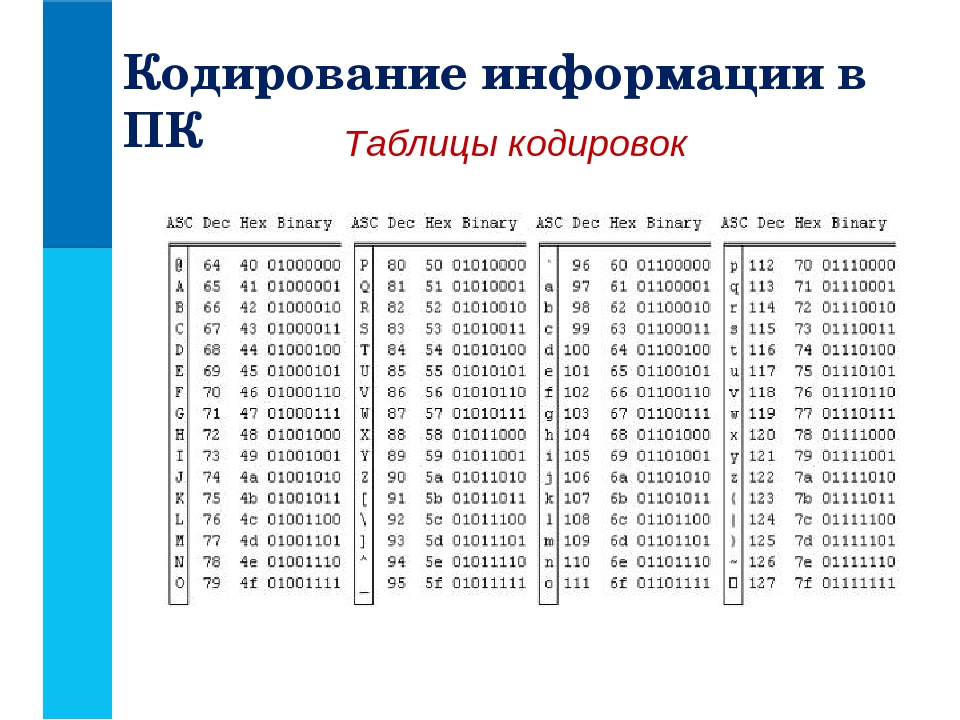

В качестве международного стандарта принята кодовая таблица ASCII (American Standard Code for Information Interchange — Американский стандартный код для информационного обмена), кодирующая первую половину символов с числовыми кодами от 0 до 127 ( коды от 0 до 32 отведены не символам, а функциональным клавишам).

Таблица кодов ASCII делится на две части.

Международным стандартом является лишь первая половина таблицы, т.е. символы с номерами от 0 (00000000), до 127 (01111111).

Структура таблицы кодировки ASCII

Порядковый номер | Код | Символ |

0 — 31 | 00000000 — 00011111 | Символы с номерами от 0 до 31 принято называть

управляющими. Их функция – управление процессом вывода текста на экран или печать, подача звукового сигнала, разметка текста и т.п. |

32 — 127 | 0100000 — 01111111 | Стандартная часть таблицы (английский). Сюда входят строчные и прописные буквы латинского алфавита, десятичные цифры, знаки препинания, всевозможные скобки, коммерческие и другие символы. Символ 32 — пробел, т.е. пустая позиция в тексте. Все остальные отражаются определенными знаками. |

128 — 255 | 10000000 — 11111111 | Альтернативная часть таблицы (русская). Вторая половина кодовой таблицы ASCII, называемая кодовой страницей (128 кодов, начиная с 10000000 и кончая 11111111), может иметь различные варианты, каждый вариант имеет свой номер. Кодовая страница в первую очередь

используется для размещения национальных алфавитов, отличных от латинского. |

Рис. 2 Первая половина таблицы кодировки ASCII.

Обращается внимание на то, что в таблице кодировки буквы (прописные и строчные) располагаются в алфавитном порядке, а цифры упорядочены по возрастанию значений. Такое соблюдение лексикографического порядка в расположении символов называется принципом последовательного кодирования алфавита.

Для букв русского алфавита также соблюдается принцип последовательного кодирования.

Рис.3 Вторая половина таблицы кодировки ASCII.

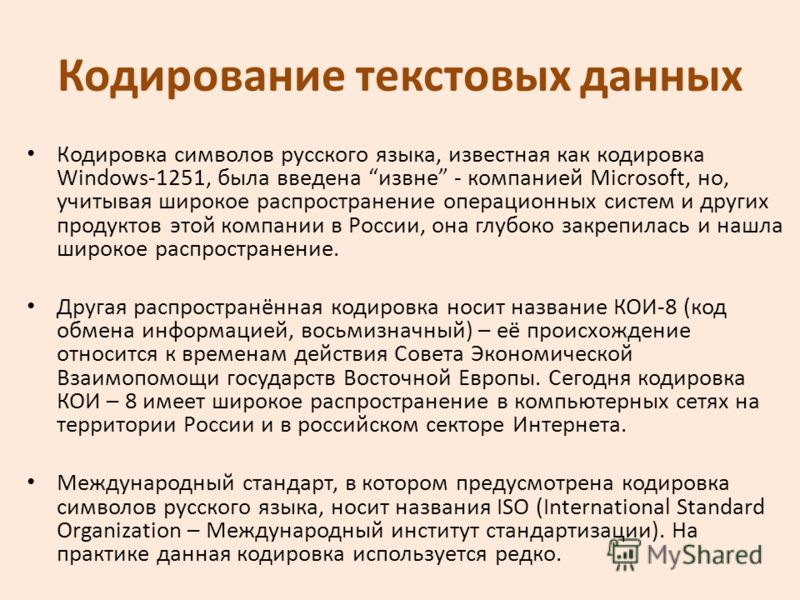

К сожалению, в настоящее время существуют пять различных кодировок кириллицы (КОИ8-Р, Windows. MS-DOS, Macintosh и ISO). Из-за этого часто возникают проблемы с переносом русского текста с одного компьютера на другой, из одной программной системы в другую.

Хронологически одним из первых стандартов кодирования русских букв на

компьютерах был КОИ8 («Код обмена информацией, 8-битный»). Эта

кодировка применялась еще в 70-е годы на компьютерах серии ЕС ЭВМ, а с

середины 80-х стала использоваться в первых русифицированных версиях

операционной системы UNIX.

Эта

кодировка применялась еще в 70-е годы на компьютерах серии ЕС ЭВМ, а с

середины 80-х стала использоваться в первых русифицированных версиях

операционной системы UNIX.

Рис.4 Кодировка КОИ8.

От начала 90-х годов, времени господства операционной системы MS DOS, остается кодировка CP866 («CP» означает «Code Page», «кодовая страница»).

Рис.5 Кодировка CP866 .

Компьютеры фирмы Apple, работающие под управлением операционной системы Mac OS, используют свою собственную кодировку Mac.

Рис.6 Кодировка Mac.

Кроме того, Международная организация по стандартизации (International Standards Organization, ISO) утвердила в качестве стандарта для русского языка еще одну кодировку под названием ISO 8859-5.

Рис. 7 Кодировка ISO 8859-5.

Наиболее распространенной в настоящее время является кодировка Microsoft

Windows, обозначаемая сокращением CP1251. Введена компанией Microsoft; с учетом

широкого распространения операционных систем (ОС) и других программных

продуктов этой компании в Российской Федерации она нашла широкое

распространение.

Рис. 8 Кодировка CP1251.

С конца 90-х годов проблема стандартизации символьного кодирования решается введением нового международного стандарта, который называется Unicode.

Рис.9 Кодировка Unicode.

Это 16-разрядная кодировка, т.е. в ней на каждый символ отводится 2 байта памяти. Конечно, при этом объем занимаемой памяти увеличивается в 2 раза. Но зато такая кодовая таблица допускает включение до 65536 символов. Полная спецификация стандарта Unicode включает в себя все существующие, вымершие и искусственно созданные алфавиты мира, а также множество математических, музыкальных, химических и прочих символов.

Внутреннее представление слов в памяти компьютера

с помощью таблицы ASCII

Слова | Память |

file | 01100110 01101001 01101100 01100101 |

disk | 01100100 01101001 01110011 01101011 |

Иногда бывает так, что текст, состоящий из букв русского алфавита,

полученный с другого компьютера, невозможно прочитать — на экране монитора

видна какая-то «абракадабра». Это происходит оттого, что на

компьютерах применяется разная кодировка символов русского языка.

Это происходит оттого, что на

компьютерах применяется разная кодировка символов русского языка.

Рис. 10.

Таким образом, каждая кодировка задается своей собственной кодовой таблицей. Как видно из таблицы, одному и тому же двоичному коду в различных кодировках поставлены в соответствие различные символы.

Например, последовательность числовых кодов 221, 194, 204 в кодировке СР1251 образует слово «ЭВМ» (Рис. 10), тогда как в других кодировках это будет бессмысленный набор символов.

К счастью, в большинстве случаев пользователь не должен заботиться о перекодировках текстовых документов, так как это делают специальные программы-конверторы, встроенные в приложения.

Проверка кодировки символов используя валидатор

Проверка кодировки символов используя валидаторIntended audience:

пользователи, шифровальщики XHTML/HTML (используя редакторы или скрипты), разработчики скриптов (PHP, JSP, и т.д.), Менеджеры веб-проектов, и каждый, кто хочет узнать, как проверить кодировку символов документа.

Как я могу проверить правильно ли кодирование символов моего документа используя W3C HTML Валидатор?

Чтобы убедиться, что все получатели документа могут его правильно отобразить и интерпретировать, очень важно правильно указать кодировку символов (‘charset’). Один из способов это проверить — использовать W3C Сервис Проверки Разметки. Валидатор обычно определяет кодировку символов с HTTP заголовков и информации в документе. Если валидатор не в состоянии обнаружить кодировку, то её можно будет выбрать на странице результатов валидатора с помощью раскрывающегося меню ‘Кодировка’ (пример).

Но часто, валидатор не жалуется, даже если обнаруженное или избранное неправильное кодирование. Причина этого в том, что много кодировок очень похожи, а валидатор проверяет только синтаксис разметки и не может решить имеет ли смысл декодированный текст или нет. Чтобы убедиться, что вы имеете правильное кодирование, которое означает, что документ будет корректно отображаться для читателей, используйте следующие пункты:

Если выбранные или обнаруженые кодирования:

US-ASCII,UTF-8,UTF-16, илиiso-2022-jp(Japanese JIS), и валидатор не жалуется на проблемы с кодировкой, то есть очень высокая вероятность того, что кодирование избранное правильно. Обратите внимание, что

Обратите внимание, что US-ASCIIявляется строгим подмножеством кодировкиUTF-8, и поэтому, еслиUS-ASCIIработает, тоUTF-8также будет работать.Для любого другого кодирования необходим визуальный контроль. Выберите опцию Show Source (показать источник) с Extended Interface (Расширенного интерфейса) валидатора, и проверьте правильно ли отображаются в тексте non-ASCII символы. Для страниц на иностранных языках, это, как правило, можно сделать достаточно быстро. Для страниц на Английском языке со всего несколькими non-ASCII символамы, это может быть более сложной задачей.

Например, если вы пытались интерпретировать главную страницу W3C как iso-8859-1, вам, возможно, придется пересмотреть источник почти до конца для того, чтобы найти такой текст, как ‘©’ и ‘®’ и увидеть, что это неправильный выбор. (Конечно, та страница, с самого начала указывает валидатору, что она закодирована в UTF-8, и поэтому на самом деле вам не нужно что-то еще проверять.

)

)В некоторых случаях более чем одна кодировка будет адекватно представлять символы в документе. Например, есть некоторое перекрытие между

iso-8859-1(Latin-1, Западная Европа) иiso-8859-2(Latin-2, Восточная Европа), и другие кодировки в этой серии. Если после тщательной проверки, вы не можете найти разницу, то любой выбор будет подходящим. Близкое сходство этих кодировок с точки зрения моделей байтов и с точки зрения фактически закодированных символов объясняет почему только визуальный осмотр может помочь убедиться правильное ли кодирование.Если ни одна из предложенных валидатором кодировок не работает, то вы либо имеете страницу в кодировке, которую валидатор (пока) не поддерживает, или как-то, текст в нескольких различных кодировках смешался на странице. В первом случае, напишите на validator mailing list (список рассылки валидатора) (public archive (общественный архив)), чтобы вашу кодировку символов добавили.

В последнем случае, вы должны исправить свою страницу, так как каждая Веб-страница может использовать только одну кодировку символов.

В последнем случае, вы должны исправить свою страницу, так как каждая Веб-страница может использовать только одну кодировку символов.

Валидатор не может работать без информации о кодировке потому что SGML или XML проверка основана на проверке последовательностей символов в документе, но то, что валидатор принимает в качестве входных данных — просто последовательность байтов. Знание кодирования символов позволяет валидатору превращать байты в символы. В общем, все то же самое действительно для всех других видов приемников, включая браузеры. Если символы определены не правильно, то Веб браузер будет отображать некорректную информацию.

Валидатор делает это путем преобразования из указанного кодирования в UTF-8, и использует UTF-8 внутренне. Если преобразование в UTF-8 не удается

потому, что отдельная последовательность байтов не может появиться во входной кодировоке, то валидатор выдает сообщение об ошибке. В UTF-8 для информации на входе, валидатор

проверяет действительно ли только UTF-8 последовательности байтов используются.

Обратите внимание, что визуальная проверка веб-страницы с помощью браузера без использования валидатор может провалиться, поскольку:

- Некоторые браузеры используют нестандартные способы выявления кодирования символов.

- Каждый браузер имеет настройки, которые используются для неотмеченных страниц, а если те настройки случайно будут правильной кодировкой страницы, то вы не увидите, что страница с должной информацией о кодировке не доходит.

- Кроме текста на странице, есть еще текст в атрибутах (например текст атрибута alt в

<img>), который нужно проверить.

HTML кодировки-W3Docs

Для того, чтобы браузер смог правильно отобразить текст на веб-странице, необходимо указать ее кодировку. В противном случае вместо текста на веб-странице будут отображаться непонятные символы.

Кодировку указывают в теге <meta> который находится в блоке <head>.

Пример

<head>

<meta charset="utf-8">

</head>В HTML 5 для указания кодировки используется атрибут charset: <meta charset=»utf-8″>

Рассмотрим основные виды кодировок

Кодировка ASCII¶

ASCII (American Standard Code for Information Interchange), американский стандартный кодекс для обмена информацией между компьютерными и аппаратными устройствами был придуман в 60 годах прошлого века. ASCII — 7-битная кодовая таблица, которая содержит 128 символов (цифры от 1 до 9, прописные и строчные латинские буквы, специальные символы). Современные системы кодировки, такие как ISO-8859 и UTF-8, разработаны на основе ASCII.

ASCII — 7-битная кодовая таблица, которая содержит 128 символов (цифры от 1 до 9, прописные и строчные латинские буквы, специальные символы). Современные системы кодировки, такие как ISO-8859 и UTF-8, разработаны на основе ASCII.

Печатные символы ASCII

ANSI ¶

Со временем стандарт кодировки ASCII расширялся, появилась возможность использовать не 128, а 256 символов, которые можно закодировать в одном байте информации. Одной из расширенных версий ASCII является ANSI (American National Standards Institute). Примером ANSI-кодировки является Windows-1251, которая включает типографические символы, а также буквы алфавитов славянских народов.

ISO-8859-1¶

Организация Международных стандартов (International Standards Organization) ввела диапазон кодировок для разных языков, от ISO 8859-1 до ISO 8859-16.

В большинстве браузеров по умолчанию используется кодировка ISO-8859-1. Кодировка символов от 0 до 127 в ISO-8859-1 соответствует кодировке ASCII (цифры от 1 до 9, заглавные и строчные буквы английского алфавита и несколько спецсимволов).

В HTML 4 любая кодировка, отличная от стандарта ISO-8859-1, должна быть указана в теге <meta> .

Таблица кодов символов ISO-8859-1

<meta http-equiv="Content-Type" content="text/html;charset=ISO-8859-8">Кодировка Unicode ¶

В 1991 году был разработан универсальный стандарт кодирования Unicode Transformation Format (UTF), благодаря которому стало возможным представить знаки практически всех известных письменных языков. Разработчиками стандарта была некоммерческая организация Unicode Consortium.

Первой была разработана кодировка UTF-32, затем UTF-16, и наконец появился стандарт UTF-8.

В UTF-32 для кодирования одного символа использовалось 32 бита (4 байта), что увеличивало вес конечного файла в 4 раза. В UTF-16 вес снизился вдвое, так как для кодирования использовалось уже 16 бит, но и это было далеко не оптимальным решением. Разработанный впоследствии стандарт UTF-8 на сегодняшний день считается самым оптимальным. Для кодирования одного символа в UTF-8 используется от 1 до 4 байт. Он идеально совмещается с системами, которые используют 8-битные символы.

Для кодирования одного символа в UTF-8 используется от 1 до 4 байт. Он идеально совмещается с системами, которые используют 8-битные символы.

UTF-8 унаследовал базовую часть кодировки ASCII (128 символов), то есть для кодировки латинских символов используется 8 бит (1 байт). Все последующие символы кодируются двумя байтами и более.

HTML4 поддерживает только кодировку UTF-8. В HTML5 поддерживаются как UTF-8, так и UTF-16.

Таблица кодов символов UTF-8

Знаки с кодами от U+0400 до U+052F, от U+2DE0 до U+2DFF, от U+A640 до U+A69F кодируют символы кириллицы.

Кодирование текстовой информации

Чаще всего кодированию подвергаются тексты, написанные на естественных языках (русском, немецком и др.).

Основные способы кодирования текстовой информации

Существует несколько основных способов кодирования текстовой информации:

- графический, в котором текстовая информация кодируется путем использования специальных рисунков или знаков;

- символьный, в котором тексты кодируются с использованием символов того же алфавита, на котором написан исходник;

- числовой, в котором текстовая информация кодируется с помощью чисел.

Процесс чтения текста представляет собой процесс, обратный его написанию, в результате которого письменный текст преобразуется в устную речь. Чтение – это ничто иное, как декодирование письменного текста.

А сейчас обратите внимание на то, что существует много способов кодирования одного и того же текста на одном и том же языке.

Пример 1

Поскольку мы русские, то и текст привыкли записывать с помощью алфавита своего родного языка. Однако тот же самый текст можно записать, используя латинские буквы. Иногда это приходится делать, когда мы отправляем SMS по мобильному телефону, клавиатура которого не содержит русских букв, или же электронное письмо на русском языке за границу, если у адресата нет русифицированного программного обеспечения. Например, фразу «Здравствуй, дорогой Саша!» можно записать как: «Zdravstvui, dorogoi Sasha!».

Стенография

Определение 1

Стенография — это один из способов кодирования текстовой информации с помощью специальных знаков. Она представляет собой быстрый способ записи устной речи. Навыками стенографии могут владеть далеко не все, а лишь немногие специально обученные люди, которых называют стенографистами. Эти люди успевают записывать текст синхронно с речью выступающего человека, что, на наш взгляд, достаточно сложно. Однако для них это не проблема, поскольку в стенограмме целое слово или сочетание букв могут обозначаться одним знаком. Скорость стенографического письма превосходит скорость обычного в $4-7$ раз. Расшифровать (декодировать) стенограмму может только сам стенографист.

Она представляет собой быстрый способ записи устной речи. Навыками стенографии могут владеть далеко не все, а лишь немногие специально обученные люди, которых называют стенографистами. Эти люди успевают записывать текст синхронно с речью выступающего человека, что, на наш взгляд, достаточно сложно. Однако для них это не проблема, поскольку в стенограмме целое слово или сочетание букв могут обозначаться одним знаком. Скорость стенографического письма превосходит скорость обычного в $4-7$ раз. Расшифровать (декодировать) стенограмму может только сам стенографист.

Пример 2

На рисунке представлен пример стенографии, в которой написано следущее: «Говорить умеют все люди на свете. Даже у самых примитивных племен есть речь. Язык — это нечто всеобщее и самое человеческое, что есть на свете»:

Рисунок 1.

Стенография позволяет не только вести синхронную запись устной речи, но и рационализировать технику письма.

Замечание 1

Приведёнными примерами мы проиллюстрировали важное правило: для кодирования одной и той же информации можно использовать разные способы, при этом их выбор будет зависеть от цели кодирования, условий и имеющихся средств.

Если нам нужно записать текст в темпе речи, сделаем это с помощью стенографии; если нужно передать текст за границу, воспользуемся латинским алфавитом; если необходимо представить текст в виде, понятном для грамотного русского человека, запишем его по всем правилам грамматики русского языка.

Также немаловажен выбор способа кодирования информации, который, в свою очередь, может быть связан с предполагаемым способом её обработки.

Пример 3

Рассмотрим пример представления чисел количественной информации. Используя буквы русского алфавита, можно записать число «тридцать пять». Используя же алфавит арабской десятичной системы счисления, запишем: $35$. Допустим нам необходимо произвести вычисления. Естественно, что для выполнения расчётов мы выберем удобную для нас запись числа арабскими цифрами, хотя можно примеры описывать и словами, но это будет довольно громоздко и не практично.

Замечание 2

Заметим, что приведенные выше записи одного и того же числа используют разные языки: первая — естественный русский язык, вторая — формальный язык математики, не имеющий национальной принадлежности. Переход от представления на естественном языке к представлению на формальном языке можно также рассматривать как кодирование.

Переход от представления на естественном языке к представлению на формальном языке можно также рассматривать как кодирование.

Криптография

В некоторых случаях возникает потребность засекречивания текста сообщения или документа, для того чтобы его не смогли прочитать те, кому не положено. Это называется защитой от несанкционированного доступа. В таком случае секретный текст шифруется. В давние времена шифрование называлось тайнописью.

Определение 2

Шифрование представляет собой процесс превращения открытого текста в зашифрованный, а дешифрование — процесс обратного преобразования, при котором восстанавливается исходный текст. Шифрование — это тоже кодирование, но с засекреченным методом, известным только источнику и адресату. Методами шифрования занимается наука криптография.

Определение 3

Криптография — это наука о методах и принципах передачи и приема зашифрованной с помощью специальных ключей информации. Ключ — секретная информация, используемая криптографическим алгоритмом при шифровании/расшифровке сообщений.

Ключ — секретная информация, используемая криптографическим алгоритмом при шифровании/расшифровке сообщений.

Числовое кодирование текстовой информации

В каждом национальном языке имеется свой алфавит, который состоит из определенного набора букв, следующих друг за другом, а значит и имеющих свой порядковый номер.

Каждой букве сопоставляется целое положительное число, которое называют кодом символа. Именно этот код и будет хранить память компьютера, а при выводе на экран или бумагу преобразовывать в соответствующий ему символ. Помимо кодов самих символов в памяти компьютера хранится и информация о том, какие именно данные закодированы в конкретной области памяти. Это необходимо для различия представленной информации в памяти компьютера (числа и символы).

Используя соответствия букв алфавита с их числовыми кодами, можно сформировать специальные таблицы кодирования. Иначе можно сказать, что символы конкретного алфавита имеют свои числовые коды в соответствии с определенной таблицей кодирования.

Однако, как известно, алфавитов в мире большое множество (английский, русский, китайский и др.). Соответственно возникает вопрос, каким образом можно закодировать все используемые на компьютере алфавиты.

Чтобы ответить на данный вопрос, нам придется заглянуть назад в прошлое.

В $60$-х годах прошлого века в американском национальном институте стандартизации (ANSI) была разработана специальная таблица кодирования символов, которая затем стала использоваться во всех операционных системах. Эта таблица называется ASCII (American Standard Code for Information Interchange, что означает в переводе с английского «американский стандартный код для обмена информацией»).

В данной таблице представлен $7$-битный стандарт кодирования, при использовании которого компьютер может записать каждый символ в одну $7$-битную ячейку запоминающего устройства. При этом известно, что в ячейке, состоящей из $7$ битов, можно сохранять $128$ различных состояний. В стандарте ASCII каждому из этих $128$ состояний соответствует какая-то буква, знак препинания или же специальный символ.

В процессе развития вычислительной техники стало ясно, что $7$-битный стандарт кодирования достаточно мал, поскольку в $128$ состояниях $7$-битной ячейки нельзя закодировать буквы всех письменностей, имеющихся в мире.

Чтобы решить эту проблему, разработчики программного обеспечения начали создавать собственные 8-битные стандарты кодировки текста. За счет дополнительного бита диапазон кодирования в них был расширен до $256$ символов. Во избежание путаницы, первые $128$ символов в таких кодировках, как правило, соответствуют стандарту ASCII. Оставшиеся $128$ — реализуют региональные языковые особенности.

Замечание 3

Как мы знаем национальных алфавитов огромное количество, поэтому и расширенные таблицы ASCII-кодов представлены множеством вариантов. Так для русского языка существует также несколько вариантов, наиболее распространенные Windows-$1251$ и Koi8-r. Большое количество вариантов кодировочных таблиц создает определенные трудности. К примеру, мы отправляем письмо, представленное в одной кодировке, а получатель при этом пытается прочесть его в другой. В результате на экране у него появляется непонятная абракадабра, что говорит о том, что получателю для прочтения письма требуется применить иную кодировочную таблицу.

В результате на экране у него появляется непонятная абракадабра, что говорит о том, что получателю для прочтения письма требуется применить иную кодировочную таблицу.

Существует и другая проблема, которая заключается в том, что алфавиты некоторых языков содержат слишком много символов, которые не позволяют помещаться им в отведенные позиции с $128$ до $255$ однобайтовой кодировки.

Следующая проблема возникает тогда, когда в тексте используют несколько языков (например, русский, английский и немецкий). Нельзя же использовать обе таблицы сразу.

Для решения этих проблем в начале $90$-х годов прошлого столетия был разработан новый стандарт кодирования символов, который назвали Unicode. С помощью этого стандарта стало возможным использование в одном тексте любых языков и символов.

Данный стандарт для кодирования символов предоставляет $31$ бит, что составляет $4$ байта за минусом $1$ бита. Количество возможных комбинаций при использовании данной кодировочной таблицы очень велико: $231 = 2 \ 147 \ 483 \ 684$ (т. е. более $2$ млрд.). Это возможно стало в связи с тем, что Unicode описывает алфавиты всех известных языков, даже «мертвых» и выдуманных, включает многие математические и другие специальные символы. И все-таки информационная емкость $31$-битового Unicode слишком велика, И как следствие, наиболее часто используют именно сокращенную $16$-битовую версию ($216 = 65 \ 536$ значений), в которой представлены все современные алфавиты.

В Unicode первые $128$ кодов совпадают с таблицей ASCII.

е. более $2$ млрд.). Это возможно стало в связи с тем, что Unicode описывает алфавиты всех известных языков, даже «мертвых» и выдуманных, включает многие математические и другие специальные символы. И все-таки информационная емкость $31$-битового Unicode слишком велика, И как следствие, наиболее часто используют именно сокращенную $16$-битовую версию ($216 = 65 \ 536$ значений), в которой представлены все современные алфавиты.

В Unicode первые $128$ кодов совпадают с таблицей ASCII.

Проблема с текстом в письмах на Mac – Наши инструкции

Неверная кодировка писем в клиенте Mail в OS X

Иногда, в процессе почтовой переписки, пользователи Mac сталкиваются с проблемой, так как и текст, и даже тема письма могут быть полностью искажены, например:

ОНДПНАМЕЕ — KOI8-R

ŽŽŽāŽÝŽÝŽÖŽÔŽÚ — SO-8859-10

¬â¬ض¬ف¬ض — CP1256

Коды, обозначенные справа от нечитаных символов — это виды кодировок, с помощью которых зашифрован текст.

Причина такого отображения — искажение кодировки, которое может возникнуть в процессе переписки между двумя пользователями.

Например, вы ведете переписку с другим человеком, использующим почтовый клиент Outlook, в котором по умолчанию выставлена кодировка CP1251, в то время как почтовый клиент Mail по умолчанию использует кодировку UTF-8.

Или же отправитель копирует информацию из какого-либо другого письма или каталога, вставляет ее в свое сообщение (при этом автоматически применяется кодировка скопированного текста) и после этого начинает писать сообщение.

Текст письма можно расшифровать с помощью сервиса Декодер.

Но, чтобы избежать таких проблем в будущем, рекомендуется минимизировать возможность искажения кодировки хотя бы со своей стороны.

Есть несколько советов:

A. используйте в новых сообщениях (ответах) формат оригинала. В этом случае вы будете отправлять письма в той же кодировке, в которой они были присланы вам.

1. Откройте клиент Mail.

2. в Строке меню Apple выберите Mail > Настройки.

3. В новом окне выберите вкладку Формат.

Укажите формат сообщения как Простой текст — это отключит Rich Text форматирование и все новые сообщения по умолчанию будут составляться как простой текст (Palin Text).

Поставьте галочку напротив Использовать в сообщении формат оригинала — при ответе, ваше сообщение будет использовать ту же кодировку и тот же формат (Rich Text или Palin Text).

B. Используйте для всех писем, отправленных через почтовый клиент, кодировку UTF-8 по умолчанию.

Чтобы отправлять все письма в формате UTF-8 — достаточно вставить в вашу подпись, которую вы используете, любой специальный символ Unicode, например ✉ или ©. В таком случае для письма всегда будет применять кодировка UTF-8.

В таком случае для письма всегда будет применять кодировка UTF-8.

Посмотреть список символов и выбрать тот, который вам больше нравится, на следующей странице: http://unicode-table.com/ru/

Чтобы отредактировать вашу подпись в почтовом клиенте Mail — вы можете воспользоваться следующей инструкцией: http://help.shortcut.ru/entries/82074997-Как-добавить-подпись-в-программе-Mail-app

C. Попросите получателя проверить настройки своего почтового клиента.

Вполне вероятно, что сложности в переписке получателя могут возникать не только с вами. Вы можете выслать ему ссылку на эту инструкцию — https://shortcut.zendesk.com/hc/admin/articles/206142038

PHP: Поддерживаемые кодировки символов — Manual

В настоящее время модулем mbstring поддерживаются

следующие кодировки символов. Любая из этих кодировок символов

может быть указаны в параметре encoding функций mbstring.

Следующие кодировки символов поддерживаются в этом расширении PHP:

- UCS-4*

- UCS-4BE

- UCS-4LE*

- UCS-2

- UCS-2BE

- UCS-2LE

- UTF-32*

- UTF-32BE*

- UTF-32LE*

- UTF-16*

- UTF-16BE*

- UTF-16LE*

- UTF-7

- UTF7-IMAP

- UTF-8*

- ASCII*

- EUC-JP*

- SJIS*

- eucJP-win*

- SJIS-win*

- ISO-2022-JP

- ISO-2022-JP-MS

- CP932

- CP51932

- SJIS-mac (alias: MacJapanese)

- SJIS-Mobile#DOCOMO (alias: SJIS-DOCOMO)

- SJIS-Mobile#KDDI (alias: SJIS-KDDI)

- SJIS-Mobile#SOFTBANK (alias: SJIS-SOFTBANK)

- UTF-8-Mobile#DOCOMO (alias: UTF-8-DOCOMO)

- UTF-8-Mobile#KDDI-A

- UTF-8-Mobile#KDDI-B (alias: UTF-8-KDDI)

- UTF-8-Mobile#SOFTBANK (alias: UTF-8-SOFTBANK)

- ISO-2022-JP-MOBILE#KDDI (alias: ISO-2022-JP-KDDI)

- JIS

- JIS-ms

- CP50220

- CP50220raw

- CP50221

- CP50222

- ISO-8859-1*

- ISO-8859-2*

- ISO-8859-3*

- ISO-8859-4*

- ISO-8859-5*

- ISO-8859-6*

- ISO-8859-7*

- ISO-8859-8*

- ISO-8859-9*

- ISO-8859-10*

- ISO-8859-13*

- ISO-8859-14*

- ISO-8859-15*

- ISO-8859-16*

- byte2be

- byte2le

- byte4be

- byte4le

- BASE64

- HTML-ENTITIES (alias: HTML)

- 7bit

- 8bit

- EUC-CN*

- CP936

- GB18030

- HZ

- EUC-TW*

- CP950

- BIG-5*

- EUC-KR*

- UHC (alias: CP949)

- ISO-2022-KR

- Windows-1251 (alias: CP1251)

- Windows-1252 (alias: CP1252)

- CP866 (alias: IBM866)

- KOI8-R*

- KOI8-U*

- ArmSCII-8 (alias: ArmSCII8)

* обозначает кодировки, которые также могут использоваться в регулярных выражениях.

Любая запись в php.ini, которая принимает имя кодировки,

может также использовать значения «auto» и

«pass«.

Функции mbstring, которые принимают имя

кодировки, также могут использовать значение «auto«.

Если установлено значение «pass«,

преобразование кодировки не производится.

Если установлено значение «auto«, оно расширяется

списком кодировок, определённым в

NLS (настройках национального языка).

Например, если NLS установлен в Japanese,

предполагается, что значение будет из списка

«ASCII,JIS,UTF-8,EUC-JP,SJIS«.

Смотрите также mb_detect_order()

Определение кодировки символов

В то время как мы рассматриваем текстовые документы как строки текста, компьютеры на самом деле видят их как двоичные данные или серию нулей и единиц. Следовательно, символы в текстовом документе должны быть представлены числовыми кодами. Для этого текст сохраняется с использованием одного из нескольких типов кодировки символов.

Для этого текст сохраняется с использованием одного из нескольких типов кодировки символов.

Самыми популярными типами кодировки символов являются ASCII и Unicode. Хотя ASCII по-прежнему поддерживается почти всеми текстовыми редакторами, Unicode используется чаще, потому что он поддерживает больший набор символов.Юникод часто определяется как UTF-8, UTF-16 или UTF-32, которые относятся к различным стандартам Unicode. UTF означает «Формат преобразования Unicode», а число указывает количество битов, используемых для представления каждого символа. С первых дней вычислений символы были представлены как минимум одним байтом (8 бит), поэтому различные стандарты Unicode сохраняют символы в количестве, кратном 8 битам.

Хотя ASCII и Unicode являются наиболее распространенными типами кодировки символов, другие стандарты кодирования также могут использоваться для кодирования текстовых файлов.Например, существует несколько типов стандартов кодировки символов для конкретных языков, таких как западные, латиноамериканские, японские, корейские и китайские. В то время как западные языки используют похожие символы, восточные языки требуют совершенно другого набора символов. Следовательно, латинская кодировка не поддерживает символы, необходимые для представления текстовой строки на китайском языке. К счастью, современные стандарты, такие как UTF-16, поддерживают достаточно большой набор символов для представления как западных, так и восточных букв и символов.

В то время как западные языки используют похожие символы, восточные языки требуют совершенно другого набора символов. Следовательно, латинская кодировка не поддерживает символы, необходимые для представления текстовой строки на китайском языке. К счастью, современные стандарты, такие как UTF-16, поддерживают достаточно большой набор символов для представления как западных, так и восточных букв и символов.

Обновлено: 24 сентября 2010 г.

TechTerms — Компьютерный словарь технических терминов

Эта страница содержит техническое определение кодировки символов. Он объясняет в компьютерной терминологии, что означает кодирование символов, и является одним из многих программных терминов в словаре TechTerms.

Все определения на веб-сайте TechTerms составлены так, чтобы быть технически точными, но также простыми для понимания. Если вы сочтете это определение кодировки символов полезным, вы можете сослаться на него, используя приведенные выше ссылки для цитирования. Если вы считаете, что термин следует обновить или добавить в словарь TechTerms, отправьте электронное письмо в TechTerms!

Если вы считаете, что термин следует обновить или добавить в словарь TechTerms, отправьте электронное письмо в TechTerms!

Подпишитесь на информационный бюллетень TechTerms, чтобы получать избранные термины и тесты прямо в свой почтовый ящик. Вы можете получать электронную почту ежедневно или еженедельно.

Подписаться

Что такое кодировка символов

Кодировка символов

Кодировка символов сообщает компьютеру, как интерпретировать необработанные нули и единицы в реальные символы. Обычно это делается путем соединения цифр с символами.Слова и предложения в тексте состоят из символов, и эти символы сгруппированы в набор символов. В настоящее время существует множество различных типов кодировок символов, но чаще всего мы имеем дело с ASCII, 8-битными кодировками и кодировками на основе Unicode.

ASCII

Американский стандартный код для обмена информацией (ASCII) — это схема кодирования символов, и это был первый стандарт кодирования символов. Это код для представления английских символов в виде чисел, где каждой букве присвоен номер от 0 до 127.Большинство современных схем кодирования символов основаны на ASCII, хотя они поддерживают множество дополнительных символов. Это однобайтовая кодировка с использованием только нижних 7 бит. В файле ASCII каждый буквенный, цифровой или специальный символ представлен 7-битным двоичным числом

Это код для представления английских символов в виде чисел, где каждой букве присвоен номер от 0 до 127.Большинство современных схем кодирования символов основаны на ASCII, хотя они поддерживают множество дополнительных символов. Это однобайтовая кодировка с использованием только нижних 7 бит. В файле ASCII каждый буквенный, цифровой или специальный символ представлен 7-битным двоичным числом

ANSI

Коды ANSI (Американский национальный институт стандартов) — это стандартизированные цифровые или буквенные коды, выпущенные Американским национальным институтом стандартов для обеспечения единообразной идентификации географических объектов во всех федеральных правительственных учреждениях.Он служил координатором системы добровольной стандартизации частного сектора США более 90 лет. По сути, это расширение набора символов ASCII, поскольку оно включает все символы ASCII с дополнительными 128 кодами символов. ASCII просто определяет 7-битную кодовую страницу со 128 символами. ANSI расширяет это значение до 8 бит, и существует несколько различных кодовых страниц для символов от 128 до 255.

ANSI расширяет это значение до 8 бит, и существует несколько различных кодовых страниц для символов от 128 до 255.

Юникод

Unicode — это стандарт, который определяет внутреннюю систему кодирования текста почти во всех операционных системах, используемых в компьютерах в настоящее время, будь то Windows, Unix, Macintosh, Linux или что-то еще, потому что Unicode может обрабатывать символы практически для всех современных языков и даже некоторых древних. языков одновременно, если в системе клиента установлены шрифты для конкретного языка.

UTF

Unicode присваивает каждому символу уникальный номер или кодовую точку. Он определяет два метода сопоставления: кодировки UTF (формат преобразования Unicode) и кодировки UCS (универсальный набор символов). Кодировки на основе Unicode реализуют стандарт Unicode и включают UTF-8, UTF-16 и UTF-32 / UCS-4. Они выходят за рамки 8-битных и поддерживают почти все языки мира. UTF-8 набирает обороты как доминирующая международная кодировка в Интернете. UTF-8, UTF-16 и UTF-32, вероятно, являются наиболее часто используемыми кодировками.

UTF-8, UTF-16 и UTF-32, вероятно, являются наиболее часто используемыми кодировками.

UTF-8 — использует 1 байт для представления символов в наборе ASCII, два байта для символов в нескольких алфавитных блоках и три байта для остальной части BMP. Дополнительные символы занимают 4 байта.

UTF-16 — использует 2 байта для любого символа в BMP и 4 байта для дополнительных символов.

UTF-32 — использует 4 байта для всех символов.

Кодовая единица

Для Unicode конкретная последовательность битов называется кодовой единицей.Кодовая единица — это битовая последовательность, используемая для кодирования каждого символа репертуара.

В US-ASCII кодовая единица составляет 7 бит. В UTF-8 кодовая единица составляет 8 бит. В EBCDIC кодовая единица составляет 8 бит. В UTF-16 кодовая единица составляет 16 бит. В UTF-32 кодовая единица составляет 32 бита.

ДАЛЕЕ ….. Подключение C # к MySQL

Понимание различных типов кодирования | by Gaurav Gupta

Прежде всего, зачем нужна кодировка символов?

Кодировка символов используется, чтобы сообщить компьютеру, как интерпретировать необработанные нули и единицы в реальные символы, буквы и символы. Обычно это делается путем соединения цифр с символами. Это способ создания программного обеспечения для всех, кто использует другой язык, чем вы.

Обычно это делается путем соединения цифр с символами. Это способ создания программного обеспечения для всех, кто использует другой язык, чем вы.

Существуют различные типы кодирования, такие как ASCII, UNICODE, BASE64 и многие другие.

Обычно мы знаем, как получить двоичные числа для любого имеющегося у нас десятичного числа. Например, если мы хотим преобразовать 55 в двоичный формат, тогда это будет 110111, но как насчет символов, таких как A до Z и от a до Z, и других вещей, таких как *, (,) и $,%, которые мы используем ежедневно, как компьютер понимает все? этих персонажей? Ответ — кодировка.Кодирование гарантирует, что каждый символ представлен на компьютере.

На нашей клавиатуре каждому символу присвоено десятичное число, даже всем специальным символам, которые мы обсуждали выше. Например, A присваивается номер 65, а маленькому a — 97 и т. Д. Для всех других символов в алфавите.

Это назначение было выполнено в одном из ранее согласованных форматов 60-х, который называется форматом ASCII. Поскольку у нас есть 8 бит (1 байт) для представления всего, в ASCII у нас есть 7 бит.Это делает его до 127 символов, которые мы можем закодировать с помощью ASCII.

Поскольку у нас есть 8 бит (1 байт) для представления всего, в ASCII у нас есть 7 бит.Это делает его до 127 символов, которые мы можем закодировать с помощью ASCII.

64 32 16 8 4 2 1

Итак, если вы хотите показать капитал, которому присвоено 65, как вы представляете его в двоичном формате? Простой

1000001

и C? 1000011

Вы можете увидеть список полной таблицы ASCII здесь. Таблица ASCII

Это упрощает кодирование и представление английских и других специальных символов, потому что теперь вы можете преобразовать любой символ в понятный компьютеру двоичный код, который представлен с использованием ASCII. символы.

По мере того, как люди стали больше пользоваться компьютерами и захотели общаться, этого было недостаточно, чтобы каждый во всем мире представлял своих персонажей на компьютере. ASCII представлял только английские символы.

Проблема действительно началась, когда вы хотели сказать закодировать арабский, японский, китайский и многие другие языки.

Затем появился UNICODE, который мог представлять гораздо больше символов, или вы могли произносить все возможные символы на всех языках мира.UNICODE может использовать больше бит, чем ASCII (всего 6 бит). В UNICODE у вас есть 8, 16 и 32 бит. Это дает нам возможность использовать около миллиарда символов и отображать их в компьютере. UNICODE обратно совместим, например, если он использует символы ASCII до 127. Если вы используете кодировку UNICODE и используете букву A, тогда это будет десятичное число 65 или 1000001 в двоичном формате.

Base64 — это способ кодирования двоичных данных в набор символов ASCII, известный практически каждой компьютерной системе. Примеры почтовых систем не могут работать с двоичными данными, потому что они ожидают текстовые данные ASCII.Поэтому, если вы хотите передать изображение или другой файл, он будет поврежден из-за способа обработки данных.

Большая часть компьютерных систем хранит данные в байтах, что составляет 8 бит на байт, поэтому ASCII становится непригодным для передачи такого рода данных. Эти данные могут быть повреждены. Система может стереть 8-й бит, что может повредить все данные, которые вы хотите отправить. Для решения этих проблем была введена кодировка Base64. Это позволяет вам кодировать произвольные байты в байты, которые, как известно, безопасно отправлять без повреждения.

Эти данные могут быть повреждены. Система может стереть 8-й бит, что может повредить все данные, которые вы хотите отправить. Для решения этих проблем была введена кодировка Base64. Это позволяет вам кодировать произвольные байты в байты, которые, как известно, безопасно отправлять без повреждения.

Если мы хотим закодировать этот пример теста в base64:

Строка: «Это тест кодирования в base64»

Кодировка Base64: VGhpcyBpcyBlbmNvZGluZyB0ZXN0IGluIGJhc2U2NA ==

Кодировка Base64 разбивает поток двоичных данных на 6-битный поток из 3 полных байтов и представляет их как печатаемые символы ASCII в стандарте ASCII.

Таблица кодировки base64 начинается с A-Z, a-z, 0–9 и +, / и дополнения, которое составляет =

26 + 26 + 10 + 2 = 64 символа, поэтому это называется кодировкой base64.

Предположим, что у нас есть строка с именем «Dog», и нам нужно преобразовать ее в строку в кодировке base64.

- Необходимо преобразовать строку ASCII «Собака» в числа ASCII

- Необходимо преобразовать эти числа в двоичное, которое становится

- Эти двоичные потоки единиц и нулей делятся на подмножество по 6 бит каждый.

- Шестизначный двоичный поток преобразуется между двоичными символами или основанием 2 в десятичные символы основанием 10 путем возведения в квадрат каждого значения, представленного 1 в двоичной последовательности, с его позиционным квадратом. Это в основном то же самое, что и преобразование двоичных 8 битов в десятичные, но здесь масштаб равен 6 битам. Таким образом, мы будем рассматривать только следующие

Таким образом, представление ASCII Dog в base64 — это RG9n.

Помните, что Base64 кодирует 24 бита кусками по 6 бит, что равняется 6 символам base64.Группа, в которой 4 символа не завершаются, мы будем использовать = для завершения набора символов из 4

различных типов схем кодирования — Праймер

Как разработчик программного обеспечения и особенно как веб-разработчик, вы, вероятно, каждый день видите / используете разные типы кодирования. Я знаю, что постоянно сталкиваюсь с самыми разными кодировками. Однако, поскольку кодирование никогда не является центральным понятием, его часто замалчивают, и иногда может возникнуть путаница, какая кодировка какая и когда каждая из них актуальна. Что ж, чтобы избавиться от путаницы раз и навсегда, вот краткое руководство по различным типам схем кодирования, с которыми вы, вероятно, столкнетесь, и о том, когда каждая из них актуальна.

Что ж, чтобы избавиться от путаницы раз и навсегда, вот краткое руководство по различным типам схем кодирования, с которыми вы, вероятно, столкнетесь, и о том, когда каждая из них актуальна.

Кодировка HTML

КодировкаHtml в основном используется для представления различных символов, чтобы их можно было безопасно использовать в документе HTML (как следует из названия). Как вы знаете, существуют различные символы, которые являются частью самой разметки HTML (например, <,> и т. Д.). Чтобы использовать их в документе в качестве содержимого, вам необходимо закодировать их в HTML.Есть два способа кодирования символов HTML.

Кодировка HTML определяет несколько объектов для представления символов, которые могут быть частью разметки, например:

”-” ‘- ' > -> <- < & - &

Вы также можете кодировать HTML любой символ, используя его код ASCII, добавив к нему префикс & #, а затем используя десятичное значение ASCII или добавив к нему префикс & # x и используя шестнадцатеричное значение ASCII, например:

’- ' <- < > -> ‘-"

Итак, каждый раз, когда вам нужно закодировать символы в самом html-документе, это способы сделать это. Иногда его путают с кодировкой URL, которая несколько отличается.

Иногда его путают с кодировкой URL, которая несколько отличается.

Кодировка URL

При работе с URL-адресами они могут содержать только печатаемые символы ASCII (это символы с кодами ASCII от 32 до 126 в десятичной системе, т.е. шестнадцатеричные 0x20 - 0x7E). Однако некоторые символы в этом диапазоне могут иметь особое значение в URL-адресе или в протоколе HTTP. Кодирование URL-адресов вступает в игру, когда мы либо имеем в URL-адресе некоторые символы со специальным значением, либо хотим, чтобы символы выходили за пределы диапазона печати.Чтобы URL-адрес закодировал символ, мы просто префикс его шестнадцатеричного значения с помощью%, например:

% -% 25 пробел -% 20 вкладка -% 09 = -% 3D

Обратите внимание, что как часть схемы кодирования URL-адреса вы также можете представить пробел с помощью +. Это часто путают с кодировкой Unicode из-за того, что обе начинаются с%, однако кодировка Unicode немного сложнее.

Кодировка Unicode

Кодировку Unicode можно использовать для кодирования символа из любого языка или системы письма в мире. Кодирование Unicode включает в себя несколько схем кодирования.

Кодирование Unicode включает в себя несколько схем кодирования.

16-битная кодировка Unicode в чем-то похожа на кодировку URL (поэтому их иногда можно спутать). Чтобы закодировать символ в 16-битном Unicode, вы начинаете с% u, а затем добавляете кодовую точку символа Unicode, который вы хотите кодировать. Кодовая точка - это, по сути, всего лишь 4-значное шестнадцатеричное число, которое соответствует определенному символу, который вы пытаетесь представить в соответствии со стандартом Unicode (как вы можете себе представить, их много, посмотрите) e.грамм.:

@ -% u0040 ∞ (бесконечность) -% u221E

UTF-8 - это еще один тип кодировки Unicode, в котором для представления каждого символа используется один или несколько байтов. Когда нам нужно кодировать символы UTF-8 для передачи по HTTP, мы просто добавляем к каждому байту представления UTF-8 префикс%. Вы можете найти представления различных символов в кодировке UTF-8, перейдя по той же ссылке, что и выше.

± (плюс минус) -% c2% b1 © (авторское право) -% c2% a9

Как вы понимаете, о Unicode можно сказать гораздо больше, но это лишь краткое руководство, так что я оставлю это на ваше усмотрение, чтобы вы узнали больше сами.

Кодировка Base64

Это весело, и о нем всегда полезно знать. Base64 используется для представления двоичных данных с использованием только печатаемых символов. Обычно он используется в базовой HTTP-аутентификации для кодирования учетных данных пользователя, он также используется для кодирования вложений электронной почты для передачи по SMPT. Кроме того, кодировка Base64 иногда используется для передачи двоичных данных внутри файлов cookie и других параметров, а также часто просто используется для того, чтобы сделать различные данные нечитаемыми (или менее легко читаемыми), чтобы предотвратить легкое вмешательство.

Base64 рассматривает данные в блоках по 3 байта, что составляет 24 бита. Эти 24 бита затем делятся на 4 фрагмента по 6 бит в каждом, и каждый из этих фрагментов затем преобразуется в соответствующее ему значение base64. Поскольку он имеет дело с 6-битными фрагментами, каждый фрагмент может отображать 64 возможных символа (отсюда и название). Если конец кодируемой строки содержит менее 3 символов (что означает, что мы можем сделать 4 символа base64), то мы создаем столько символов base64, сколько можем, и дополняем остальные символы =.Вы можете ознакомиться с алфавитом с основанием 64 здесь, а также во многих других местах. Давайте посмотрим на быстрый пример.

Поскольку он имеет дело с 6-битными фрагментами, каждый фрагмент может отображать 64 возможных символа (отсюда и название). Если конец кодируемой строки содержит менее 3 символов (что означает, что мы можем сделать 4 символа base64), то мы создаем столько символов base64, сколько можем, и дополняем остальные символы =.Вы можете ознакомиться с алфавитом с основанием 64 здесь, а также во многих других местах. Давайте посмотрим на быстрый пример.

Если мы хотим преобразовать слово «торт» в основание 64, мы просто преобразуем каждый из символов в его десятичное значение ASCII, а затем получаем двоичное значение каждого десятичного значения. В нашем случае:

торт = 01100011011000010110101101100101

Теперь нам нужно разбить нашу двоичную строку на блоки по 6 бит каждый, и, поскольку каждые 3 символа должны составлять 4 символа base64, мы можем дополнить его нулями, если нам не хватает:

011000 110110 000101 101011 011001 010000 000000 000000

Теперь мы конвертируем каждое из 6-битных двоичных значений в соответствующий ему символ, а в случае нулевого значения мы используем символ заполнения (=). В нашем случае получаем:

В нашем случае получаем:

Y2FrZQ ==

Значение слова «торт» в кодировке base64.

КодировкуBase64 обычно довольно легко обнаружить, поскольку она выглядит довольно характерно, особенно когда она содержит символы-заполнители (=) в конце строки.

Шестнадцатеричное кодирование

Этот простой, вроде как :). В основном с шестнадцатеричным кодированием мы просто используем шестнадцатеричное значение каждого символа для представления набора символов. Итак, если бы мы хотели представить слово «привет», это было бы:

68656C6C6F

Довольно просто, правда? Что ж, это просто, когда мы кодируем печатаемые символы ASCII (я уже упоминал о них выше).Как только нам нужно кодировать какие-то международные символы, это становится более сложным, поскольку мы должны вернуться к Unicode. Я бы не стал особо беспокоиться об этом, у вас гораздо меньше шансов столкнуться с ним в повседневной веб-разработке, и теперь вы знаете, что это может быть, если вы увидите кучу шестнадцатеричных чисел, склеенных вместе.

Надеюсь, это было полезно, и вы можете ссылаться на это - как на отправную точку - всякий раз, когда у вас есть проблемы с кодировкой; чтобы разобраться в путанице. Если вы думаете, что есть другие схемы кодирования (актуальные для нашей повседневной жизни как разработчиков программного обеспечения), о которых я должен был упомянуть, дайте мне знать в комментариях.

Encoding 101 - Часть 1: Что такое кодирование? Блог Bizbrains

Итак, вы можете подумать, что текст - это просто текст. Ну подумай еще раз. В этой серии сообщений в блоге мы перейдем к байтовому уровню, изучим, как текст на самом деле представлен компьютерами, и обсудим, как это влияет на ваши интеграционные решения.

Что такое кодировка?

Кодирование - это способ, которым компьютер сохраняет текст как необработанные двоичные данные. Чтобы правильно читать текстовые данные, вы должны знать, какая кодировка использовалась для их хранения, а затем использовать ту же кодировку для интерпретации двоичных данных, чтобы получить исходный текст. Теперь вы, вероятно, думаете: «Звучит не так уж плохо, конечно, есть всего пара разных кодировок, и наверняка все текстовые данные содержат информацию о том, какая кодировка используется, не так ли?» Что ж, ответы на эти вопросы, к сожалению, не так просты, поэтому кодирование может быть таким кошмаром для разработчиков.

Теперь вы, вероятно, думаете: «Звучит не так уж плохо, конечно, есть всего пара разных кодировок, и наверняка все текстовые данные содержат информацию о том, какая кодировка используется, не так ли?» Что ж, ответы на эти вопросы, к сожалению, не так просты, поэтому кодирование может быть таким кошмаром для разработчиков.

Что такое текст?

Фактический текст зависит от контекста. Когда текст хранится или куда-то передается, это просто часть двоичных данных, таких же, как и любые другие данные.На самом базовом уровне это длинный ряд нулей и единиц. Когда он активно обрабатывается компьютером, это все еще двоичные данные, но они интерпретируются системой как отдельные символы и во многих случаях преобразуются в другое двоичное представление во время обработки. Это представление называется Unicode.

Краткое введение в Unicode

Еще в 1988 году цифровая обработка данных становилась все более и более распространенной, но рынок все еще был крайне фрагментирован, и каждый поставщик использовал свои собственные нестандартные решения для большинства задач. В результате взаимная совместимость между различными компьютерными системами практически отсутствовала, и отправка данных из одной системы в другую часто была очень сложной задачей. В это время была предпринята попытка остановить поток возникающих проблем с кодировкой путем введения стандартного общего набора символов, известного как Unicode. Таким образом, все различные используемые кодировки можно было, по крайней мере, сопоставить с общим набором символов, поэтому не было бы никаких сомнений относительно того, какой символ должен представлять данный код.

В результате взаимная совместимость между различными компьютерными системами практически отсутствовала, и отправка данных из одной системы в другую часто была очень сложной задачей. В это время была предпринята попытка остановить поток возникающих проблем с кодировкой путем введения стандартного общего набора символов, известного как Unicode. Таким образом, все различные используемые кодировки можно было, по крайней мере, сопоставить с общим набором символов, поэтому не было бы никаких сомнений относительно того, какой символ должен представлять данный код.

Из статьи Википедии для Unicode:

«Unicode - это стандарт компьютерной индустрии для согласованного кодирования, представления и обработки текста, выраженного в большинстве мировых систем письма. Стандарт поддерживается Консорциумом Unicode, и по состоянию на май 2019 года самая последняя версия Unicode 12.1 содержит набор из 137 994 символа, охватывающий 150 современных и исторических сценариев, а также несколько наборов символов и эмодзи.

При обработке текста Unicode обеспечивает уникальную кодовую точку - число, а не глиф - для каждого символа.Другими словами, Unicode представляет символ абстрактным образом, а визуальную визуализацию (размер, форму, шрифт или стиль) оставляет другому программному обеспечению, например веб-браузеру или текстовому процессору ».

Набор символов Unicode сам по себе не является кодировкой, а представляет собой просто стандартизованный набор всех символов, с которыми кто-либо может встретиться в файле данных. Стандарт Unicode также содержит ряд актуальных кодировок. Общим для всех этих форм, в отличие от большинства других форм кодирования текста, является то, что они поддерживают весь набор символов Unicode.

XKCD # 1953 - История Unicode

Хотя Unicode действительно устранил некоторые проблемы, связанные с избытком сосуществующих кодировок символов, он не решил все из них. Во-первых, внедрение сопутствующих систем кодирования было медленным и все еще далеко не универсальным. С другой стороны, даже при том, что наличие общего набора символов для сопоставления кодировок, безусловно, было полезным, это не изменило тот досадный факт, что многие типы текстовых данных не содержат никакой информации о том, какая система кодирования использовалась для их создания.

С другой стороны, даже при том, что наличие общего набора символов для сопоставления кодировок, безусловно, было полезным, это не изменило тот досадный факт, что многие типы текстовых данных не содержат никакой информации о том, какая система кодирования использовалась для их создания.

Итак, как работает кодирование?

Хорошо, давайте перейдем к мельчайшим деталям. Что на самом деле сохраняется при сохранении текстового файла? Сначала мы рассмотрим одну из самых старых и простых кодировок - ASCII. Вот выдержка из статьи Википедии для ASCII:

«Первоначально основанный на английском алфавите, ASCII кодирует 128 заданных символов в семибитовые целые числа, как показано в таблице ASCII выше. Можно напечатать девяносто пять закодированных символов: это цифры от 0 до 9, строчные буквы от a до z, прописные буквы от A до Z и символы пунктуации.Кроме того, исходная спецификация ASCII включала 33 непечатаемых управляющих кода, которые были созданы с помощью телетайпов; большинство из них уже устарели, хотя некоторые из них все еще широко используются, например, коды возврата каретки, перевода строки и табуляции ».

Поскольку ASCII был разработан в США и основан на английском алфавите, он содержит только стандартные английские символы. Это означает, что текст, содержащий неанглийские символы (например, буквы с диакритическими знаками или специальные буквы, используемые в других языках), не может быть точно закодирован в ASCII без замены специальных символов на стандартные английские.ASCII был разработан с использованием 7-битных кодов для представления закодированных символов, но поскольку все современные компьютеры используют байты (8 бит) в качестве наименьшей единицы памяти, символы ASCII теперь хранятся с использованием 8 бит на символ. Первый бит просто не используется.

Весь стандарт кодирования ASCII выглядит так:

Теперь давайте рассмотрим пример, чтобы увидеть, как эти тексты будут закодированы в стандарте ASCII. Вместо того, чтобы полностью писать двоичные представления более длинных текстов, мы будем использовать шестнадцатеричную нотацию для двоичных данных.

Когда вы открываете текстовый файл в кодировке ASCII в текстовом редакторе, программа считывает каждый байт файла и ищет значение в таблице ASCII, чтобы определить, какой символ отображать для этого байта.

ОднакоASCII - это очень ограниченная кодировка. Он содержит только 95 печатных символов и поэтому может использоваться только для кодирования этих символов. Если у вас есть текстовые данные, которые содержат больше символов, чем эти 95 печатных символов, вам придется использовать другую кодировку.

Это основы работы кодирования. В следующей части серии мы рассмотрим несколько различных кодировок и их отличия друг от друга, которые вы можете найти здесь. Кодировка 101 - часть 2.

Безболезненное руководство - Настоящий Python

Обработка кодировок символов в Python или любом другом языке временами может показаться болезненной. В таких местах, как Stack Overflow, есть тысячи вопросов, возникающих из-за путаницы с исключениями, такими как UnicodeDecodeError и UnicodeEncodeError .Это руководство предназначено для устранения тумана Exception и демонстрации того, что работа с текстовыми и двоичными данными в Python 3 может быть удобной. Поддержка Unicode в Python сильна и надежна, но для ее освоения требуется время.

Это руководство отличается тем, что оно не зависит от языка, а вместо этого намеренно ориентировано на Python. Вы все равно получите учебник, не зависящий от языка, но затем вы погрузитесь в иллюстрации на Python с минимальным количеством текстовых абзацев.Вы увидите, как использовать концепции кодировок символов в живом коде Python.

К концу этого руководства вы будете:

- Получите концептуальные обзоры кодировок символов и систем нумерации

- Узнайте, как кодирование вступает в игру с помощью Python

strибайт - Знайте о поддержке в Python систем нумерации с помощью различных форм

intлитералов - Ознакомьтесь со встроенными функциями Python, связанными с кодировками символов и системами нумерации.

Системы кодирования и нумерации символов настолько тесно связаны, что их нужно рассматривать в одном учебном пособии, иначе обработка любой из них будет совершенно неадекватной.

Примечание : эта статья ориентирована на Python 3. В частности, все примеры кода в этом руководстве были сгенерированы из оболочки CPython 3.7.2, хотя все второстепенные версии Python 3 должны вести себя (в основном) одинаково при обработке текста.

Если вы все еще используете Python 2 и вас пугают различия в том, как Python 2 и Python 3 обрабатывают текстовые и двоичные данные, то, надеюсь, это руководство поможет вам сделать переход.

Что такое кодировка символов?

Существуют десятки, если не сотни кодировок символов.Лучший способ понять, что это такое, - рассмотреть одну из простейших кодировок символов - ASCII.

Независимо от того, являетесь ли вы самоучкой или имеете формальное образование в области информатики, скорее всего, вы видели таблицу ASCII один или два раза. ASCII - хорошее место для начала изучения кодировки символов, потому что это небольшая и ограниченная кодировка. (Как оказалось, слишком мало.)

Включает:

- Строчные английские буквы : a от до z

- Заглавные английские буквы : A от до Z

- Некоторые знаки препинания и символы :

"$"и"!", чтобы назвать пару - Пробельные символы : фактический пробел (

""), а также перевод строки, возврат каретки, горизонтальная табуляция, вертикальная табуляция и некоторые другие - Некоторые непечатаемые символы : символы, такие как backspace,

"\ b", которые не могут быть напечатаны буквально так, как буква A может

Итак, какое более формальное определение кодировки символов?

На очень высоком уровне это способ преобразования символов (таких как буквы, знаки препинания, символы, пробелы и управляющие символы) в целые числа и, в конечном итоге, в биты.Каждый символ может быть закодирован в уникальную последовательность битов. Не волнуйтесь, если вы не уверены в концепции битов, потому что мы скоро к ним вернемся.

Различные обозначенные категории представляют собой группы персонажей. Каждому одиночному символу соответствует код , который можно рассматривать как целое число. В таблице ASCII символы разбиты на разные диапазоны:

| Диапазон кодовой точки | Класс |

|---|---|

| от 0 до 31 | Управляющие / непечатаемые символы |

| 32-64 | Пунктуация, символы, числа и пробел |

| 65-90 | Заглавные буквы английского алфавита |

| 91–96 | Дополнительные графемы, например [ и \ |

| 97–122 | Строчные буквы английского алфавита |

| от 123 до 126 | Дополнительные графемы, например { и | |

| 127 | Управляющий / непечатаемый символ ( DEL ) |

Вся таблица ASCII содержит 128 символов.В этой таблице содержится полный набор символов , разрешенный ASCII. Если вы не видите здесь символа, вы просто не можете выразить его как печатный текст в схеме кодировки ASCII.

| Кодовая точка | Персонаж (Имя) | Кодовая точка | Персонаж (Имя) |

|---|---|---|---|

| 0 | NUL (Нуль) | 64 | @ |

| 1 | SOH (начало заголовка) | 65 | А |

| 2 | STX (начало текста) | 66 | В |

| 3 | ETX (конец текста) | 67 | К |

| 4 | EOT (конец передачи) | 68 | Д |

| 5 | ENQ (Запрос) | 69 | E |

| 6 | ACK (подтверждение) | 70 | Ф. |

| 7 | BEL (Звонок) | 71 | G |

| 8 | BS (Backspace) | 72 | H |

| 9 | HT (горизонтальный выступ) | 73 | я |

| 10 | LF (перевод строки) | 74 | Дж |

| 11 | VT (вертикальный выступ) | 75 | К |

| 12 | FF (подача формы) | 76 | л |

| 13 | CR (возврат каретки) | 77 | м |

| 14 | SO (сдвиг) | 78 | N |

| 15 | SI (сдвиг внутрь) | 79 | О |

| 16 | DLE (выход из канала передачи данных) | 80 | п. |

| 17 | DC1 (Управление устройством 1) | 81 | Q |

| 18 | DC2 (Управление устройством 2) | 82 | R |

| 19 | DC3 (Управление устройством 3) | 83 | S |

| 20 | DC4 (Управление устройством 4) | 84 | т |

| 21 | NAK (отрицательное подтверждение) | 85 | U |

| 22 | SYN (синхронный холостой ход) | 86 | В |

| 23 | ETB (конец блока передачи) | 87 | Вт |

| 24 | CAN (Отмена) | 88 | X |

| 25 | EM (конец среднего) | 89 | Y |

| 26 | SUB (Заменитель) | 90 | Z |

| 27 | ESC (выход) | 91 | [ |