Redmine Wiki Guide Plugin — вики-эссе

Превратите свой Redmine Wiki в идеальный портал самообслуживания. Нет ничего лучше, чем решить проблему самостоятельно. И быстро определите необходимую информацию.

Редмин Продукты / Redmine Wiki Guide Plugin — вики-эссе

Что, если бы вы могли улучшить возможности самообслуживания вашей вики?

Успех интернет-порталов самообслуживания зависит не только от качества или объема информации. Но и доступность доступного вики-контента для пользователя.

От IT-поддержки до HR и администрирования, плагин Redmine Wiki Guide помогает облегчить поиск и обмен информацией, хранящейся в вики.

Redmine Wiki Guide Plugin — более вдохновляющий

Большинство пользователей хотят самостоятельно решать проблемы или вопросы, связанные с их работой, продуктом или услугой. Сделайте это как можно проще для них и тем самым освободите вашу поддержку, отдел кадров, административный персонал или менеджеров проектов.

Плагин Redmine Wiki Guide является расширением для Redmine и легко интегрируется с существующим Redmine Wiki. Оно позволяет пользователям Redmine быстрее и точнее находить контент в вики.

Оно позволяет пользователям Redmine быстрее и точнее находить контент в вики.

Будь то более эффективная обработка запросов поддержки или упрощение поиска необходимой информации. Среди прочего, здесь используются типичные функции базы знаний.

Простой в использовании инструмент предназначен в первую очередь для компаний, которые называют своих клиентов и/или сотрудников пользователями. И хотим предложить ряд полезных функций в Redmine для более эффективного сотрудничества между командами по продукту, маркетингу, продажам и поддержке.

Buyers Guide of Wiki Guide Plugin (EN)

Everything you need to know when buying Redmine Wiki Guide.

Download PDF now

Global wiki page

Интеграция глобального портала с полезными функциями (Популярные страницы, Последние страницы, Последние обновленные страницы, Мои последние обновления, Кнопки).

Wiki Guide buttons

Позволяет пометить вики-страницы и предоставляет определенные теги вики-страницам в виде так называемых кнопок на глобальной вики-странице. Для прямой навигации по целевым страницам и лучшей категоризации контента.

Для прямой навигации по целевым страницам и лучшей категоризации контента.

Live-Search

Добавляет find-as-you-type Search, чтобы обеспечить еще более быстрый и качественный поиск, чем глобальный Redmine Search. Позволяет, например, отрицание или фразы.

Voting for Wiki pages

Пользователи могут предоставлять положительные или отрицательные отзывы на отдельные вики-страницы посредством голосования. Для ещё более качественного контента.

Orphaned wiki pages

Помогает найти забытое содержимое проектной вики и обновить его.

Missing wiki pages

Показывает, где контент должен быть доступен в проектной вики, чтобы предоставить пользователям дополнительную информацию.

Confidential wiki pages

Позволяет пользователям с соответствующими правами маркировать вики-страницы как Confidential, чтобы делиться информацией, хранящейся там, только с небольшой группой пользователей.

Quick start made easy

Строится на основе существующего вики-контента. Никакого специфического для плагина, пользовательского контента не требуется, как в случае с другими провайдерами. Это экономит время во время реализации.

Никакого специфического для плагина, пользовательского контента не требуется, как в случае с другими провайдерами. Это экономит время во время реализации.

24/7

Служба самообслуживания обеспечивает пользователей информацией круглосуточно. Это сокращает время ожидания ответов.

Optimal integration

Оптимально интегрирован в Redmine и плавно работает с другими нашими плагинами.

Company-wide use

Для лучшего самообслуживания всех пользователей. Полезно для IT-отдела в маркетинге. А также для отдела кадров, вплоть до администрации.

Extended role permissions

Расширяет концепцию авторизации для отдельных ролей пользователей в вики.

Own panel macro

Предоставляет панельные макросы для интеграции в вики-контент для выделенной информации типа: Примечание, Информация, Совет, Предупреждение.

Dashboard support

Поддерживает функцию плагина Additionals, предоставляя вики-блоки инструментальной панели на странице Redmine Home и на странице обзора проекта.

Почему клиенты любят Redmine Wiki Guide Plugin

Потому что вы можете использовать его немедленно. Большое преимущество здесь:

Вы можете напрямую использовать данные, содержащиеся в ней. Никакие собственные типы данных не вводятся. При необходимости вы можете оптимизировать существующий вики-контент или создать новый контент в соответствующей вики-проекте.

Our plugins will suit your needs!

Our Redmine plugins are multilingual and a good choice if you want to work productively. 12 month support & updates included.

Get it now

Buy Wiki Guide Plugin v3.0.8

Fast, free delivery of the download URL after receipt of payment

Plugin requirements — Plugin FAQ — Terms of use

12 Month — DE, EN — E-Mail support via customer area

Right to use the obtained plugin versionLifetime

€ 249 / Year*

Single product

€ 1295 / Year*

as part of Enterprise+ Bundle(Full-Stack contains all Plugins) — Compare all features

* Offer is directed exclusively to entrepreneurs within the meaning of §14 BGB. All prices are in EUR and net prices. Plus the applicable statutory sales tax. Reverse Charge applies for international clients outside Germany with a valid EU VAT ID No. Delivery of the download URL against advance payment. Plugin installation is done by the client himself, according to our installation instructions. Note the minimum system requirements and FAQ before purchase.

All prices are in EUR and net prices. Plus the applicable statutory sales tax. Reverse Charge applies for international clients outside Germany with a valid EU VAT ID No. Delivery of the download URL against advance payment. Plugin installation is done by the client himself, according to our installation instructions. Note the minimum system requirements and FAQ before purchase.

1) does not run stand-alone. Requires Redmine Reporting. Affects: Automation, HRM, DevOps

What annual support and maintenance license do you need?

Redmine Wiki Guide License (€249.00)Enterprise+ Bundle (Full-Stack) (€1,295.00)википедия | Теги | Overclockers.ru

А Б В Г Д Е Ж З И Й К Л М Н О П Р С Т У Ф Х Ц Ч Ш Щ Ъ Ы Ь Э Ю Я

A B C D E F G H I J K L M N O P Q R S T U V W X Y Z

Madarator 19 апреля 2023

Сообщается, что российские аналоги всемирной интернет-энциклопедии уже разработаны, но их релиз постоянно переносится

g1tarist 8 апреля 2023

Песков заявил о необходимости в создании российской онлайн-энциклопедии, способной заменить «Википедию».

Михаил Андреев 4 апреля 2023 в 19:26

Проблема в том, что поезд со станции давно ушёл и уже прибыл в пункт Б.

DeepDeep 21 декабря 2022

Саму «Википедию» понизят в поисковой выдаче

Михаил Андреев 20 декабря 2022 в 13:53

Википедия развивалась 21 год, если что.

Zelot 24 августа 2022

На момент написания данного материала сайт российского клона так и не открывался

Михаил Андреев 20 июля 2022 в 12:52

Теперь в отечественных поисковиках будут сообщать о нарушениях соответствующим юр. лицом российского законодательства.

DeepDeep 30 июня 2022

Многие считают, что вскрылась одна из самых масштабных фальсификаций с момента создания «свободной энциклопедии»

[Zero] 2 мая 2022

Решение было принято в минувшее воскресенье

[Zero] 26 апреля 2022

За статьи о «спецоперации» на территории Украины и порохе

[Zero] 7 апреля 2022

Павел Перников обвинялся в «дискредитации Беларуси»

Kachka 5 апреля 2022

Между прочим, уже не первый раз.

Михаил Андреев 31 марта 2022 в 18:53

Конкретно что касается статьи о боевых действиях на территории сопредельного государства.

LongTimeAgo 17 сентября 2021

Внутреннее расследование длилось почти 1 год

Nacvark 19 июля 2021

Ещё в 2015 году Ларри Сэнгер сообщал, что в Википедии появилось множество «троллей», вносящих в статьи неверные данные

warmuza 5 ноября 2019

Президент России высказался по поводу замены популярного международного ресурса на отечественный

Блогер 16 мая 2019

Приближается 30-я годовщина событий на площади Тяньаньмэнь.

Как служба написания Википедии может помочь с тегами-сиротами

Автор: Майк Вуд

Мы все их видели. Уродливые теги, которые помещаются в верхней части статей Википедии, часто используются как знак стыда редактором, которому нечем заняться, кроме как троллить Википедию, стремясь оставить свой след, размещая теги на статьях. Это очень неприятно, если у вас есть статья, относящаяся конкретно к вам или вашей компании. Когда вы пытаетесь поддерживать свой бренд в Википедии, нет ничего хуже, чем видеть эти теги в верхней части вашей статьи. Вот почему часто необходимо нанять службу написания Википедии, чтобы сохранить стабильность статьи.

Уродливые теги, которые помещаются в верхней части статей Википедии, часто используются как знак стыда редактором, которому нечем заняться, кроме как троллить Википедию, стремясь оставить свой след, размещая теги на статьях. Это очень неприятно, если у вас есть статья, относящаяся конкретно к вам или вашей компании. Когда вы пытаетесь поддерживать свой бренд в Википедии, нет ничего хуже, чем видеть эти теги в верхней части вашей статьи. Вот почему часто необходимо нанять службу написания Википедии, чтобы сохранить стабильность статьи.

Один тег, который очень часто можно увидеть, называется тегом-сиротой. Как следует из названия, это статья без дома. Под этим я подразумеваю, что это статья, которая стоит сама по себе и не взаимодействует ни с какой другой статьей в Википедии. В теге указано, что «другие статьи не ссылаются на него», и содержится просьба к редакторам ввести ссылки, чтобы сделать статью бесхозной. Мне это кажется ерундой, так как на ссылку на другую статью уходит меньше времени, чем на размещение такой метки, но иногда вам приходится наводить порядок в редакторах, которые скорее поставят метку, чем исправят проблему, которую они помечают.

Тег сироты можно удалить после того, как вы представили его из других статей Википедии. Например, если статья для Джорджа Буша-младшего была помечена как сирота (маловероятно, но мне нужно привести пример, который не заставит редакторов отомстить мне, нанеся ущерб статье, которую я упоминаю), вы можете связать ее со статьей. для Гарвардской школы бизнеса в разделе выпускников. На примере ниже видно, как это уже сделано.

Посмотрите статью Гарвардской школы бизнеса. Вы можете увидеть Джорджа Буша-младшего, отмеченного синим цветом под списком известных выпускников:

Поскольку статья связывает имя Джорджа Буша-младшего со статьей для Джорджа Буша-младшего, она больше не будет сиротой. Итак, если вы хотите удалить потерянный тег самостоятельно, не нанимая службу написания статей в Википедии, вот что вам нужно сделать.

При создании статьи:

Для человека самый простой способ — добавить его в списки выдающихся выпускников школ, которые он окончил (аналогично приведенному выше примеру Джорджа Буша-младшего). Вы также можете связать человека из компании, в которой он работает (например, генеральный директор компании должен быть связан со страницы компании). Лучший способ удалить потерянный тег — убедиться, что он не размещен в статье.

Для человека самый простой способ — добавить его в списки выдающихся выпускников школ, которые он окончил (аналогично приведенному выше примеру Джорджа Буша-младшего). Вы также можете связать человека из компании, в которой он работает (например, генеральный директор компании должен быть связан со страницы компании). Лучший способ удалить потерянный тег — убедиться, что он не размещен в статье.При редактировании статьи:

Если вы редактируете статью с потерянным тегом без помощи службы написания Википедии, вам нужно будет найти статью в Википедии, с которой вы можете сделать ссылку на потерянную статью. Для этого используйте инструмент «Найти ссылку», расположенный здесь. Просто введите название статьи, которую вы редактируете, и она найдет потенциальные статьи Википедии, на которые вы можете дать ссылку. Чтобы продолжить использовать пример Джорджа Буша-младшего, вы можете увидеть следующий снимок экрана со статьями, которые возвращаются с помощью инструмента «Найти ссылку».

Сколько ссылок — это слишком много:

При использовании Wiki-ссылок не бывает «слишком много» ссылок. Связывание статей в Википедии — вот что делает Википедию таким полезным инструментом для поиска информации. Вам нужно только 1, чтобы статья не считалась сиротой, но я бы рекомендовал связать как минимум 3 или 4 статьи, чтобы быть уверенным, что редактор не вернется и не попытается оправдать повторную пометку статьи только из-за одна ссылка. Наем службы написания Википедии, чтобы помочь удалить такие теги, обычно приводит к нескольким ссылкам на вашу статью и постоянному удалению потерянного тега.

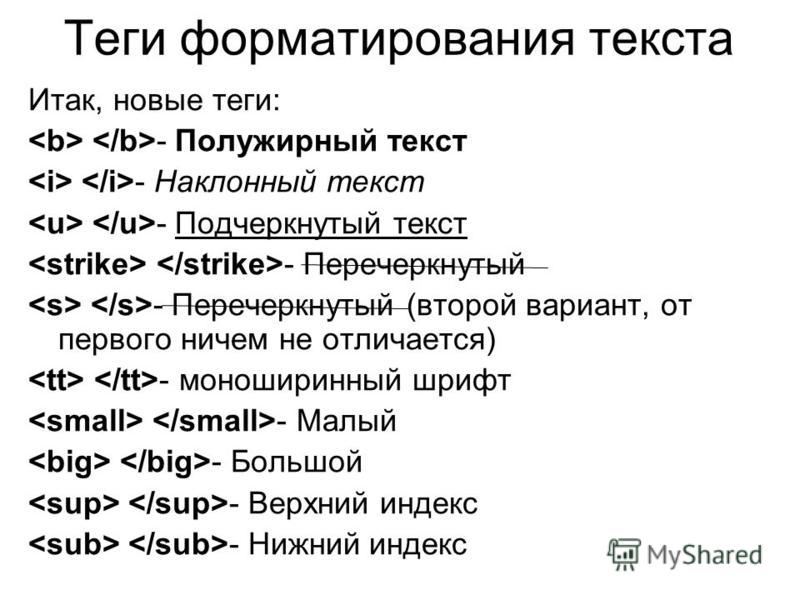

Удаление тегов html при сканировании википедии с помощью Python urllib2 и Beautifulsoup

Задавать вопрос

спросил

Изменено 8 лет, 2 месяца назад

Просмотрено 2к раз

Я пытаюсь просканировать Википедию, чтобы получить данные для анализа текста. Я использую Python urllib2 и Beautifulsoup. Мой вопрос заключается в следующем: есть ли простой способ избавиться от ненужных тегов (например, ссылок «a» или «span») из текста, который я прочитал.

Я использую Python urllib2 и Beautifulsoup. Мой вопрос заключается в следующем: есть ли простой способ избавиться от ненужных тегов (например, ссылок «a» или «span») из текста, который я прочитал.

для этого сценария:

импортировать urllib2

из импорта BeautifulSoup *

открыватель = urllib2.build_opener()

opener.addheaders = [('Агент пользователя', 'Mozilla/5.0')]

infile = opener.open("http://en.wikipedia.org/w/index.php?title=data_mining&printable=yes")pool = BeautifulSoup(infile.read())

res=pool.findAll('div',attrs={'class' : 'mw-content-ltr'}) # для прямого доступа к содержимому

paragrapgs=res[0].findAll("p") # получить все абзацы

Я получаю абзацы с большим количеством тегов ссылок, таких как:

paragrapgs[0] =

Интеллектуальный анализ данных (этап анализа обнаружения знаний в базах данных процесс,[1] или KDD), относительно молодая и междисциплинарная область компьютерных наук

[2][3] – это процесс обнаружения новых шаблонов из больших наборов данных с использованием методов на пересечении искусственный интеллект, машинное обучение, статистика и системы баз данных. [2] Целью интеллектуального анализа данных является извлечение знаний из набора данных в человеческом понятная структура[2] и включает базу данных и управление данными, предварительная обработка данных, < href="/wiki/Statistical_model" title="Статистическая модель">модель и вывод, показатели интереса, < a href="/wiki/Computational_complexity_theory" title="Теория вычислительной сложности">соображения сложности, постобработка найденной структуры, визуализация< /a> и онлайн-обновление.[2]

Есть идеи, как их удалить и получить чистый текст?

- python

- html

- html-parsing

- beautifulsoup

- wikipedia

Вот как вы могли бы сделать это с lxml 900 83 (и прекрасные запроса ):

запросов на импорт импортировать lxml.4html как lh из BeautifulSoup импортировать UnicodeDammit URL = "http://en.wikipedia.org/w/index.php?title=data_mining&printable=yes" HEADERS = {'Агент пользователя': 'Mozilla/5.0'} def lhget(*args, **kwargs): r = запросы.get(*args, **kwargs) html = UnicodeЧерт возьми(r.content).unicode дерево = lh.fromstring(html) дерево возврата деф удалить (эль): el.getparent().удалить(эль) дерево = lhget (URL, заголовки = ЗАГОЛОВКИ) el = tree.xpath("//div[@class='mw-content-ltr']/p")[0] для ссылки в el.xpath("//sup[@class='reference']"): удалить (ссылка) напечатать lh.tostring(el, pretty_print=True) распечатать el.text_content()

для p в абзацах (text=True):

печатать р

Кроме того, вы можете использовать api.php вместо index.php :

#!/usr/bin/env python импорт системы время импорта импортировать urllib, urllib2 импортировать xml.etree.cElementTree как etree # подготовить запрос maxattempts = 5 # сколько раз попробовать запрос, прежде чем сдаться maxlag = 5 # секунд http://www.mediawiki.org/wiki/Manual:Maxlag_parameter params = dict(action="query", format="xml", maxlag=maxlag, prop="ревизии", rvprop="content", rvsection=0, titles="data_mining") запрос = urllib2.Request( "http://en.wikipedia.org/w/api.php?" + urllib.urlencode(параметры), headers={"User-Agent": "WikiDownloader/1.2", "Реферер": "http://stackoverflow.com/q/8044814"}) # Сделать запрос для _ в диапазоне (максимальное количество попыток): ответ = urllib2.urlopen(запрос) если response.headers.get('MediaWiki-API-Error') == 'maxlag': t = response.headers.get('Повторить-после', 5) print "повторная попытка через %s секунд" % (t,) time.sleep (поплавок (т)) еще: перерыв # готов к чтению else: # исчерпаны все попытки sys.exit(1) # скачать и разобрать xml дерево = etree.parse(ответ) # найти данные о оборотах rev_data = tree.findtext('.//rev') если не rev_data: print 'MediaWiki-API-Error:', response.headers.get('MediaWiki-API-Error') дерево.

запись(sys.stdout) Распечатать sys.exit(1) печать (rev_data)

Вывод

{{Различие|аналитика|извлечение информации|анализ данных}}

'''Интеллектуальный анализ данных''' (этап анализа '''обнаружения знаний в базах данных..

0Похоже, что они работают с узлами тегов «Красивый суп». parentNode изменяется, поэтому соответствующие теги удаляются. Найденные теги также возвращаются вызывающей стороне в виде списков.

@статический метод

def seperateCommentTags (родительский узел):

комментарийТеги = []

для потомка в parentNode.descendants:

если экземпляр (потомок, элемент.Комментарий):

commentTags.append(потомок)

для комментарияТег в комментарииТеги:

тег комментария.extract()

вернуть комментарийТеги

@статический метод

def seperateScriptTags (родительский узел):

scripttags = parentNode.find_all ("сценарий")

скрипты = []

для scripttag в scripttags:

сценарий = scripttag.