Регистрация сайта в поисковых системах Яндекс и Google

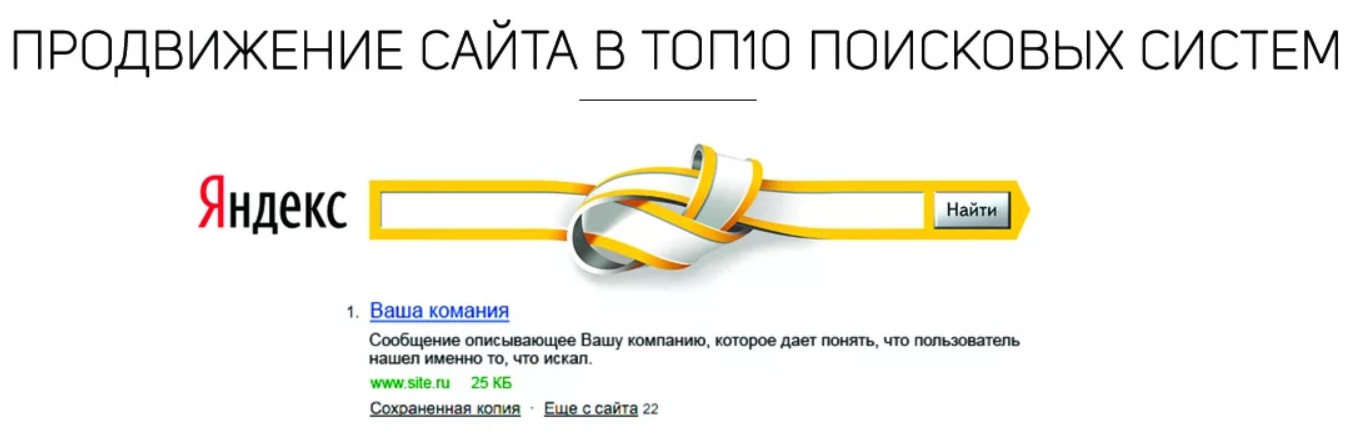

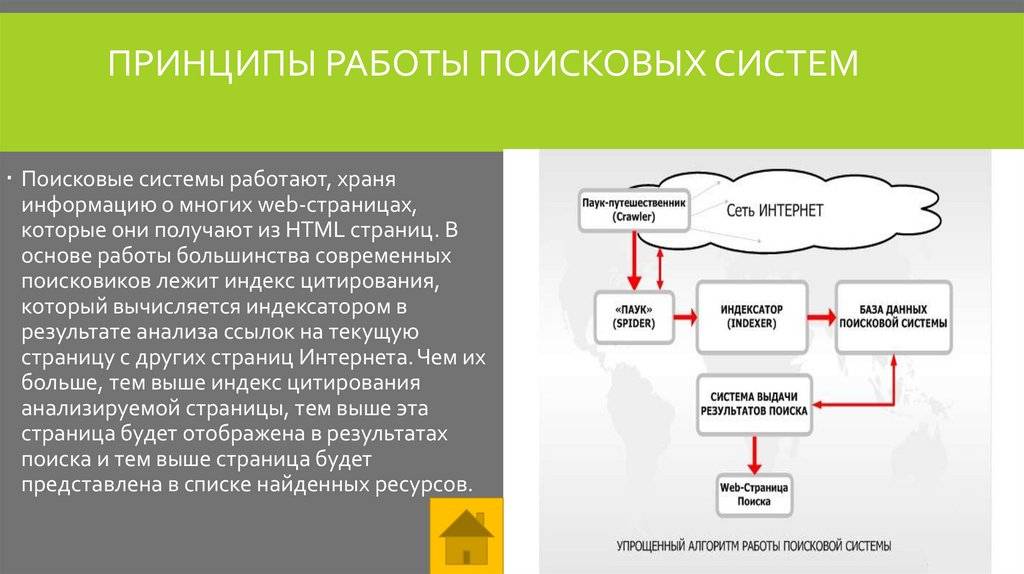

Регистрация сайта в поисковых системах – это фактическое начало его активной жизни и роста в рамках Глобальной сети. Вы добавляете его в очередь на индексирование, ускоряя процесс принятия в поисковую выдачу. Спустя некоторое время он начнёт собирать трафик, качество и количество которого будет зависеть только от вас.

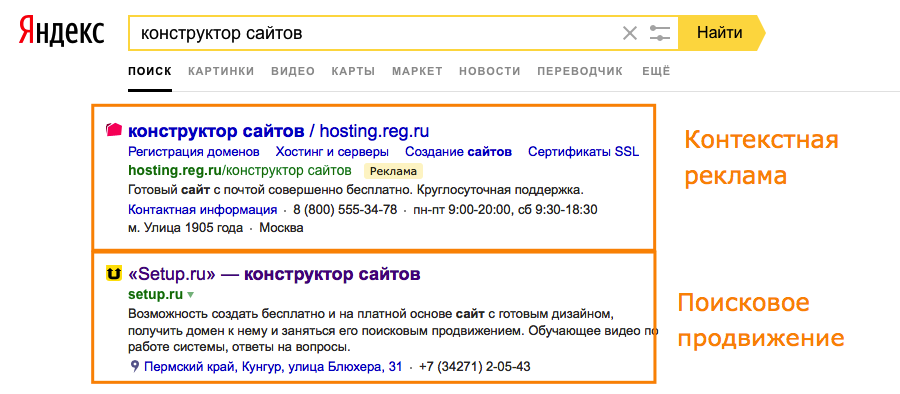

Привлекать трафик сегодня можно из различных источников. Это могут быть поисковые системы, социальные сети, платные и бесплатные внешние ссылки с других площадок. Основной посыл при привлечении трафика заключается не в том, чтобы собрать как можно большую аудиторию, вне зависимости от того, как и почему она попала к вам. Собирайте только целевых посетителей, которые зайдут на ваш ресурс и совершат определённые полезные действия, которые будут повышать его вес и трастовость.

Большое количество случайных посетителей сказывается не столько на счётчике посещений, сколько на счётчике отказов.

Так что всегда помните о том, что не стоит слепо гнаться за количеством посещений. Обращайте куда большее внимание на качество каждого конкретного из них. Пусть к вам будет приходить немного пользователей, но каждый из них подробно прочитает всю информацию, находящуюся на странице. Это и будет значить, что вы занимаетесь действительно полезным делом. Которое со временем оценят и пользователи, и поисковики.

Для чего нужно регистрировать сайт в поисковых системах?

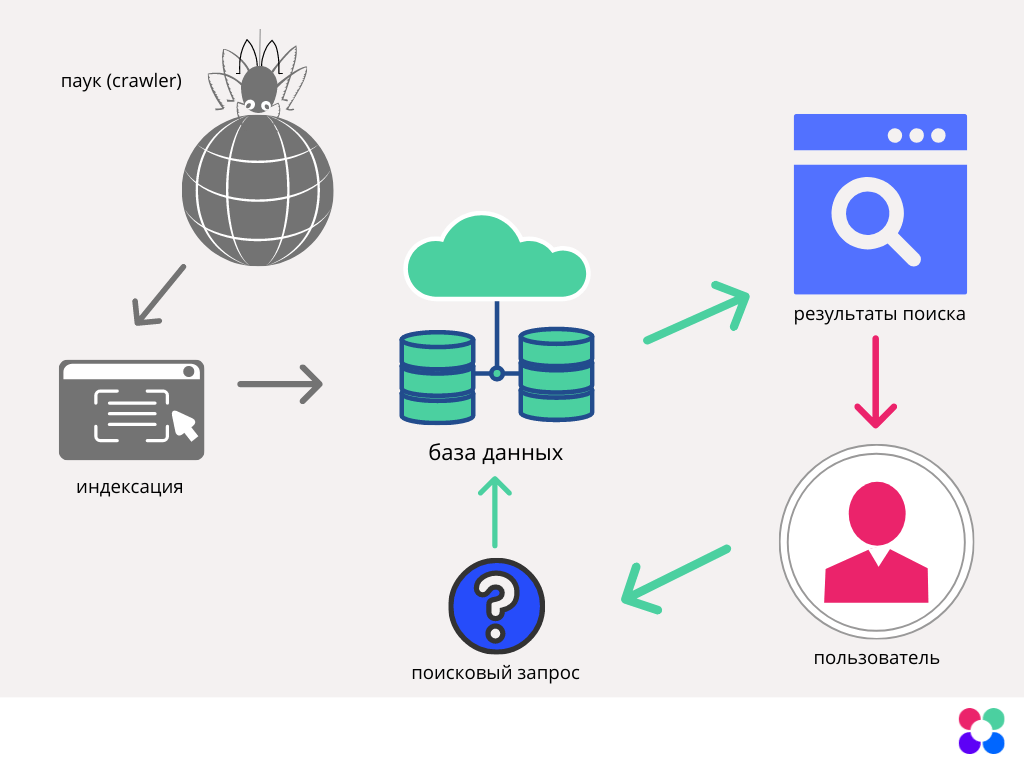

До момента индексирования сайта в поисковых системах, последние о нём попросту не знают и не могут ссылаться на него.

В целом автоматические механизмы поисковиков могут и сами отыскать ваш ресурс. Правда нет никаких гарантированных сроков подобного события. Они могут отыскать вас через месяц, а могут и через десятки лет. Скорость автоматической индексации во многом зависит от количества внешних ссылок, которые ведут на ваш сайт. Если поисковый бот индексирует сайт и видит на нём ссылку на ваш ресурс, то он перейдёт по ней и проверит его содержимое. Таким образом поисковик обратит внимание на вас. Но это также не значит, что стоит поставить пару ссылок, как вас сразу же включат в выдачу.

Добавление сайта в индекс необходимо не только с точки зрения привлечения трафика. Поисковые системы дают свои рекомендации по оптимизации структуры сайта и его технических параметров.

Как добавить сайт в поисковые системы?

Перед тем, как отправлять собственный сайт на индексирование, стоит заранее подумать о том, как его воспримут поисковики. Чтобы с их стороны к вам не было никаких претензий, в виде фильтров и низкой оценки самого ресурса, необходимо поработать над его внутренностями:

Пропишите метатеги

Метатеги – это такие служебные элементы, которые видят только поисковые системы. Они являются указателями для ботов, которые помогают им не запутаться в структуре и проще понять содержание ресурса.

Вам нужно прописать следующие элементы:

-

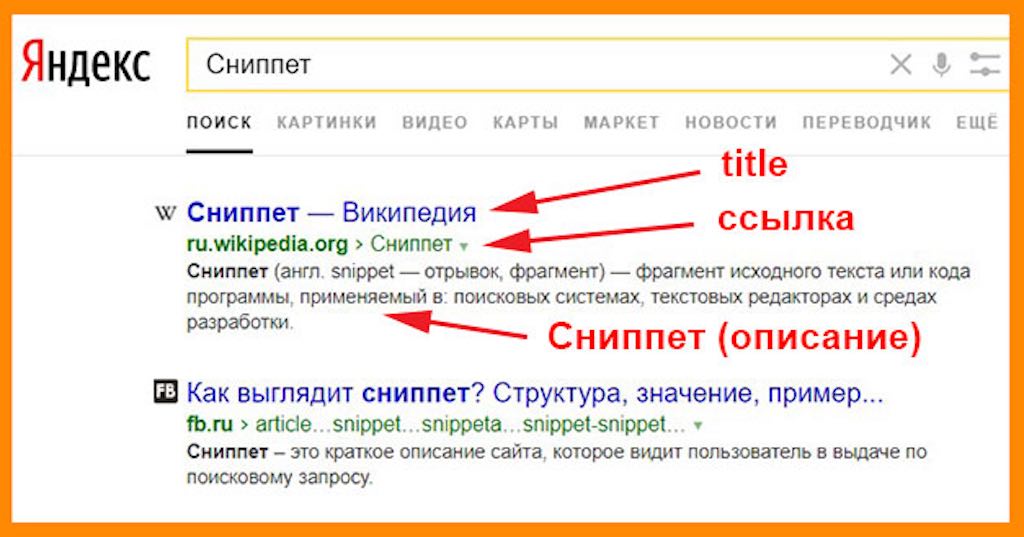

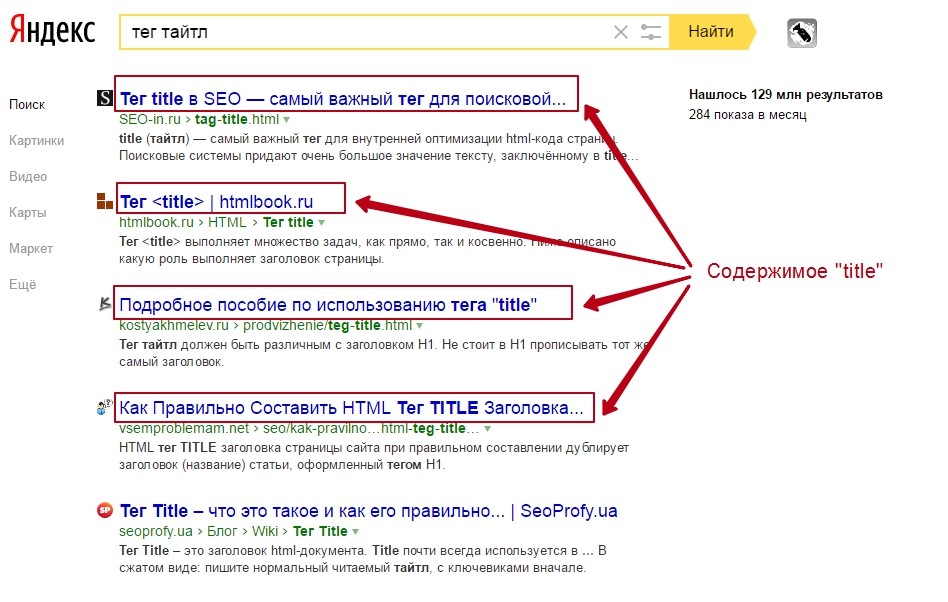

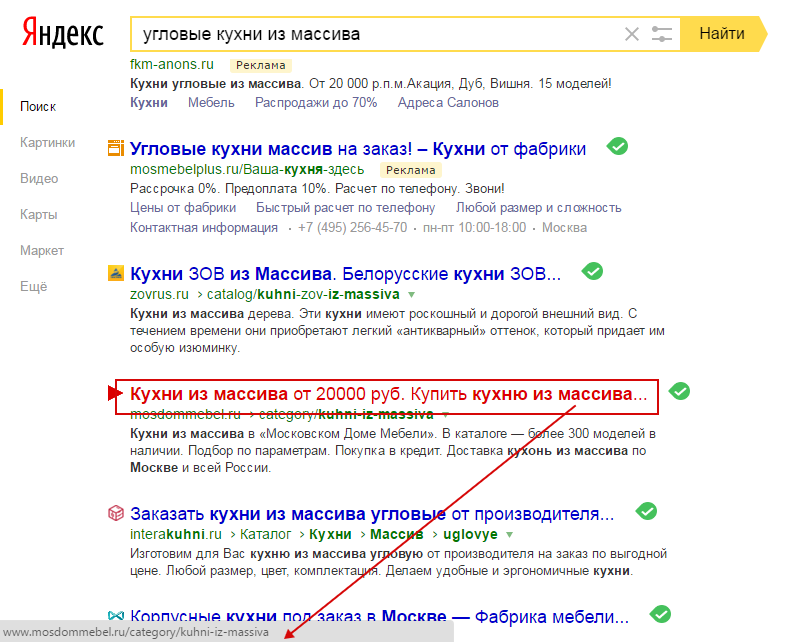

Title – заголовок страницы. Он должен содержать порядка 50-65 символов. Это первое, что увидят ваши посетители. Объясните им в нескольких словах, что происходит на вашем сайте. Заголовок будут видеть пользователи и в поисковой выдаче, так что не пренебрегайте этим элементом.

Во многом от него будет зависеть количество собираемого вами трафика.

-

Description – описание страницы. Несколько более обширный текст, содержащий пару предложений (порядка 200 символов), описывающих назначение страницы. Его пользователи увидят в поисковой выдаче прямо под заголовком. Поэтому согласуйте оба этих элемента для каждой страницы ресурса.

-

h2, h3, h4 – заголовки в теле текста. Эти элементы находятся непосредственно внутри статей. Тогда как первые два – специализированные и предназначены для успешного формирования поисковыми алгоритмами превьюшки вашей страницы для выдачи. Эти заголовки призваны структурировать информацию, находящуюся на страницах сайта. Они нужны посетителям, которые придут за информацией, находящейся на вашем ресурсе. Помните о том, что заголовки не должны повторять title.

-

Autor – обычная информация об авторе.

Напишите в формате: “Имя Фамилия”.

Напишите в формате: “Имя Фамилия”.

Поработайте над SEO сайта

Если вы хотите активно получать трафик из поисковых систем, поработайте над ключевыми словами. Соберите наиболее подходящие ключевики и распределите их в тексте соответствующих страниц. Таким образом посетителям будет проще понять, что именно находится на сайте, а поисковые боты на их основе сформируют пул запросов, в ответ на которые вы будете появляться в выдаче.

Помните о том, что всю техническую часть сайта лучше будет проработать заранее. До того, как отправлять заявку на индексирование. Потому что впоследствии изменения будут вноситься по мере того, как поисковые боты начнут фиксировать внесённые коррективы. А это, в свою очередь, может занять определённое время. И если не сделать всё основательно изначально, исправления и переделки будут требоваться бесконечно. А потери времени, особенно если дело касается коммерческого проекта, крайне негативно сказываются на бизнесе.

Проверьте внешние и внутренние ссылки

Регулярно проверяйте работоспособность ссылок, размещённых на страницах вашего сайта. Если среди них будут встречаться неработающие, поисковые боты могут выкинуть страницы из выдачи. С точки зрения поисковика это техническая ошибка, которая требует своевременного вмешательства администратора ресурса. А если его не последовало, получается, что сайт не регулярно проверяется и обновляется. Что в свою очередь ведёт к снижению его рейтинга.

Поработайте над удобством интерфейса

Самое главное правило, которому необходимо следовать при организации структуры интерфейса – интуитивность. Любой посетитель должен не задумываясь находить всю необходимую информацию. Поэтому располагать её следует так, чтобы не приходилось ничего искать. Поисковые работы ничуть не хуже оценивают эффективный и ориентированный на пользователей интерфейс.

Откажитесь от сложных скриптов

Если вам нужно добавить на страницу тот или иной “тяжёлый” элемент, лучше всего будет разместить его отдельным файлом и проставить на него ссылку. Таким образом получится сохранить высокую скорость загрузки, так высоко ценящуюся поисковыми системами, без потери ифнормативности. На самом деле никто не любит тяжёлые страницы, которые долго прогружаются и съедают много трафика.

Таким образом получится сохранить высокую скорость загрузки, так высоко ценящуюся поисковыми системами, без потери ифнормативности. На самом деле никто не любит тяжёлые страницы, которые долго прогружаются и съедают много трафика.

Не забудьте про файл robots.txt

Технический файл, содержащий информацию для поисковых роботов. Внутри него вы можете разграничить страницы сайта на те, которые открыты для демонстрации посетителям, и технические, закрытые от индексации и не попадающие в выдачу. В каждом конкретном случае, количество и состав страниц, закрывающихся для просмотра, может быть индивидуальным.

Добавьте внешних ссылок

Вы можете проставить ссылки на популярные ресурсы и сервисы. Например, собственные страницы или группы в социальных сетях и каналы в мессенджерах. Поисковые системы любят ссылки на доверенные площадки, которые уже давно зарекомендовали себя с наилучшей стороны.

Завершив работу над технической стороной проекта, можете смело приступать к ручной регистрации на индексацию.

Регистрация сайта в Яндекс

Само по себе добавление сайта в индекс Яндекса не требует ничего особенного. Перейдите на эту страницу и вставьте в поле адрес главного зеркала. Помните о том, что ваш ресурс может быть доступен по различным URL-адресам. Например, с добавлением www и без, на обычном протоколе http и на защищённой его версии https.

Вариантов написания адреса сайта может быть куда больше, чем кажется на первый взгляд. И в идеале все они должны вести на одну и ту же главную страницу. Подобная организация достигается благодаря 301 редиректу, через который настраивается перенаправление на нужную страницу вне зависимости от технических подробностей введённого адреса.

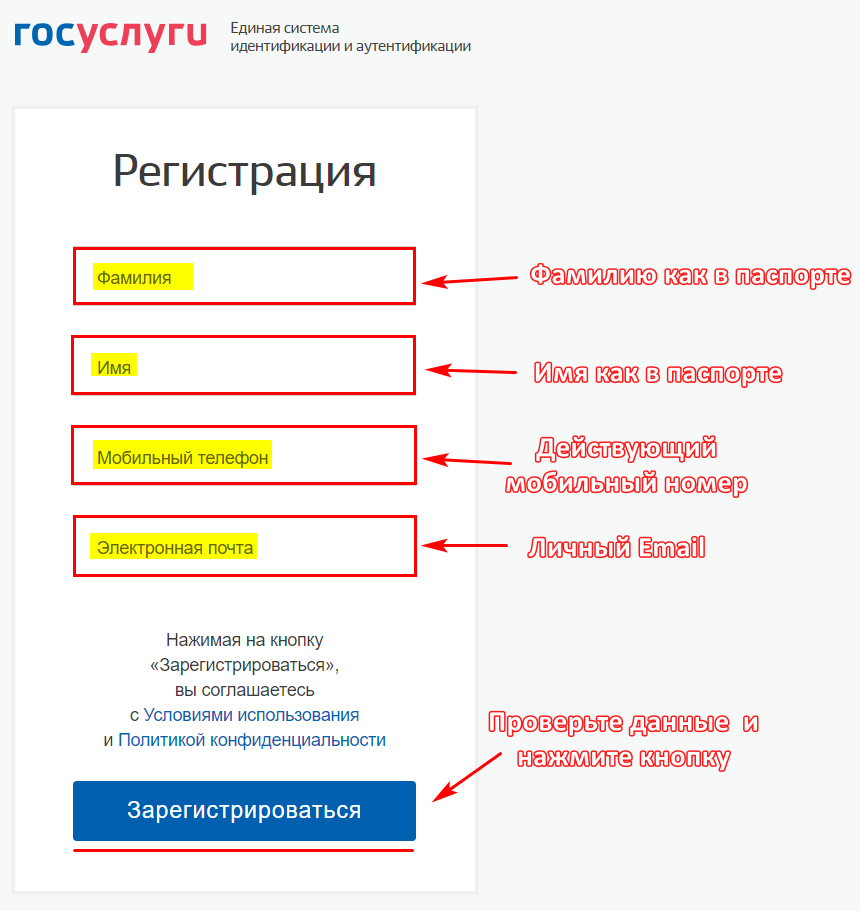

Перейдём к самой регистрации:

-

Зарегистрируйте личный почтовый ящик на Яндексе.

-

Добавьте свой сайт в Яндекс.Вебмастер.

-

Введите адрес сайта.

-

Подтвердите право владения.

Регистрация не занимает много времени, тогда как эффект от неё может быть просто невероятным. Не стоит пренебрегать ни одним доступным источником качественного трафика. Каждый раз, когда вы из-за лени или неграмотности отказываетесь от интеграции с той или иной площадкой (будь то организация присутствия в социальных сетях или добавление сайта в выдачу поисковой системы), вы попросту упускаете возможную выгоду.

Регистрация сайта в Google

Самая популярная во всём мире поисковая система по своей сути не сильно отличается от того же Яндекса. В Google также есть собственная страница с возможностью добавления сайтов в индекс. Как и в случае с регистрацией в Яндексе, заранее убедитесь в том, что все копии вашей главной страницы систематизированы и организованы таким образом, чтобы переадресация вела только на одну из них.

-

Зайдите на страницу формы добавления сайта.

-

Введите адрес ресурса, который хотите включить в поисковую выдачу.

image3.jpg

image3.jpg

-

Подтвердите права администратора. В каждом конкретном случае процесс подтверждения прав владения может отличаться.

image7.jpg

image7.jpg

-

Если всё прошло успешно, то вам пришлют уведомление с сообщением о том, что “Право собственности подтверждено”.

Регистрация поддоменов осуществляется отдельно от основного сайта. Каждый из них нужно вносить в индекс и подтверждать право собственности индивидуально.

Факт индексации поисковиком можно проверить, введя запрос с адресом сайта и техническим оператором site:. Выглядеть запрос будет следующим образом:

Выглядеть запрос будет следующим образом:

site:“адрес вашего сайта”.

Если поисковая система ещё не обработала запрос на индексацию, то вы увидите соответствующее сообщение об этом.

В том случае, когда сайт не обрабатывается в течении нескольких дней, после регистрации, стоит обратить внимание на его доступность и работоспособность всех элементов интерфейса.

Регистрация сайта в поисковых системах (Веб-мастер)

Приветствую вас, дорогой посетитель! Хотите, чтобы ваш сайт посещало больше пользователей? Тогда нужно добавить сайт в поисковые системы Google, Яндекс, Bing и Поиск Mail.ru. Данный пост — регистрация сайта в поисковых системах, должен был бы увидеть свет ещё пару лет назад, но почему я его не написал. А всё просто. Со временем (с 2011 года), набираясь опыта по созданию и ведению сайтов/блогов постоянно думал, если я знаю такие банальные вещи — создал новый сайт, то его нужно обязательно добавить в поисковые системы (бесплатно) и самостоятельно, то и остальные пользователи, естественно, это знают.

То есть, для меня многие вещи со временем начали казаться очевидными, понятными и само собой разумеющимися, но не для вас — новичков. Теперь, буду исправлять эту ошибку и делиться с вами всем подряд, не пропуская ничего, даже всякими мелочами, которые могут пригодится вам. Вот, как то, так. Надеюсь, друзья, вы меня поняли. А теперь, позвольте, перейти к нашей сегодняшней теме.

В Интернете очень много сайтов, но не забывайте и для вашего найдётся местечко в нём и поэтому, как только вы создали сайт/блог, опубликовали несколько своих шедевров (уникальных статей), то пора сообщить о рождение сайта всему миру, то есть, поисковым системам. Чем быстрей вы заявите поисковым системам о своём сайте, тем быстрее новый URL появится в базе данных поисковиков, это значит, ваши статьи начнут появляться в выдаче. Смотришь и посетители понемногу начнут заходить знакомится с вашим материалом.

А для начала — Доля рынка поисковых систем по всему миру и России.

Рейтинг поисковых систем в России (РФ) и мире. 2020 г.

Данные статистики от Statcounter GlobalStats:

Рейтинг поисковых систем в мире. Июнь 2020 г.Рейтинг поисковых систем в России. Август 2020 г.Как добавить сайт в поисковые системы? Веб-мастер Google, Яндекс, Bing и Поиск Mail.ru

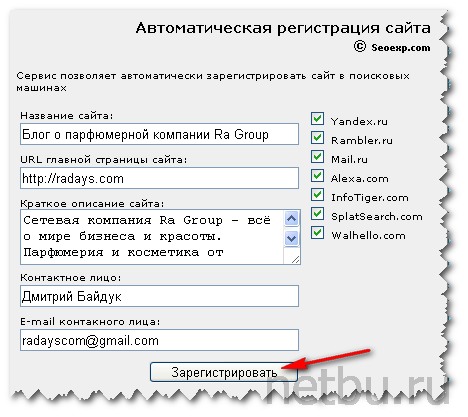

Сначала нужно добавить сайт в поисковые системы через так называемые «Аддурилки» (ADD URL — добавить URL), у всех известных и актуальных, и даже новых (Спутник) поисковиков такая возможность есть.

Post updated! Аддурилки ликвидировали, теперь, чтобы ваш сайт находили в Интернете надо воспользоваться кабинетом вебмастера каждого поисковика.

У Яндекс это — Яндекс.Вебмастер, у Google — Search Console, у Поиска Mail.Ru — Кабинет вебмастера Mail.Ru, у Bing — Средства веб-мастера – Bing.

Пост полностью пришлось редактировать/переделывать, для того, чтобы для вас, друзья, информация была актуальна всегда. Если вы хотите, чтобы ваш сайт отображался в поисковой выдаче, он должен быть проиндексирован.

Нужными инструментами для вебмастеров обладают только поисковые системы Google, Яндекс (Yandex), Bing и Поиск Mail.ru.

Регистрация сайта в Google Search Console

Добавьте свой сайт в поисковую систему Google. Попасть в результаты поиска Google просто. Не нужно ничего платить. Используйте новую Search Console (раньше Google для веб-мастеров).

Что такое Search Console?

Google Search Console – это бесплатный сервис, который позволяет узнать, как ваш сайт представлен в Google Поиске, и при необходимости оптимизировать его.

Поисковая система GoogleНадеюсь, корпорация добра Google в представлении вам не нуждается, а поэтому сразу к делу. Здесь, всё просто. Зайдите под своим аккаунтом Google, на эту страницу — https://search.google.com/search-console/welcome и введите свой адрес URL сайта и спокойно кликайте кнопку «Добавить ресурс»:

Добро пожаловать в Search Console!Затем, вам надо подтвердить права на свой сайт, любым предлагаемым методом:

Подтверждение права собственности на сайтКак подтверждать права на сайт? У меня написано специальная статья, очень подробно, разными способами. Смотрите тут. У всех поисковиков подтверждать права на свой добавляемый веб-ресурс обязательно.

Смотрите тут. У всех поисковиков подтверждать права на свой добавляемый веб-ресурс обязательно.

Обратите внимание, что после проверки сайта данные отчетов Search Console станут доступны не сразу. Сбор данных о вашем сайте начинается сразу после его добавления в аккаунт Search Console и до подтверждения права собственности. Пару дней ждите. А тем временем переходите к следующему ПС.

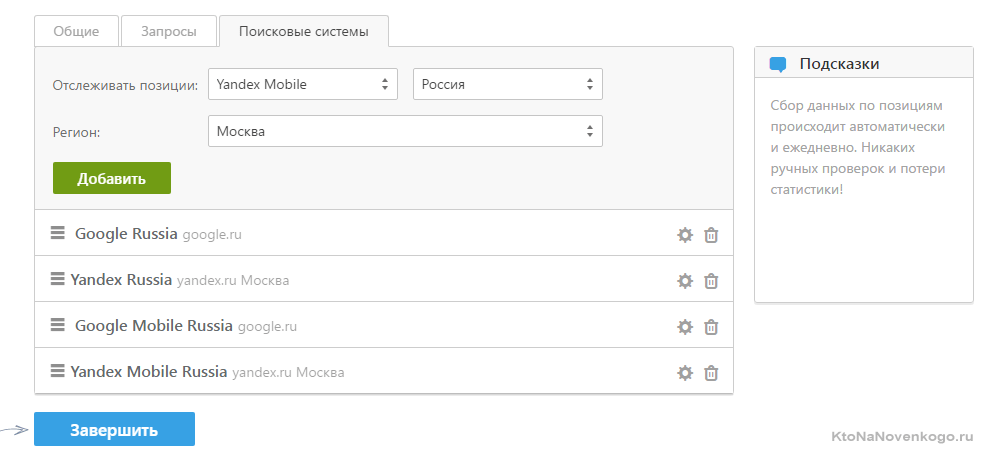

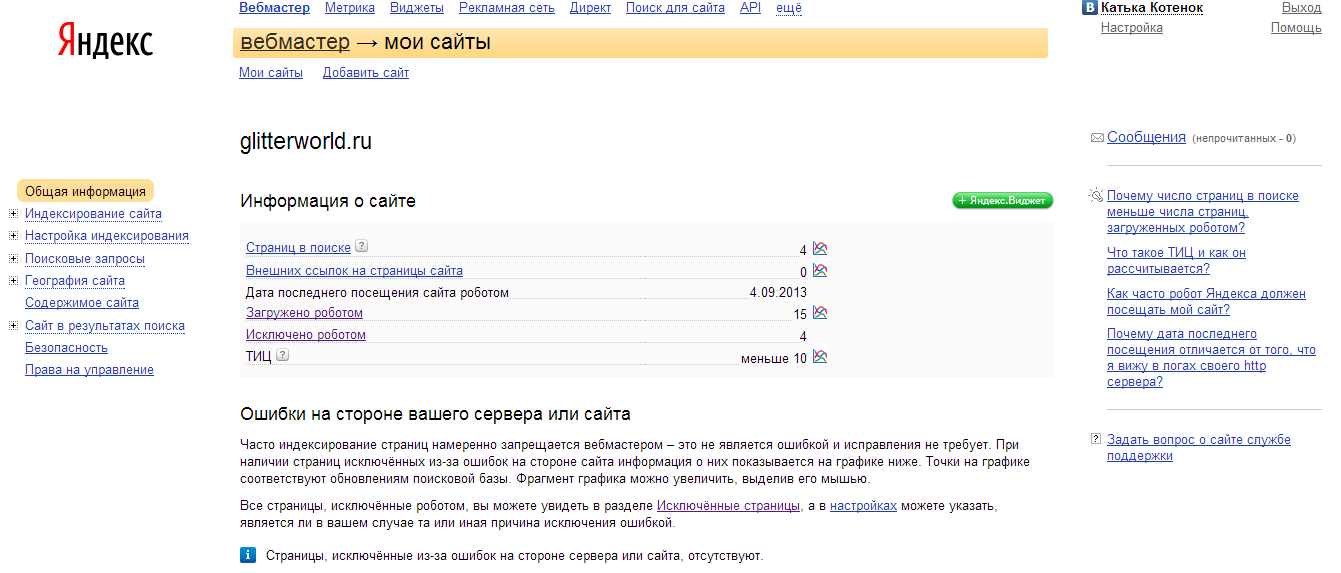

Добавить сайт в поисковую систему Яндекс

Поисковая система ЯндексТакже, как и Google, Яндекс в рекламе не нуждается, только в индекс Яндекса ваши страницы сайта попадут не быстро, ждать несколько дней, а может даже и недель. В Google с этим намного лучше обстоят дела. Для работы с Яндекс.Вебмастером необходима учетная запись на Яндексе. Если у вас ее нет, зарегистрируйтесь.

Что такое Яндекс.Вебмастер?

Яндекс.Вебмастер помогает понимать, насколько легко ваш сайт находят пользователи. Сервис предлагает инструменты для отслеживания и анализа индексирования страниц сайта, его позиций в поиске и технического состояния. Если ваш сайт новый и еще не присутствует в поиске Яндекса, сообщите о нем с помощью Яндекс.Вебмастера.

Если ваш сайт новый и еще не присутствует в поиске Яндекса, сообщите о нем с помощью Яндекс.Вебмастера.

Для добавления сайта в Яндекс зайдите на эту страницу — https://webmaster.yandex.ru/sites. Нажмите кнопку Добавить сайт:

Добавьте сайт в Яндекс.ВебмастерВ поле укажите адрес сайта, по которому он будет участвовать в поиске:

- по протоколу HTTP или HTTPS;

- с префиксом www или без него.

После этого, вам надо также подтвердить права на сайт одним из предложенных способов. Подтверждение прав необходимо для работы в Яндекс.Вебмастере:

Подтверждение прав на сайтИнструкция подтверждения по ссылке выше. Сайт подтвердили и он отобразится в разделе Мои сайты. И снова вам остаётся только ждать пока информация о нём будет доступна вам. Роботы Яндекса регулярно обходят страницы сайтов и загружают их в свою базу. Идём далее, к следующей поисковой системе.

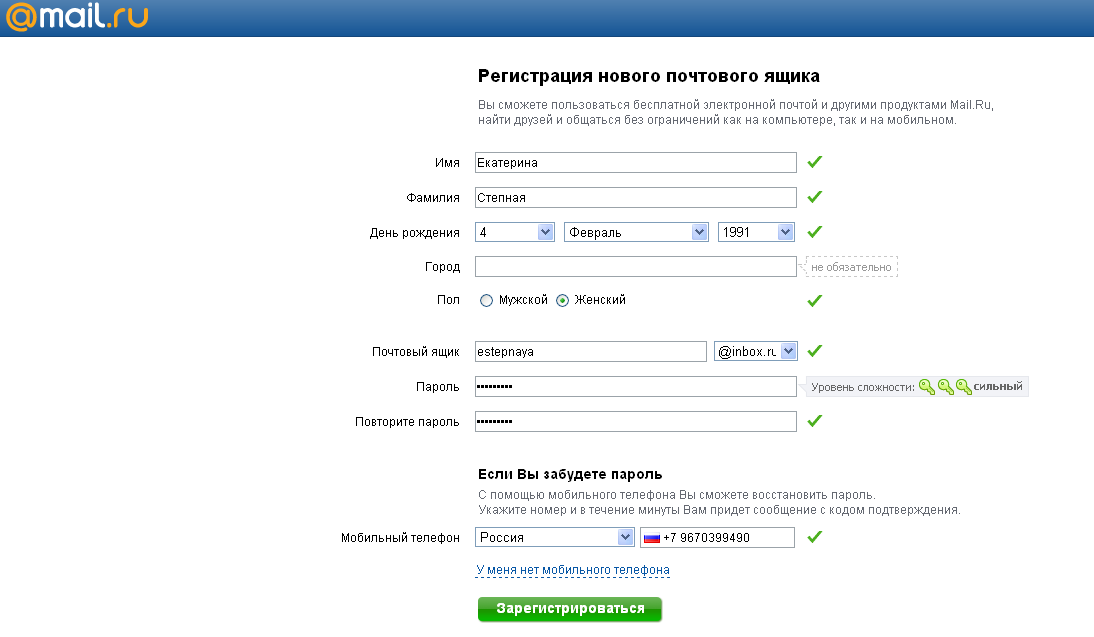

Добавить сайт в поиск Mail ru

Не стоит пренебрегать поисковой системой mail ru думая, что через неё ни кто не ищет. Это не так, обычному пользователю всё равно/без разницы через какой поисковик находить нужную информацию. Например, моя жена пользуется браузером от mail ru и естественно, ищет разную информацию (рецепты, здоровье и так далее) в поиск@mail.ru.

Это не так, обычному пользователю всё равно/без разницы через какой поисковик находить нужную информацию. Например, моя жена пользуется браузером от mail ru и естественно, ищет разную информацию (рецепты, здоровье и так далее) в поиск@mail.ru.

Для регистрации сайта в mail поиск, вам нужно зарегистрироваться на портале майл ру и перейти в кабинет вебмастера, по этому адресу — http://webmaster.mail.ru/.

Что такое кабинет вебмастера Поиска Mail.Ru?

Кабинет вебмастера – это сервис, предоставляющий информацию о том, как индексируются ваши сайты в Поиске Mail.Ru. Вам будет доступна следующая информация:

- кто ссылается на страницы вашего сайта;

- по каким запросам пользователи приходят на ваш сайт;

- какие страницы скачаны и проиндексированы;

- какие страницы и по каким запросам наиболее релевантны;

- какие страницы Поиск Mail.Ru считает хорошими и по каким запросам.

Как добавить свой сайт? Нажать кнопку «Добавить сайт»:

Добавить сайт в поиск mailОпять же, введите URL вашего сайта, буквы капчи и кнопку «Добавить сайт». После этого, вас перенаправят на страницу подтверждения прав на сайт/блог. После чего сайт будет добавлен в список ваших сайтов. Если по каким-то причинам сайт не был ранее проиндексирован, то он будет поставлен в очередь на индексирование.

После этого, вас перенаправят на страницу подтверждения прав на сайт/блог. После чего сайт будет добавлен в список ваших сайтов. Если по каким-то причинам сайт не был ранее проиндексирован, то он будет поставлен в очередь на индексирование.

Всё, форма отправлена. Идем дальше, последний шаг, это поисковая система Bing.

Добавить сайт в поисковую систему Bing

Привлеките больше посетителей на свой сайт с помощью данных и средств Bing. Веб-мастер Bing предоставляет простые в использовании общедоступные средства для повышения эффективности вашего веб-сайта.

Поисковая система Bing от MicrosoftТоже хорошая поисковая система, особенно новый кабинет вебмастера, кстати, полностью на русском языке. Регистрация сайта в Bing вы одновременно добавляете веб-ресурс и в Yahoo. Отправьте свой сайт в Bing/Yahoo. Для этого надо также зарегистрироваться — https://www.bing.com/toolbox/webmaster/. Регистрация возможна с помощью учётной записи Microsoft или аккаунта Google, или Facebook.

После авторизации в веб-мастере Bing вводите URL сайта или можно произвести быстрый импорт ваших сайтов из консоли поиска Google. Нажимаете нужную кнопку Импорт или Добавить:

Поисковая система bingСледующий шаг, это проверить права на добавляемый сайт. Выберите один из методов проверки. Хотя можно пропустить, но это действие обязательное:

Подтвердить права на сайт BingПосле успешной проверки вас поздравят:

Сайт добавлен в средства веб-мастера BingЕсли вы уже создали и опубликовали карту sitemap xml для вашего сайта, то можете добавить ее здесь в текстовом поле «Добавить sitemap», введя полный URL-адрес sitemap. Следует иметь в виду, что sitemap можно всегда будет добавить позже.

Отправить карту XML Sitemap в BingКликайте «Отправить.» Потом ваш сайт будет в списке Мои сайты. Пока его робот проиндексирует блог/сайт — надо какое-то время подождать. Кстати, Bing запустил новую версию Webmaster Tools для всех пользователей.

Новый Bing Webmaster

В рамках обновления поисковик запустил ряд нововведений: инструмент проверки URL, инструмент проверки файла robots. txt:

txt:

Инструмент Site Scan (сканирование сайта), который позволяет находить и устранять распространённые ошибки технического SEO. Проанализируйте веб-сайт на предмет общих технических проблем SEO и исправьте их, чтобы улучшить свою производительность в Bing:

Новое сканирование сайта в Бинги новые рекомендации для вебмастеров.

В новой версии Webmaster Tools интерфейс стал более интуитивным и удобным за счёт объединения 47 ссылок, которые были доступны в старой версии сервиса. Теперь их стало всего лишь 17. Стало намного удобнее, обязательно пользуйтесь, друзья.

Вот, пожалуй и всё на сегодня. В основные поисковые системы мы сайты отправили, с чем я вас и поздравляю. Очень надеюсь, дамы и господа, статья вам будет полезна. До новых встреч и удачи. Пока, Пока!

Инструменты Bing для веб-мастеров (Пошаговое руководство на 2023 год)

Вы, наверное, уже знаете, что Bing — вторая по величине поисковая система, верно? Итак, вы определенно настроили Bing Webmaster Tools .

А может быть, вы еще этого не сделали, потому что никогда особо не задумывались об этом.

Хотя вы, возможно, не уделяете Bing столько внимания, сколько Google, вам следует как минимум настроить Инструменты Bing для веб-мастеров. Почему? Потому что это довольно просто сделать и может помочь вам получить дополнительный SEO-трафик на ваш сайт.

Позвольте мне показать вам.

Что такое инструменты Bing для веб-мастеров?

Инструменты Bing для веб-мастеров (Bing WMT) — это бесплатная служба Microsoft, которая позволяет веб-мастерам добавлять свои сайты в поисковый робот Bing, чтобы они отображались в поисковой системе.

Это также помогает контролировать и поддерживать присутствие сайта. Инструменты Bing для веб-мастеров для поисковой системы Bing — то же, что Google Search Console для Google.

Инструментальная панель инструментов Bing для веб-мастеров Любой пользователь веб-сайта может извлечь выгоду из использования инструментов Bing для веб-мастеров, независимо от того, являетесь ли вы владельцем сайта, администратором сайта, маркетологом или разработчиком веб-сайта.

Почему вы не должны игнорировать Bing

Прежде всего: Bing занимает второе место в списке крупнейших поисковых систем в США. Итак, вы хотите, чтобы ваш сайт был в рейтинге.

Почему? Потому что у него разная аудитория. И, согласно имеющимся данным, доля Bing на рынке поисковых систем составляет 9,41%:

Статистика использования BingТеперь 9,41% могут показаться не такими уж впечатляющими, если не учитывать фактические цифры:

- 1,3 миллиарда уникальных ежемесячных посетителей Bing со всего мира. .ком.

- 12 миллиардов ежемесячных запросов по всему миру.

- 500 миллионов ежемесячных запросов в США.

Зачем использовать инструменты Bing для веб-мастеров?

Инструменты Bing для веб-мастеров позволяют отслеживать общее состояние вашего веб-сайта и помогают вам увидеть, как ваши клиенты находят ваш сайт. Вы можете использовать инструменты и отчеты, чтобы найти ключевые слова, привлекающие трафик, а также показы и клики по этим терминам, а также найти веб-сайты, ссылающиеся на вас. Вы также можете:

Вы также можете:

- Отслеживайте эффективность своего сайта и смотрите, по каким ключевым словам он ранжируется.

- Посмотрите, как Bing сканирует и индексирует ваш сайт.

- Отправьте свой веб-сайт/новые страницы для сканирования.

- Удалите любой контент, который вы не хотите индексировать.

- Отклонить ссылки.

- Отслеживайте и устраняйте потенциальные проблемы с вредоносными программами или спамом.

Все это поможет вам понять, как Bing просматривает ваш веб-сайт (и ваш контент), чтобы вы могли внести любые коррективы, чтобы улучшить свой рейтинг и, следовательно, привлечь трафик на свой веб-сайт.

Как настроить Bing Webmaster Tools

1. Создайте учетную запись в Bing Webmaster Tools

Для этого перейдите в Bing Webmaster Tools и нажмите «Зарегистрироваться»:

Страница регистрации в Bing Webmaster Tools Вы будет предложено создать учетную запись Bing WMT через существующую учетную запись Microsoft, Google или Facebook.

После создания учетной записи вы увидите пустую панель инструментов:

Пустую панель инструментов сайта BingНо пустая панель управления никому не нужна. Давайте добавим ваш сайт в Bing.

2. Отправить URL-адрес в Bing

Прежде всего, нам нужно добавить URL-адрес.

Добавьте URL вашего сайта в поле и нажмите «Добавить».

Мои сайты в Инструментах для веб-мастеров BingТеперь вы перейдете на страницу, где сможете добавить дополнительную информацию о своем сайте. Давайте пробежимся по тому, что вы хотите добавить сюда:

3. Отправьте карту сайта в Bing

Вероятно, самым важным моментом здесь является добавление вашей XML-карты сайта в Bing.

Добавление XML-карты сайта в BingНайдите свою карту сайта и вставьте этот URL-адрес в поле.

Добавив это, вы можете оставить остальные параметры без изменений, прокрутить вниз и нажать Сохранить .

Теперь пришло время начать проверку Bing.

Проверка инструментов Bing для веб-мастеров

Существует три способа проверки вашего профиля:

1.

Файл XML

Файл XMLПроверка с помощью файла XML:

- Загрузите файл Bing XML.

- Загрузите его в корневую папку вашего домена.

Это создаст URL-адрес: YOURDOMAIN.com/BingSiteAuth.xml

Вам нужно будет загрузить этот файл через FTP. Если у вас нет доступа, этот метод проверки может не подойти.

2. Метатег

Далее необходимо добавить метатег на главную страницу вашего сайта. Это всего лишь простой фрагмент HTML, например, мета-описание.

Метатег для проверки Bing Webmaster ToolsЕсли вы используете CMS, в которой есть раздел для пользовательского HTML, вы можете поместить его туда, чтобы активировать.

Чтобы инструменты Bing для веб-мастеров оставались проверенными, вам нужно оставить этот метатег на месте

3. Хостинг-провайдер: CNAME

Последний вариант позволяет добавить запись CNAME через вашего хостинг-провайдера.

Обычно это самый быстрый и надежный способ подтверждения вашего профиля. Но в зависимости от вашего хоста, это может быть самым сложным.

Но в зависимости от вашего хоста, это может быть самым сложным.

Используйте любой из трех методов, который вы предпочитаете (или можете использовать), все они в основном одинаковы.

Теперь я знаю, что я сказал, что есть только три способа проверить Bing WMT, но если вы используете WordPress для своего сайта, у вас есть еще несколько вариантов:

Проверка инструментов Bing для веб-мастеров с помощью WordPress

Процесс проверки для WordPress сайты довольно легко. Убедитесь, что у вас установлен один из следующих SEO-плагинов:

- Yoast SEO .

- Все в одном SEO-пакете

- Ранг Математика

Все они делают примерно одно и то же и помогают улучшить SEO. Но если вам нужна помощь в принятии решения, какой из них выбрать, ознакомьтесь с нашим углубленным анализом Rank Math и Yoast SEO.

Вот как проверить Bing Webmaster Tools для каждого из плагинов:

Yoast

Войдите в свою серверную часть WordPress, затем перейдите к SEO в меню слева. На главной панели Yoast перейдите на вкладку Инструменты для веб-мастеров.

На главной панели Yoast перейдите на вкладку Инструменты для веб-мастеров.

Теперь вы увидите поле, которое вы можете поместить в свой проверочный код Bing (а также коды для Baidu, Google и Yandex):

Yoast SEO Настройка инструментов для веб-мастеров BingПомните метатег HTML из ранее в этом руководстве ?

Если вы забыли:

Метатег для BingСкопируйте этот код и вставьте его в Yoast.

Сделав это, просто нажмите « Сохранить изменения », затем вернитесь в Инструменты Bing для веб-мастеров и подтвердите (используя метод тега HTML).

All In One SEO Pack

Процесс для All in One SEO Pack не сильно отличается.

Перейдите в All-In-One SEO, затем в Общие настройки и прокрутите, пока не увидите раздел «Подтверждение веб-мастера»:

All-in-One SEO Настройка инструментов Bing для веб-мастеровВставьте свой HTML-тег, прокрутите страницу вниз и нажмите кнопку «Обновить параметры», чтобы сохранить.

Rank Math

Перейдите на вкладку «Общие настройки» в Rank Math.

На этой странице настроек SEO вы увидите инструменты для веб-мастеров в подменю, щелкните его и вставьте свой метатег в поле Bing: и проверено.

Но что вы на самом деле можете сделать с новой приборной панелью?

Давайте изучим это:

Использование инструментов Bing для веб-мастеров

Прежде чем мы начнем изучать инструменты Bing для веб-мастеров, давайте сделаем небольшой экскурс и рассмотрим добавление URL-адресов в Bing:

Индексирование Bing

Мы уже рассмотрели, как отправить URL-адрес в Bing в разделе настройки этого руководства. Но знаете ли вы, что вы можете отправить свои URL-адреса в Bing для более быстрого сканирования и индексации?

Ну, вы можете, и это очень просто. Вот как:

Перейдите в «Настроить мой сайт» и выберите «Отправить URL-адреса» в раскрывающемся списке. Затем просто вставьте свои URL-адреса, нажмите «Отправить» и расслабьтесь, зная, что Bing индексирует ваши страницы.

Отправка URL-адресов в Bing На панели инструментов Bing WMT вы сможете настроить свой сайт, отправить URL-адреса, заблокировать URL-адреса, управлять пользователями и многое другое. Но давайте сосредоточимся на различных отчетах и инструментах, которые делают Bing WMT полезным и эффективным инструментом SEO:

Но давайте сосредоточимся на различных отчетах и инструментах, которые делают Bing WMT полезным и эффективным инструментом SEO:

Отчеты и данные

Это сводка любой активности веб-сайта в Bing. График активности сайта показывает тенденцию за выбранные вами даты.

Отчеты и данные BingВнутри вы также найдете другие инструменты и отчеты:

- Трафик страницы.

- Обозреватель индексов.

- Ключевые слова для поиска.

- SEO-отчеты.

- Входящие ссылки.

- Информация о сканировании.

Давайте быстро взглянем на них:

Трафик страницы

Отчет о трафике страниц в BingЗдесь показаны самые популярные URL-адреса на вашем сайте, которые появляются в результатах поиска Bing, а также их позиции, клики и рейтинг кликов. Вы можете нажать «Просмотр», чтобы увидеть ключевые слова для каждого URL-адреса и экспортировать данные.

Обозреватель индексов

Обозреватель индексов в Bing Обозреватель индексов позволяет увидеть, какие страницы Bing просканировал (или пытался просканировать). Он предоставляет вам такие данные, как количество обнаруженных URL-адресов, количество отображаемых в поиске, количество кликов и количество входящих ссылок. Вы можете прокручивать папки и просматривать данные для определенных областей вашего сайта.

Он предоставляет вам такие данные, как количество обнаруженных URL-адресов, количество отображаемых в поиске, количество кликов и количество входящих ссылок. Вы можете прокручивать папки и просматривать данные для определенных областей вашего сайта.

Ключевые слова поиска

Отчет по ключевым словам поиска в BingОтчет по ключевым словам поиска показывает органические ключевые слова, по которым вы получаете показы и клики. В основном самые популярные URL-адреса, которые появляются в Bing. Вы также сможете увидеть, как ваш сайт работает с точки зрения CTR.

SEO-отчеты

SEO-отчеты в BingSEO-отчеты содержат рекомендации, которые помогут убедиться, что ваш сайт соответствует передовым методам SEO. Просто нажмите на предложение, чтобы просмотреть дальнейшее объяснение ошибки и даже рекомендацию по ее устранению. Если вам интересно, этот отчет автоматически запускается раз в две недели и сканирует все проверенные веб-сайты в вашей учетной записи.

Входящие ссылки

Отчет о входящих ссылках в Bing Отчет о входящих ссылках показывает… ну, все входящие ссылки, обнаруженные Bing, указывающие на ваш сайт. Это полезно для того, чтобы увидеть, есть ли места, где вы получаете или теряете ссылки с течением времени.

Это полезно для того, чтобы увидеть, есть ли места, где вы получаете или теряете ссылки с течением времени.

Информация о сканировании

Информация о сканировании в BingИнформация о сканировании предоставляет обзор любых ошибок сканирования на вашем сайте. Вы сможете увидеть такие вещи, как ошибки, возникающие (Bing) при посещении страницы, любые элементы, заблокированные robots.txt, и любые URL-адреса, зараженные вредоносным ПО.

Диагностика и инструменты

В этом разделе вы найдете набор диагностических инструментов, предоставляемых Bing, которые помогут вам устранить любые проблемы с веб-сайтом и улучшить SEO-видимость вашего сайта.

Диагностические инструменты BingВнутри вы найдете:

Давайте взглянем на них:

1. Инструмент проверки совместимости с мобильными устройствами

Инструмент проверки совместимости Bing с мобильными устройствами Каждый знает, как важно иметь сайт, оптимизированный для мобильных устройств. Даже Бинг. Чтобы использовать этот инструмент, просто введите URL-адрес и нажмите «Анализ». Затем вы сможете увидеть, рассматривает ли Bing страницу как удобную для мобильных устройств, а также как она выглядит на мобильном устройстве.

Чтобы использовать этот инструмент, просто введите URL-адрес и нажмите «Анализ». Затем вы сможете увидеть, рассматривает ли Bing страницу как удобную для мобильных устройств, а также как она выглядит на мобильном устройстве.

2. Исследование ключевых слов

Выполнение исследования ключевых слов в Инструментах для веб-мастеров BingИнструмент исследования ключевых слов Bing позволяет быстро выполнять исследование ключевых слов из панели управления. Он использует данные исследования ключевых слов Bing, чтобы показать объемы поиска по ключевым словам в Bing (а также по связанным ключевым словам). Вы можете исследовать до 20 ключевых слов одновременно, сортировать по стране или языку и экспортировать все данные о ключевых словах. Не плохо бесплатно.

3. Получить как Bingbot

Получить как отчет Bingbot Fetch as Bingbot позволяет вам увидеть, как выглядит ваш сайт для поисковых роботов Bing. Это полезный инструмент для устранения ошибок, которые могут повредить вашему сайту в поиске. Просто введите свой URL-адрес и посмотрите источник своей страницы, как это делает Bingbot.

Просто введите свой URL-адрес и посмотрите источник своей страницы, как это делает Bingbot.

4. Средство проверки разметки

Средство проверки разметки схемы/структурированных данных в Bing Средство проверки разметкисообщит вам, правильно ли реализована схема. Если вы используете разметку схемы на своем веб-сайте (Schema.org, RDFa, Microformats, HTML Microdata или Open Graph), код отсканированной страницы будет отображаться в отчете Bing.

5. SEO Analyzer

SEO-анализатор BingSEO Analyzer делает то, что говорит: он анализирует SEO-эффективность ваших страниц. Он сканирует любой URL-адрес и подсвечивает, соответствует ли страница лучшим практикам SEO, а также дает рекомендации.

6. Подтвердить Bingbot

Подтвердить Bingbot Инструмент Подтвердить Bingbot позволяет исследовать IP-адреса, содержащиеся в ваших файлах журналов, чтобы определить, принадлежат ли они Bingbot. Если IP-адрес не является подлинным, это указывает на то, что сервер, отправляющий запрос, не является законным.

7. Перемещение сайта

Сообщить Bing, если вы переместите свой сайт в новый доменПеремещение сайта позволяет напрямую сообщить Bing, если ваш сайт переместился в новый домен. Как правило, Bing все равно улавливает перенаправления и меняет индексацию, но функция «Перемещение сайта» может ускорить процесс и убедиться в отсутствии проблем.

Множество полезных отчетов и инструментов, которые вы можете найти в Инструментах для веб-мастеров Bing. Но это не останавливается на достигнутом. Команда Bing также собрала коллекцию полезных ресурсов.

Дополнительная литература

Вот набор инструментов, ресурсов и дополнительной литературы, собранных Bing, чтобы помочь вам понять их алгоритм (и воспользоваться им):

- Рекомендации Bing для веб-мастеров. набери себе скорость. Вы узнаете все, что вам нужно знать о Bing SEO.

- Microsoft SEO Tool Kit — этот малоизвестный 100% бесплатный SEO-инструмент представляет собой простое в использовании настольное приложение, которое сканирует ваш веб-сайт, чтобы найти любые SEO-проблемы.

- Блог веб-мастера Bing. Как и у Google, у Bing также есть блог. Прочтите и подпишитесь, чтобы быть в курсе новостей поисковой системы.

- Блог качества поиска Bing — Блог качества поиска Bing предлагает передовой опыт и информацию о мире поиска.

- Связаться с командой веб-мастеров Bing — это не совсем инструмент, но, тем не менее, полезный. Если на вашем сайте возникла проблема, вы можете легко связаться с командой Bing напрямую, чтобы решить проблему.

Сводка

Вот и все, что вам нужно знать об инструментах Bing для веб-мастеров.

Инструменты Bing для веб-мастеров предлагают практически все, что делает Google Search Console, и хотя вы можете не использовать их так часто, их обязательно следует включить в вашу общую стратегию SEO.

Получите все свои приложения, базы данных и сайты WordPress онлайн и под одной крышей. Наша многофункциональная высокопроизводительная облачная платформа включает в себя:

- Простая настройка и управление в панели управления MyKinsta

- Экспертная поддержка 24/7

- Лучшее оборудование и сеть Google Cloud Platform на базе Kubernetes для максимальной масштабируемости

- Интеграция Cloudflare корпоративного уровня для скорости и безопасности

- Глобальный охват аудитории с 35 центрами обработки данных и 260 точками присутствия по всему миру

Начните с бесплатной пробной версии нашего хостинга приложений или хостинга баз данных. Ознакомьтесь с нашими планами или поговорите с отделом продаж, чтобы найти наиболее подходящий вариант.

Что это такое и как им пользоваться

Вы когда-нибудь слышали термин robots.txt и задавались вопросом, как он применим к вашему веб-сайту? На большинстве веб-сайтов есть файл robots. txt, но это не значит, что большинство владельцев сайтов понимают его. В этом посте мы надеемся изменить это, предложив подробно изучить файл robots.txt WordPress, а также то, как он может контролировать и ограничивать доступ к вашему сайту.

txt, но это не значит, что большинство владельцев сайтов понимают его. В этом посте мы надеемся изменить это, предложив подробно изучить файл robots.txt WordPress, а также то, как он может контролировать и ограничивать доступ к вашему сайту.

Нам предстоит многое рассказать, так что давайте начнем!

Что такое файл robots.txt WordPress?

Прежде чем мы поговорим о файле robots.txt WordPress, важно определить, что такое «робот» в данном случае. Роботы — это «боты» любого типа, которые посещают веб-сайты в Интернете. Наиболее распространенным примером являются сканеры поисковых систем. Эти боты «ползают» по сети, помогая таким поисковым системам, как Google, индексировать и ранжировать миллиарды страниц в Интернете.

Итак, боты есть, вообще , хорошая штука для интернета… ну или хотя бы нужная вещь. Но это не обязательно означает, что вы или другие владельцы сайтов хотите, чтобы боты свободно бегали. Желание контролировать взаимодействие веб-роботов с веб-сайтами привело к созданию в середине 1990-х годов стандарта исключения роботов . Robots.txt является практической реализацией этого стандарта — , он позволяет вам контролировать, как участвующие боты взаимодействуют с вашим сайтом . Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Robots.txt является практической реализацией этого стандарта — , он позволяет вам контролировать, как участвующие боты взаимодействуют с вашим сайтом . Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Однако эта часть «участия» важна. Robots.txt не может заставить бота следовать его указаниям. А вредоносные боты могут и будут игнорировать файл robots.txt. Кроме того, даже авторитетные организации игнорируют некоторые команды, которые вы можете поместить в robots.txt. Например, Google будет игнорировать любые правила, которые вы добавите в файл robots.txt о том, как часто его поисковые роботы посещают ваш сайт. Вы можете настроить скорость, с которой Google сканирует ваш веб-сайт, на странице настроек скорости сканирования вашего ресурса в Google Search Console.

Если у вас много проблем с ботами, может пригодиться защитное решение, такое как Cloudflare или Sucuri.

Как найти robots.

txt?

txt?Файл robots.txt находится в корне вашего веб-сайта, поэтому добавление /robots.txt после вашего домена должно загрузить файл (если он у вас есть). Например, https://kinsta.com /robots.txt .

Когда следует использовать файл robots.txt?

Для большинства владельцев сайтов преимущества хорошо структурированного файла robots.txt сводятся к двум категориям:

- Оптимизация ресурсов сканирования поисковых систем путем указания им не тратить время на страницы, которые вы не хотите индексировать. Это помогает поисковым системам сосредоточиться на сканировании наиболее важных для вас страниц.

- Оптимизация использования сервера путем блокировки ботов, которые тратят ресурсы впустую.

Robots.txt не предназначен конкретно для управления тем, какие страницы индексируются в поисковых системах

Robots.txt не является надежным способом управления тем, какие страницы индексируются поисковыми системами. Если вашей основной целью является предотвращение включения определенных страниц в результаты поисковой системы, правильным подходом является использование мета-тега noindex или защиты паролем.

Это связано с тем, что файл robots.txt прямо не указывает поисковым системам не индексировать контент — он просто говорит им не сканировать его. Хотя Google не будет сканировать отмеченные области внутри вашего сайта, сам Google заявляет, что если внешний сайт ссылается на страницу, которую вы исключаете с помощью файла robots.txt, Google все равно может проиндексировать эту страницу.

Джон Мюллер, аналитик Google для веб-мастеров, также подтвердил, что если на страницу есть ссылки, указывающие на нее, даже если она заблокирована файлом robots.txt, она все равно может быть проиндексирована. Ниже приводится то, что он сказал в видеовстрече Webmaster Central:

Здесь следует иметь в виду одну вещь: если эти страницы заблокированы robots.txt, то теоретически может случиться так, что кто-то случайно свяжется с одной из этих страниц. И если они это сделают, то может случиться так, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован robots.

txt. Таким образом, мы не знали бы, что вы не хотите, чтобы эти страницы действительно индексировались.

Принимая во внимание, что если они не заблокированы robots.txt, вы можете поместить на эти страницы метатег noindex. И если кто-то ссылается на них, и мы случайно просканируем эту ссылку и подумаем, что, может быть, здесь есть что-то полезное, тогда мы будем знать, что эти страницы не нужно индексировать, и мы можем просто полностью исключить их из индексации.

Итак, в этом отношении, если на этих страницах есть что-то, что вы не хотите индексировать, не запрещайте их, вместо этого используйте noindex .

Нужен ли мне файл robots.txt?

Важно помнить, что у вас нет файла robots.txt на вашем сайте. Если у вас нет проблем с тем, что все боты могут свободно сканировать все ваши страницы, вы можете не добавлять их, поскольку у вас нет реальных инструкций для сканеров.

В некоторых случаях вы даже не сможете добавить файл robots. txt из-за ограничений используемой вами CMS. Это нормально, но есть и другие способы проинструктировать ботов о том, как сканировать ваши страницы без использования файла robots.txt.

txt из-за ограничений используемой вами CMS. Это нормально, но есть и другие способы проинструктировать ботов о том, как сканировать ваши страницы без использования файла robots.txt.

Какой код состояния HTTP должен быть возвращен для файла robots.txt?

Файл robots.txt должен возвращать код состояния HTTP 200 OK, чтобы поисковые роботы могли получить к нему доступ.

Если у вас возникли проблемы с индексацией ваших страниц поисковыми системами, стоит дважды проверить код состояния, возвращенный для вашего файла robots.txt. Все, кроме кода состояния 200, может помешать поисковым роботам получить доступ к вашему сайту.

Некоторые владельцы сайтов сообщают о деиндексации страниц из-за того, что их файл robots.txt возвращает статус, отличный от 200. В марте 2022 года владелец веб-сайта спросил о проблеме с индексацией во время встречи Google SEO в рабочее время, и Джон Мюллер объяснил, что файл robots.txt должен либо возвращать статус 200, если они присутствуют, либо статус 4XX, если файл не существовать. В этом случае возвращалась внутренняя ошибка сервера 500, которая, по словам Мюллера, могла привести к тому, что робот Googlebot исключил сайт из индексации.

В этом случае возвращалась внутренняя ошибка сервера 500, которая, по словам Мюллера, могла привести к тому, что робот Googlebot исключил сайт из индексации.

То же самое можно увидеть в этом твите, где владелец сайта сообщил, что весь его сайт деиндексирован из-за того, что файл robots.txt возвращает ошибку 500.

[Совет по поисковой оптимизации]

Если у вас возникли проблемы с индексированием, убедитесь, что ваш файл robots.txt возвращает либо 200, либо 404.

Если ваш файл возвращает 500, Google в конечном итоге деиндексирует ваш веб-сайт, как я видел в этом проекте. pic.twitter.com/8KiYLgDVRo

— Антуан Эрипрет (@antoineripret) 14 ноября 2022 г.

Можно ли использовать метатег Robots вместо файла robots.txt?

Нет. Метатег robots позволяет вам контролировать, какие страницы индексируются, а файл robots.txt позволяет вам контролировать, какие страницы сканируются. Боты должны сначала просканировать страницы, чтобы увидеть метатеги, поэтому вам следует избегать попыток использовать метатеги disallow и noindex, так как noindex не будет обнаружен.

Боты должны сначала просканировать страницы, чтобы увидеть метатеги, поэтому вам следует избегать попыток использовать метатеги disallow и noindex, так как noindex не будет обнаружен.

Если ваша цель — исключить страницу из поисковых систем, метатег noindex обычно является лучшим вариантом.

Как создать и отредактировать файл robots.txt в WordPress

По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Так что, даже если вы и пальцем не пошевелите, на вашем сайте уже должен быть файл robots.txt по умолчанию. Вы можете проверить, так ли это, добавив «/robots.txt» в конец вашего доменного имени. Например, «https://kinsta.com/robots.txt» открывает файл robots.txt, который мы используем здесь, в Kinsta.

Пример файла robots.txt

Вот пример файла robots.txt от Kinsta:

Пример файла robots.txt Это предоставляет всем роботам инструкции о том, какие пути игнорировать (например, путь wp-admin) с любыми исключениями (например, admin-ajax. php), а также расположение XML-карты сайта Kinsta.

php), а также расположение XML-карты сайта Kinsta.

Поскольку этот файл виртуальный, вы не можете его редактировать. Если вы хотите отредактировать файл robots.txt, вам нужно фактически создать физический файл на своем сервере, которым вы сможете манипулировать по мере необходимости. Вот три простых способа сделать это:

Как создать и отредактировать файл robots.txt в WordPress с помощью Yoast SEO

Если вы используете популярный плагин Yoast SEO, вы можете создать (а затем отредактировать) файл robots.txt прямо из интерфейса Yoast. Однако, прежде чем вы сможете получить к нему доступ, вам нужно добраться до SEO → Инструменты и нажать Редактор файлов

Перейдите в редактор файлов в Yoast SEOИ как только вы нажмете эту кнопку, вы сможете редактировать содержимое вашего файла robots.txt непосредственно из того же интерфейса, а затем сохраните все внесенные изменения.

Отредактируйте и сохраните изменения в файле robots. txt

txtЕсли у вас еще нет физического файла robots.txt, Yoast предложит вам вариант Создать файл robots.txt :

Создать файл robots.txt Как вы читаете дальше, мы углубимся в то, какие типы директив следует помещать в файл robots.txt WordPress.

Как создать и отредактировать файл robots.txt с All-in-One SEO

Если вы используете плагин Yoast All-in-One SEO Pack , который почти так же популярен, вы также можете создавать и редактировать ваш файл WordPress robots.txt прямо из интерфейса плагина. Все, что вам нужно сделать, это перейти к All-in-One SEO → Инструменты :

Как перейти к robots.txt в All-in-One SEOЗатем включите радиокнопку Enable Custom robots.txt , чтобы она была включена. Это позволит вам создавать собственные правила и добавлять их в файл robots.txt:

Как добавить собственные правила в robots.txt в All-in-One SEOКак создать и отредактировать файл robots.

txt через FTP

txt через FTPЕсли вы не используете SEO-плагин, предлагающий функциональность robots.txt, вы все равно можете создавать файл robots.txt и управлять им через SFTP. Сначала с помощью любого текстового редактора создайте пустой файл с именем «robots.txt»:

Как создать собственный файл Robots.txtЗатем подключитесь к своему сайту через SFTP и загрузите этот файл в корневую папку вашего сайта. Вы можете внести дополнительные изменения в файл robots.txt, отредактировав его через SFTP или загрузив новые версии файла.

Что поместить в файл robots.txt

Хорошо, теперь у вас есть физический файл robots.txt на вашем сервере, который вы можете редактировать по мере необходимости. Но что вы на самом деле делаете с этим файлом? Что ж, как вы узнали из первого раздела, robots.txt позволяет вам контролировать, как роботы взаимодействуют с вашим сайтом. Вы делаете это с помощью двух основных команд:

- User-agent — позволяет настроить таргетинг на определенных ботов.

Пользовательские агенты — это то, что боты используют для идентификации себя. С ними можно было бы, например, создать правило, применимое к Bing, но не к Google.

Пользовательские агенты — это то, что боты используют для идентификации себя. С ними можно было бы, например, создать правило, применимое к Bing, но не к Google. - Disallow — позволяет запретить роботам доступ к определенным областям вашего сайта.

Существует также команда Разрешить , которую вы будете использовать в определенных ситуациях. По умолчанию все на вашем сайте отмечено цифрой 9.0003 Разрешить , так что в 99% случаев нет необходимости использовать команду Разрешить . Но это удобно, когда вы хотите запретить доступ к папке и ее дочерним папкам, но разрешить доступ к одной конкретной дочерней папке.

Чтобы добавить правила, сначала укажите, к какому User-agent должно применяться правило, а затем укажите, какие правила следует применять, используя Disallow и Allow . Есть также некоторые другие команды, такие как Задержка сканирования и Карта сайта , но это либо:

- Игнорируется большинством основных поисковых роботов, либо интерпретируется совершенно по-разному (в случае задержки сканирования)

- Излишне использовать такие инструменты, как Google Search Console (для карт сайта)

Давайте рассмотрим некоторые конкретные варианты использования, чтобы показать вам, как все это сочетается.

Как использовать Robots.txt Запретить все, чтобы заблокировать доступ ко всему вашему сайту

Допустим, вы хотите заблокировать все доступ сканера к вашему сайту. Это вряд ли произойдет на живом сайте, но пригодится для сайта разработки. Для этого вы должны добавить robots.txt запрещающий весь код в ваш файл robots.txt WordPress:

User-agent: * Disallow: /

Что происходит в этом коде?

Звездочка * рядом с User-agent означает «все пользовательские агенты». Звездочка — это подстановочный знак, означающий, что он применяется к каждому отдельному пользовательскому агенту. / косая черта рядом с Disallow говорит, что вы хотите запретить доступ к всем страницам, которые содержат «yourdomain.com/» (то есть каждая отдельная страница на вашем сайте).

Как использовать robots.txt, чтобы заблокировать доступ одного бота к вашему сайту

Давайте изменим ситуацию. В этом примере мы притворимся, что вам не нравится тот факт, что Bing сканирует ваши страницы. Вы все время являетесь командой Google и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать только Bing от сканирования вашего сайта, вы должны заменить подстановочный знак *звездочка с Bingbot:

В этом примере мы притворимся, что вам не нравится тот факт, что Bing сканирует ваши страницы. Вы все время являетесь командой Google и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать только Bing от сканирования вашего сайта, вы должны заменить подстановочный знак *звездочка с Bingbot:

Агент пользователя: Bingbot Disallow: /

По сути, приведенный выше код говорит, что только применяют правило Disallow к ботам с агентом пользователя «Bingbot» . Теперь вы вряд ли захотите заблокировать доступ к Bing, но этот сценарий пригодится, если есть конкретный бот, которому вы не хотите получать доступ к своему сайту. На этом сайте есть хороший список имен большинства известных пользовательских агентов службы.

Как использовать robots.txt для блокировки доступа к определенной папке или файлу

В этом примере предположим, что вы хотите заблокировать доступ только к определенному файлу или папке (и ко всем подпапкам этой папки). Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

- Всю папку wp-admin

- WP-логин.php

Вы можете использовать следующие команды:

Агент пользователя: * Запретить: /wp-admin/ Disallow: /wp-login.php

Как использовать robots.txt Разрешить все, чтобы предоставить роботам полный доступ к вашему сайту

Если в настоящее время у вас нет причин блокировать доступ сканеров к любой из ваших страниц, вы можете добавить следующую команду.

Агент пользователя: * Позволять: /

Или альтернативно:

User-agent: * Запретить:

Как использовать Robots.txt, чтобы разрешить доступ к определенному файлу в запрещенной папке

Хорошо, теперь предположим, что вы хотите заблокировать всю папку, но при этом хотите разрешить доступ к определенному файлу внутри этой папки. Вот где 9Команда 0003 Разрешить пригодится. И это на самом деле очень применимо к WordPress. Фактически, виртуальный файл robots.txt WordPress прекрасно иллюстрирует этот пример:

Фактически, виртуальный файл robots.txt WordPress прекрасно иллюстрирует этот пример:

User-agent: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

Этот фрагмент блокирует доступ ко всей папке /wp-admin/ , за исключением файла /wp-admin/admin-ajax.php .

Как использовать robots.txt, чтобы запретить ботам сканировать результаты поиска WordPress

Одна из настроек WordPress, которую вы, возможно, захотите сделать, — запретить поисковым роботам сканировать ваши страницы результатов поиска. По умолчанию WordPress использует параметр запроса «?s=». Итак, чтобы заблокировать доступ, все, что вам нужно сделать, это добавить следующее правило:

User-agent: * Запретить: /?s= Disallow: /search/

Это также может быть эффективным способом предотвращения программных ошибок 404, если вы их получаете. Обязательно прочитайте наше подробное руководство о том, как ускорить поиск в WordPress.

Как создать разные правила для разных ботов в robots.txt

До сих пор все примеры касались одного правила за раз. Но что, если вы хотите применить разные правила к разным ботам? Вам просто нужно добавить каждый набор правил в объявление User-agent для каждого бота. Например, если вы хотите создать одно правило, которое применяется к , ко всем ботам , а другое правило, которое применяется к , только к Bingbot , вы можете сделать это следующим образом:

User-agent: * Запретить: /wp-admin/ Агент пользователя: Bingbot Запретить: /

В этом примере всем ботам будет заблокирован доступ к /wp-admin/, но Bingbot будет заблокирован доступ ко всему вашему сайту.

Проверка файла robots.txt

Чтобы убедиться, что файл robots.txt настроен правильно и работает должным образом, его следует тщательно протестировать. Один неуместный символ может иметь катастрофические последствия для производительности сайта в поисковых системах, поэтому тестирование может помочь избежать потенциальных проблем.

Тестер Google robots.txt

Инструмент Google robots.txt Tester (ранее входивший в состав Google Search Console) прост в использовании и выявляет потенциальные проблемы в вашем файле robots.txt.

Просто перейдите к инструменту и выберите свойство для сайта, который вы хотите протестировать, затем прокрутите страницу вниз и введите любой URL-адрес в поле, затем нажмите красную кнопку TEST :

Testing robots.txt filesЕсли все доступно для сканирования, вы увидите зеленый ответ Разрешено .

Вы также можете выбрать, с какой версией Googlebot вы хотите провести тест: Googlebot, Googlebot-News, Googlebot-Image, Googlebot-Video, Googlebot-Mobile, Mediapartners-Google или Adsbot-Google.

Вы также можете проверить каждый отдельный URL-адрес, который вы заблокировали, чтобы убедиться, что они действительно заблокированы и/или запрещены .

Остерегайтесь спецификации UTF-8

Спецификация означает метку порядка следования байтов и в основном является невидимым символом, который иногда добавляется в файлы старыми текстовыми редакторами и т. п. Если это произойдет с вашим файлом robots.txt, Google может неправильно его прочитать. Вот почему важно проверить файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется на непонимание синтаксиса. По сути, это делает первую строку нашего файла robots.txt недействительной, что нехорошо! У Гленна Гейба есть отличная статья о том, как UTF-8 Bom может убить ваш SEO.

п. Если это произойдет с вашим файлом robots.txt, Google может неправильно его прочитать. Вот почему важно проверить файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется на непонимание синтаксиса. По сути, это делает первую строку нашего файла robots.txt недействительной, что нехорошо! У Гленна Гейба есть отличная статья о том, как UTF-8 Bom может убить ваш SEO.

Робот Google в основном базируется в США

Также важно не блокировать робота Googlebot из США, даже если вы ориентируетесь на локальный регион за пределами США. Иногда они выполняют локальное сканирование, но Googlebot в основном базируется в США .

Робот Google в основном базируется в США, но иногда мы также выполняем локальное сканирование. https://t.co/9KnmN4yXpe

— Google Search Central (@googlesearchc) 13 ноября 2017 г.

Что популярные сайты WordPress помещают в свой файл robots.

txt

txtЧтобы на самом деле представить некоторый контекст для перечисленных выше пунктов, вот как некоторые из самых популярных сайтов WordPress используют свои файлы robots.txt.

TechCrunch

TechCrunch Robots.txt FileПомимо ограничения доступа к ряду уникальных страниц, TechCrunch, в частности, запрещает поисковым роботам:

- /wp-admin/

- /wp-логин.php

Также установлены специальные ограничения на двух ботов:

- Swiftbot

- ИРЛбот

Если вам интересно, IRLbot — это поисковый робот из исследовательского проекта Техасского университета A&M. Странно!

Фонд Обамы

Фонд Обамы Файл Robots.txtФонд Обамы не вносил никаких специальных дополнений, ограничивая доступ исключительно к /wp-admin/.

Angry Birds

Angry Birds Файл Robots.txtAngry Birds имеет те же настройки по умолчанию, что и Фонд Обамы. Ничего особенного не добавляется.

Дрифт

Дрейф Robots. txt Файл

txt ФайлНаконец, Drift решает определить свои карты сайта в файле Robots.txt, но в остальном оставляет те же ограничения по умолчанию, что и The Obama Foundation и Angry Birds.

Правильно используйте Robots.txt

Завершая руководство по robots.txt, мы хотим еще раз напомнить вам, что использование команды Disallow в файле robots.txt не равнозначно использованию команды Тег noindex . Robots.txt блокирует сканирование, но не обязательно индексирование. Вы можете использовать его, чтобы добавить определенные правила, определяющие взаимодействие поисковых систем и других ботов с вашим сайтом, но он не будет явно контролировать, индексируется ли ваш контент или нет.

Большинству случайных пользователей WordPress нет необходимости в срочном изменении стандартного виртуального файла robots.txt. Но если у вас возникли проблемы с определенным ботом или вы хотите изменить способ взаимодействия поисковых систем с определенным плагином или темой, которую вы используете, вы можете добавить свои собственные правила.