Как проверить 100 тысяч страниц на вхождение в индекс Google — инструкция — Маркетинг на vc.ru

О скрипте, который проверяет, проиндексировал ли бот Google нужные страницы огромного сайта, рассказывает SEO-специалист новостного проекта info-kurs.com Андрей Верстаков в своем материале для ppc.world.

1068 просмотров

Для специалиста по поисковой оптимизации понимание того, как Google и другие поисковые системы сканируют и индексируют веб-сайт, является одним из главных приоритетов. Однако получить необходимые данные для анализа сотен тысяч страниц не так просто, как хотелось бы.

Первое, о чем подумает опытный SEO-гуру, — это автоматическая обработка лог-файла визитов сайта, чтобы отследить посещения робота Google. Но само посещение еще не гарантирует добавление страницы в индекс. У нас сотни тысяч страниц находятся в индексе, поэтому мы задумались о разработке надежного способа получения данных о статусе индексации Google.

В этом материале мы поговорим:

- почему важно знать статус индексации сайта;

- о решении этой задачи с помощью кастомного инструмента проверки индексации;

- как проверить индексацию сайта самостоятельно.

Почему важно знать статус индексации сайта

Если вы крупный издатель, то наверняка хотите привлечь потенциальных пользователей или клиентов на сайт из поиска Google. Если веб-сайт (или его часть) не проиндексирован, вы не будете отображаться в результатах поиска и потеряете любой потенциальный органический трафик, конверсии или рекламный инвентарь останется невостребованным.

Но может быть и обратная проблема. Если веб-сайт создает URL-адреса в геометрической прогрессии (обычная проблема на сайтах электронной торговли) или допускает неконтролируемый пользовательский контент, то Google может сканировать и индексировать больше, чем следовало бы. Это может быстро привести к огромной неэффективности в ущерб основной архитектуре сайта. В этом случае страницы, которые представляют пользу для издателя будут отдаваться сервером медленнее, именно потому что сервер тратит много времени на отработку запросов бота Google. Поэтому реальный человек, когда зайдет на сайт, получит контент медленнее или вообще не получит, так как сервер сбросит его соединение по таймауту.

Распространенные проблемы при сборе данных об индексации Google

Скорее всего, для сбора данных индексации вы используете Google Search Console или стороннее решение. Однако оба варианта имеют свой набор недостатков, когда дело доходит до проверки индексирования сотен тысяч страниц. Обычно они связаны с доступностью данных и точностью результатов. Это те проблемы, с которыми столкнулись мы.

Ограничения Google Search Console

Google Search Console (GSC) — достоверный и точный источник данных о статусе индексации, ведь он подключен к системе индексирования Google. В GSC есть три суперполезных отчета, которые предоставляют данные о статусе индексации: инструмент URL Inspector, отчет о покрытии и отчет о файлах Sitemap.

Однако ни один из этих отчетов не подходит для крупномасштабных веб-сайтов, поскольку GSC ограничивает количество URL-адресов, которые вы можете проверять в день (50 URL для инспектора, и по 1000 URL в остальных отчетах).

Мы хорошо знаем об этом, потому что нам приходилось автоматизировать работу браузера для работы с URL Inspector Tool. Возможно, мы поделимся этим драгоценным опытом в новой статье.

Теоретически отчет о покрытии и отчет о файлах Sitemap могут помочь, но, к сожалению, Google Search Console ограничивает отчет об экспорте до 1000 строк данных, и сейчас нет доступа к API для извлечения большего количества.

GSC ограничивает экспорт до 1000 URL, но у нас сотни тысяч страниц… Спасибо Google 🙂

Наверное, единственный способ обойти это ограничение — разделить всю архитектуру сайта на XML-карты объемом не более 1000 URL-адресов. Следовательно, если на сайте есть 100 000 (известных / важных) URL-адресов, потребуется создать 100 XML-файлов Sitemap. Но этим было бы очень сложно управлять, и поэтому не вариант.

Кроме того, это не даст вам необходимых данных для индексации неконтролируемых URL-адресов, созданных с помощью фасетной навигации или пользовательского контента.

Ограничения URL Profiler

В некоторых случаях профилировщик URL был подходящим вариантом для сбора данных индексации. Хотя нам нравится этот инструмент для решения других задач, мы поняли, что у него много проблем с получением точных данных для «нечистых» URL.

Некоторые примеры включают параметризованные URL-адреса, URL-адреса с закодированными символами, URL-адреса с различным регистром букв и URL-адреса с небезопасными символами.

Решение: кастомный инструмент проверки индексации

Чтобы обойти ограничения, с которыми сталкиваются большинство SEO-специалистов, работающих с крупными проектами, мы разработали специальный скрипт для проверки индексации.

Он может проверять неограниченное количество URL-адресов с любыми типами проблемных символов: параметры, кодировка, зарезервированные символы, небезопасные символы, разные алфавиты — если Google проиндексировал страницу, наш скрипт подтвердит это.

Как настроить скрипт

Вам понадобятся начальные знания о командной строке и немного о node. js. Скорее всего, этого будет достаточно.

js. Скорее всего, этого будет достаточно.

Сначала установите последнюю версию Node.js на свой компьютер. Затем загрузите или клонируйте наш репозиторий с GitHub.

Откройте командную строку и перейдите в папку, которую вы только что скачали. Затем установите необходимые зависимости, используя следующую команду:

npm install

Раньше, если бы вам приходилось парсить результаты поиска Google, понадобилось бы много прокси-серверов, но благодаря ребятам из ScraperAPI это больше не проблема. У них есть тысячи прокси по всему миру, поэтому всё, что вам нужно сделать, — это отправить запрос, используя вызов через их API, они будут выполнять ротацию прокси в фоновом режиме. Как это сделать, читайте дальше.

Перейдите на сайт ScraperAPI и создайте учетную запись. Первые 1000 запросов в месяц бесплатны, этого более чем достаточно для тестирования нашего скрипта, а за $29 можно проверить 250 000 страниц.

Зайдите в свой аккаунт и получите свой API-ключ.

Добавьте свой ключ API в файл APIKEY.

Пора запускать скрипт

Теперь добавьте список URL-адресов, которые вы хотите проверить на индексирование Google и сохраните его без заголовков в виде CSV с именем urls.csv в папке, которую скачали. Обязательно используйте полные URL-адреса с протоколом.

Если у вас нет списка, вы можете использовать наш список сложных URL. Мы подготовили его, когда разрабатывали скрипт, и он включает почти все проблемные типы URL-адресов, а также несколько поддельных URL-адресов, чтобы проверить, не было ли ложных срабатываний.

Перейдите в обратно в командную строку и запустите скрипт с помощью следующей команды:

npm run start

Работа скрипта началась. Теперь вы должны увидеть URL-адреса из вашего CSV, появляющиеся в командной строке с кодом ответа сервера.

Поскольку скрипт использует прокси, иногда вы будете получать код состояния 500. Ничего страшного:, скрипт повторно обработает эти ошибки и повторно запустит список, пока не будут проверены все URL-адреса.

По завершении сценария вы получите сообщение об успешном выполнении и новый файл с именем results.csv. Внутри вы найдете список URL-адресов с указанием статуса индексации.

В среднем проверка 2500 URL-адресов занимает около часа, поэтому если вы планируете использовать этот скрипт для тысяч URL-адресов, имейте это в виду.

Больше материалов по digital-маркетингу читайте на ppc.world.

Как проверить индексацию страниц сайта в поисковых системах Яндекс и Google

- Поделиться статьей

- Прочитать позже

Содержание статьи:

Нам часто задают вопрос: “Как узнать проиндексирован ли сайт в Яндексе?”. На этом же месте может быть и Google, и просто поисковые системы в целом. Ведь иногда ресурс подготовлен к продвижению, открыт для индексации, но трафика так и нет. В этом случае непонятно что делать: просто ещё немного подождать или трафик так и не придёт, потому что поисковая система просто не проиндексировала сайт? Давайте разбираться, как всё это работает.

Что такое индексация и зачем её контролировать?

Индексация — это процесс, во время которого поисковые системы добавляют в свою базу информацию о конкретном сайте. Новый ресурс, который создали только вчера, не будет в тот же день показываться в поисковиках. Сначала поисковые роботы должны зайти на него, разобраться, что можно, а что нельзя сканировать, собрать информацию, оценить её и только потом представить пользователям. И так происходит всегда: даже если ресурс существует давно, при добавлении новых страниц и разделов все они проходят через индексацию.

Полностью понять, как проходит индексация, сложно. Ни Яндекс, ни Google не раскрывают точных алгоритмов.

Сайт может как попасть в индекс, так и вылететь из него. Это значит, что ни один пользователь не увидит его в поисковой выдаче. А следовательно трафик на ресурс заметно снизится и потянет за собой количество клиентов. Вот почему важно контролировать индексацию не только на этапе создания, но и в остальное время.

Проверка индексации сайта

Теперь давайте разберёмся, как проверить, верно ли проиндексирован ваш сайт. Основные способы — ниже.

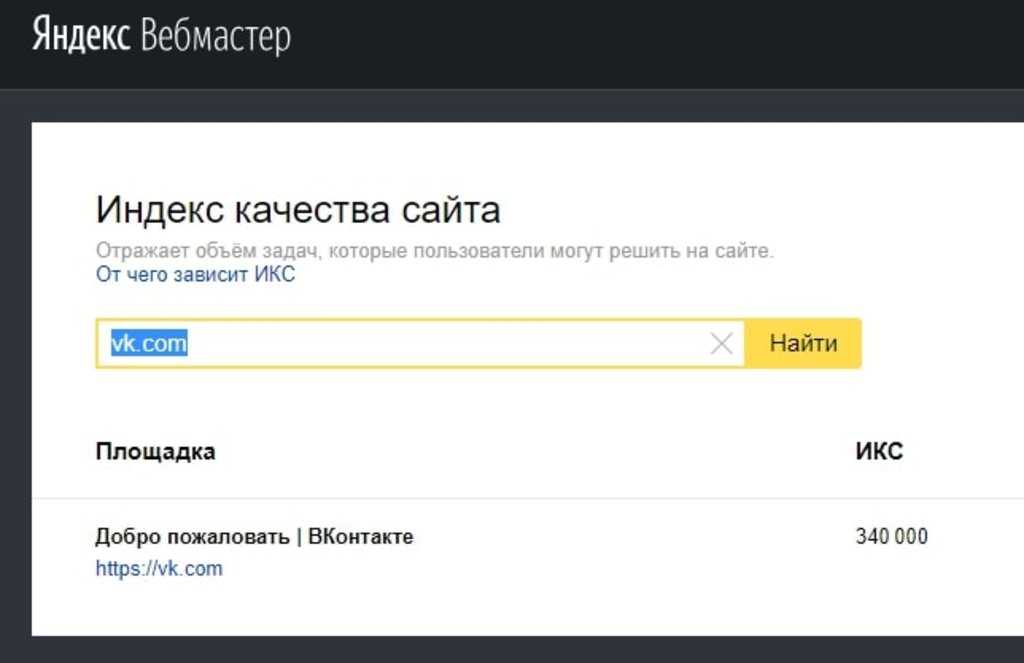

- Проверка через Яндекс.Вебмастер

Проиндексирован ли ресурс в Яндексе, можно проверить в панели Вебмастера. Для этого в левой колонке выберите раздел “Индексирование”, а потом перейдите на “Страницы в поиске”.

В разделе “Все страницы” вы увидите все проиндексированные материалы. В исключённых можно найти то, что, наоборот, не индексируется в поиске.

Также общее количество страниц и число тех, что находятся в поиске, можно увидеть в списке “Мои сайты”.

- Проверка через Google Search Console

Как посмотреть индексацию сайта в Google? Именно через этот инструмент.

Заходим в раздел “Индекс”, а потом на вкладку “Страницы”. Там мы увидим количество проиндексированных и не проиндексированных материалов. Это число примерное, потому что что-что роботы могли ещё не успеть просканировать.

Заходим в раздел “Индекс”, а потом на вкладку “Страницы”. Там мы увидим количество проиндексированных и не проиндексированных материалов. Это число примерное, потому что что-что роботы могли ещё не успеть просканировать.

Также ниже можно найти причины, по которым некоторых URL нет в индексе.

Индексацию отдельных страниц можно проверить в разделе “Проверка URL”. В строку поиска нужно ввести адрес, а система покажет, есть ли он в индексе. Также если вы недавно вносили какие-то изменения, здесь можно запросить повторное сканирование, чтобы информация в базе поисковой системы обновилась быстрее.

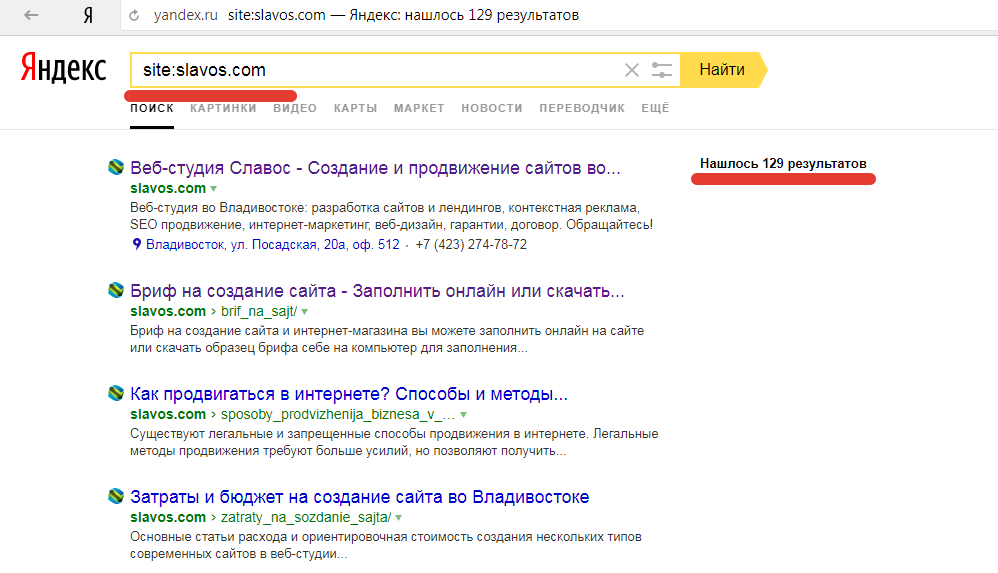

- Проверка с помощью операторов поисковой выдачи

Операторы — это специальные слова, которые помогают выполнить какие-то функции. В нашем случае пригодятся поисковые операторы, которые уточнят результаты выдачи. Их нужно подставить перед началом ссылки на страницу, отделить от неё двоеточием и ввести получившуюся комбинацию в строку поиска.

То есть выглядит это так: “оператор: ссылка”. Узнавать индексацию сайта в Яндексе и Google в этом случае придётся отдельно.

То есть выглядит это так: “оператор: ссылка”. Узнавать индексацию сайта в Яндексе и Google в этом случае придётся отдельно.

Для нужных нам целей существуют три оператора:

- Site. Позволяет увидеть, сколько страниц проиндексировано. Количество результатов в выдаче по запросу “site: ваш URL”, это и есть число страниц в индексе. Но этот способ не всегда показывает точные данные. Например, если результатов больше двух тысяч, то может возникнуть большая погрешность.

- Url. Помогает понять, показывается ли конкретная страница сайта в поисковой выдаче. Если она проиндексирована, по такому запросу найдётся только один результат.

- Host. Можно использовать, чтобы найти страницы только на конкретном домене. То есть если у вас есть поддомены для других городов, для проверки есть смысл воспользоваться именно этим методом.

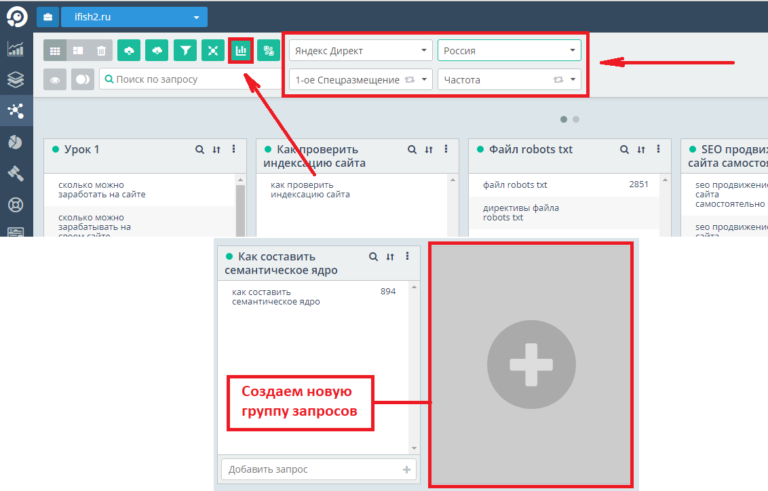

- Проверить индексацию с помощью инструментов для SEO

В программах, которые SEO-специалисты используют для работы, также есть функции для проверки индексации.

Например, это можно сделать через инструмент “Проверка индексации” от PR-CY. В поле вводится список страниц, которые нужно проверить, а потом выбирается поисковая система. После проверки программа просто показывает, есть URL в поиске или нет. Бесплатно можно проверить список до 10 ссылок, в платном до 500.

Например, это можно сделать через инструмент “Проверка индексации” от PR-CY. В поле вводится список страниц, которые нужно проверить, а потом выбирается поисковая система. После проверки программа просто показывает, есть URL в поиске или нет. Бесплатно можно проверить список до 10 ссылок, в платном до 500.

Ещё один пример — сервис Пиксель Тулс. На нём есть быстрый аудит сайта, где можно ввести нужный URL и посмотреть, сколько страниц проиндексировано в Яндексе и в Google с учётом поддоменов и без них. Сервис платный, но помимо этой там есть ещё много полезных для SEO функций.

- Проверка с помощью расширений для браузера

Также для быстрой проверки индексации существуют расширения, которые устанавливаются в браузер. Для примера разберём два из них.

Первое расширение — SEO-tools. В нём есть много инструментов для контроля продвижения ресурса, в том числе проверка индексации.

По сути сервис просто подставляет за вас операторы, о которых мы говорили выше, так что вам не нужно вбивать их вручную. Работает это так: вы заходите на необходимый адрес, открываете расширение, нажимаете на нужный значок в разделе индексации и система за вас подставляет к ссылке нужный оператор и перебрасывает вас в выдачу.

По сути сервис просто подставляет за вас операторы, о которых мы говорили выше, так что вам не нужно вбивать их вручную. Работает это так: вы заходите на необходимый адрес, открываете расширение, нажимаете на нужный значок в разделе индексации и система за вас подставляет к ссылке нужный оператор и перебрасывает вас в выдачу.

Ещё одно расширение называется ”SEO-анализ сайта от Be1.ru”. Здесь опять заходим на нужную страницу, открываем расширение и проматываем вниз. Появится раздел “Видимость страницы”, где будут указаны запросы, по которым она отображается в поиске. Соответственно, если блок будет пустым, она не проиндексирована.

Почему сайт или отдельная страница могут отсутствовать в индексе?

С тем, как проверить индексацию сайта, разобрались. Теперь давайте посмотрим, почему он всё-таки может быть не проиндексирован.

- Индексация запрещена в файле robots.

txt

txt

Robots.txt — это специальный файл, который отвечает за разрешение или запрет индексации. С его помощью можно закрыть весь ресурс, например, если вы вносите на него глобальные изменения и не хотите, чтобы он пока появлялся в поиске. Или можно запретить поисковым роботам заходить в разделы, которые содержат техническую или конфиденциальную информацию, не предназначенную для того, чтобы появляться в открытом доступе.

Но иногда что-то идёт не так и закрытыми оказываются части сайта, которые вы всё-таки хотели бы продвигать в поиске. Чтобы посмотреть, не относится ли эта ситуация к вам, можно зайти в файл robots.txt (он находится в корневой папке сайта) и посмотреть, что именно в нём закрыто от индексации. Также данные об этом можно найти в том же Яндекс.Вебмастере или Google Search Console. Рядом со списком проиндексированных страниц есть список страниц, которые исключены из индекса в этом файле.

- Индексирование закрыто метатегом noindex

Тег noindex используется, чтобы скрыть отдельные страницы или какую-то часть контента на них.

Например, в карточках товаров в интернет-магазинах часто бывает повторяющаяся информация про доставку и оплату, что может плохо повлиять на общую уникальность контента. Чтобы этого избежать, одинаковый текст скрывают с помощью тега noindex.

Например, в карточках товаров в интернет-магазинах часто бывает повторяющаяся информация про доставку и оплату, что может плохо повлиять на общую уникальность контента. Чтобы этого избежать, одинаковый текст скрывают с помощью тега noindex.

Здесь опять же может возникнуть какая-то ошибка, при которой скрытым окажется не то, что нужно. Чтобы это выяснить, нужно зайти в код страницы и найти в нём тег noindex. Если его там нет, значит этот вариант не объясняет отсутствие индексации.

- Запрет в файле .htaccess

Это ещё один полезный файл, который отвечает за работу сервера. В нём также можно прописать директивы, которые запретят индексирование. Файл .htaccess, как и robots.txt находится в корневой папке.

- Неправильные настройки CMS

Если ваш ресурс управляется с помощью CMS, то есть шанс, что индексирование запрещено в админпанели. В некоторых CMS также можно вносить правки в файл robots.

txt. Так что даже если вы никогда не видели этот файл, возможно, правки в него вносились через админпанель. Также в некоторых системах запрет индексации для новых ресурсов стоит по умолчанию, так что его нужно просто отключить.

txt. Так что даже если вы никогда не видели этот файл, возможно, правки в него вносились через админпанель. Также в некоторых системах запрет индексации для новых ресурсов стоит по умолчанию, так что его нужно просто отключить.

- Сайт новый и/или слишком большой

Иногда бывает так, что вы только создали свежий ресурс или добавили какой-то новый раздел, и теперь с нетерпением проверяете, проиндексирован ли сайт, но этого всё не происходит. Индексация занимает довольно много времени, поэтому роботы просто могли ещё не успеть проанализировать ваш ресурс. В целом на полную индексацию среднего сайта понадобится до месяца, а если ресурс крупный — то ещё больше.

Помочь роботам быстрее собрать информацию поможет наличие карты сайта. Это специальная страница, где подробно описана структура ресурса. Таким образом робот ничего не упустит и отсканирует все важные элементы. Карту можно сравнить с оглавлением: искать информацию по нему намного легче, чем просто листая книгу.

Карту нужно постоянно обновлять, чтобы данные не устаревали. Либо, если у вас часто появляется новый контент, есть смысл сделать её динамичной. Иначе можно только запутать поисковых роботов и навредить массовой индексации.

Карту нужно постоянно обновлять, чтобы данные не устаревали. Либо, если у вас часто появляется новый контент, есть смысл сделать её динамичной. Иначе можно только запутать поисковых роботов и навредить массовой индексации.

Также существует понятие краулингового бюджета. Это количество страниц, которое поисковый робот может отсканировать за одно посещение. У каждого сайта бюджет свой, а формула его расчёта точно неизвестна. Рекомендации по тому, как оптимизировать краулинговый бюджет и сделать так, чтобы роботы быстрее анализировали ресурс, мы дадим в последнем разделе статьи.

- На вас наложили санкции

За использование запрещённых методов продвижения поисковые системы могут накладывать на ресурсы санкции. Одна из таких мер — снижение количества отображаемых в выдаче страниц.

Проблема здесь в том, что во многих ситуациях нельзя точно сказать, есть ли на вас санкции. В некоторых случаях вы можете получить письмо с уведомлением от поисковой системы, а в некоторых ресурс просто резко перестанет отображаться в выдаче.

Но если вы пользовались скрытым контентом, накруткой поведенческих факторов или другими приёмами чёрного SEO, точно есть смысл рассматривать санкции в качестве причины выпадения из индекса. Также часто в этом случае сайт может продолжать индексироваться в одном поисковике, но отсутствовать в другом.

Но если вы пользовались скрытым контентом, накруткой поведенческих факторов или другими приёмами чёрного SEO, точно есть смысл рассматривать санкции в качестве причины выпадения из индекса. Также часто в этом случае сайт может продолжать индексироваться в одном поисковике, но отсутствовать в другом.

- Сайт взрослый, но на нём редко обновляется контент

Если контент публикуется редко, со временем поисковые роботы понимают, что слишком часто посещать ресурс не имеет смысла, ведь ничего нового на нём не появляется. Это приводит к тому, что при обновлении роботы могут нескоро зайти к вам, поэтому сканирования приходится ждать долго.

Как сделать так, чтобы страницы сайта быстрее появлялись в индексе?

Вот несколько основных советов:

- Регулярно обновлять контент. Например, можно завести раздел блога или пополнять ассортимент новыми товарами (для интернет-магазинов).

- Подготовить карту сайта (если её ещё нет).

Если контент обновляется очень часто, сделать карту динамической.

Если контент обновляется очень часто, сделать карту динамической. - Работать со скоростью загрузки. Всё логично: чем быстрее грузится ваш сайт, тем быстрее роботы могут его отсканировать.

- Избавиться от дублей страниц. Если краулинговый бюджет тратится на сканирование одних и тех же дублей, индексацию действительно важного контента можно ждать очень долго.

- Устранить ненужные редиректы, битые ссылки и мусорные страницы. На них тоже бесполезно тратится краулинговый бюджет. Ведь роботы переходят на несуществующие страницы и сканируют бесполезный контент.

- Настроить перелинковку. Если все страницы связаны между собой внутренними ссылками, роботам также проще просканировать их. Это ещё одно хорошее дополнение к карте сайта.

- Принудительно отправлять на индексирование. В Google это легко сделать через Search Console.

Вернуться к оглавлению

- Поделиться статьей

Оцените статью

Наши услуги по теме:

SEO

оптимизация

Продвижение сайта

на лидирующие позиции в поиске

Подробнее

Рекомендуем прочитать

Индексация сайта: что это за процесс и как его ускорить

Как закрыть сайт от индексации поисковыми системами: 3 основных способа

В каких случаях может понадобиться закрыть поисковым роботам доступ к сайту и как это сделать.

Найти публикацию Персональные закладки

Все рубрики

- Все статьи

- LP и сайты

- SEO Оптимизация

- Аналитика

- Заметки специалиста

- Контекстная реклама

- Отдел продаж

- Продвижение в интернете

- Управление репутацией

Подпишитесь на полезный контент

Есть интересный проект?

Давайте его обсудим!

Обсудить проект

Наш Telegram канал @ SoldiMarketing -присоединяйтесь

Обсуждения

Полезное видео каждую неделю. Подписывайся!

Подписаться

Гостевой постинг: важные аспекты размещения и продвижения через внешние ресурсы.

Продающий лендинг: что это, для чего нужен, как сделать и продвигать | landing page | лэндинг

Все о Яндекс Кью | Экспертность | Узнаваемость бренда | Теплый трафик на сайт и лиды

12 инструментов как повысить узнаваемость бренда | Как отслеживать узнаваемость бренда?

12 причин почему сайт не может попасть в ТОП. Как продвинуть сайт в ТОП? SEO продвижение сайта

Как продвинуть сайт в ТОП? SEO продвижение сайта

10 самых частых ошибок на сайте, которые убивают конверсию. Технический аудит сайта Конверсия сайта

Сквозная аналитика: что это и зачем. Как увеличить доход от интернет маркетинга? Roistat

SEO 2021. 16 трендов SEO продвижение сайта

Продвижение сайта 2021. Внешние ссылки: 12 критериев выбора. Seo audit

Бесплатный трафик на сайт. ТОП-8 инструментов. Рабочие схемы

Аудит сайта: эти 13 ОШИБОК есть у КАЖДОГО третьего. SEO audit

Внедрение CRM системы в отделе продаж ➤ 7 ФИШЕК, чтобы все заработало | Бизнес идеи

Работа с отзывами в интернете. Как НЕ ТЕРЯТЬ клиентов и работать с негативом?

SEO продвижение. Где и у кого заказать? SEO-специалист или агентство? ОШИБКИ при выборе

Разработка сайта для продвижения. Как УВЕЛИЧИТЬ КОНВЕРСИЮ сайта, лендинга с 6,2% до 21%?

Контекстная реклама. Сколько стоит настройка Яндекс.Директ и Google.AdWords (Ads) 2020?

Вернуться к оглавлениюКак проверить, проиндексированы ли веб-страницы в Google

Вы можете проверить, индексируются ли URL-адреса вашего веб-сайта в Google, воспользовавшись API проверки URL-адресов Search Console, который вы можете подключить к Sitebulb через интеграцию Google Search Console.

Это может позволить вам увидеть данные высокого уровня о том, индексируется ли URL-адрес или нет, а также «причины», по которым URL-адреса не индексируются, что позволяет вам исследовать дальше.

Для ясности: возвращаемые данные — это данные, которые Google Search Console хранит для заданного URL-адреса. API будет возвращать информацию об индексации, которая в настоящее время доступна в инструменте проверки URL-адресов. Что делает Sitebulb, так это позволяет вам собирать эти данные в большом количестве.

Подключение Sitebulb к API проверки URL-адресов

Чтобы подключить Sitebulb к API проверки URL-адресов, добавьте Google Search Console в настройки аудита при настройке проекта и установите флажок в разделе Конфигурация Опции для Извлечь данные URL из Search Console Inspection API .

На этом этапе важно убедиться, что вы выбрали правильное свойство. Sitebulb поможет вам сделать это, предварительно выбрав свойство путем сопоставления с начальным URL-адресом, но у вас может быть несколько свойств для одной и той же учетной записи (например, свойства домена и свойства на уровне URL).

Ограничение дневной квоты

Основное предостережение этой функции заключается в том, что Google ограничивает количество запросов до 2000 URL-адресов в день для каждого свойства веб-сайта Search Console (т. е. вызовов, запрашивающих один и тот же сайт).

Это означает, что если у вас есть веб-сайт с более чем 2000 URL-адресов, Sitebulb не сможет одновременно собирать информацию об индексировании всех URL-адресов. В этом случае Sitebulb будет запрашивать 2000 лучших URL-адресов HTML, упорядоченных по рейтингу URL-адресов.

Таким образом, по умолчанию Sitebulb всегда выбирает наиболее важные страницы для проверки индексации на основе популярности внутренних ссылок.

Важное замечание, которое не стоит игнорировать

Эта квота распространяется на каждый веб-сайт, а не на инструмент. Если вы собираете данные API с помощью нескольких разных инструментов, все они берутся из одного и того же пула квот. Если вы израсходовали лимит в 2000 деней с помощью других инструментов, вы не сможете собирать больше данных с помощью Sitebulb в тот же день.

Точно так же существует ограничение на количество запросов в API, равное 600 URL-адресам в минуту. Sitebulb настроен на безопасный запрос в пределах этого ограничения, но если вы одновременно нажмете на API двумя разными инструментами, вы можете случайно превысить его для любых сообщений об ошибках.

Дополнительную информацию о превышении ограничений API см. в разделе «Если данные URL не возвращаются».

Просмотр данных проверки URL-адресов в Sitebulb

Чтобы получить доступ к данным, собранным Sitebulb, перейдите к отчету Проверка URL-адресов с помощью навигации слева.

В обзоре показаны многочисленные диаграммы и таблицы, и если вы нажмете на вкладку URL-адреса , вы увидите все данные в формате таблицы:

Как и во всех списках URL-адресов в Sitebulb, данные могут быть дополнены и точны. -настраивается путем добавления дополнительных столбцов, сортировки или применения расширенных фильтров.

Изучение данных проверки URL

Данные, возвращаемые API, могут быть весьма обширными и детализированными, поэтому для того, чтобы действительно понять, на что вы смотрите, требуется некоторое знакомство с отчетом о покрытии индекса и инструментом проверки URL в Google Search Console.

Тем не менее, Sitebulb предоставляет вам простой и интуитивно понятный доступ к важным элементам данных, таким как «URL-адреса не индексируются в Google», с простым рабочим процессом для более глубокого изучения данных.

На любой из диаграмм щелкните область сегмента, чтобы просмотреть отфильтрованный URL-адрес Список данных:

Это приведет вас к следующим URL-данным:

Кроме того, на любой диаграмме вы можете щелкнуть переключатель «Просмотр таблицы данных», который отображает данные диаграммы в формате таблицы:

Затем данные диаграммы будут отображаться в таблице, и нажатие на любое из этих значений также приведет вас к соответствующему списку URL-адресов:

В самих списках URL-адресов вы можете анализировать проблемы в пакетном режиме, прокручивая вправо, чтобы просмотреть наиболее значимые столбцы:

В качестве альтернативы, чтобы погрузиться в определенный URL-адрес и посмотреть, что говорит инструмент проверки в Google Search Console, просто нажмите оранжевую кнопку, чтобы Открыть проверку URL-адреса :

Это откроет консоль поиска Google в в вашем браузере с уже открытым инструментом проверки URL и предварительно загруженным выбранным URL:

Что показывают различные диаграммы

В отчете о проверке URL есть несколько круговых диаграмм и столбчатых диаграмм, поэтому мы пройдемся по ним что показывает каждый:

Покрытие

На этой диаграмме каждый URL-адрес разбит на разные сегменты в зависимости от того, сможет ли Google найти и проиндексировать страницу. Каждый вариант включает краткую описательную причину статуса URL-адреса, объясняющую, почему URL-адрес находится или не находится в Google.

Каждый вариант включает краткую описательную причину статуса URL-адреса, объясняющую, почему URL-адрес находится или не находится в Google.

Сводка

Эта круговая диаграмма дает сводную оценку того, могут ли URL отображаться в результатах поиска Google.

Важно отметить, что «URL находится в Google» не обязательно означает, что страница появляется в результатах поиска, а просто означает, что она проиндексирована.

Индексирование разрешено

На этой диаграмме показано, разрешают ли URL-адреса явно запрещать индексирование (например, тег noindex). Если индексация запрещена, в легенде указывается причина — эти страницы не будут отображаться в результатах поиска Google.

Обратите внимание: если страница заблокирована файлом robots.txt, для параметра «Индексирование разрешено» всегда будет установлено значение «Да», поскольку Google не может видеть и соблюдать директивы noindex.

URL-адреса карты сайта

На этой диаграмме URL-адреса, отправленные в Inspection API, разделены на основе их статуса карты сайта. Либо они не были найдены на картах сайта в Google Search Console (в этом случае они отображаются как «Не отправлено»), они были отправлены и проиндексированы, либо отправлены, но не проиндексированы.

Либо они не были найдены на картах сайта в Google Search Console (в этом случае они отображаются как «Не отправлено»), они были отправлены и проиндексированы, либо отправлены, но не проиндексированы.

Просканировано как

На этой диаграмме показано распределение между URL-адресами, просканированными с помощью Google Mobile Crawler и их Desktop Crawler.

Результаты на этой диаграмме относятся только к проиндексированным URL-адресам.

Сканирование разрешено

На этой диаграмме показано, разрешено ли Google сканирование URL-адресов в соответствии с правилами сайта robots.txt. Обратите внимание, что это значение отличается от разрешения индексирования, которое задается значением «Индексирование разрешено».

Результаты на этой диаграмме относятся только к проиндексированным URL-адресам.

Пользователь против Google Canonical

На этой диаграмме показано, согласен ли Google с объявленным пользователем каноническим URL-адресом. Если они согласны, это будет отображаться как «Совпадение», а если они не согласны, это будет отображаться как «Несоответствие». Если канонических нет и Google выбрал один, это будет отображаться как «Выбрано Google».

Если они согласны, это будет отображаться как «Совпадение», а если они не согласны, это будет отображаться как «Несоответствие». Если канонических нет и Google выбрал один, это будет отображаться как «Выбрано Google».

Дней с момента последнего сканирования

На этой диаграмме показано распределение URL-адресов на основе даты их последнего сканирования Google. Дни, обозначенные как «0», означают, что URL-адрес был просканирован в течение последнего дня. Диапазоны дат позволяют копать глубже и исследовать URL-адреса, которые недавно сканировались или вообще не сканировались.

Расширенные результаты

На этой диаграмме показано, подходят ли URL-адреса для расширенных результатов и вызывают ли URL-адреса ошибки или предупреждения.

Результаты на этой диаграмме относятся только к URL-адресам, которые содержат структурированные данные, которые могут привести к расширенным результатам.

Подходит для мобильных устройств

На этой диаграмме показано, считает ли Google URL-адреса удобными для мобильных устройств и вызывают ли URL-адреса ошибки или предупреждения.

Результаты на этой диаграмме относятся только к проиндексированным URL-адресам.

Когда данные URL не возвращаются

Иногда вы обнаружите, что данные URL не возвращаются, и это может быть по ряду причин:

#1 Превышена квота: Вы исчерпали дневную квоту URL

Если вы превысите дневную квоту (см. выше), вам нужно будет подождать 24 часа, прежде чем пытаться снова. Также имейте в виду, что ограничение в 2000 URL-адресов относится к ресурсу в день, что может означать, что вы превысили ограничение из-за инструментов, отличных от Sitebulb.

Как только Sitebulb превысит дневную квоту, он перестанет отправлять запросы API.

#2 Превышена квота: Вы превысили лимит скорости

В API существует ограничение на количество запросов в 600 URL-адресов в минуту. Sitebulb настроен на безопасный запрос в рамках этого ограничения, но если вы одновременно нажмете на API двумя разными инструментами, вы можете случайно превысить его для любых сообщений об ошибках.

#3 Запрещено: запрошенный URL-адрес недействителен для этого ресурса

Это означает, что Sitebulb запросил данные индексации для URL-адреса, который «не является частью выбранного ресурса».

Например, https://example.com для свойства префикса URL https://www.example.com . Если вы хотите проверить URL-адреса из нескольких субдоменов, выберите свойство на уровне домена.

#4 Сбой: вышла ошибка API

Это означает, что сам API Google не работает. Если это произойдет, вернитесь и повторите попытку позже.

Как проверить статус индексирования крупного веб-сайта

Прежде чем ваши страницы появятся в результатах поиска и привлекут трафик на ваш сайт, их необходимо проиндексировать.

К сожалению, проиндексировать сайт непросто, особенно если у вас большой веб-сайт. Согласно нашему исследованию, 16% ценных страниц веб-сайтов не индексируются.

Прежде чем предпринимать шаги по улучшению индексации и эффективности поиска вашего сайта, крайне важно проверить статус индексации вашего сайта и определить, какие из ваших страниц индексируются правильно, а какие нет.

Одной из проблем, с которой вы можете столкнуться, является поиск надежных методов проверки статуса индексации вашего сайта, позволяющих анализировать URL-адреса в пакетном режиме. 902:00 Если это так, то вы пришли в нужное место.

Существует несколько полезных инструментов, которые могут помочь вам определить статус индексации вашего сайта и помочь в более тщательном анализе каждого URL-адреса, чтобы определить, почему он не индексируется.

Следуйте моим советам в этой статье, чтобы узнать, как проверить статус индексации крупного веб-сайта, проанализировать проблемы, препятствующие индексации страниц, и найти правильные решения.

Что нужно сделать перед проверкой статуса индексации вашего веб-сайта

Прежде чем проверять статус индексации и решать проблемы, вам необходимо разработать правильную стратегию индексации.

Создав его, вы сможете определить, какие страницы являются важными и должны быть проиндексированы, а какие следует исключить из индексации.

Некоторые из ваших страниц могут быть низкого качества или содержать дублированный контент, и пользователи не должны находить их в результатах поиска. Как правило, это те страницы, которые должны быть исключены из индекса.

Вот несколько примеров страниц, которые не следует индексировать:

- Архивное содержимое,

- Страницы, защищенные логином и паролем,

- URL с добавленными параметрами, созданные в результате сортировки или фильтрации,

- Результаты внутреннего поиска,

- Страницы благодарности.

Если вы не хотите, чтобы страница индексировалась, вы можете:

- Включить соответствующие директивы для ботов в файл robots.txt, чтобы они не сканировали данную страницу, 902:30

- Внедрите тег noindex, чтобы роботы поисковых систем не индексировали страницу.

URL-адреса, которые не были проиндексированы и должны оставаться такими, не требуют вашего внимания. Вместо этого сосредоточьтесь на страницах, которые не проиндексированы, но должны быть проиндексированы.

Как правило, вы должны стремиться к тому, чтобы канонические версии ваших страниц были проиндексированы, и они должны быть представлены в вашей карте сайта.

Так как же узнать, какие страницы проиндексированы, а какие нет?

Методы проверки статуса индексации и диагностики проблем с индексацией

Существует несколько полезных инструментов для проверки статуса индексации вашего сайта.

Но имейте в виду, что большинство из них имеют ограничения на количество URL-адресов, которые вы можете проверить. При поиске в Интернете вы можете столкнуться со многими ненадежными инструментами.

Я покажу вам какие инструменты показывают наиболее точную информацию и обходные пути для расширения своих возможностей.

Кроме того, я познакомлю вас с новым инструментом анализа индексации, разработанным нашей родственной компанией ZipTie.

Команда «site:»

Один из популярных способов проверить количество проиндексированных страниц сайта — ввести команду «site:» в поиске Google, а затем имя домена, например «site:onely. com».

com».

Несмотря на то, что он позволяет вам проверить статус индексации веб-сайта, данные, которые вы увидите, могут вводить в заблуждение или быть неточными, поскольку числа являются только приблизительными.

Этот метод будет особенно неточным для больших веб-сайтов с динамически изменяющимся содержимым.

Может случиться так, что каждый раз, когда вы его используете, результаты будут показывать совершенно другое количество проиндексированных страниц для вашего домена.

Однако, несмотря на то, что команда «site:domain» далека от оптимальной, вы можете использовать команду «site:URL», где вы вводите конкретный URL-адрес вместо имени домена. Затем вы можете узнать, был ли проиндексирован конкретный URL-адрес.

Джон Мюллер рекомендовал это решение:

Использование site:-queries полезно для проверки отдельных URL-адресов, но я бы не стал использовать счетчики для целей диагностики.

— Джона Мюллера здесь почти нет 🐀 (@JohnMu) 16 апреля 2019 г.

Инструменты в Google Search Console

Google Search Console предлагает гораздо лучшие инструменты для проверки охвата вашего индекса.

Если вы еще не используете их регулярно, начните прямо сейчас — они должны стать вашими стандартными инструментами SEO-мониторинга.

Расскажу о них подробнее и посоветую, как максимально использовать их на большом сайте.

Отчет о покрытии индексом (индексация страниц)

Отчет «Покрытие индекса (индексация страниц)» в Google Search Console предоставляет данные от Google о том, какие страницы проиндексированы.

Кроме того, он дает вам представление о конкретных состояниях ваших URL-адресов в отношении их обнаружения, сканирования и индексации, а также, если применимо, о том, какую проблему обнаружил Google, которая препятствует их индексации.

В отчете «Покрытие индекса (индексация страниц)» отображаются два статуса:

- Не проиндексировано — для страниц, которые не проиндексированы.

- Они могут столкнуться с такими ошибками, как код состояния HTTP 5xx, неправильная директива disallow в файле robots.txt или неправильное использование тега noindex.

- Иногда системы Google могут принять решение не индексировать страницу, которая была им доступна для сканирования, по другим причинам.

- Indexed — для страниц, которые проиндексированы. Некоторые из них могут все еще иметь дело с проблемами, которые вы должны исследовать, но никакая критическая проблема не помешала их индексации. 902:30

В зависимости от того, какие данные вы хотите отобразить, в левом верхнем углу вы можете выбрать:

- «Все известные страницы» — для всех URL-адресов, обнаруженных Google каким-либо образом,

- «Все отправленные страницы» — для URL-адресов, которые Google нашел в вашей карте сайта,

- «Только неотправленные страницы» — для URL-адресов, обнаруженных Google при сканировании, даже если их нет в вашей карте сайта.

Обычно представление «Все отправленные страницы» должно содержать все страницы, которые вы хотите проиндексировать.

Если некоторые страницы отображаются в разделе «Только неотправленные страницы» и должны быть проиндексированы, поместите их в карту сайта. Если они не должны быть проиндексированы, это означает, что Google находит их в другом месте, возможно, по ссылкам.

Основным ограничением отчета является то, что каждый отчет, отображающий определенные проблемы, содержит только 1000 страниц. К счастью, есть способы обойти это.

Одним из решений является создание отдельных свойств домена для разных разделов веб-сайта.

Альтернативой может быть разделение ваших страниц на создание нескольких карт сайта и сужение отчета до отдельной карты сайта.

Рекомендуется, чтобы каждая карта сайта содержала не более 50000 URL-адресов.

Существует множество способов разделения страниц между картами сайта. Подумайте о том, чтобы упорядочить их таким образом, чтобы вам было легче сгруппировать похожие типы контента для более удобного анализа.

Подумайте о том, чтобы упорядочить их таким образом, чтобы вам было легче сгруппировать похожие типы контента для более удобного анализа.

Вот несколько предложений:

- Отдельные файлы Sitemap для разных типов контента, например категорий, продуктов, сообщений в блогах, 902:30

- Отдельные карты сайта для выбранного количества или вида продуктов,

- Отдельные карты сайта для разных языковых версий сайта.

Теперь выберите одну из карт сайта и перейдите к разделу «Почему страницы не индексируются» отчета.

Просмотрите проблемы, которые он отображает — справа вы можете увидеть количество затронутых страниц и узнать, какие проблемы являются наиболее распространенными. Вы можете ознакомиться с другими нашими статьями о том, как работать с часто возникающими отчетами «просканировано — в настоящее время не проиндексировано» и «обнаружено — в настоящее время не проиндексировано».

Статусы отчета довольно описательно описывают причины каждой проблемы и в большинстве случаев указывают на действия, которые необходимо предпринять для их устранения.

Узнайте, как обращаться с каждым статусом, в моем полном руководстве по отчету о покрытии индекса (индексации страницы) в Google Search Console.

Ищите закономерности на исключенных страницах. Если многие страницы имеют схожее содержание или макет, просмотр только части URL-адресов может дать вам представление о том, с чем могут быть проблемы на остальных страницах.

Инструмент проверки URL

Еще одна полезная функция, доступная в Google Search Console, — это инструмент проверки URL.

Позволяет проверить, находится ли конкретный URL в индексе Google, и просмотреть массу дополнительной информации. Этот инструмент можно использовать для дополнения данных, получаемых из отчета «Покрытие индекса (индексация страниц)».

Вот обзор наиболее важных функций инструмента проверки URL:

- Статус присутствия — может ли URL-адрес отображаться в результатах поиска Google и любых предупреждениях или ошибках, обнаруженных Google.

- Просмотр просканированной страницы — технические подробности, такие как ответ HTML и HTTP, полученный Google.

- Запросить индексацию — используйте его, чтобы попросить Google повторно просканировать и повторно проиндексировать ваш URL. Для этой функции существует дневной лимит. Хотя это явно не указано в документации Google, он упоминается как способ отправки «всего нескольких URL-адресов». Это может позволить вам отправить до 50 URL-адресов. 902:30

- Подробная информация о статусе покрытия страницы, а именно:

- Указывают ли какие-либо известные карты сайта на URL-адрес,

- Ссылающаяся страница — страница, которую Google мог использовать для обнаружения URL-адреса,

- Когда страница была просканирована в последний раз,

- Доступна ли страница для сканирования,

- Можно ли получить страницу с сервера,

- Является ли страница индексируемой,

- Канонический URL-адрес, объявленный пользователем,

- Канонический URL, выбранный вместо него Google.

902:30

902:30

- Улучшения — в этом разделе показано, нашел ли Google достоверные структурированные данные на странице, а также сведения об удобстве использования страницы для мобильных устройств и AMP.

- Test Live URL — вы можете запустить живой тест на URL-адресе, например. если вы хотите проверить исправления или изменения.

Инструмент проверки URL-адресов требует проверки статуса индексации каждого URL-адреса, что может занять много времени, если у вас большой веб-сайт.

Однако анализ выборки страниц уже может указать вам, с какими проблемами сталкивается ваш сайт.

Вместо проверки всех URL-адресов вы можете выбрать и проверить часть URL-адресов, которые были исключены из индекса Google. Вы также можете собирать URL-адреса, которые должны быть проиндексированы, но не получают органического трафика.

Кроме того, на вашем сайте могут быть следующие разделы:

- example.com/shop

- example.

com/blog

com/blog - example.com/галерея.

Вы можете выбрать несколько URL-адресов для анализа из каждого отдельного раздела. Но не просто выберите несколько URL-адресов — используйте репрезентативную выборку для каждого раздела.

Ваши страницы «исключены тегом noindex» в Google Search Console?

Прочитайте нашу статью, чтобы убедиться, что вы использовали тег noindex намеренно.

API проверки URL

В 2022 году Google объявила о выпуске API проверки URL, который позволяет отправлять до 2000 запросов в день для одного свойства Google Search Console.

Это отличная новость для тех, кто считает данные инструмента проверки URL полезными, но не может проверить только один URL за раз. Получая доступ к данным проверки URL-адресов через API, вы можете автоматизировать процесс, что открывает множество новых возможностей использования этой информации.

Ограничения инструментов Google Search Console

Инструменты Google Search Console не лишены недостатков.

В октябре 2021 года пользователи сообщали, что видели в отчете об индексировании URL-адреса с пометкой «Просканировано — в настоящее время не проиндексировано». Однако при проверке с помощью инструмента проверки URL-адресов эти URL-адреса были указаны как «Отправлено и проиндексировано» или с другим статусом.

Google ответил, что эта ситуация не ошибка, а скорее ограничение отчета о покрытии индекса:

Это связано с тем, что данные отчета о покрытии индекса обновляются с другой (и более медленной) скоростью, чем данные проверки URL-адресов. Результаты, показанные в проверке URL-адресов, являются более свежими, и их следует рассматривать как достоверные, если они противоречат отчету о покрытии индекса. (2/4)

— Google Search Central (@googlesearchc) 11 октября 2021 г.

Сообщить о проблеме с индексированием

В апреле 2021 года Google объявила о введении функции под названием «Сообщить о проблеме с индексированием», чтобы помочь пользователям информировать Google о проблеме с индексацией. В настоящее время эта функция доступна в США.

В настоящее время эта функция доступна в США.

Для тех, кто нуждается в дополнительной поддержке, вошедшие пользователи Search Console в США скоро увидят кнопку «Сообщить о проблеме с индексированием» под отчетом о покрытии индекса и статьями Инструмента проверки URL в Справочном центре Search Console.https://t. co/3sFqvCvhjohttps://t.co/I7k3BYAH0i pic.twitter.com/Wd9ooXqK0y

— Google Search Central (@googlesearchc) 28 апреля 2021 г.

Пользователи могут получить доступ к форме и выбрать, будут ли их сайт или страницы не проиндексированы или проиндексированы, но не ранжируются должным образом. Затем им будут предложены варианты устранения неполадок, связанных с обнаруженной проблемой.

Если эти решения не сработают, они могут сообщить о проблеме непосредственно в Google.

Однако к этой функции следует относиться как к крайней мере, и нет гарантии, что Google выполнит ваш запрос и проиндексирует ваш контент.

Google стремится индексировать только наиболее актуальный и высококачественный контент. Поэтому, следуя передовым методам и оптимизируя свои страницы, чтобы сделать их доступными для сканирования, индексируемыми и достойными внимания Google, вы можете обеспечить долгосрочные результаты своего сайта.

ZipTie

ZipTie предоставляет набор обширных функций для анализа статуса индексации любого веб-сайта, независимо от его размера. Этот инструмент особенно удобен для крупных веб-сайтов корпоративного типа.

Вот что предлагает ZipTie:

Анализ покрытия индекса

Основная функция ZipTie заключается в том, что он сообщает вам, какие страницы не были проиндексированы Google.

И, что очень важно, не существует ограничений на количество URL-адресов, которые ZipTie может анализировать. Это важно для крупных веб-сайтов с тысячами или миллионами URL-адресов, которые невозможно успешно оценить с помощью других инструментов.

Важно отметить, что вы можете проверить индексирование любого домена — не только своего, но и домена вашего конкурента. Затем сравните свой статус индексации с конкурирующими доменами и посмотрите, какие области вам следует улучшить, чтобы продвинуться вперед.

Отслеживание задержек индексации

ZipTie позволяет отслеживать задержки индексации и оценивать, когда ваш недавно опубликованный контент будет проиндексирован и когда вы можете ожидать, что он будет привлекать трафик.

Это делается путем анализа новых URL-адресов, добавленных в ваши карты сайта, и изучения времени между публикацией контента и моментом его появления в результатах поиска.

Оповещения о деиндексированном контенте

ZipTie сообщит вам количество деиндексированного контента. Страницы, которые уже были проиндексированы, через некоторое время могут быть исключены из индекса Google — эта функция позволяет быстро реагировать, когда это происходит.

Индексация JavaScript

Индексация страниц на основе JavaScript сложна, но ZipTie предлагает руку помощи.

В частности, ZipTie может определить, проиндексировал ли Google определенные фрагменты страниц, сгенерированные с помощью JavaScript.

Очень важно понимать, есть ли у Google проблемы с рендерингом и индексацией вашего контента на основе JavaScript. В этом случае ZipTie может сообщить вам, какие именно элементы страницы вызывают проблемы.

Дополнительная информация о непроиндексированных страницах

В качестве бонуса ZipTie предлагает дополнительную информацию о непроиндексированных URL-адресах , такие как количество слов, заголовки, заголовки, количество изображений, метаописание и многое другое. Это важно при исследовании возможных причин проблем с индексацией и выявлении закономерностей между неиндексированными страницами.

Вы можете экспортировать данные из ZipTie в виде файла CSV и легко комбинировать их с данными из других инструментов, таких как Google Analytics или Google Search Console.

ZipTie пока не доступен в открытом доступе. Более подробная информация о нем будет опубликована по мере развития инструмента. Вы можете быть в курсе официального запуска, подписавшись на список рассылки ZipTie.

Но ждать не обязательно.

Свяжитесь с командой ZipTie прямо сейчас, чтобы провести углубленный анализ статуса индексации вашего веб-сайта.

Инструменты Bing для веб-мастеров

Даже если появление в Bing не является вашим приоритетом, Инструменты Bing для веб-мастеров могут помочь вам получить представление обо всех типах проблем с индексированием, некоторые из которых могут возникать и в других поисковых системах.

Site Explorer

Прежде всего, давайте посмотрим на Site Explorer.

Инструмент Site Explorer позволяет вам просматривать структуру вашего веб-сайта и сведения о статусе индексации страниц, среди прочих данных:

Одним из аспектов, который выделяет Site Explorer, является возможность группировать URL-адреса по папкам, где каждая папка может представлять поддомен или часть пути URL-адреса. В результате у вас есть доступ к данным для значительного количества страниц.

В результате у вас есть доступ к данным для значительного количества страниц.

Информация о сканировании, к которой у вас есть доступ, включает:

- Проиндексировано — количество проиндексированных URL-адресов в данной папке,

- Ошибка — критические ошибки сканирования, которые привели к тому, что указанные URL-адреса не были проиндексированы, 902:30

- Предупреждение . Было обнаружено, что эти URL-адреса имеют проблемы с рекомендациями, временные проблемы со сканированием, запрещены в файле robots.txt и т. д. Регулярно проверяйте этот раздел, чтобы выявлять всплески или падения затронутых URL-адресов,

- Исключено — URL-адреса, которые были исключены из индекса, например, из-за спама или низкого рейтинга.

У вас есть возможность дополнительно фильтровать URL-адреса для отображения страниц на основе определенных функций.

Эти фильтры позволяют определить URL-адреса, требующие вашего внимания, и указать правильное направление при решении проблем с индексацией.

Инструмент проверки URL-адресов Bing

Еще одна замечательная функция — инструмент проверки URL-адресов Bing, который дополняет Site Explorer. Он позволяет вам проверить, находится ли конкретный URL-адрес в индексе Bing и были ли обнаружены какие-либо ошибки индексации или сканирования.

Вставьте URL-адрес в инструмент — вы увидите много дополнительной информации.

В разделе Индексная карточка вы можете увидеть статус индексирования URL-адреса и подробные сведения о нем, например, когда URL-адрес был обнаружен и как он был просканирован.

Вы также можете просмотреть HTML-код страницы и HTTP-ответ, полученный системой.

Если URL-адрес не был проиндексирован из-за ошибок, вы сможете предпринять дальнейшие действия, например запросить индексацию URL-адреса, связаться со службой поддержки, внести изменения в файл robots.txt и т. д.

Bing предоставляет рекомендации о том, почему страница может не индексироваться – вот несколько причин:

- Нет ссылок, ведущих на вашу страницу,

- Страница не соответствует пороговым значениям качества, 902:30

- Директивы robots.

txt блокируют сканирование страницы,

txt блокируют сканирование страницы, - На странице есть и другие проблемы со сканированием — функция Live URL поможет вам разобраться в этом подробнее,

- На странице есть тег noindex, который препятствует ее индексации,

- URL-адрес еще не был обнаружен и просканирован, и ему просто нужно больше времени,

- Страница не соответствует рекомендациям по обеспечению качества, за что была оштрафована и удалена из индекса.

Вы можете использовать его в качестве ориентира при диагностике проблем с индексацией в других поисковых системах, таких как Google.

Если URL-адреса не проиндексированы и должны быть проиндексированы, Bing позволяет отправлять URL-адреса для индексирования.

Важно то, что лимит относительно высок — вы можете отправить до 10000 URL-адресов в день. Это намного превышает установленный Google предел в 50 URL-адресов.

Распространенные проблемы с индексацией для крупных веб-сайтов

Проблемы с индексацией возникают на большинстве сайтов и могут иметь катастрофические последствия для эффективности обычного поиска вашего сайта.

Томек Рудзки изучил наиболее распространенные проблемы индексации для веб-сайтов разного размера.

Благодаря его исследованиям мы теперь знаем, что крупные веб-сайты обычно страдают от следующих проблем:

- Просканировано – в настоящее время не индексируется,

- Обнаружен — в настоящее время не проиндексирован,

- Дублированный контент,

- Мягкий 404,

- Проблемы со сканированием.

Другая типичная проблема касается внутренних ссылок. Роботу Googlebot нужно пройти по пути, чтобы найти страницу — если она не связана с другими страницами, она может быть исключена из индекса.

Как решить проблемы с индексацией

Вы можете предпринять шаги, чтобы максимизировать шансы на индексацию ваших страниц.

Эти решения также полезны, когда вы находите непроиндексированные URL-адреса и не можете определить, почему они не проиндексированы.

Убедитесь, что ваши страницы индексируются

Выяснение того, индексируются ли ваши страницы, состоит из изучения двух аспектов:

Директивы, указанные в вашем файле robots.

txt

txt Файл robots.txt содержит инструкции для поисковых роботов о том, что должно быть залез на сайт. Убедитесь, что директива «Запретить» не препятствует сканированию ваших ценных страниц.

Содержат ли страницы теги noindex

Теги Noindex позволяют ботам поисковых систем посещать страницы, но препятствуют их индексации.

Чтобы массово проверить, индексируются ли ваши страницы, используйте поисковый робот, например, Screaming Frog.

Ознакомьтесь с другими популярными поисковыми роботами в этой статье.

Вы можете вставить список своих URL-адресов в инструмент и начать сканирование. Когда это будет сделано, посмотрите на столбец «Индексируемость», в котором будет указано, является ли страница индексируемой или неиндексируемой.

Убедитесь, что все ценные страницы представлены в карте сайта

Проверьте, были ли непроиндексированные страницы отправлены в карту сайта – если нет, добавьте их соответствующим образом.

Кроме того, убедитесь, что ваши файлы Sitemap не содержат URL-адресов, которые не должны быть проиндексированы в первую очередь. Разрешение поисковым системам обнаруживать и сканировать нерелевантные страницы может привести к неэффективному сканированию и увеличению времени, необходимого ботам для поиска вашего контента самого высокого качества.

Если у вас нет карты сайта, вы можете легко создать ее или использовать специальные инструменты, которые будут поддерживать ее в актуальном состоянии, например, Yoast SEO или SEO Spider от Screaming Frog. Вы также можете использовать один из инструментов генератора карты сайта.

Наше исчерпывающее руководство по картам сайта станет вашим главным ресурсом для создания оптимизированной карты сайта.

Настройте внутренние ссылки

Внутренние ссылки являются важным аспектом вашего сайта с точки зрения SEO.

Для Google недостаточно просто включить URL-адрес в карту сайта. Googlebot должен быть уверен, что URL-адрес стоит его внимания — по этой причине ему необходимо найти сигналы, подчеркивающие его важность.

Убедитесь, что у вас нет страниц-сирот, означает страницы без входящих ссылок. Вы можете просканировать свой веб-сайт, чтобы найти потерянные страницы — например, сделать это с помощью отчета Screaming Frog о потерянных страницах.

Некоторые идеи по улучшению внутренних ссылок включают создание разделов для связанных продуктов или написание сообщений в блогах для ссылок на другие страницы вашего сайта.

Вам также необходимо иметь чистую архитектуру веб-сайта. Это означает организацию контента на сайте таким образом, чтобы пользователи и боты могли интуитивно и быстро перемещаться по каждому разделу вашего сайта.

Свяжитесь с Onely, если вам нужна более подробная внутренняя оптимизация ссылок.

Устранение проблем с дублированием контента

Если на вашем сайте существует более одной версии одного и того же или очень похожего контента, поисковым системам может быть сложно решить, какая страница является наиболее репрезентативной.

Чтобы упростить работу поисковых систем, внедрите канонические теги, указывающие на выбранные вами канонические URL-адреса. Каждая версия страницы должна иметь только один канонический URL.

Убедитесь, что канонические теги последовательно указывают на правильные канонические страницы. Если они указывают на дубликаты страниц, основной URL-адрес может остаться непроиндексированным.

Консоль поиска Google уведомила вас о проблемах с индексацией из-за дублирования контента? Прочтите наши руководства и исправьте:

- статус «Дубликат, Google выбрал другой канонический статус, чем пользовательский», 902:30

- статус «Дублировать без выбранного пользователем канонического».

Следуйте рекомендациям по поисковой оптимизации JavaScript для облегчения сканирования и индексирования

Хотя поисковые системы стали намного лучше отображать и индексировать JavaScript, их обработка по-прежнему не идеальна.

Как правило, поисковые системы могут не отображать JavaScript на странице , если они считают, что это не внесет существенных изменений в ее содержание. Кроме того, если ваши страницы выглядят совершенно по-разному с JavaScript и без него, у вас могут возникнуть проблемы с их индексацией.

Кроме того, если ваши страницы выглядят совершенно по-разному с JavaScript и без него, у вас могут возникнуть проблемы с их индексацией.

Существуют инструменты, которые можно использовать для анализа индексации JavaScript.

Вы можете легко проверить, какие части вашей страницы используют JavaScript, используя наш инструмент Что бы сделал JavaScript.

Используйте Live Test в инструменте проверки URL-адресов Google, чтобы увидеть скриншот того, как именно робот Googlebot будет отображать содержимое JavaScript на вашей странице. Затем вы можете перейти на вкладку «Дополнительная информация», чтобы найти ошибки JavaScript.

Параметр «Просмотреть просканированную страницу» в инструменте проверки URL-адресов сообщит вам, что Google просканировал на вашей странице, и есть ли там весь контент JavaScript.

В случае проблем с индексированием JavaScript, обратитесь к нашей статье о JavaScript SEO для получения дальнейших инструкций или свяжитесь с нами, чтобы получить SEO-аудит JavaScript.

Оптимизируйте краулинговый бюджет

Краулинговый бюджет — это количество страниц на веб-сайте, которые поисковые системы могут и хотят сканировать.

На краулинговый бюджет вашего сайта может влиять множество факторов.

Следуйте этим общим рекомендациям по оптимизации краулингового бюджета :

- Улучшите производительность в Интернете,

- Оптимизируйте файлы JavaScript и CSS на своем сайте,

- Избегайте внутренних перенаправлений и цепочек перенаправлений,

- Настройте архитектуру сайта,

- Очистите внутренние ссылки — обновите все ссылки, указывающие на страницы «Не найдено (404)», и почаще ссылайтесь на самый важный контент,

- Имейте правильно структурированную карту сайта — вы можете проанализировать структуру своей карты сайта с помощью одного из поисковых роботов, таких как Ryte или Sitebulb. 902:30

СЛЕДУЮЩИЕ ШАГИ

Вот что вы можете сделать сейчас:

- Свяжитесь с нами.

- Получите от нас индивидуальный план решения ваших проблем с индексацией.

- Наслаждайтесь своим контентом в индексе Google!

Все еще не уверены, стоит ли писать нам? Узнайте, как услуги технического SEO могут помочь вам улучшить ваш сайт.

Takeaways

Крупные веб-сайты могут испытывать трудности с индексацией многих своих страниц. Но это не значит, что невозможно проиндексировать весь ваш ценный контент.

Анализ индексации большого веб-сайта может потребовать некоторой работы. Тем не менее, функции, доступные в Google Search Console и Bing Webmaster Tools, дадут вам полезную информацию, на основе которой вы сможете немедленно начать действовать.

Я думаю, вы можете ожидать, что ZipTie изменит правила игры в области индексации — я рекомендую вам связаться с командой ZipTie для анализа индексации.

И, если вы имеете дело с масштабными проблемами индексации, которые вы изо всех сил пытаетесь решить, свяжитесь с нами для полного технического SEO-аудита.