Анализатор внутренней перелинковки сайта

Freeware программа для анализа и оптимизации ссылочной структуры сайта

Программный код анализатора, написан в виде макросов рабочей книги excel, сканирующий сайт или связанные сайты и определюящий внутренние веса (pagerank) его страниц. Анализатор также позволяет вводить список URL обратных ссылок на исследуемые сайты и задавать их веса, которые используются для расчета уточненного ссылочного веса страниц сайтов. Программа позволяет менять и редактировать данные, сканированные с веба, что позволяет проверить изменения весов страниц в зависимости от ссылочной структуры сайта и оптимизировать ее.

Текущая версия распространяется по лицензии Freeware, но все права на ее распространение принадлежат автору.

Для работы программы на компьютере пользователя должен быть установлен excel 2003 или более поздней версии.

Видео инструкция по работе с анализатором перелинковки

youtube.com/embed/1rAoHHcZJdU»/>Скачать анализатор перелинковки сайта (версия 0.95) в форматах excel 2003 (xls) и excel 2007 (xlsm) в одном архиве.

Скачать старую версию анализатора перелинковки сайта (версия 0.93).

Более подробная справка о работе анализатора перелинковки и обсуждение программы читайте в блоге.

Версии

-

Версия 0.61 (октябрь 2010) — базовая версия

-

Версия 0.7 (ноябрь 2010) — добавлена проверка редиректа во внутренних ссылках

-

Версия 0.74 (декабрь 2010) — исправлены ошибки в работе с редиректами во внутренних ссылках, добавлены диагностические сообщения, интерфейс стал двухязычный (английский — русский)

-

Версия 0.92 (29 ноября 2011):

Поддержка формата excel 2007 — убрано ограничение на максимальное число URL

Поддержка списков исключений (строчки Disallow из файлов robots. txt)

txt)

Ввод списков игнорируемых параметров в URL

Выбор режима склейки зеркал с www и без www

Поддержка канонических URL (canonical URL)

Вывод всех обратных ссылок на сайт, полученный из списка URL (страница extpages)

Исправлены ошибки при проверке расширений файлов

Исправлены ошибки очистки старых данных -

Версия 0.93 (25 июля 2012):

Ускорена работа анализатора, функционирование программы проверено для сайта с 3000 страниц

Устранена проблема с зависанием интерфейса во время работы

Добавлены кнопки быстрого выбора режима сканирования -

Версия 0.95 (18 февраля 2014):

Изменен принцип работы с каноническими URL. При проверке канонических URL, страницы с одинаковыми каноническими URL будут «склеиваться». Опция работает только если включен также флажок проверки редиректов во внутренних ссылках.

лучшие методы оптимизации внутренних ссылок для SEO — SEO на vc.ru

Известный за рубежом SEO-специалист Кевин Индиг подготовил подробное руководство, в котором объясняются все аспекты внутренней перелинковки сайтов, а также описал стратегии и методы оптимизации внутренних ссылок относительно высказываний и заявлений сотрудников Google и личного опыта продвижения сайтов.

11 206 просмотров

Перевод материала подготовлен специалистами SiteAnalyzer.

Внутренние ссылки – это самый мощный рычаг поискового продвижения после контент-маркетинга, который может на 100% контролироваться владельцем сайта. Вот почему мы создали подробное руководство, в котором объясняются все аспекты перелинковки. После изучения этой статьи вы сможете оптимизировать структуру внутренних ссылок и повысить трафик своего сайта.

Вот почему мы создали подробное руководство, в котором объясняются все аспекты перелинковки. После изучения этой статьи вы сможете оптимизировать структуру внутренних ссылок и повысить трафик своего сайта.

Ссылки в Библии похожи на внутренние ссылки веб-сайтов

Изображение выше – это арт-проект Криса Харрисона и Кристофа Ремхильда. В нем визуализируются перекрестные ссылки между стихами из Библии. Аналогичным образом можно представить внутренние ссылки сайта.

Данное руководство разделено на две части.

- Первая из них ориентирована для начинающих – в ней объясняются основы использования внутренних ссылок.

- Вторая часть представляет из себя расширенное руководство для опытных пользователей. В ней рассматриваются главные стратегии и методы оптимизации внутренних ссылок.

Самую важную часть этого руководства составляют аксиомы о перелинковке. Это широко распространенные и устоявшиеся убеждения об оптимизации внутренних ссылок для поисковых систем. SEO постоянно и стремительно меняется. Поэтому, чтобы наилучшим образом оптимизировать сайт для поисковых систем (и людей), необходимо бросить вызов устоявшимся убеждениям. А для этого следует подвергнуть сомнению главные аксиомы.

Основы внутренней перелинковки страниц

Что такое внутренняя перелинковка?

Внутренние ссылки – это гиперссылки на другие страницы этого же сайта.

Ссылка (внешняя или внутренняя) в HTML выглядит следующим образом:

- <a href=»https://domain.com»>текст ссылки (анкор)</a>

Их называют «внутренними ссылками», потому что они ведут на страницы того же домена.

Они обеспечивают навигацию посетителей на сайте и помогают людям найти то, что они ищут. Также внутренние ссылки чрезвычайно полезны для сканирования поисковыми системами и продвижения сайта в Интернете.

В чем заключается разница между внутренними и внешними ссылками?

Внутренние ссылки перенаправляют пользователя на страницы в том же домене, на которых они расположены, в то время как внешние ссылки ведут на страницы других доменов.

Разница между внутренними и внешними ссылками очевидна, но многие часто забывают, что они тесно взаимосвязаны. Как я писал в прошлых статьях:

Существуют исходящие и входящие ссылки.

- Внутренняя исходящая ссылка – Ведет со страницы, которую вы просматриваете, на другую страницу на том же домене.

- Внутренняя входящая ссылка – Ведет с другой страницы в том же домене на страницу, которую вы просматриваете.

- Внешняя исходящая ссылка – Ведет со страницы, которую вы просматриваете, на страницу в другом домене.

- Внешняя входящая ссылка – Ведет с другой страницы в другом домене на страницу, которую вы просматриваете.

Внутренние ссылки влияют на PageRank так же, как внешние.

Что такое PageRank?

PageRank – это алгоритм, который оценивает важность веб-страницы на основе релевантности и авторитета ссылок, указывающих на нее с других сайтов.

Основной принцип – рассматривайте обратные ссылки (ссылки с других сайтов) как «голоса». Чем больше голосов у страницы, тем выше она поднимается в результатах поиска. Имейте в виду, что при ранжировании документов Google учитывает множество факторов, и обратные ссылки – лишь один из них.

Google больше не использует классическую формулу расчета PageRank, хотя она до сих пор в той или иной степени влияет на ранжирование. Раньше PR любой страницы можно было узнать с помощью специальных дополнений к браузеру, но в 2013 году эту возможность упразднили. Другими словами, простым пользователям больше не доступен реальный PageRank страницы. Однако, можно использовать сторонние инструменты, чтобы определить показатель, наиболее близкий к традиционному PageRank. Эти проприетарные метрики называются авторитетом домена (Domain Authority от Moz), силой страницы (Page Strength от SEMrush) или рейтингом домена (Domain Rating от Ahrefs).

Эти проприетарные метрики называются авторитетом домена (Domain Authority от Moz), силой страницы (Page Strength от SEMrush) или рейтингом домена (Domain Rating от Ahrefs).

Можно сказать, что концепция PageRank сделала Google тем, чем он является сегодня: самым успешным стартапом в истории. За прошедшие годы поисковой гигант зарегистрировал множество патентов, по которым можно отследить эволюцию PageRank.

Что такое CheiRank?

CheiRank измеряет важность страницы на основе исходящих ссылок. Это противоположность PageRank, с помощью которой можно оценить, насколько коммуникативным является веб-узел. Объясню это понятие простыми словами: если цель PageRank заключается в измерении «силы» входящих ссылок на страницу, то цель CheiRank – измерение силы исходящих ссылок со страницы.

Это противоположность PageRank, с помощью которой можно оценить, насколько коммуникативным является веб-узел. Объясню это понятие простыми словами: если цель PageRank заключается в измерении «силы» входящих ссылок на страницу, то цель CheiRank – измерение силы исходящих ссылок со страницы.

Обратите внимание, что важность CheiRank относительна. Обычно его сравнивают со всеми страницами домена. Вы можете использовать его, к примеру, для определения важных страниц-хабов. Иными словами, «коммуникативность» можно рассматривать как количество исходящих ссылок на странице.

Оптимизация CheiRank порой вызывает сложности, поскольку идеального значения не существует. Однако, есть оптимальное значение для определенного контекста. Наилучшая структура внутренних ссылок зависит от вашей бизнес-модели.

Чтобы понять, что именно представляет из себя этот показатель, взгляните на скриншот выше. Это отрывок из анализа, который я провел много лет назад, когда еще работал в Atlassian. В нем с помощью краулера оцениваются PageRank и CheiRank. Эти метрики помогли нам оптимизировать маркетплейс и значительно увеличить трафик.

Типы внутренних ссылок

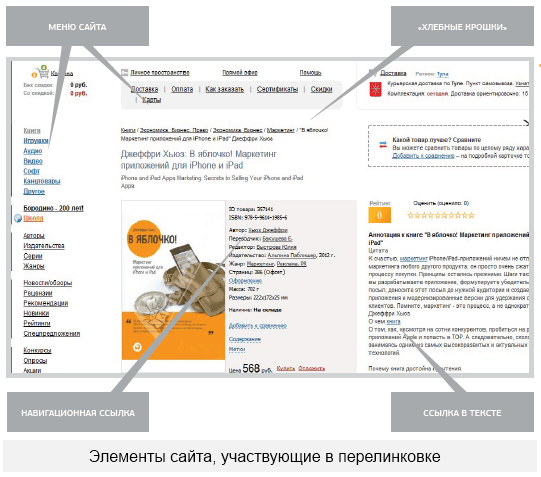

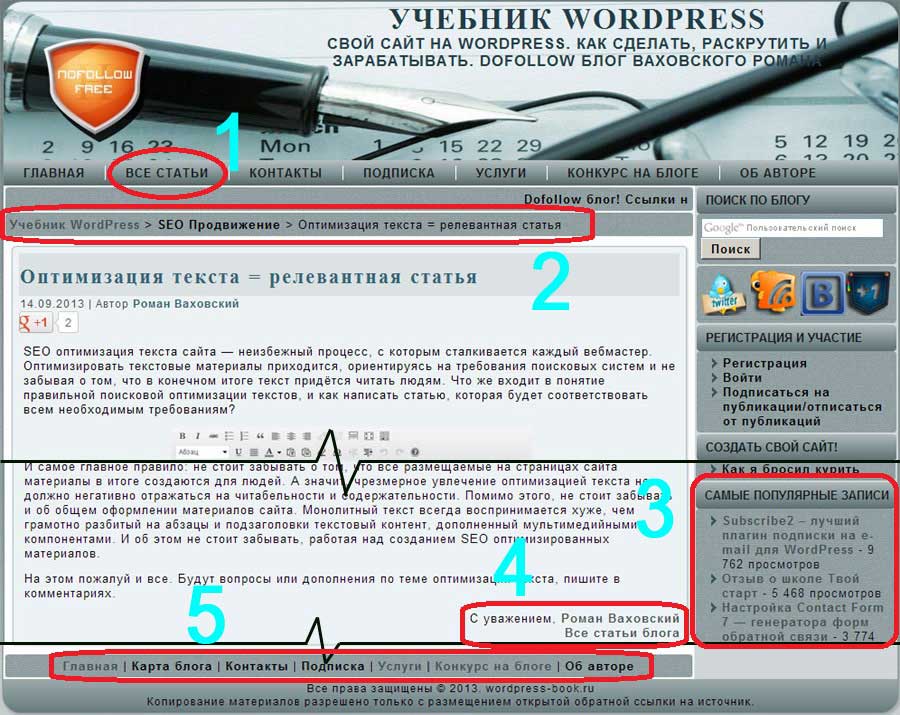

Есть два типа внутренних ссылок: контентные и модульные. Контентная ссылка – это простая ссылка в основном содержимом страницы (см. желтое поле на рисунке ниже).

Модульные ссылки используются в различных элементах навигации – к примеру, в хедере и футере страницы, а также в связанных статьях (оранжевые поля на скриншоте выше). Связывание модулей позволяет более систематически настраивать внутренний ссылочный граф сайта. Такой способ проще масштабировать в сравнении со ссылками в основном содержимом.

Связывание модулей позволяет более систематически настраивать внутренний ссылочный граф сайта. Такой способ проще масштабировать в сравнении со ссылками в основном содержимом.

Как внутренние ссылки помогают SEO

Внутренние ссылки не только полезны для простых пользователей, но и распределяют PageRank по всему сайту, помогая поисковым роботам находить все релевантные страницы домена. Теоретически, чем выше PageRank страницы, тем выше она располагается в поисковой выдаче.

PageRank – это лишь одна из многих метрик для ранжирования. Основная цель оптимизации внутренних ссылок заключается в привлечении органического трафика на сайт.

Эта информация больше недоступна, но в документации Search Console упоминается, что внутренние ссылки – это сигналы относительной важности страницы для Google (статья на SearchEngineLand).

Мэтт Каттс подтвердил это в интервью для Stone Temple (ныне Perficient):

«Нет жесткого ограничения на сканирование. Правильнее всего считать, что количество страниц, которые сканирует робот, примерно пропорционально показателю PageRank. Следовательно, если на вашей корневой странице много входящих ссылок, мы обязательно их просканируем. Она может ссылаться на другие страницы, которые получат оценку PageRank, а мы просканируем и их. Однако, чем дальше вы углубляетесь в свой сайт, тем ниже становится рейтинг PageRank в большинстве случаев».

Однако, чем дальше вы углубляетесь в свой сайт, тем ниже становится рейтинг PageRank в большинстве случаев».

Инструменты оптимизации внутренних ссылок

Для оптимизации внутреннего ссылочного графа, поиска неработающих ссылок и регулярных проверок сайта можно использовать либо специализированные веб-краулеры, либо некоторые из инструментов проверки позиций:

Проверка позиций с возможностью сканирования сайтов:

Корпоративные SEO-инструменты для оптимизации внутренних ссылок:

Расширенное руководство по внутренним ссылкам

Аксиомы о внутренних ссылках

SEO – это уникальная сфера с неоднозначной информацией и быстрыми изменениями. Если вы не будете постоянно бросать вызов устоявшимся убеждениям, то отстанете от остальных. Вот почему я создал это руководство на основе аксиом.

Если вы не будете постоянно бросать вызов устоявшимся убеждениям, то отстанете от остальных. Вот почему я создал это руководство на основе аксиом.

Я перечислю доказательства (в основном из заявлений Google) за и против каждой аксиомы, чтобы либо подтвердить, либо опровергнуть ее. Жизнь не состоит только из черных и белых цветов. Многое зависит от контекста. Также я поделюсь своим личным опытом, к которому следует относиться с долей скепсиса.

Аксиома: «Не следует ставить слишком много внешних ссылок»

Слишком большое количество исходящих ссылок снижает вероятность высокого ранжирования веб-страницы по целевому ключевому слову. В области SEO-оптимизации остается некоторая путаница, потому что с годами Google изменил свою позицию по этому вопросу.

В области SEO-оптимизации остается некоторая путаница, потому что с годами Google изменил свою позицию по этому вопросу.

Неверно: в старом сообщении в блоге Google от 2008 года говорится: «Слишком большое количество ссылок на одной странице сбивает посетителей с толку (обычно мы рекомендуем веб-мастерам добавлять не более 100 ссылок на одной странице)». Обратите внимание, что сейчас информация о сотне ссылок была удалена из статьи.

В видео 2013 года Мэтт Каттс подтвердил, что старая рекомендация устарела. Некоторые страницы часто содержат 200, 300, 400 и больше ссылок – главное, чтобы они были полезными.

Неверно: Джон Мюллер упомянул, что исходящие ссылки не понижают PageRank.

«На некоторых сайтах присутствует множество ссылок, а на других их может быть мало, но все они могут ранжироваться в поиске. Можно провести тестирование – найдите 5000 случайных исходящих ссылок и изучите, как они влияют на страницы, с которых проводится перенаправление пользователя. Скорее всего, вы обнаружите, что даже индейские танцы для вызова дождя в результате оказывают более сильное влияние.»

Неверно: Джон также говорил, что большое количество ссылок – менее серьезная проблема, чем недостаток высококачественного контента.

- «Возможна ли ситуация с переизбытком исходящих ссылок на сайте, даже если они «естественные»?

- «— Я не слышал ничего подобного. Обычно проблема заключается в других составляющих сайта (к примеру, с отсутствием актуального, уникального, убедительного, высококачественного контента), а не в ссылках.»

Личный опыт: в 2013 году я работал с крупной публичной компанией над их удалением из фильтра Google Panda. У них были тысячи страниц с более чем 2000 исходящих ссылок, но на них не было никакого контента. Сокращение этих хабовых страниц и добавление контента вернуло сайт к исходному уровню (он потерял около 70% трафика). После слов Джона становится понятно, почему сработало добавление контента и удаление лишних ссылок.

Аксиома: «Вы должны ссылаться на авторитетные источники»

Я думаю, эта аксиома родилась из идеи о плохом/хорошем соседстве сайтов. Она заключается в том, что входящие и исходящие ссылки на ваш сайт со страниц с низким качеством контента/рассылкой спама/нарушениями правил относят вас к «плохому соседству» и понижают в ранжировании.

За: в блоге Google есть старая запись 2008 года, в которой говорится, что исходящие ссылки могут влиять на уровень доверия к сайту. Однако, в этой же статье говорится о том, что более сотни исходящих ссылок могут привести к проблемам. Вероятно, эта информация устарела.

Также эта статья утверждает, что «[…] с точки зрения поисковой системы, спам в комментариях может поместить ваш сайт в плохое соседство, а не в категорию проверенных законных ресурсов».

Личный опыт: я никогда не видел, чтобы кто-то это тестировал, и не замечал повышения рейтинга от ссылок на более авторитетные источники. При этом мне кажется бессмысленным делать ссылки на авторитетный источник только ради того, чтобы они были. Я бы не рекомендовал так делать. Тем не менее, я стараюсь делать ссылки на другие сайты, когда они по-настоящему полезны.

Аксиома: «Вы должны использовать в тексте ссылки (анкоре) ключевое слово, по которому хотите ранжироваться»

Анкор – это важный фактор для поисковых систем, с помощью которого можно понять тему страницы. Идея, лежащая в основе этой аксиомы, заключается в использовании одного и того же текста ссылки для повышения релевантности ключевого слова в Google.

Идея, лежащая в основе этой аксиомы, заключается в использовании одного и того же текста ссылки для повышения релевантности ключевого слова в Google.

Правда: Google четко рекомендует «Выбирать описательный текст» в своем руководстве по SEO для начинающих и советует «тщательно продумывать тексты ссылок».

Видимый текст ссылки помогает пользователям и Google понять содержание страницы. Ссылки на странице могут быть внутренними (указывают на другие страницы сайта) или внешними (ведут на другие сайты). В любом случае, чем понятнее текст ссылки, тем проще пользователям ориентироваться на сайте, а поисковым системам легче понять, о чем страница, на которую ведет ссылка.

Правда: Джон Мюллер подтвердил в своем Twitter, что текст ссылки предоставляет контекст.

«Большинство ссылок предоставляют дополнительный контекст с помощью анкора. По крайней мере, так должно быть, верно?»

Правда: патент под названием «тематический PageRank» (ссылка на него приведена в разделе патентов) говорит о важности релевантности контента. Несмотря на то, что Google зарегистрировала его, не факт, что он действительно используется. Тем не менее, весьма вероятно, что этот патент применяется при оценке ссылок, поскольку представители Google так часто подчеркивают важность релевантности.

Правда: серия патентов на концепцию «индексации на основе фраз» описывает, как релевантность может быть определена по тому, отображается ли анкор на странице, на которую указывает ссылка. Лучше всего это объясняет Билл Славски:

Лучше всего это объясняет Билл Славски:

«Анкоры ссылок, ведущих на страницы, которые включают эту же или близкие к ней по смыслу фразы (которые часто встречаются на страницах, которые ранжируются по этой фразе), должны иметь больший вес.»

Личный опыт: релевантность внешних ссылок со временем стала намного важнее, чем просто их число: качество лучше количества. И кажется, что в случае внутренних ссылок контентные ссылки сильнее влияют на ранжирование, чем модульные.

Есть два разных мнения об анкорах для внутренних ссылок: либо меняйте его, либо сохраняйте согласованность. Моя личная позиция – придерживаться стратегии, когда текст внутренней ссылки должен совпадать с ключевым словом, по которому вы хотите ранжироваться. Иногда анкор можно немного изменить, но не стоит этого делать без необходимости.

Моя личная позиция – придерживаться стратегии, когда текст внутренней ссылки должен совпадать с ключевым словом, по которому вы хотите ранжироваться. Иногда анкор можно немного изменить, но не стоит этого делать без необходимости.

Аксиома: «Не используйте один и тот же анкор для ссылок на две разные страницы»

Правда: в статье от 2008 года Google рекомендует использовать в анкоре описательный текст.

«Написание описательного текста в анкоре помогает поисковым системам и пользователям лучше понять ваш контент. Чем больше Google знает о вашем сайте (благодаря вашему контенту, заголовкам страниц, тексту ссылок и т. д.), тем более релевантные результаты мы сможем предоставить пользователям (и вашим потенциальным посетителям)».

д.), тем более релевантные результаты мы сможем предоставить пользователям (и вашим потенциальным посетителям)».

Личный опыт: я не смог найти никаких доказательств против этой теории. Думаю, ссылки на одну и ту же страницу с разными анкорами указываются по ошибке. Я рекомендую регулярно проверять тексты внутренних ссылок и при необходимости вносить небольшие изменения, чтобы упростить их.

Аксиома: «Ссылки в футере сайта менее важны, чем ссылки внутри основного текста»

Правда: В видео Мюллер подтвердил, что Google в основном «смотрит» на основное содержимое страницы, а не на футер.

В этой конкретной ситуации ссылки в основном тексте страницы важнее. С точки зрения пользователя это также не лишено смысла.

Правда: существует множество патентов, которые показывают, как Google может различать основное содержимое, футер и другие блоки содержимого (пример).

Правда: в 2016 году Мюллер подтвердил, что Google по-разному оценивает ссылки в основном тексте и в футере.

С одной стороны, это область страницы с вашим основным контентом, а с другой – все остальное, включая меню, боковую панель, футер и хедер. .. Мы действительно принимаем это во внимание при оценке ссылок.

.. Мы действительно принимаем это во внимание при оценке ссылок.

Правда: в патенте Google, полученном в 2010 году, описывается оценка поведения пользователей при определении веса ссылки. Другими словами, Google может оценить, насколько вероятно, что пользователи перейдут по ссылке, и на основе этих данных присвоить им больший или меньший вес.

Личный опыт: хотя я согласен с тем, что ссылки в футере менее важны, чем ссылки в основном тексте, мне кажется, что они все равно важны при сканировании сайта поисковыми системами. Они упрощают нахождение сайта и уменьшают глубину перехода на важные страницы. Я не считаю ссылки в футере бесполезными.

Аксиома: «Google не может переходить по внутренним Javascript-ссылкам»

Правда: хотя Google все лучше и лучше сканирует и рендерит Javascript, поисковой гигант рекомендует на всякий случай использовать тег <noscript> при дублировании содержания Javascript.

Ложь: как показал эксперимент Onely еще в 2017 году, Google действительно хорошо сканирует Javascript-ссылки.

Ложь: в документации Google (см. ниже) и в статье за 2014 год говорится, как именно Google обычно обрабатывает Javascript.

Личный опыт: скрытие ссылок с помощью Javascript больше невозможно. Google находит их при правильном рендеринге HTML (при условии, что вы отметили все флажки).

Аксиома: «Не рекомендуется использовать тег nofollow для внутренних ссылок»

Тег nofollow для внутренних ссылок изначально использовался для «моделирования PageRank» – устаревшего метода оптимизации, который предотвращал передачу PageRank на маловажные страницы. Он используется для предотвращения сканирования определенных страниц поисковой системой в случае сбоя методов наподобие robots.txt. Однако, некоторые считают, что nofollow – это сигнал недоверия, и его бессмысленно использовать для внутренних ссылок.

Он используется для предотвращения сканирования определенных страниц поисковой системой в случае сбоя методов наподобие robots.txt. Однако, некоторые считают, что nofollow – это сигнал недоверия, и его бессмысленно использовать для внутренних ссылок.

В 2019 году Google объявил, что использует nofollow в качестве сигнала, а не директивы, и представил 2 новых атрибута: rel=sponsored и rel=ugc. После этого Google начал считать nofollow сигналом ссылки.

Правда: В 2009 году Мэтт Каттс подтвердил, что метод моделирования PageRank не работает:

«Nofollow – это метод (представленный в 2005 году и поддерживаемый несколькими поисковыми системами) для аннотирования ссылок, который позволяет предупредить: «Я не могу или не хочу поручиться за эту ссылку». В Google ссылки nofollow не передают PageRank и анкоры».

В Google ссылки nofollow не передают PageRank и анкоры».

Правда: страницы с внутренними ссылками, помеченными как «nofollow», все равно можно сканировать, если на них указывают другие ссылки без nofollow. Как определяется краулинговый бюджет поискового робота Googlebot: «Любой просматриваемый URL влияет на краулинговый бюджет. Даже если на вашей странице URL отмечен как nofollow, он все равно может сканироваться, если другая страница вашего сайта или любая страница в Интернете не помечает эту ссылку как nofollow.»

Личный опыт: я никогда не был поклонником использования тега nofollow для внутренних ссылок. Кроме того, недавно я удалил множество таких ссылок из большого домена и не заметил особого влияния на ранжирование (за исключением увеличения числа просканированных страниц).

Кроме того, недавно я удалил множество таких ссылок из большого домена и не заметил особого влияния на ранжирование (за исключением увеличения числа просканированных страниц).

Аксиома: «Глубина клика не должна превышать 3»

Глубина клика или «глубина сканирования» – это количество кликов, необходимое для перехода с главной страницы на ваши самые важные страницы.

Ложь: В приведенном выше видео Джон Мюллер подтвердил, что глубина клика важна, но не назвал конкретное число.

Личный опыт: я понял, что лучше выбрать такую структуру сайта, которая позволит минимизировать глубину кликов без ущерба для пользовательского опыта – к примеру, путем заполнения домашней страницы ссылками. При этом не страшно, если для перехода по некоторым ссылкам потребуется 8 или 10 кликов. Опасения вызывают только те страницы, для перехода на которые с главной требуется больше 10 кликов.

При этом не страшно, если для перехода по некоторым ссылкам потребуется 8 или 10 кликов. Опасения вызывают только те страницы, для перехода на которые с главной требуется больше 10 кликов.

Аксиома: «Внутренние ссылки помогают оптимизировать краулинговый бюджет»

Правда: в документации Google о том, как работает поиск, есть информация о краулинговом бюджете, подтверждающая эту аксиому.

«Нет жесткого ограничения на сканирование. Правильнее всего считать, что количество страниц, которые сканирует робот, примерно пропорционально показателю PageRank. Следовательно, если на вашей корневой странице много входящих ссылок, мы обязательно их просканируем. Она может ссылаться на другие страницы, которые получат оценку PageRank, а мы просканируем и их. Однако, чем дальше вы углубляетесь в свой сайт, тем ниже становится рейтинг PageRank в большинстве случаев».

Следовательно, если на вашей корневой странице много входящих ссылок, мы обязательно их просканируем. Она может ссылаться на другие страницы, которые получат оценку PageRank, а мы просканируем и их. Однако, чем дальше вы углубляетесь в свой сайт, тем ниже становится рейтинг PageRank в большинстве случаев».

Личный опыт: внутренние ссылки помогают Google определять, какие страницы сканировать и как часто. Логи покажут, насколько эффективна внутренняя структура вашего сайта. Увеличение числа внутренних ссылок на страницы, которые сканируются и ранжируются хуже остальных, может оказать огромное влияние на трафик.

Аксиома: «Страница не должна содержать две ссылки на одну и ту же цель»

Ложь: Джон Мюллер из Google опроверг этот миф в своем Twitter:

- «Вредят ли повторяющиеся внутренние ссылки ранжированию?

- — Нет, можно использовать их без ограничений!»

Правда: В 2013 году Мэтт Каттс рассказал о делении PageRank на число ссылок.

Ложь: в интервью 2010 года для издания Stone Temple Эрик Энге спросил Мэтта Каттса: «Допустим, у вас есть страница, на которую ссылаются десять других страниц. Если три из них являются дубликатами, тратятся ли в итоге три голоса впустую?». Он ответил: «Ну, не обязательно. В таких случаях люди могут проводить тесты. Мы пытаемся объединить страницы, а не полностью их отбросить. Если вы создадите ссылку на три страницы, которые являются дубликатами, поисковая система может понять это и передать вес входящих ссылок на эти объединенные страницы».

Личный опыт: я бы не стал слишком беспокоиться о делении PageRank. Ссылки на одну и ту же страницу могут одновременно быть в панели навигации сайта, основном тексте и в футере. В этом нет ничего страшного, если это происходит не слишком часто.

В этом нет ничего страшного, если это происходит не слишком часто.

Аксиома: «Вы должны избегать ссылок на неважные страницы»

Правда: Google заявляет в своем блоге, что краулинговый бюджет может пострадать из-за ссылок на некачественный контент (повторяющийся, бессмысленный или спам-контент).

Личный опыт: ссылки на некачественные страницы – не лучшая идея, но основная проблема заключается в некачественном контенте. В первую очередь я всегда пытаюсь его улучшить.

Аксиома: «Для пагинации следует использовать rel=next/prev»

Атрибут rel=next/prev был стандартом в SEO до тех пор, пока Google не отказался от него в 2019 году.

Правда: Илья Григорик из Google упомянул, что Googlebot достаточно умен, чтобы определять пагинацию. Кроме того, для внедрения rel=prev/next есть другие веские причины (это все еще официальный стандарт W3C).

Личный опыт: мне кажется, что Google пока не может предложить хороших альтернатив. Поисковой гигант рекомендует добавлять возможность просмотреть все страницы, бесконечную прокрутку или просто «позволить Googlebot во всем разобраться». Все эти варианты ненадежны.

Аксиома: «Для оптимизации внутренней структуры ссылок следует использовать HTML-карты сайта»

Правда: в 2010 году в блоге Google сообщалось о том, что «у 59% сайтов отсутствуют карты сайта, доступные для просмотра пользователем. С их помощью вы можете отобразить структуру своего ресурса и предоставить посетителям удобную навигацию в один клик. Если пользователи не могут найти на вашем сайте определенные страницы, карта может помочь им сориентироваться. Не оставляйте своих посетителей без неё!»

С их помощью вы можете отобразить структуру своего ресурса и предоставить посетителям удобную навигацию в один клик. Если пользователи не могут найти на вашем сайте определенные страницы, карта может помочь им сориентироваться. Не оставляйте своих посетителей без неё!»

Личный опыт: я большой поклонник файлов HTML-карт. Конечно, они не могут в одночасье удвоить органический трафик, но действительно помогают поисковым системам обнаруживать все страницы в домене, а также уменьшают глубину клика.

Аксиома: «Не используйте анкоры наподобие «нажмите здесь» для внутренних ссылок»

Правда: в руководстве Google по SEO для начинающих говорится: «Не забывайте, что ссылки бывают не только внешними, но и внутренними. Тщательно продуманный текст внутренних ссылок поможет лучше ориентироваться на вашем сайте не только пользователям, но и поисковым системам.»

Тщательно продуманный текст внутренних ссылок поможет лучше ориентироваться на вашем сайте не только пользователям, но и поисковым системам.»

Личный опыт: я люблю делать максимально понятные и точные тексты ссылок. Это благоприятно влияет на ранжирование сайта.

Лучшие методы оптимизации внутренних ссылок

Давайте рассмотрим несколько основных методик оптимизации внутренних ссылок.

Исправление или удаление нерабочих ссылок

Нерабочие ссылки – плохой опыт как для пользователей, так и для поисковых систем. Короче говоря, вы должны избегать ссылок на страницы с кодом состояния, отличным от 200.

Короче говоря, вы должны избегать ссылок на страницы с кодом состояния, отличным от 200.

Google говорит об этом Руководстве по SEO: «Не допускайте устаревания навигационной страницы из-за неработающих ссылок».

Мой совет: трудно предотвратить появление нерабочих ссылок для крупных сайтов, но от них стоит избавляться. Вы можете найти их с помощью различных утилит, в том числе и с помощью SiteAnalyzer.

В здоровой структуре сайта должно быть как можно меньше ссылок с кодом статуса, отличным от 200 (см. изображение ниже).

Оптимизация анкоров для внутренних ссылок

Как уже говорилось в аксиоме об анкорах для внутренних ссылок, их необходимо упрощать. Сам Google рекомендует избегать «использования текста, не относящегося к теме или не имеющего отношения к содержанию страницы, на которую ведет ссылка».

Я рекомендую два исправления:

- Убедитесь, что вы не используете фразы наподобие «нажмите здесь», «здесь» или аналогичные фразы.

- Оптимизируйте анкоры для ключевых слов, по которым должна ранжироваться страница.

Лично я в 80% случаях использую для текстов ссылок ключевые слова, но это не значит, что в вашем случае это соотношение тоже окажется наиболее эффективным.

Мой совет: регулярно (каждые 3 месяца) проверяйте анкоры внутренних ссылок и избавляйтесь от слишком разных и несогласованных ссылок.

Если вы хотите добиться наилучшего результата, сопоставляйте анкоры внешних обратных ссылок с текстом ваших внутренних ссылок. Это значительно увеличит ваш потенциал для ранжирования по целевому ключевому слову.

Посмотрите на скриншоты раздела обратных и внутренних ссылок в Ahrefs: в обоих случаях я искал «техническую привязку», чтобы я мог сравнить, использую ли я тот же внутренний текст, что и у внешних ссылок.

Уменьшите количество страниц с одной входящей ссылкой

Если на вашем сайте много страниц с единственной входящей ссылкой, обычно это плохой знак. Почему? Потому что это значит, что страницы имеют плохие ссылки и, следовательно, получают очень низкий PageRank, либо они низкого качества, и вы стараетесь ссылаться на них как можно меньше.

Мой совет: в Search Console можно перейти в раздел «Ссылки» > «Наиболее часто ссылаются» и отсортировать список по возрастанию, чтобы увидеть, какие страницы вашего сайта имеют наименьшее количество внутренних ссылок. Возможно, пришла пора добавить на них ссылки!

Помимо дополнительных внутренних ссылок, эти страницы также могут нуждаться в обновлении контента. Это особенно актуально для крупных сайтов. Типичные кандидаты – это профили пользователей, старые продукты или страницы с устаревшими характеристиками продуктов. Если они больше не нужны, присвойте им код статуса 410 и удалите внутренние ссылки.

Используйте навигацию по хлебным крошкам

Навигация по хлебным крошкам сейчас очень популярна и используется на большинстве сайтов. Она не только позволяет генерировать красивые сниппеты в поисковой выдаче, но и благоприятно влияет на краулинг и внутреннюю структуру ссылок.

В руководстве для начинающих от Google хлебные крошки упоминаются как одна из передовых практик.

Мой совет: убедитесь, что каждый шаг таксономии вашего сайта отражен в хлебных крошках и используйте структурированные данные для создания сниппетов.

Не используйте цепочки наподобие:

- домой > товары > стул

Вместо этого выберите что-нибудь более наглядное – например:

- домой > мебель > стул

- домой > мебель > кухня > стул

Стратегии оптимизации перелинковки сайта

Цель стратегии оптимизации перелинковки – улучшение ссылочного графа в соответствии с типом сайта.

Наилучшая структура внутренних ссылок зависит от используемой бизнес-модели. Она может быть централизованной или децентрализованной в зависимости от того, на каких страницах возможна конверсия посетителей. Централизованные сайты обычно очень загружены контентом – например, SaaS, агентства или закрытые торговые площадки. Децентрализованные сайты (общедоступные маркетплейсы, потребительские сайты, социальные сети) легко масштабируются.

Стратегии оптимизации перелинковки децентрализованных сайтов

Основная цель для децентрализованных сайтов – обеспечить как можно больше релевантных связей между продуктами и категориями для увеличения продаж и поисковой видимости.

Ниже приведено множество примеров из сегмента электронной коммерции, но большинство из них также можно перенести на другие бизнес-модели.

Другие товары этого бренда

Горизонтальная таксономия

Большинство сайтов электронной коммерции по умолчанию используют вертикальную таксономию: категории продуктов, подкатегории и продукты. Горизонтальные таксономии – это бренды, места, события, личности и т.д.

Примером горизонтальной таксономии является категория Samsung Best Buy, которая ведет на несколько подкатегорий внутри Samsung.

Другой пример таксономии с горизонтальными ссылками можно найти на главной странице Target (обратите внимание на категории «Хэллоуин» и «Готовы к школе»).

Вместе с этим часто покупают

Пакеты продуктов – это один из лучших (а, возможно, и САМЫЙ лучший) способ семантически связать два продукта, которые тесно связаны друг с другом, но находятся в разных категориях.

Связанные категории

Стратегии оптимизации внутренних ссылок для контент-ориентированных сайтов

Разделение тем: идея заключается в том, чтобы в статьях чаще ссылаться на близкие по темам материалы и реже – на тексты по другим темам. То же самое можно сделать для товара в категории. Таким образом вы гарантируете, что текст ссылки останется актуальным, а статьи будут находиться в непосредственной близости друг к другу.

Эволюция разделения тем – это тематические кластеры. Такой подход предполагает статью, охватывающую короткое (основное) ключевое слово, а также короткие статьи (кластеры) для длинных ключевых слов, связанные и ссылающиеся на основное. Это позволяет создать тесные тематические отношения внутри ссылочной структуры.

Статьи по теме: Ссылки на статьи по теме внизу страницы должны использоваться на всех сайтах. Тем не менее, некоторые до сих пор о них забывают. Не совершайте эту ошибку! Оставляйте ссылки на близкие по теме сайты на с релевантными статьями.

Вот и все, друзья! Если вам кажется, что мы что-то упустили – расскажите об этом в комментариях, и мы обязательно дополним статью.

Внутренние ссылки и SEO, SILO-структура сайта — практическое руководство

Внешние ссылки это как Бэтман, внутренние — как Робин. Последние имеют огромное значение для SEO, но получают куда меньше внимания, чем супергеройские бэклинки.

Какие такие внутренние? Те, что есть на каждом сайте и ведут с одной страницы домена на другую. Стратегическое использование этих ссылок может существенно повысить видимость сайта в поисковых системах.

Сервис для автоматизации линкбилдинга и аутрича, Ninja Outreach, благодаря работе над внутренней перелинковкой увеличил органический трафик на 40%. Есть подробный кейс на английском. Ahrefs подтверждает успех операции:

Почему внутренние ссылки так важны для SEO?

Во-первых, Яндекс и Google используют их для поиска новых страниц на вашем сайте. Предположим, вы разместили новый документ, но ни одна старая страница на него не ссылается, внешних ссылок тоже пока нет, и в Sitemap страницу мы не указали. Краулеры Яндекса и Google просто её не найдут:

Страницы, на которые не ссылаются другие документы называются orphan page, то есть «страницы-сироты». По-хорошему их нужно: удалять, закрывать от индексации или расставлять ссылки, ведущие на них, если документы важны для SEO.

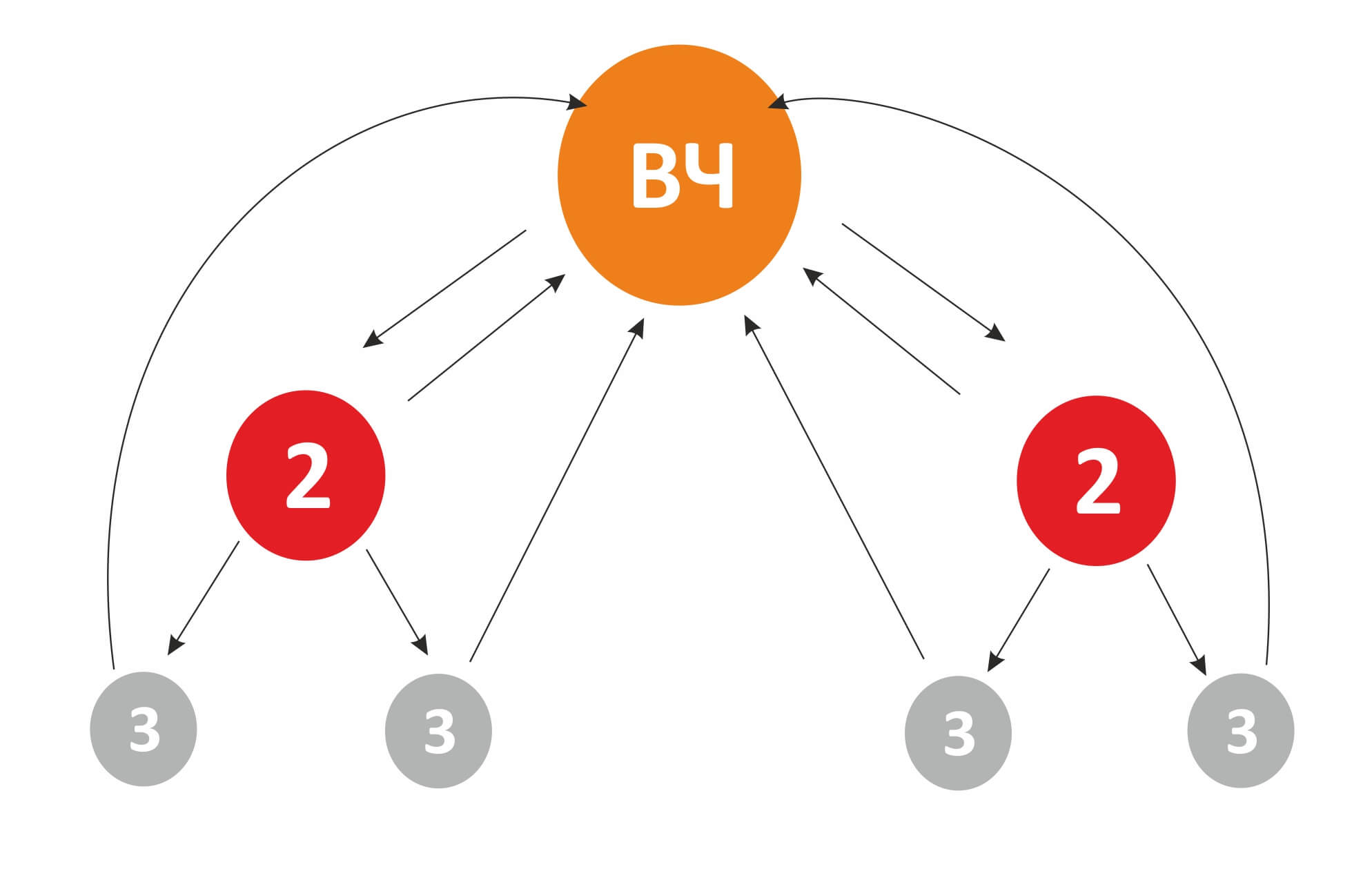

Также внутренние ссылки влияют на PR (PageRank) страницы. Но здесь важно не только количество, но и качество ссылок.

Вот упрощенная схема того, как формируется PageRank:

Заметка: хотя Google прекратил поддержку тулбара, показывающего PR, сам показатель продолжает использоваться в ранжировании. Например, об этом говорят сами работники Google.

Кроме того, структура сайта с точки зрения внутренних ссылок влияет на отображение дополнительных ссылок в сниппетах.

Идеальная структура внутренних ссылок

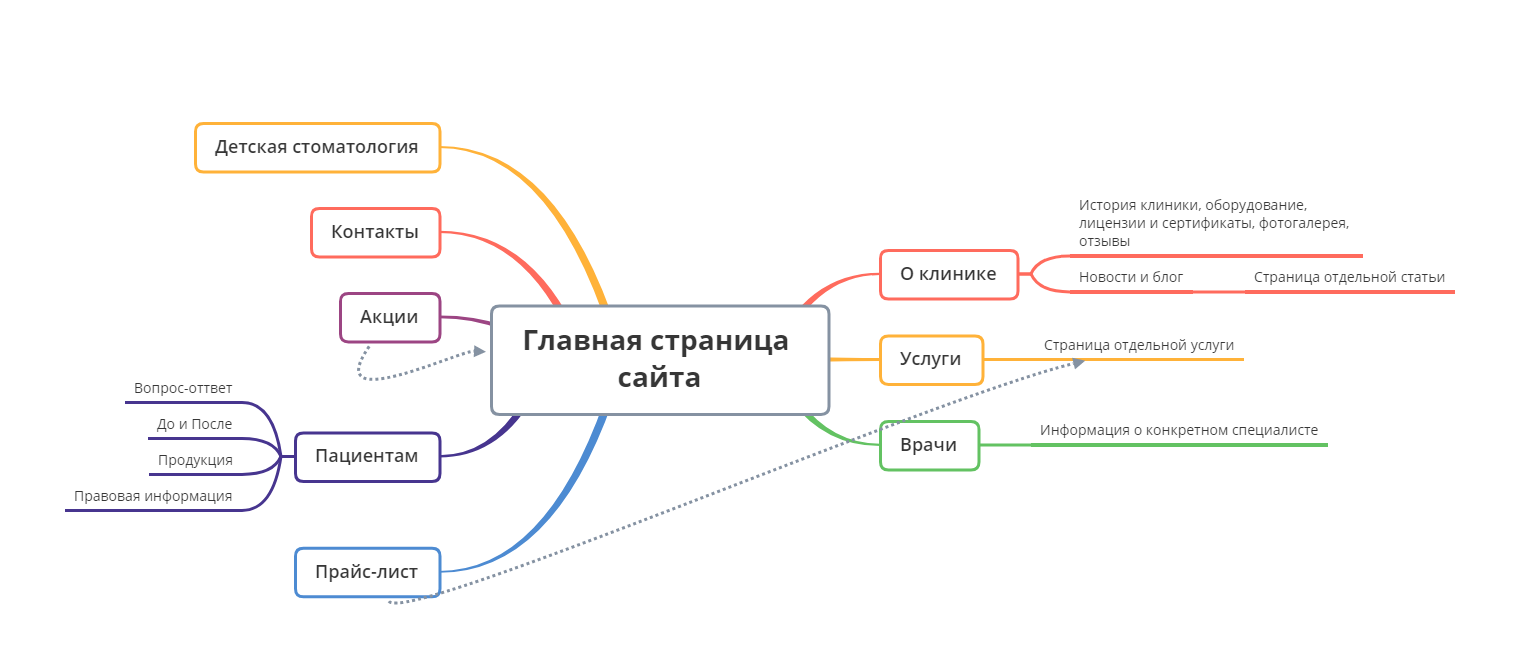

Полезно представить свой сайт в виде пирамиды, где важный контент расположился на вершине, а менее значительный — ближе к основанию.

На вершине большинства сайтов — главная страница. Спускаемся ниже: услуги, продукты, о нас, контакты, блог или другое. Далее – документы из подразделов, посадочные под конкретные виды услуг, карточки товаров и прочие.

Но вам не нужно связывать все страницы на одном уровне иерархии со всеми документами на другом уровне иерархии. Здесь важна релевантность, логичность и определённая стратегия.

Искусство силосования (SILO-структура)

Такой термин использует Ahrefs в работе над перелинковкой. Звучит не очень, но неплохо описывает процесс — консервирование сочной растительной массы. В нашем случае ссылочной. То есть речь о правильной группировке тематически связанных страниц.

Например, у нас сайт и страницы, посвященные странам и городам:

Каждая из страниц попадает в одну из групп:

-

страны

-

города

Скорее всего, SILO-структура будет выглядеть так:

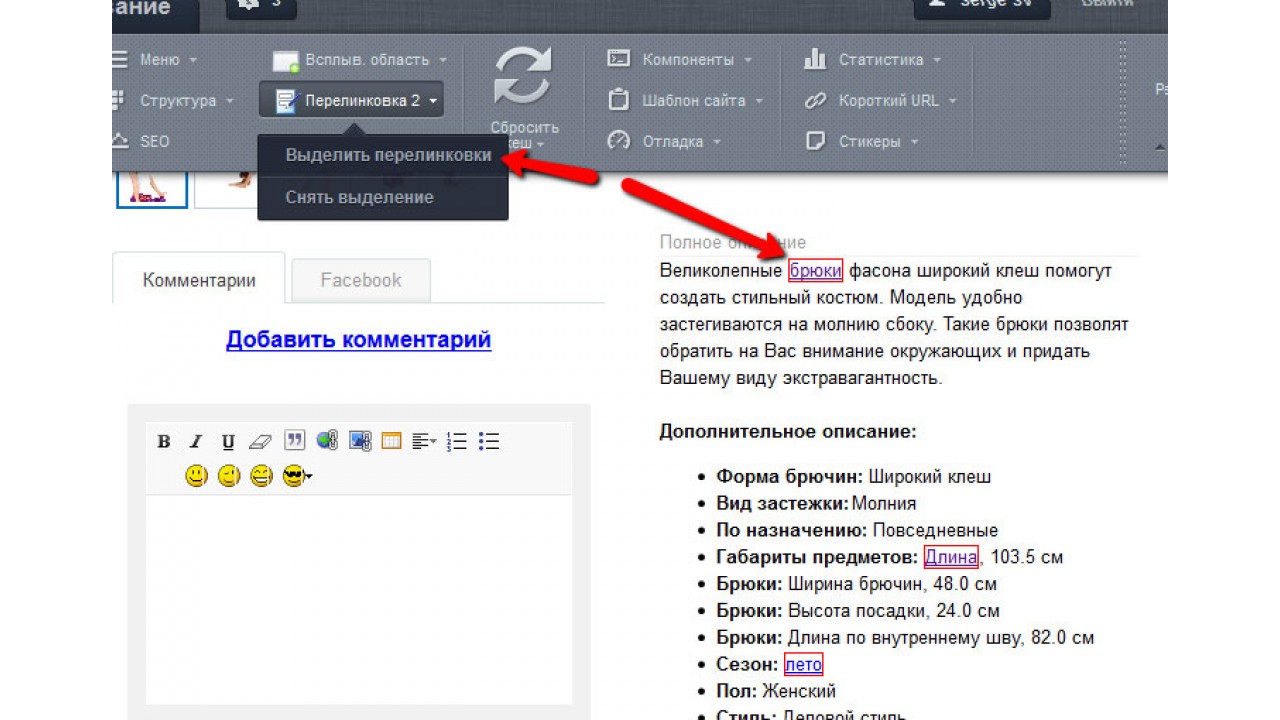

Таким образом, каждая страница выступает в роли «хаба» и содержит ссылки на связанные страницы: страны или города. Такой подход помогает создать тематические кластеры — группы тесно связанных документов.

Три преимущества такого подхода:

-

Интуитивная навигация для пользователей.

-

Краулерам легче понять структуру вашего сайта и сканировать страницы.

-

Правильное распределение «важности» (подстраницы ссылаются на «хабы» и наоборот).

Есть ещё одно важное достоинство — поисковые системы начинают понимать контекст и взаимосвязь вашего контента.

Предположим, у нас есть следующая страница: domain.com/squash

О чём эта страница? Сквош — это игра или кабачок в переводе с английского. Непонятно. Но если эта страница часть SILO-структуры, всё становится ясно даже краулерам:

Также правильная иерархия даёт возможность правильно распределить статический вес страницы и использовать анкорный текст на ссылающихся документах без опасения нарушить тематическую связность контента.

Как проверить внутренние ссылки и проанализировать конкурентов?

Всё прекрасно, когда мы запускаем сайт с нуля и можем организовать иерархию по обозначенным выше советам. Но как быть если мы работаем с уже готовой структурой?

Для начала её следует проанализировать. У нас есть отдельный инструмент, который получает иерархию сайта с учётом уровней вложенности на основе проиндексированных Яндексом страниц.

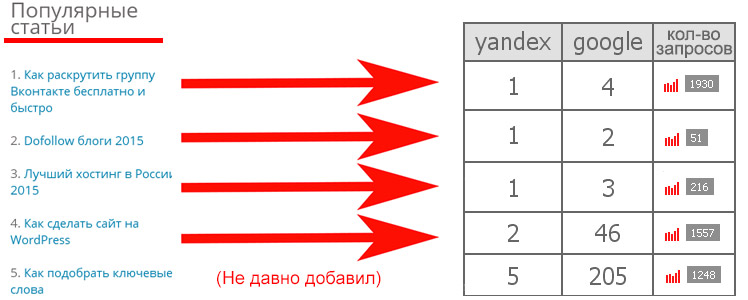

Инструмент поможет проверить собственный проект или сайт конкурента, что полезно для поиска новых типов страниц и точек роста. Например, на нашем сайте в разделе, посвящённому контекстной рекламе всего 18 страниц, что составляет 0,9% от всех документов проекта:

А вот сколько у конкурентов. Уже есть над чем подумать, если имеются проблемы с позициями и поисковым трафиком:

Как проверить число внутренних ссылок на странице и определить их необходимое количество?

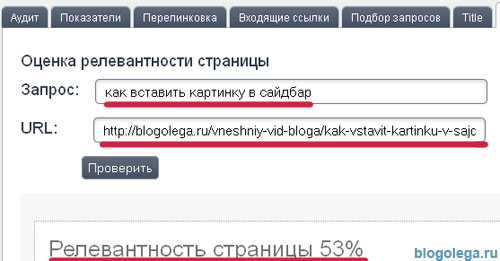

Ориентироваться на ТОП выдачи по запросу. Для этой задачи используйте инструмент Анализ ТОП в Google или Яндексе. Указали запрос, выбрали глубину ТОПа и получили результаты и рекомендации:

В отчёте мы видим, что количество внутренних ссылок на продвигаемой странице почти в два раза превышает среднее по ТОПу. Возможно, стоит проработать и этот момент.

Не забывайте, что анкорный лист может влиять на переоптимизацию документа, а у Яндекса есть даже отдельный фильтр за переизбыточную перелинковку. Если число внутренних ссылок обусловлено тематикой или количеством товаров / услуг, то важно оформить их в удобный и полезный для пользователей блок.

Неработающие страницы (404)

Периодически проводите аудит сайта на наличие 404-ошибок и удаляйте ссылки, ведущие на такие страницы или настраивайте для них 301-редирект.

Для регулярного поиска этих страниц удобно завести проект в нашем модуле. Согласно выбранным интервалам проведения аудитов, система будет проверять коды ответа страниц сайта и сообщать о найденных ошибках.

Как стратегически использовать внутренние ссылки для прокачки новых страниц?

Предположим, вы разместили новый контент на сайте. Попробуйте отыскать тематически связанные с ним старые страницы и разместите ссылки, ведущие на свежий URL.

Особенно хорошо, если ссылки будут вести с качественных трафиковых документов. Совсем круто — если у них есть бэклинки. Так вы сможете передать часть ссылочного веса новой странице.

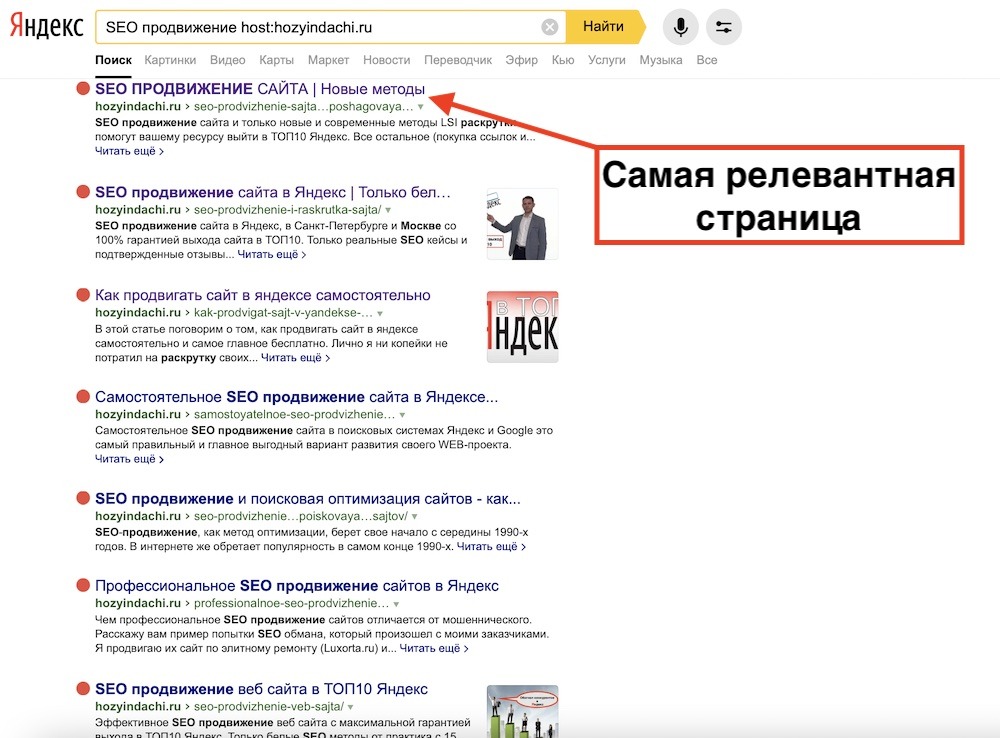

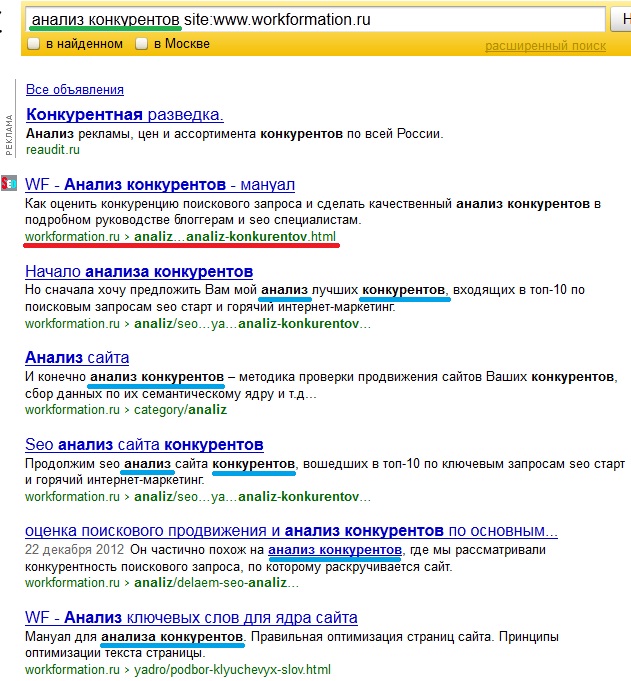

Чтобы найти подходящий URL, используйте поисковые операторы. Например, мы разместили статью про аудит контента. Хотим добавить на неё ссылку с другой, уже прокаченной, страницы. Идём в Google и, используя оператор, находим подходящую:

Если хотите узнать какие из страниц вашего сайта имеют больше всего внешних ссылок и планируете использовать их для буста свежего контента, загляните на вкладку «аудит» в Проектах. Модуль анализирует ссылочную массу из Вебмастера и показывает самых мощных акцепторов. Используйте их авторитет для перелинковки:

Напоследок

Три полезных правила, которых стоит придерживаться:

-

Не используйте один и тот же анкорный текст для одного URL-получателя. Старайтесь его максимально разнообразить.

-

Старайтесь добиться тематической связности страниц.

-

Не переусердствуйте. Внутренних ссылок не должно быть слишком много. Можно взять максимальный порог в 400-500 штук. Всё зависит от тематики — анализируйте конкурентов в нише.

В качестве хорошего примера внутренней перелинковки посмотрите на Википедию. Это эталон продуманной навигации и тематических кластеров =)

Что ещё почитать про внутренние ссылки и организацию страниц?

Всем продуманной иерархии, красивой структуры и удобной навигации!

Проверка (анализ) сайта — 85 онлайн сервисов и программ

Обновлено 22 мая 2021- SEO анализ сайта

- Инструменты для вебмастеров

- Проверка сайта на фильтры и историю

- Онлайн сервисы и программы для Сео анализа

- Проверка сайта с помощью плагинов для браузеров

- Проверка позиций сайта

- Сколько стоит сайт

- Проверка обратных ссылок сайта

- Проверка траста и доверия к сайту

- Расшаривания ресурса в социальных сетях

- Проверка кода, битых ссылок и ответов сервера

- Скорость загрузки и правильность перелинковки

- Проверка доступности сайта (аптайм)

- Сервисы по проверке орфографии

- Где проверить тексты сайта на уникальность

- Программы для проверки уникальности текстов

- Проверка текстов на переспам

- Проверка сайта на вирусы

Здравствуйте, уважаемые читатели блога KtoNaNovenkogo.ru. Сегодня я хотел бы в рамках одной статьи объединить все сервисы и программы, которые могут помочь вебмастеру в оценке достигнутых сайтом результатов и перспектив развития на будущее.

Далеко не все упомянутые ниже инструменты понадобятся «здесь и сейчас», но вполне возможно, что такая необходимость возникнет у вас со временем, поэтому не примените добавить этот пост в закладки.

Сегодня речь пойдет про проверку индексации и позиций занимаемых сайтом в поисковой выдаче, про оценку его доступности и скорости загрузки, проверку на ошибки, вирусы и уникальность размещенных на нем текстов.

А также про анализ обратных ссылок, оценку стоимости сайта, проверку кросбраузерности верстки, посещаемости и много другого. Если какие-то аспекты или сервисы были упущены, то с вашей подсказки они будут добавлены в данный список.

SEO анализ сайта в онлайн сервисах и программах

Что такое анализ? В общем смысле это широкое понятие, которое включает в себя проверку десятков (а можете быть даже и сотен) показателей, таких, например, как Тиц и Пр, число проиндексированных поисковыми системами страниц, видимость сайта в поисковиках и позиции занимаемые им в выдачах по различным запросам. Узнайте больше про сервисы проверки позиций — сравните цены и возможности. В общем, это огромный комплекс параметров, который сегодня попробуем охватить.

Наверное, стоит начать с проверки индексации вашего сайта ведущими поисковыми системами рунета. Понятно, что приток посетителей с поисковиков является желанным для всех владельце ресурсов, но он будет невозможен априори, если ваш сайт еще не был в полной мере проиндексирован (читайте про то, как работают поисковики).

Инструменты для вебмастеров от поисковых систем

Доступ к данным панелей вебмастера поисковых систем Яндекс, Google, Бинг и Майл.ру можно будет получить только после того, как вы подтвердите свое право на владение сайтом. Эта информация и функционал являются доступными только для владельцев ресурсов, хотя в Яндексе есть ряд инструментов доступных для всех.

Нужно ли тратить время на регистрацию и подтверждение прав в панелях вебмастеров? Безусловно стоит, поэтому я приведу ссылки на свои статьи, где подробно описывал этот процесс, а также возможности всех этих панелей поисковых систем.

- Вебмастер Яндекса — целый набор инструментов, который существенно улучшился и расширился после недавнего обновления:

- Сообщить о новом сайте (переобход страниц в Яндекс Вебмастере) — если у вас появился новый проект, который еще не проиндексирован ни одним поисковиком, то имеет смысл добавить его в так называемые аддурилки (от слова Add url). Сейчас этот инструмент можно так же использовать для того, чтобы заставить заново проиндексировать уже существующую страницу, его она, например, была изменена и вам важно, чтобы в индексе была именно новая версия странички.

Проверить сайт — очень полезный инструмент, который позволит оценить степень индексации любого ресурса Яндексом:

Можно посмотреть дату попадания любой страницы сайта в индексную базу Яндекса, а при необходимости обновления можно будет воспользоваться предыдущим инструментом.

Проверить robots.txt — есть такой инструмент в арсенале вебмастеров, который позволяет запретить поисковым роботам (всем или только избранным) индексировать определенные разделы или отдельные страницы на вашем сайте. Синтаксис этого файла не так уж и сложен, и я о нем довольно подробно писал в статье про настройку индексации через файл robots.txt, но все равно будет не лишним проверить его работоспособность:

Проверить орфографию — замечательный инструмент, которым я пользуюсь для проверки всех своих статей сразу после их публикации. Более подробно описан в этой же публикации.

- Пожаловаться на спам и вирусы — вот это уже в духе буржуйских сервисов, ибо стучать в рунете считается делом зазорным, что, в общем-то, и понятно, ибо в начале и середине прошлого века половина всего населения прошла через лагеря, и живем мы теперь больше «по понятиям», чем по закону. Хотя лично я считаю, что плохие сайты (ГС), фейковые ресурсы (читайте что такое фейк) и ресурсы заражающие наши компьютеры вирусами (пусть даже, зачастую, и непреднамеренно) должны быть известны поиску, чтобы он мог вовремя принять меры к удалению ГС и фишеров из индекса или уведомлению вебмастеров о заражении зловредами. ИМХО.

- Удалить URL — в общем-то, не совсем понятно назначение этого инструмента, ибо сам алгоритм поиска должен удалять из индекса все страницы, которые отдают в ответ 404 ошибку, либо запрещены к индексации в файле robots.txt или одноименном мета-теге. Возможно, что таким образом можно будет несколько ускорить этот процесс, подстегнув робота Яндекса на внеочередную проверку статуса указанных страниц.

Валидаторы микроразметки, XML-фиды и файлы Sitemap — существуют специальные коды микроразметки, которые позволяют коммерческим и официальным сайтам организаций добавлять свой адрес в сниппет или еще что-то другое, что оговорено в соответствующем разделе хелпа Яндекса. Здесь это дело можно будет проверить на ошибки и соответствие принятым стандартам.

То же самое касается созданных карт в формате XML, которые вы должны иметь для улучшения и ускорения индексации. Файл карты сайта можно будет сначала проверить на ошибки, а уже потом добавлять в соответствующую форму Яндекс вебмастера (она доступна только после подтверждения права на управление) или же прописывать путь до него в файле robots.txt

- Вебмастер Гугла — собственно, аналогичный инструмент от Google, но со своими нюансами и возможностями.

- Кабинет для вебмастеров в Майл.ру — отличается от аналогов тем, что в нем имеется возможность проверить поведенческие характеристики сайта.

- Панель для вебмастеров от Бинга — раньше была еще отдельная панель в Яху, но после его поглощения поисковой системой Бинг осталась только эта. Если в панели от Яху можно было получить интересную информацию по обратным ссылкам ведущим на сайт, то тут уже ничего такого не осталось, хотя свои изюминки тоже имеются.

- Vpodskazke — новый сервис для продвижения подсказок в поисковых системах. Можно продвигать сайт и привлекать целевых посетителей с помощью Vpodskazke, который позволяет поднять нужные вам поисковые подсказки в Яндексе

Проверка фильтры и история сайта

- Website Penalty Indicator — если ваш сайт был пессимизорован в Гугле (у вас просел поток посетителей идущих с этой поисковой системы), то данный инструмент позволит определить, после апдейта какого именно из двух фильтров Google (Панды или Пингвина) это произошло. Зачем это нужно? Если виной всему оказался Пингвин, то вам нужно будет проверять и снимать «плохие» ссылки (читайте про вывод сайта из под фильтра Google Пингвин) или же добавлять их в инструмент Disavow links.Если же виновницей пессимизации стала Панда, то нужно смотреть в сторону переспама текстов, заголовков, внутренней перелинковки и т.п. вещей, касающихся именно устройства вашего сайта. В случае моего блога получается, что именно Панда (даты ее апдейта отмечены красными вертикальными линиями на графике) в апреле 2012 подрезала ему крылья и продолжает это делать в течении уже двух лет. Начальную дату в верхнем поле можно изменить и тем самым расширить диапазон проверки.

- Archive.org — уникальная возможность проверить сайт на предмет его исторического развития.

Например, если вы выбираете донора для размещения ссылки и хотите избежать вероятности попадания на дроп, то этот сервис поможет вам понять, сменился ли владелец и тематика данного сайта в последнее время. Также этот сервис может являться источником уникального контента для сайта. Как с ним работать, я подробно описывал в статье про Webarchive.

Онлайн сервисы и программы для полной проверки сайта

- Site-Auditor — замечательная, простая и бесплатная программа от Игоря Ашманова. Пользуюсь ей с момента появления данного блога и по сей день. Все ее возможности описал в статье приведенной по ссылке (правда, после перехода на третью версию дизайн ее в корне поменялся, а статью я еще не обновлял — но суть и возможности остались прежними).Умеет она не только проводить экспресс-анализ любого интересующего вас сайта (тиц, индексация, каталоги, посещаемость), но и проверять позиции по введенным вами запросам. Да, в ней мало автоматизации, но она все равно лучшая в своем роде.

Серпхант — отечественный сервис, предоставляющий широкий набор инструментов для анализа и мониторинга SEO-показателей сайтов (в том числе и конкурентных площадок).

В состав платформы входит 7 средств:

- Инструмент для снятия и отслеживания позиций сайта в поисковых выдачах Яндекса и Google.

- Инструмент для измерения показателей посещаемости.

- Проверки индексации веб-страниц сайта.

- Средство SEO-анализа конкурентных площадок с функцией концентрации ключевиков и сравнения с заданной страницей.

- Инструмент для оценки качества контента сайта.

- Анализ входящей ссылочной массы.

- Анализ популярности ключевых слов.

Чтобы воспользоваться перечисленными выше возможностями Серпханта, нужно пройти регистрацию и выбрать один из тарифных планов.

*при клике по картинке она откроется в полный размер в новом окнеВ рамках бесплатной подписки (тариф «Старт») пользователю предоставляется 500 проверок на месяц. Этого объема вполне хватает для всестороннего мониторинга и анализа небольшого сайта. А также SEO-исследования площадок ближайших конкурентов.

Платформа предоставляет эффективное средство для быстрого определения позиций сайта. В Серпхант этот инструмент предоставляется бесплатно и без регистрации. Он позволяет проанализировать рейтинг веб-страницы или сайта по пятидесяти ключевым словам в региональных выдачах Яндекса и Google.

Сервис умеет определять ключевые слова сайта, по которым он представлен не только в отечественных версиях выдачи, но и зарубежных.

Процесс анализа занимает всего несколько секунд. Поэтому Серпхант можно смело назвать одной из самых быстрых платформ для всестороннего исследования SEO любого интернет-ресурса.- Pr-cy — один из самых популярных и известных сервисов, на котором можно провести довольно масштабный онлайн анализ своего или чужого сайта. Достаточно будет зайти на страницу с инструментами для вебмастеров, чтобы понять насколько обширные возможности вам предоставляются.

- Cy-pr — похож по названию и частично по функционалу на описанный выше онлайн сервис. По приведенной выше ссылке вы сможете провести бесплатный экспресс анализ сайта.

На странице с результатами будет информации побольше, чем в Pr-cy, но по сути все то же самое. Можно узнать тот же самый Тиц, ПР и Alexa Rank. Для просмотра многих данных нужно щелкнуть по иконке с замочком.

- Xseo — мощный по функционалу, но не очень удобный с точки зрения юзабилити сервис проверки массы Сео показателей сайта. Инструментов действительно очень много и они отлично работают, но вот темный фон лично меня сильно напрягает.Позволяет проверить, например, процент страниц сайта, которые находятся в сопливом индексе (Supplemental Index) Google.

- 2ip— в большинстве своем «попсовый» сервис, но кое-что интересное в нем все же проверить можно.

- SEO Site Checkup — буржуйский сервис, который анализирует кучу Сео параметров вашего сайта и через минуту-другую выдает свой вердикт и советы по улучшению оптимизации.

- Alexa — старейший сервис, который собирает данные о всех сайтах в интернете. Делает он это благодаря своему тулбару, который установлен на многих браузерах пользователей (в основном в буржунете). Он позволяет по месту сайта в общем и региональном рейтинге оценить его посещаемость, а также узнать еще много интересного про источники трафика и поведение посетителей.Сейчас этот сервис, правда, движется в сторону коммерциализации, поэтому все самое «вкусное» можно посмотреть только за денежку.

- SimilarWeb — выдает довольно-таки много информации и графиков, которые чем-то напоминают упомянутый чуть выше сервис alexa.com.

Расширения для браузеров, позволяющие проверять любые сайты

Не всегда удобно использовать упомянутые выше онлайн сервисы, когда вам регулярно требуется проверять Сео показатели множества сайтов, например, при подборе доноров, на которых планируете закупать ссылки в ГоГетЛинкс, РотаПост, Collaborator или WebArtex. В этом плане гораздо более удобным вариантом представляется использование расширений для того браузера, которым вы пользуетесь.

В принципе, я довольно подробно писал про такие дополнения для некоторых браузеров:

- SEO плагины для Мазилы

- СЕО расширения для Оперы

- SEO дополнения для Гугл Хрома

Среди универсальных плагинов, работающих почти во всех браузерах, хотел бы выделить этих двух представителей:

- Rds Bar — это тот инструмент, которым пользуюсь практически ежедневно. По приведенной ссылке вы найдете его подробное описание, здесь же я скажу, что он позволяет в считанные секунды увидеть основные SEO характеристики открытой в браузере страницы. В обзоре биржи Ротапост я описал те пункты проверки, на которые стоит обращать особое внимание.

Кроме этих данных, плагин Rds Bar позволяет проверить внешние ссылки на данной странице на предмет их открытости для индексации поисковиками. По умолчанию эта опция включена, а в настройках плагина вы сможете изменить палитру для фона подсветки и используемых рамок.

- SeoQuake — буржуйский аналог Rds Bar (или наоборот). Удобно с помощью него анализировать выдачу в Яндексе и Гугле

Вполне себе функциональный и удобный, особенно для тех, кто к нему уже привык.

Проверка позиций сайта в выдачах Яндекса и Google

- Site-Auditor — уже упомянутая чуть выше программа, которая умеет довольно-таки сносно в полуавтоматическом режиме проверять позиции сайта по интересующим вас поисковым запросам. Да, долго, нудно и капчу придется все время вводить, но для быстрой рекогносцировки вполне подойдет.

- Проверка видимости сайта в Мегаиндексе — сервис бесплатный и позволяет посмотреть позиции вашего сайта по тем запросам, по которым он имеет хоть какую то видимость (находится в Топ 100 Яндекс или Гугла). Это очень полезно бывает знать, чтобы покупкой ссылок загнать такие запросы в Топ 10 (откуда реально может идти трафик).Сам сервис МегаИндекс предназначен для продвижения сайтов (за деньги), но имеет еще массу бесплатных сервисов описанных в упомянутой статье. Иногда бывает полезно проверять видимость не только своего сайта, но и ресурсов конкурентов, чтобы позаимствовать у них удачные ключевые слова.

- Проверка позиций в ТопВизоре — онлайн сервис Топвизор платный, но зато осуществляет проверку в полностью автоматическом режиме и в соответствии с заданными вами в настройках интервалами. Результаты проверок предоставляются в довольно удобном и наглядном виде.Ключевые слова, которые вы будете проверять, можно будет прямо в этом онлайн сервисе и подобрать (т.е. собрать семядро). Также имеется возможность проверять ограниченное число поисковых запросов бесплатно за счет отданных сервису лимитов в Яндекс XML. Подробнее читайте в статьях по приведенным ссылкам.

- Проверка позиций сайта в SE Ranking — еще одни платный сервис, в котором предусмотрена арендная плата за пользование его возможностями (совсем недавно появилась так же и возможность оплаты за отдельные проверки). Также имеется вариант купить у них скрипт и установить его на свой сайт, чтобы самостоятельно производить съем позиций в неограниченном количестве и бесплатно.

- Rankinity — конкуренция всегда выгодна конечному пользователю и поэтому я вам представляю еще одного очень серьезного игрока на рынке проверки позиций занимаемых сайтом в поисковых системах. У него есть свои особенности, которые вам могут приглянуться, поэтому не примените ознакомиться и с ним тоже, прежде чем сделать выбор в пользу одного из кандидатов.

Как узнать стоимость своего или чужого сайта?

На самом деле, существует довольно много ресурсов, которые готовы дать оценку вашему ресурсу в плане его стоимости (собственно, упомянутый в этой статье SEObuilding сделает это на раз). Но как мне кажется, наиболее точный прогноз должен давать сервис, который ориентирован на покупку и продажу вебсайтов, ибо у них за годы работы накопилось достаточно много статистического материала, который можно применять при расчетах.

Проверка стоимости сайта в Telderi — сервис этот относится к бирже Telderi, которая выступает гарантом при совершении сделок купли или продажи сайтов, ну и позволяет разместить свое объявление о продаже или посмотреть имеющиеся на данный момент предложения о покупке. Проверка стоимости будет проведена точнее, если вы заполните все поля в форме, но для грубой оценки достаточно просто указать Урл.

Для моего блога он выдал такой вот вердикт:

Проверка обратных ссылок сайта

Обратные ссылки для своего или чужого сайта можно будет посмотреть на ряде сервисов, которые специализируются на сборе подобной информации. Бесплатно для своего сайта эту информацию можно почерпнуть из упомянутых чуть выше панелей для Вебмастеров от Яндекса и Гугла:

- Проверка обратных ссылок в Яндексе — из левого меню выбираете «Индексация сайта» — «Входящие ссылки».

Очень здорово то, что если ввести в фильтр поля «Куда» адрес любой страницы своего сайта, то точно узнаете другие ресурсы, которые на нее ссылаются.

Для выгрузки всех найденных обратных ссылок прокрутите список до конца и нажмите на кнопку «Архив от»:

- Выгрузка обратных ссылок из панели Гугла — выберите из левого меню «Поисковый трафик» — «Ссылки на ваш сайт», нажмите на кнопку «Дополнительно» и на открывшейся странице кликните по кнопке «Загрузить больше ссылок для примера».

У вас будет возможность сохранить этот список в формате CSV и открыть его потом в Экселе, либо сразу начать работать с документами в Гугл Диске. Как получить из этого полного списка Урлов полный список доменов доноров, читайте тут.

Гораздо больше возможностей по работе с обратными ссылками предоставляют специализированные сервисы, но, к сожалению, доступ к их полному функционалу платный и не так чтобы слишком уже дешевый. Чуть ниже я упомяну способ получения выгрузки из Ahrefs.

Итак, где же можно проверить обратные ссылки на ваш сайт:

- Ahrefs — один из самых популярных ссылочных анализаторов. Предоставляемая им бесплатная информация довольно скудна, а за большее придется платить (от восьми десятков баксов в месяц). Можно будет оценить качество доноров и многое другое интересное почерпнуть (поищите на блоге Михаила Шакина — там есть, по-моему, хорошая статья или записанный им ролик на тему работы с Ahrefs).

- Backlink за копейки — позволяет сделать выгрузку обратных ссылок ведущих на ваш домен из упомянутого выше сервиса Ahrefs. Плата взимается за каждый бэклинк. Например, для моего сайта это будет стоить столько (не копейки, но все же дешевле):

- Open Site Explorer — тот самый знаменитый SeoMoz, который теперича стал просто Мозом. В общем-то, все то же самое — платите деньги и будет вам проверка по всем пунктам.

- Linkpad — бывший Solomono. У них тоже можно найти много интересного про ваши обратные ссылки и про оценку качества ваших доноров. Все это доступно бесплатно, в отличии от упомянутых выше сервисов. Там довольно-таки много информации, но ее еще нужно будет научиться понимать и воспринимать.

Кроме проверки ссылок там имеются инструменты для продвижения своего сайта (за деньги, естественно), ну и биржа ссылок наличествует.

- Majestic SEO — в бесплатном варианте этот сервис тоже предоставляет не очень много информации, но зато выводит вот такой вот замечательный график (справа), по которому можно очень быстро оценить количество и качество обратных ссылок, ведущих на изучаемый вами сайт (например, когда проверяете потенциальных доноров), а чуть ниже приведены количественно временные графики истории наращивания ссылочной массы.

- SEMrush — как бы все то же самое. Сервис платный и в демо режиме не очень-то и функционален.

- Проверка наличия обратных ссылок — если вы обменивались или покупали ссылки минуя различные биржи (например, ГоГетЛинкс, РотаПост, Collaborator или WebArtex), то отслеживать их наличие вам придется самим. Для этого и может понадобиться данный сервис, в который можно за раз загрузить до 100 Урлов страниц, где должны быть размещены полученные вами бэклинки. В результате проверки вы узнаете где они еще стоят, а где были удалены.

- Когда вам нужно будет вогнать в индекс новые страницы, появившиеся на сайте, то лучшим вариантом будут сервисы по привлечению быстробота (индексатора) поисковых систем. Среди них могу выделить два похожих — IndexGator и GetBot. Стоит это дело совсем не дорого, а эффект достаточно стабилен.

Проверка траста и доверия к сайту

- XTools — сервис существует уже довольно-таки давно. Если нужно проверить траст своего сайта, то это можно будет сделать бесплатно. Хотя траст и считается мифическим понятием, но владельцы сервиса подразумевают под ним общий вес ресурса в глазах поисковых систем (по совокупности факторов ранжирования).Массовые проверки траста, например, для сайтов доноров осуществляются на платной основе.

- Сервис сравнения сайтов от SEObuilding — позволяет бесплатно проверить список доноров на траст и другие важные показатели, которые могут повлиять на ваш выбор.

- CheckTrust (FastTrust) — сервис и программа от Алаича. Суть та же — помочь вам подобрать наиболее подходящих трастовых и не заспамленных доноров (сайты, с которых вы сможете купить в ГоГетЛинкс, РотаПост, Collaborator или WebArtex ссылки).

- Проверка доверия к сайтам в Web of Trust (WOT) — расширение для браузера, которое позволит вам быстро понять, насколько можно доверять тому или иному открываемому вами сайту.Фактически он показывает репутацию отрытого в браузере сайта, которую формируют такие же пользователи как и вы, путем оценки этих ресурсов в WOT.

Как проверить число расшариваний в социальных сетях

- Google +1 Checker — поможет вам проверить сколько кликов по кнопке социальной сети Google+ получили отдельные страницы вашего сайта, Урл которых вы введете в предложенную сервисом форму (до 50 Урлов за одну проверку).

- Число расшариваний и комментариев в Фейсбуке — используем стандартный дебагер Фейсбука. Достаточно будет ввести Урл интересующей страницы вашего сайта (вы должны быть авторизованы в этой социалке) и получите искомое значение. Немного неудобно, но зато наверняка точно, ибо взято из первоисточника.

- SharedCount — хотите узнать число расшариваний любой страницы вашего сайта в такие популярные социальные сервисы, как Твиттер, Google+, Pinterest, LinkedIn, Facebook и другие? Просто введите Урл страницы в предложенную форму и смотрите результаты:

- Поверка числа расшариваний в рунетовских соцсетях (Одноклассниках, Вконтакте, Мой мир и Я.ру). Собственно, может служить дополнение к упомянутому выше сервису — нужно просто ввести Урл вебстраницы и посмотреть результат.

- LinkTally — поможет вам узнать число расшариваний любых страниц вашего или чужого сайта в популярных социальных сетях буржунета.

Проверка кода сайта, битых ссылок и ответов сервера

- Проверка валидности Html кода сайта — вещь нужная, ибо позволяет выявить грубые ошибки совершенные при верстке, но зацикливаться на полном их устранении не стоит, ибо это практически не реально (почти все ресурсы в интернете их имеют). К тому же это не добавит вам плюсов в ранжировании сайта поисковыми системами, но иногда ошибки верстки мешают правильной индексации, поэтому внимание на это обращаем, но без фанатизма.

- Проверка валидности CSS кода — также может быть полезным взглянуть на ошибки верстки с точки зрения стилевого оформления и соответствия стандартам CSS3. Проверка осуществляется на официальном сайте валидатора W3C.

- Валидатор RSS ленты сайта — собственно, если есть проблемы с фидом, либо добавляли возможность его использования на вашем вебсайте самостоятельно, то можете осуществить проверку на валидность формируемой ленты, чтобы быть спокойным за это дело.

- Проверка ссылок на странице — открывает все ссылки имеющиеся на странице, урл которой вы вставите в приведенную форму. Таким образом можно найти все имеющиеся на ней битые ссылки.

- Проверка сайта на битые ссылки в Xenu Link — это программа, которая позволяет выявить и исправить битые ссылки, которые имеются на любом ресурсе. Их большое количество, равно как и большое количество орфографических ошибок и ошибок в коде, может привести к пессимизации вашего сайта поисковыми системами. Как работать с этой программой описано в приведенной по ссылке статье.

- Screaming Frog SEO Spider Tool — программа очень похожая по своим возможностям на упомянутую чуть выше Xenu Link. Правда в бесплатной версии она имеет ограниченный функционал и возможности.

- Проверка ответа сервера — инструмент из арсенала Яндекс Вебмастера. Правда использовать его можно только для вашего сайта, права на который вы подтвердили.

Более подробно про коды ответа сайта и редиректы читайте в приведенной по ссылке статье.

Проверяем скорость загрузки сайта

- Проверка оптимизации скорости страницы — у меня была целая серия статей, посвященная увеличению скорости загрузки сайта. Так вот, данный сервис представляет из себя онлайн версию инструмента Page Speed, о котором шла речь в статье. Он не просто выдает вердикт, а дает конкретные советы по ускорению работы вашего ресурса.Кроме этого он дает оценку адаптированности вашего сайта для показа на мобильных устройствах и предлагает конкретные шаги для ее улучшения. Подробности смотрите в приведенной по ссылке статье.

- Test my Site — похожий сервис от того же Гугла, но с более попсовым интерфейсом:

- GTmetrix — достаточно просто указать адрес страницы, скорость загрузки которой вы хотите измерить.В результате вы получите отчет, сформированный на основе данных двух плагинов для браузеров — Page Speed (читайте о работе с ним ниже) и YSlow. Собственно, каким данным доверять и чьим рекомендациям следовать — решать вам. На диаграммах можно легко отследить те элементы, которые тормозят загрузку, а также посмотреть, какие изображения можно будет объединить в спрайты для уменьшения числа запросов к серверу.

- Web Page Analyzer — измеряет скорость загрузки страницы при различных скоростях интернет-канала пользователя. Кроме этого дает подробную разблюдовку по загружаемым объектам и дает советы по способам ускорения вашего сайта (правда, на английском).

- WebPageTest — выдает две диаграмы загрузки проверяемой страниц: за первый проход и за второй, когда уже часть элементов сайта загружаются из кеша браузера. Можно получить из этого массу полезной информации для размышления:

Проверка правильности перелинковки и настройки сайта

- Siteliner — проверка сайта на наличие дублей страниц, битые ссылки и распределение веса по страницам. Полный функционал доступен только на платном тарифе.

- Проверка перелинковки сайта в Page Weight — похож на предыдущий сервис, но только русскоязычный. Он тоже платный и имеет в своем арсенале как программу (Page Weight), так и онлайн сервис (Page Weight Online) для проверки статического веса страниц вашего сайта (или чужого). Нужно это дело для создания грамотной перелинковки способной помочь продвижению (суть в переносе статвеса на нужные страницы).

- Анализатор внутренней перелинковки — необычная софтина в виде набора макросов для Эксела. Служит для расчета статического веса внутренних страниц вебсайта.

- Проверка конкурентности запросов — бесплатная программа Page Weight Request Range для оценки конкурентности запросов, под которые вы планируете писать статьи и продвигаться. Актуально, например, при подборе низкоконкурентных НЧ запросов, ибо для их продвижения будут нужны только хорошие тексты (обратные ссылки не обязательны).

- SimilarSites — помогает найти сайты похожих на ваш или на тот, что будет введен в соответствующее поле. Зачем это может быть нужно? Ну, например, если вы планируете размещение баннеров и пытаетесь найти подходящие для этого ресурсы, опираясь на некоторые уже вами найденные. Работает не идеально, но вполне себе сносно.

- Mobile emulator — можно посмотреть, как будет выглядеть ваш сайт на экране мобильных телефонов различных моделей. Сейчас идет довольно много споров по поводу создания адаптивного дизайна (подстраивающего под любой размер окна) или же создания отдельной версии вебсайта.

- Сайт глазами бота — показывает страницу без учета CSS разметки (все в один столбец), помогает проверить количество внутренних и внешних (в том числе открытых для индексации) ссылок, а также отображает заголовки всех уровней имеющиеся на странице. В общем, этот сервис позволяет вам взглянуть на ваш вебсайт без мишуры в виде стилевого оформления.

- Проверка доступности сайта для слабовидящих — к сожалению, у нас не принято учитывать потребности людей с ограниченными возможностями, но вот в «насквозь прогнившем» буржунете имеется сервис, позволяющий выявить недостатки верстки, которые могут вызвать затруднение у слабовидящих посетителей.

Проверка доступности сайта

Очень важным аспектом успешного продвижения сайта в поисковых системах является его доступность в режиме 24 на 7 (24 часа 7 дней в неделю). Про мониторинг доступности сайта и проверку аптайма читайте в приведенной статье, а здесь я просто перечислю способы осуществления подобных проверок.

- UptimeRobot — замечательный бесплатный сервис, на котором я зарегистрировался сразу после открытия этого блога и который помогал мне не раз своевременно обнаружить возникшие с сайтом проблемы. Проверку доступности он проводит каждые пять минут и присылает на почту сообщения о начале периода недоступности и о его завершении с указанием общего времени простоя.

- Проверка доступности сайта в Яндекс Метрике — знаменитый счетчик от Яндекса тоже умеет отслеживать доступность вебсайтов, на которых установлен его код. Кроме письма на указанный емайл у вас будет возможность настроить бесплатную отправку СМС сообщения на ваш мобильный телефон. Последнее может быть очень актуально, ибо почту мы проверяем не постоянно, а вот сотовый, как правило, всегда при нас.

- SiteUptime — на бесплатном тарифе можно мониторить один сайт с интервалом от получаса до часа. Уведомления в этом случае будут приходить только на почту. На платных тарифах все более заманчиво — СМС уведомления, пятиминутный интервал между проверками, три сайта в мониторинге (за 5 баксов в месяц) и т.п. прелести.

Проверка текстов на уникальность, ошибки и спамность

В принципе, про сервисы и программы антиплагиата, а также про лучшие онлайн-сервисы поиска ошибок в текстах, я уже писал в упомянутых статьях, но здесь я все же перечислю все, чего мы там касались для создания общей картины.

Сервисы по проверке орфографии

- Яндекс.Спеллер — если нужно проверить текст на странице, которая еще не опубликована, то просто копируете его в буфер обмена и вставляете в форму данного сервиса.Данную форму для проверки орфографии можно использовать на своем сайте или приложении с помощью предлагаемого API, если оно вам надо.

- Мультиязычная проверка орфографии — понятно, что актуальным проверка орфографии будет для бирж копирайтинга, поэтому я и привел в качестве примера онлайн сервис от биржи контента Адвего. Найденные в вашем тексте ошибки будут выделяться цветом и подчеркиванием.

- Орфограф — текст вставляете либо через буфер обмена, либо указываете Урл страницы Вашего сайта, а все найденные орфографические ошибки и непонятные слова будут подсвечиваться желтым цветом.

- Istio — можно указать Урл страницы и текст с нее будет взят для проверки провописания, а можно вставить текст через буфер обмена прямо в предоставленную форму:

Где проверить тексты сайта на уникальность онлайн?

- Copyscape — указываете Урл страницы, текст которой могли растащить по своим ГС всякие редиски. Этот сервис разбивает часть указанной вебстраницы на кусочки, которые прогоняет через поисковую систему Гугл. В бесплатной версии вам разрешат проверить лишь десяток страниц за день. В платной версии сервиса, кроме снятия ограничений на проверку уникальности, вы получите еще и некоторую автоматизацию.

В этом случае Copyscape будет периодически (в зависимости от выбранного тарифа — раз в день или в неделю) проверять тексты вашего сайта на уникальность и выявлять новых плагиаторов.

- Copywatcher.com — обещает не только проверять введенные вами Урлы страниц на предмет плагиата, но и сам будет пытаться удалять копии из индекса Гугла, а также рассылать абузы хостерам и самому плагиатору. Пока только тестирую этот сервис и не могу сказать однозначно за его эффективность. Но сама идея весьма интересна.

- Антиплагиат — всецело ориентирован на клиентов из учебных заведений. В своем базовом функционале бесплатен (имеются тарифы для поиска по расширенным базам) и позволяет проверить на уникальность текст, скопированный из буфера обмена размером до 3000 символов, можно будет даже без регистрации. После регистрации вы получите возможность загружать файлы различных популярных форматов (HTML, TXT, DOC, RTF, DJVU и PDF), а не пользоваться клипбордом.

Программы для проверки уникальности текстов

- Advego Plagiatus — по ссылке вы найдете описание одной из самых популярных программ для проверки уникальности текстов от разработчиков известной биржи контента. Чаще всего пользуюсь для проверки работы копирайтеров именно ей. Работает довольно быстро и имеет интуитивно понятный интерфейс:

- Etxt антиплагиат — тоже очень известная и популярная программа проверки на плагиат от не менее популярной биржи контента. Все подробности читайте по ссылке.