| ||||||||||||

Программы и онлайн сервисы для сохранения сайта целиком на компьютер

Советы и рекомендации КомментироватьЗадать вопросНаписать пост

Необходимость в скачивании сайтов возникает в случае сохранения нужной информации на компьютере без создания закладок и вкладок в браузере. Это удобно, т.к. не требует подключения Интернета (важный контент всегда хранится на носителе). Также исключается постоянный поиск нужных сайтов для получения информации.

Также исключается постоянный поиск нужных сайтов для получения информации.

Есть онлайн-сервисы, позволяющие сохранить интересующие «юзера» сайты.

Используем Site2zip

Данный ресурс дает возможность в 3 «клика» сохранить необходимую веб –страницу. Первое действие — это ввод адреса сайта, второе – заполнение капчи и третье — непосредственный процесс скачивания нужного пользователю ресурса.

Из преимуществ можно отметить бесплатное пользование ресурсом и простой интерфейс управления. К недостаткам относятся отсутствие каких-либо настроек и медленная скорость закачки. Поэтому, Site2zip больше подходит для «работы» с небольшими сайтами.

Копирование с помощью Robotools

Это платный on-line ресурс. В нём имеется четыре тарифа в зависимости от объема скачиваемых страниц. Размеры платежей по тарифным планам: 500 стр.- 2доллара, 4000 стр.- 8 долларов, 9000 стр. — 15 долларов, 20000 стр.- 25 долларов. Но есть некоторые «поблажки» при оплате: если несколько страниц не нужны пользователю, то он может их удалить, вернув часть средств на свой баланс.

— 15 долларов, 20000 стр.- 25 долларов. Но есть некоторые «поблажки» при оплате: если несколько страниц не нужны пользователю, то он может их удалить, вернув часть средств на свой баланс.

К плюсам Robotools можно отнести: понятный интерфейс, возможность закачки нескольких сайтов и просмотр скачанных сайтов на сервере. Минусом является донат за пользование услугой.

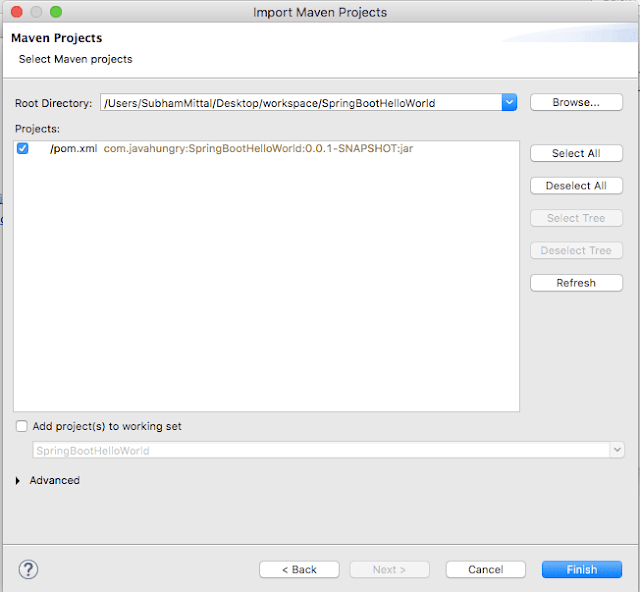

Приложение HTTrack WebSite Copier

Кроме онлайн сервисов существуют программы по сохранению сайтов на своем компьютере. Пожалуй, самой популярной из них является HTTrack WebSite Copier. Она отличается простым интерфейсом и возможностью работать в большинстве версий Windows (от 2000 до 7). Также её поддерживает Linux. Программа абсолютно бесплатная.

Из возможностей этого софта можно отметить следующее:

- выбор места сохранения контента.

- настройка скачиваемой информации (текст, либо видеофайлы, или то и другое).

- первоочередная загрузка текстовой информации, а потом лишь медиа-файлы.

К недостаткам можно отнести невзрачный интерфейс.

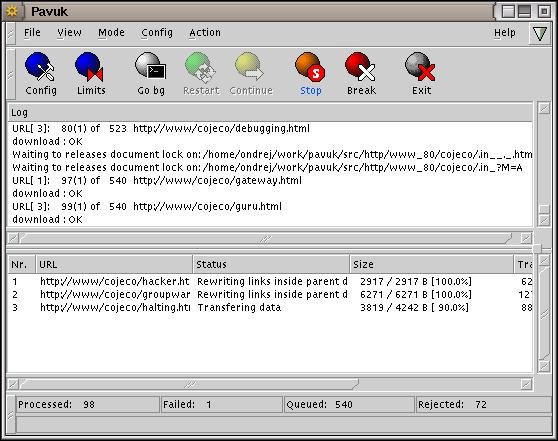

Программа Teleport Pro

Ещё одной программой по сохранению сайтов стала Teleport Pro. Сразу надо сказать, что «прога» платная. Её разработчики установили стоимость лицензии в размере 50 долларов. Программа может находить файлы определённого типа и размера на искомой веб-странице. Также, она позволяет осуществлять поиск необходимого места по ключевым словам, что очень удобно, особенно для больших сайтов. Одной из интересных функций Teleport Pro является возможность формирования номенклатуры всех страниц и файлов. Главным из минусов «проги» стало отсутствие русского языка в настройках. Также её поддерживает только Windows.

Используем Offline Explorer Pro

Ещё одной, не особо популярной программой, является Offline Explorer Pro. Высокая цена от 60 до 600 долларов, в зависимости от пакета, отталкивает потенциальных клиентов. Однако эта «прога» позволяет скачивать не только сайты, но и видео- и аудиофайлы больших размеров. Интуитивно понятное расположение команд и разделов, а также наличие русского языка в интерфейсе делает Offline Explorer Pro незаменимым помощником для профессионального анализа скачанных файлов.

Интуитивно понятное расположение команд и разделов, а также наличие русского языка в интерфейсе делает Offline Explorer Pro незаменимым помощником для профессионального анализа скачанных файлов.

Утилита WGET

Кроме представленных ресурсов и программ, можно отметить интересную утилиту WGET. Сначала находим её по ссылке: https://sourceforge.net/projects/tumagcc/files/ под названием: wget-1.18 _curl -7.49.1_win32_win64.7z

Скачав её на компьютер и распаковав, корректируем «Дополнительные параметры системы» (путь: Панель управления-Система-Дополнительные параметры системы). Здесь в свойствах системы выбираем: «Переменные среды». В этом «окне» в «значениях переменных» имеется некий файл. Прописываем в конце его: C:\Program Files\wget

Далее в командной строке (в «Пуске») набираем: cmd и попадаем в командную строку. Ее необходимо запустить от имени администратора.

Затем вписываем: wget-r-k-l 10-p-E-nc http://sidemob. com Число 10 в этой записи означает «глубину скачивания». После нажимаем «Enter». Теперь скаченный сайт будет сохраняться в: C:\Users\Asd\sidemob.com

com Число 10 в этой записи означает «глубину скачивания». После нажимаем «Enter». Теперь скаченный сайт будет сохраняться в: C:\Users\Asd\sidemob.com

На главную

Reader Interactions

13 Копировщики веб-сайтов, которые помогут вам сохранить автономные зеркальные версии веб-сайтов

Что нужно копировщику сайтов?

Вы когда-нибудь хотели сохранить копию определенного веб-сайта, чтобы просмотреть его позже в автономном режиме?

В начале 2000-х мы копировали весь веб-сайт в статический формат HTML с изображениями и скриптами, чтобы иметь к ним доступ при отключении.

Хотите верьте, хотите нет, но по многим причинам некоторые до сих пор это делают.

Чтобы получить копию веб-сайта, вам необходимо использовать специальный поисковый робот, называемый копировщиком веб-сайтов, который копирует весь веб-сайт в статические HTML-файлы вместе с его изображениями, стилями и файлами JavaScript.

13 инструментов с открытым исходным кодом для автономной копии любого веб-сайта

В этом посте мы предлагаем вам список лучших копировщиков веб-сайтов, обратите внимание, что некоторые из них являются низкоуровневыми, а некоторые предназначены для нетехнических пользователей.

1- ArchiveBox

ArchiveBoxArchiveBox — это бесплатный инструмент веб-архивирования с открытым исходным кодом, который берет любой веб-сайт и сохраняет его для использования в автономном режиме.

Хотя это инструмент веб-архивирования с самостоятельным размещением, он также предлагает версию для командной строки и настольную версию.

ArchiveBox делает снимок веб-сайта и сохраняет его в нескольких форматах файлов. Он может извлекать мультимедийные файлы, такие как YouTube, улучшать читаемость статей и многое другое.

2- HTTrack

HTTrack — это бесплатное программное обеспечение с открытым исходным кодом, которое поможет вам получить автономную копию любого веб-сайта. К сожалению, он доступен только для Windows.

С помощью HTTrack вы можете получить зеркальную версию любого веб-сайта, которую можно обновлять, если на веб-сайте появляется новый контент.

HTTrack поставляется с простым многоязычным интерфейсом, поддерживает прокси, работает с интегрированным кэшем DNS, предлагает полную поддержку HTTPS и ipv6.

Если у вас есть компьютер с Windows, это приложение просто необходимо.

3- Getleft

Getleft — это бесплатный граббер веб-сайтов с открытым исходным кодом, который с момента его первого выпуска еженедельно загружается. Getleft доступен для Windows, Linux и macOS. .

До Git многие веб-сайты использовали Archivarix для хранения резервных копий своих веб-сайтов и загрузки их по мере необходимости.

Archivarix работает как плагин для WordPress.

5- Загрузчик веб-сайтов

Это специализированное решение для загрузки веб-сайтов, которое копирует любой веб-сайт, включая JavaScript, таблицы стилей и изображения.

Этот проект «Загрузчик веб-сайтов» является детищем Ахмада Ибрагима, который выпустил его с открытым исходным кодом под лицензией MIT.

6- Гоклон

Goclone клонирует любой веб-сайт на ваш локальный рабочий стол за считанные минуты. Он построен с использованием языка программирования Go.

Goclone — это инструмент командной строки, но его чрезвычайно легко использовать даже для нетехнических пользователей.

Проект выпущен под лицензией MIT.

7- PC Website Grabber

PC Website Grabber — еще один инструмент, помогающий копировать веб-сайты на локальный диск. Он загружает все активы и сохраняет весь веб-сайт в виде zip-архива.

Этот проект выпущен под лицензией GPL-2.0. Это часть конструктора сайтов PageCarton.

8- goscrape

Инструмент «goscrape» — это еще один парсер веб-сайтов, который позволяет пользователям создавать автономные читаемые версии веб-сайтов с его активами.

В отличие от своих конкурентов в этом списке, он преобразует большие файлы изображений в меньшие версии и извлекает файлы из внешних доменов.

Goscrape легко работает из командной строки, поэтому не ждите никакой версии с графическим интерфейсом.

9- Website Cloner

Website ClonerИнструмент Visual Basic .NET для создания копии любого работающего веб-сайта с его страницами с полной рекурсивной поддержкой каталогов.

Однако для этого инструмента нет готовых выпусков, поэтому вам необходимо собрать приложение из исходного кода.

10- Monolith

В отличие от других инструментов в этом списке, этот предлагает новую концепцию: Monolith берет любой веб-сайт со своими страницами и сжимает их в один HTML-файл.

Monolith создан с использованием языка программирования Rust и готов к установке с помощью диспетчера пакетов Rush (Cargo), Homebrew или MacPorts для macOS, а также нескольких менеджеров пакетов для Linux и FreeBSD.

11- Node-site-downloader

Node.js — популярный выбор многих разработчиков для создания своих веб-приложений, мобильных приложений, настольных приложений или приложений командной строки.

Здесь Node.js используется для создания этого сценария командной строки, который позволяет любому скопировать работающий веб-сайт с помощью одной команды.

Node-Site-Downloader, без проблем работает в Docker, но вы можете установить его на любом компьютере с Node.js с помощью этой команды: множественная передача, пауза загрузки, параметры ограничения скорости и очередь загрузки.

MiniCopier без проблем работает на Windows, Linux и macOS. Он выпущен под лицензией GPLv2.0.

13- Загрузчик веб-сайтов

Это простой PHP-скрипт для загрузки копии веб-сайта на локальный диск. Он не поставляется со сложными инструкциями или учебными пособиями, но его не так сложно использовать для опытных разработчиков.

Заключительное примечание

Копировщик веб-сайтов — это программа, которая помогает вам сохранять функциональные копии веб-сайтов на вашем диске. Поскольку мы перечислили здесь самые популярные программы для копирования веб-сайтов с открытым исходным кодом, мы надеемся, что этот список пригодится всем, кто ищет такие инструменты.

Если вам известны какие-либо другие бесплатные программы для копирования веб-сайтов с открытым исходным кодом, которые мы здесь не упомянули, сообщите нам об этом.

11 лучших бесплатных программ для загрузки веб-сайтов

Вот список лучших бесплатных программ для загрузки веб-сайтов для локальной загрузки веб-сайтов на ваш компьютер . Это бесплатное программное обеспечение позволяет загружать весь веб-сайт локально на компьютер, чтобы вы могли просматривать веб-контент, даже если вы не в сети. Они довольно просты в использовании, поэтому вам не нужно беспокоиться о том, как загрузить весь веб-сайт. Здесь вам нужно просто ввести URL-адрес веб-сайта, указать место загрузки, установить параметры загрузки в соответствии с вашими требованиями, и все готово. Некоторые из них также можно использовать, чтобы получить представление об отсутствующих ссылках и проблемах веб-сайта.

Это бесплатное программное обеспечение позволяет загружать весь веб-сайт локально на компьютер, чтобы вы могли просматривать веб-контент, даже если вы не в сети. Они довольно просты в использовании, поэтому вам не нужно беспокоиться о том, как загрузить весь веб-сайт. Здесь вам нужно просто ввести URL-адрес веб-сайта, указать место загрузки, установить параметры загрузки в соответствии с вашими требованиями, и все готово. Некоторые из них также можно использовать, чтобы получить представление об отсутствующих ссылках и проблемах веб-сайта.

Лучшее бесплатное программное обеспечение для загрузки веб-сайтов для Windows:

Программное обеспечение для загрузки веб-сайтов, которое мне больше всего нравится, — это WinHTTrack Website Copier. Это потому, что он довольно прост в использовании и предлагает множество функций. Вы можете выбрать загрузку из нескольких доступных вариантов, проверить ссылки и обновить загрузку. Можно установить несколько правил для ограничения поиска и задать правила сканирования. Его также можно использовать для создания файлов журнала, создания индекса, создания базы данных Word, создания почтового архива и многих других подобных опций.

Его также можно использовать для создания файлов журнала, создания индекса, создания базы данных Word, создания почтового архива и многих других подобных опций.

Вы также можете воспользоваться программным обеспечением для массовой загрузки изображений, онлайн-редактором HTML и автономными браузерами.

WinHTTrack Website Copier

WinHTTrack Website Copier — это простое бесплатное программное обеспечение, позволяющее бесплатно загрузить весь веб-сайт. Лучшая особенность, которую предлагает этот веб-сайт, заключается в том, что он довольно прост и удобен в использовании.

- Сначала вы должны ввести имя проекта, выбрать категорию проекта и выбрать базовый путь.

- Затем вам нужно выбрать действие из списка доступных действий, т. е. загрузить веб-сайт, загрузить веб-сайт + вопросы, получить отдельные файлы, загрузить все сайты на страницах, проверить ссылку на страницах, продолжить прерванную загрузку и обновить существующую загрузку.

Список URL-адресов

Список URL-адресов - также можно добавить с помощью текстовых файлов.

Также могут быть добавлены дополнительные параметры для загрузки, например:

- Установить прокси, правила сканирования, ограничения, управление потоком, ссылки, сборку, поисковый робот, типы MIME, идентификатор браузера, журнал, индекс, кэш и различные другие параметры. .

- На вкладке «Только эксперты» можно выбрать другие параметры основного правила сканирования, режима перемещения, глобального режима перемещения, активировать режим отладки и параметры перезаписи внутренних/внешних ссылок.

- Можно также выбрать параметры удаленного подключения, установить параметр отключения по завершении, выключения компьютера по завершении и приостановки загрузки.

- Может также использоваться для установки правил сканирования, включения или исключения определенных типов файлов, установки ограничений и других параметров.

- Вы можете настроить загрузку и тестирование ссылок, структуру файлов, выбор файлов Java, прием файлов cookie, создание файлов журналов, создание индекса, создание базы данных Word, создание почтового архива, установку идентификатора браузера и многие другие параметры.

- Можно легко настроить ассоциации MIME для разных типов файлов и их удостоверение MIME.

Домашняя страница

Страница загрузки

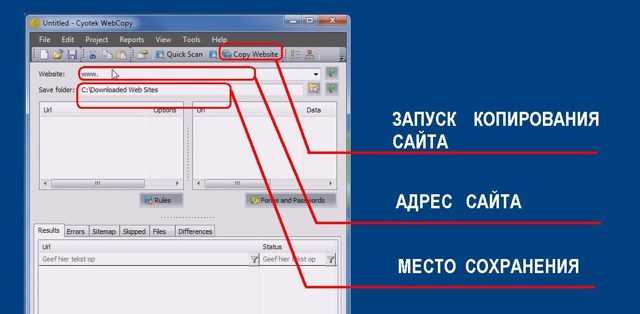

Cyotek WebCopy

Cyotek WebCopy — это простая бесплатная программа, которую можно использовать для локальной загрузки веб-сайтов на компьютер. Здесь вам нужно просто ввести URL-адрес веб-сайта и выбрать папку, в которой вы хотите сохранить веб-сайт.

- Можно также установить определенные правила для загрузки, например: включать или исключать определенный контент, сканировать или не сканировать контент, использовать полный URL-адрес, реверс, шаблон и замены.

- Также можно добавить имя пользователя и пароль.

- Вы можете просматривать веб-сайт локально или удаленно, предварительно просматривать локальный файл, создавать правила, просматривать карты ссылок, просматривать свойства URL-адреса и копировать выделение.

- Наконец, список содержимого также можно экспортировать в формате CSV.

- Создаются различные отчеты для отображения результатов, ошибок, карты сайта, пропущенных и отсутствующих файлов.

Может использоваться для выполнения ряда операций и персонализации загрузки.

- Вы можете выполнять быстрое сканирование, сканировать веб-сайт, копировать веб-сайт, копировать настройки, проверять наличие дополнительного хоста, включать или исключать определенные документы, использовать прокси-сервер и пользовательские агенты, а также изменять многие другие параметры.

- Он может создавать ряд отчетов, например: пустые метаданные, внешние URL-адреса, изображения, не найденные, перенаправления, медленные страницы и многое другое.

- Может также использоваться для создания графических отчетов, таких как ссылка на веб-сайт, диаграмма веб-сайта, статистика и многое другое.

- Отображает отсутствующие ссылки, которые могут быть использованы для поддержки веб-сайтов и улучшения их функциональности.

Домашняя страница

Страница загрузки

Автономный загрузчик

Offline Downloader — это хорошее программное обеспечение, которое позволяет загружать содержимое веб-сайта локально и просматривать его в автономном режиме, когда это необходимо.

- Просто введите URL-адрес веб-сайта и место, откуда вы хотите загрузить веб-сайт.

- Затем сайт загружается и отображается под картой сайта.

- Вы можете просмотреть веб-сайт онлайн или просмотреть его в автономном режиме.

- Параметр может быть установлен для отслеживания и извлечения новых ссылок, установки количества подключений, времени ожидания и ограничения по времени.

- Ссылки на сайты также можно вводить через текстовый файл, и загруженная ссылка на сайт также может отображаться в виде текстового файла.

- Параметры загрузки можно приостановить и возобновить в любой момент времени.

- Вы можете сохранить все ссылки импорта и экспорта в виде текстового файла.

- Это бесплатное программное обеспечение также позволяет вам устанавливать различные параметры, такие как расположение папки, параметры загрузки, ограничение уровня ссылки, параметры каталога и подкаталога, подключение, пароль, прокси-сервер, фильтры, домен, каталог, браузер, параметры отображения и расписания.

Но в бесплатной версии есть ограничение, которое не позволяет скачивать более 5000 файлов за один сеанс.

Домашняя страница

Страница загрузки

Менеджер бесплатных загрузок

Менеджер бесплатных загрузок — хороший менеджер загрузок, который также можно использовать для загрузки веб-сайтов и содержимого веб-сайтов. Он довольно прост в использовании, поэтому вам не нужно беспокоиться о том, как загрузить веб-сайт. Чтобы использовать функцию загрузки сайта:

- Перейдите на вкладку HTML Spider и нажмите кнопку загрузки с веб-сайта .

- Затем в появившемся новом окне добавьте URL-адрес веб-сайта, выберите параметры загрузки, такие как: структура папок, глубина загрузки, возможность хранения страниц сервера, удаление завершенных загрузок из списка, расположение папки загрузки, группа , и график загрузки.

- Если требуются параметры входа, вы также можете добавить имя пользователя и пароль.

Загрузка может быть запущена автоматически, вручную или по расписанию в зависимости от удобства.

- В расширенном меню вы также можете установить различные другие настройки, такие как: расширения веб-страниц, загружать файлы CSS или нет, загружать файлы с других сайтов или нет, загружать ли изображения, загружать изображения с других сайтов, устранение изображений по расширению, загрузка файлов, загрузка файлов с других сайтов, удаление файлов по расширению и многие другие подобные настройки.

Домашняя страница

Страница загрузки

Пробная версия Inspyder Web2Disk

Пробная версия Inspyder Web2Disk — это простое программное обеспечение для загрузки веб-сайтов, которое можно использовать для загрузки всего веб-сайта локально на компьютер для удобного просмотра в автономном режиме.

- Введите корневой URL-адрес и расположение папки.

- При нажатии кнопки Перейти веб-сайт загружается локально.

- Вы также можете ввести имя пользователя и пароли, проверить и установить параметры для исключенных страниц, установить параметры загрузки, параметры сканера, псевдонимы доменов, корневые URL-адреса и обнаружение программных ошибок 404.

- В параметре загрузки вы можете установить параметры загрузки, такие как: исправить URL-адрес для просмотра в автономном режиме, переименовать файл и динамический URL-адрес, сгладить структуру каталогов, автоматически исправить HTML, создать URL-адрес для сопоставления файлов, добавить дату к старым загрузкам, создать файл автозапуска, создать журнал изменений и добавить опцию загрузки метаданных.

- Также можно указать задержку искателя, время ожидания искателя, пользовательский агент, размер файла и ограничения URL.

- Вы также можете ограничить сканирование, используя глубину страницы или количество страниц.

Но вы не можете иметь более двух активных проектов одновременно и планировать проекты в бесплатной (пробной) версии.

Домашняя страница

Страница загрузки

Darcy Ripper

Darcy Ripper — это простое Java-приложение для загрузки веб-сайтов для автономного использования на локальном компьютере.

- Просто нажмите кнопку «Создать новый» и введите сведения о веб-сайте, такие как имя, URL-адрес, путь, возможность загрузки всего веб-сайта, сохранение на диск или не сохранение на диск, количество параллельных загрузок, а также игнорировать и игнорировать готовые ссылки.

- При необходимости измените параметры подключения, например: максимальное количество подключений, максимальное количество повторных попыток, настройки прокси-сервера, настройки запросов и ссылок, ограничение полосы пропускания, настройки аутентификации, настройки файлов cookie, настройки ответа HTTP и различные другие параметры фильтров.

Затем при нажатии кнопки «Пуск» загружается весь веб-сайт, показывая различные сведения об URL-адресе, состоянии, прогрессе, размере, приоритете, глубине, статусе, заголовках ответа HTTP и многих других подобных параметрах. Пакеты заданий можно сохранить, чтобы потом не настраивать те же элементы.

Пакеты заданий можно сохранить, чтобы потом не настраивать те же элементы.

Домашняя страница

Страница загрузки

ScrapBook

ScrapBook — это простое расширение Firefox для загрузки веб-сайтов. Его можно использовать для загрузки веб-страницы, содержимого веб-сайта и даже целых веб-сайтов. При установке он добавляет контекстное меню в браузер Firefox, которое затем можно использовать для загрузки веб-страницы или веб-сайта одним нажатием кнопки.

- Откройте веб-сайт, который вы хотите загрузить, и щелкните правой кнопкой мыши, чтобы отобразить контекстное меню.

- Выберите параметр Сохранить страницу как. Откроется окно, в котором вы можете ввести сведения о заголовке, папке, параметрах загрузки изображений, CSS, JavaScript, параметрах загрузки файлов изображений, звуковых файлов, файлов фильмов, архивных файлов, любых пользовательских файлах и параметрах глубины.

Затем в соответствии с вашим выбором файлы загружаются, что может занять некоторое время в зависимости от размера веб-сайта. Во время загрузки его можно отфильтровать, приостановить, пропустить или прервать.

Во время загрузки его можно отфильтровать, приостановить, пропустить или прервать.

Домашняя страница

Страница загрузки

WinWSD

WinWSD — это простое бесплатное программное обеспечение, позволяющее загружать весь веб-сайт для использования в автономном режиме.

- Выберите вариант «Новый проект» и введите сведения о проекте, например: URL-адрес, имя проекта, тип проекта, каталог проекта и другие важные сведения.

- Затем нажмите кнопку «Добавить», после чего вы должны нажать кнопку «Пуск», чтобы начать загрузку сайта.

- Можно установить различные параметры для установки ограничений на загрузку мультимедийных файлов или других архивов и исполняемых файлов, параметров потока, максимального размера файла, отключенных URL-адресов, необходимых URL-адресов, файлов cookie, авторизации и команд JavaScript.

- Отображается подробная информация, такая как скорость, загруженный размер, количество файлов и прошедшее время.

- Также отображается ряд параметров, таких как размер, загруженность, статус и т. д.

Домашняя страница

Страница загрузки

Getleft

Getleft — это простая бесплатная программа, которую можно использовать для локальной загрузки веб-сайтов на компьютер.

- Нажмите кнопку ввода URL-адреса, после чего вы должны ввести URL-адрес, каталог и выбрать вариант запуска сейчас.

- Вы также можете выбрать исходящие ссылки, обновление, CGI, получить карту только в формате HTML, уровни, внешние ссылки и параметры загрузки изображений.

- Это бесплатное программное обеспечение также можно использовать для очистки определенных расширений файлов, таких как PDF, JPG, GIF, MOV, MPG и многих других.

- Также можно установить параметры для отложенной загрузки и дней для загрузки по расписанию.

- Загрузка веб-сайта может быть приостановлена, остановлена или возобновлена в любой момент времени.

Домашняя страница

Страница загрузки

Полный загрузчик веб-сайтов

Полный загрузчик веб-сайтов — это простое бесплатное программное обеспечение, которое можно использовать для загрузки веб-сайтов. Просто введите URL-адрес, место загрузки, глубину загрузки, возможность загрузки изображений и ресурсов с внешних сайтов, исключите файлы, содержащие определенное имя, и исключите файлы, содержащие определенные расширения файлов.

- Может также предоставить информацию для входа на сервер для загрузки защищенных паролем веб-сайтов.

- Отображает информацию о загруженных файлах, общем количестве файлов и ходе выполнения.

- Процесс может быть прерван в любой момент.

Домашняя страница

Страница загрузки

Копирование веб-сайтов

Копирование веб-сайтов — это небольшая и простая программа для загрузки веб-сайтов. Здесь вам нужно просто ввести URL-адрес веб-сайта, который вы хотите скопировать, указать папку для загрузки веб-сайта и нажать кнопку загрузки.

72

72 07.2017

07.2017