Массовая проверка индексации страниц в Яндекс и Google

Главная » Софт » SEO софт » Массовая проверка индексации страниц в Яндекс и Google

21.01.11

Рассмотрим ситуацию, которая может возникнуть при продвижении сайтов ссылками навсегда. Они стоят дороже временных ссылок потому что размещаются на весь срок деятельности сайта, но на практике не всегда все получается гладко:

- Во-первых, некоторые нехорошие вебмастера пытаются схитрить, поэтому, к сожалению, не редки случаи, когда через месяца 2-3 после закупки ссылок вы можете их на сайтах-донорах не обнаружить.

- Во-вторых польза от ссылок будет в случае, если страницы с ними находятся в индексе поисковых систем.

Поэтому после покупки ссылок где-то через недельку можно проверить какие страницы были проиндексировали, а каким нужно помочь это сделать, например, помощью Sapient InterSocial Submitter или любым другим софтом.

К моему величайшему удивлению проверка индексации страниц в Яндекс и Google оказалась не такой тривиальной задачей.

Насколько я понимаю программка YCCY старожил на рынке seo, хотя до сих пор не потеряла свою актуальность. Вообще она содержит несколько модулей, которые выполняют разные задачи. Так, например, там есть некий WHOIS PAID, позволяющий массово проверять даты окончания доменов, NAME GENERATOR, генерирующий доменный имена и PageRankDC, который смотрит значение PR по разным дата центрам Google. Но самую большую ценность представляет модуль INDEXATOR. Он содержит следующие функции:

- Массовая проверка индексации страниц сайтов в Яндексе (через Mail.

ru, Яндекс.XML) и в Google.

ru, Яндекс.XML) и в Google. - Проверка количества проиндексированных страниц в Яндексе, Google, Rambler.

- Проверка Google PageRank, тИЦ, AlexaRank, бэклинков Yahoo.

- Пакетная проверка количества найденных страниц по запросу.

- Пакетная проверка обратных ссылок(текста ссылки) в Яндексе, Google.

При этом поддерживается экспорт ссылок PROPAGE, SAPE, XAP, прокси-сервера, что крайне полезно в работе. Вообще программа YCCY достойна похвалы. Работать с ней проще простого.

Слева добавляете нужные ссылки, далее указываете настройки проверки (в моем случае индексация страниц в ПС), а потом запускаем процесс. В результате справа в первом блоке появятся проиндексированные ссылки, потом не проиндексированные и те, которые не смогли определиться (для них можно запустить повторную проверку).

Если говорить о результатах, то на 90-95% информация программы соответствует действительности, а это, поверьте, среди других онлайн сервисов просто блестящий показатель. Что касается отзывов, то в большинстве случаев читал только положительные. Причем люди сравнивали с некоторыми другими похожими программами (хоть и давно это было). Оптимизаторы говорили, что YCCY работает быстрее остальных, хотя при проверке большого числа страниц пишут, что Яша может забанить IP (что, в принципе, для всех программ характерно — в YCCY можно и нужно использовать прокси).

Что касается отзывов, то в большинстве случаев читал только положительные. Причем люди сравнивали с некоторыми другими похожими программами (хоть и давно это было). Оптимизаторы говорили, что YCCY работает быстрее остальных, хотя при проверке большого числа страниц пишут, что Яша может забанить IP (что, в принципе, для всех программ характерно — в YCCY можно и нужно использовать прокси).

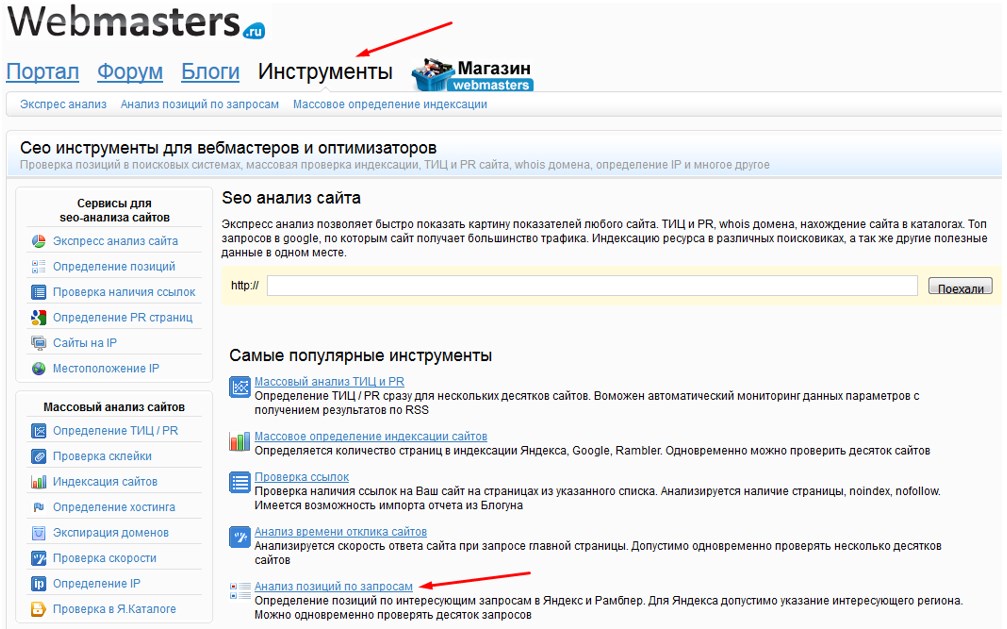

Во время поиска решения для проверки индексации страниц можно найти сразу несколько онлайновых сервисов, но ни один из них нормальные результаты не выдал. Ни один кроме онлайн скрипта от seolib.ru. Здесь вообще все элементарно просто — на странице в форме вводите ссылки, выбираете проверку индексации страниц в Google и (или) Яндекс, после чего запускаете скрипт.

Через пару секунд начнут появляться результаты в виде удобной таблицы. Проверка показала, то здесь если не 100% совпадение, то очень близкие к этому. Также большим плюсом и экономией времени есть то, что индексация проверяется сразу в двух поисковиках, в отличии от YCCY. Из минусов можно отметить, что бесплатная проверка слегка ограничена в количестве попыток — вы можете ее сделать лишь 5 раз в сутки с одного IP, причем не более 10-ти страниц за раз. Если для вас это важный момент и имеются большие объемы работы. то можно снять ограничение за небольшую плату — 0.001у.е. за 1 страницу. В целом, конечно, скрипт от seolib.ru — очень хорошая разработка.

Из минусов можно отметить, что бесплатная проверка слегка ограничена в количестве попыток — вы можете ее сделать лишь 5 раз в сутки с одного IP, причем не более 10-ти страниц за раз. Если для вас это важный момент и имеются большие объемы работы. то можно снять ограничение за небольшую плату — 0.001у.е. за 1 страницу. В целом, конечно, скрипт от seolib.ru — очень хорошая разработка.

Semonitor

В одном из постов блога я писал уже про Semonitor, когда рассматривал программы для мониторинга обменных или купленных ссылок. Собственно, софт оказался весьма универсальным в плане проверки ссылок, там за это отвечает отдельный модуль Link Exchanger. От вас требуется ввести сайт на которые ставятся ссылки и из файла загрузить список url для проверки индексации страницы в поисковиках. После этого можно выбрать проверяемые параметры и запустить программу:

Безусловным плюсом в Semonitor есть то, что кроме проверки наличия ссылки вы сможете увидеть некоторые параметры проекта, анкор, количество внешних, внутренних ссылок, открытость ссылки для индексации и т. п. При большом числе запросов не обойтись без Yandex XML лимитов которые можете найти в своей учетной записи.

п. При большом числе запросов не обойтись без Yandex XML лимитов которые можете найти в своей учетной записи.

Ну и, конечно, результат проверки на 100% правильный, что также весьма радует. Даже и не знаю теперь, может не продавать Semonitor будет от него теперь хоть какая-то польза:) Нужно изучить остальные модули, там в принципе, полно опций и фишек для оптимизаторов.

А какими сервисами для проверки индексации страниц в поисковиках пользуетесь вы?

21.01.11

Категории: SEO софт.

Теги: google, Semonitor, seo софт, индексация, онлайн seo сервисы, проверка индексации, Яндекс

Полезное

Страницы

Как проверить индексацию сайта

Полезные сервисы

Всем привет. Мы уже говорили о том, как ускорить индексацию сайта. Думаю, было бы не правильно, не упомянуть о том, как проверить индексацию сайта. Именно об этом мы сегодня и поговорим.

Проверить индексацию сайта в Яндексе не составляет туда. Для этого достаточно зайти в панель по адесу http://webmaster. yandex.ru/check.xml. Далее нужно ввести УРЛ адрес сайта в адресную строку и нажать кнопку «Проверить». После этого, Яндекс покажет все страницы, которые находятся в его поисковом индексе.

yandex.ru/check.xml. Далее нужно ввести УРЛ адрес сайта в адресную строку и нажать кнопку «Проверить». После этого, Яндекс покажет все страницы, которые находятся в его поисковом индексе.

Иногда возникает необходимость проверить индексацию какой-нибудь отдельной страницы. Тогда удобнее будет воспользоваться следующим способом. Открываем расширенный поиск Яндекс. В строку «Я ищу» вбиваем заголовок статьи, а в поле «На сайте» УРЛ адрес сайта.

Если страница проиндексирована, то она должна появиться в списке результатов на одном из первых мест.

Проверка индексации в Google тоже не составляет особого труда. Для этого нужно набрать в поисковой строке: site:vashsait.ru. Вместо vashsait.ru, естественно, подставляем адрес интересующего Вас сайта. После этого, вы получите список всех проиндексированных Google страниц сайта.

Для того, чтобы проверить индексацию в Google отдельной статьи можно воспользоваться расширенным поиском, также как и в случае с Яндексом.

Иногда нужно проверить только общее количество страниц в индексе поисковых систем. Для этого можно воспользоваться очень удобным инструментом от MegaIndex. Он называется «экспересс-анализ сайтов». Для этого, регистрируемся в системе, и на главной странице щелкаем на логотип системы. Откроется выпадающее меню, в котором выбираем «e.megaindex.ru — Экспресс-анализ сайтов».

После этого, вводим адрес сайта в адресную строку и нажимаем кнопку «Начать!».

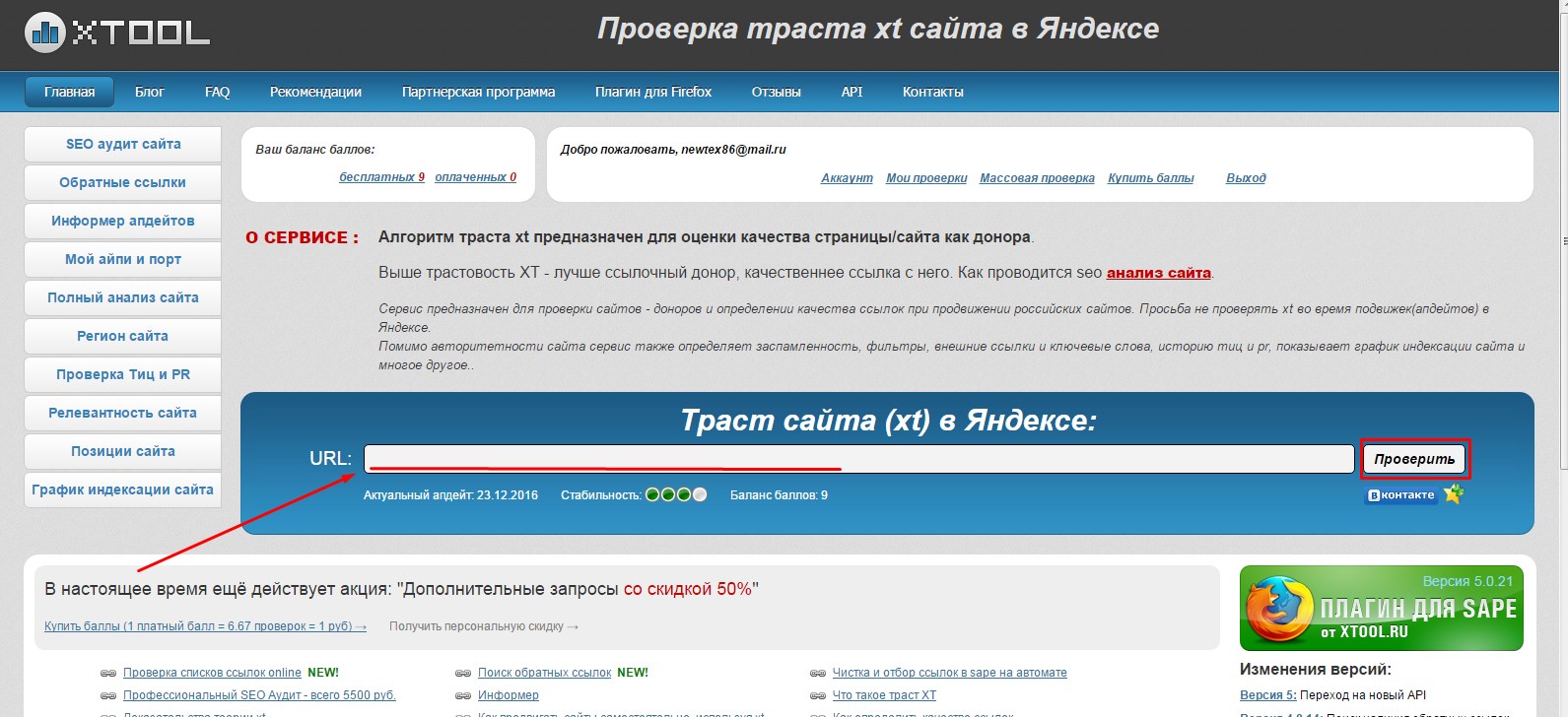

Через несколько секунд мы получим результаты анализа сайта, включая общее количество проиндексированных Яндекс и Google страниц, ТИЦ, PR, наличие сайта в каталогах DMOZ и ЯК.

Помимо этого, здесь можно узнать позиции сайта по популярным запросам, входящие ссылки, исходящие ссылки, внутренние ссылки, данные Alexa Rank, robots.txt и еще много чего интересного.

Все данные можно экспортировать в формате csv для дальнейшего изучения и анализа в программе excel. Разумеется, все это совершенно бесплатно! И это далеко не весь функционал, который предоставляет система MegaIndex.

Не так дано сам узнал о данном сервисе и с тех пор постоянно пользуюсь им. Незаменимая вещь для продвижения своих сайтов и анализа и оценки сайтов конкурентов. Рекомендую всем.

Полезные сервисы

Обзор сервиса для создания логотипов Logaster

Авторadmin

Всем привет. В статье про создание логотипа я уже мельком касался сервиса для создания логотипов Logaster. Сегодня я хочу рассказать о нем подробнее. Создаем логотип в Logaster. Пошаговое руководство Итак, для того, чтобы создать логотип, заходим на сайт. Для начала нужно зарегистрироваться. Думаю, эта процедура не вызовет у Вас вопросов. Далее переходим на главную страницу…

Читать далее Обзор сервиса для создания логотипов LogasterПродолжить

Полезные сервисы

Научные поисковые системы

Авторadmin

Всем привет. Сегодня мы поговорим о самых лучших научных поисковых системах. Большинство людей пользуется для поиска информации поисковыми системами Яндекс или Googgle. Они идеально подходят для поиска развлекательного контента или коммерческих поисковых запросов. Тем не менее, найти узкоспециализированную научную информацию с помощью них, очень часто, бывает проблематично. Именно для таких случаев существуют специальные научные поисковые…

Сегодня мы поговорим о самых лучших научных поисковых системах. Большинство людей пользуется для поиска информации поисковыми системами Яндекс или Googgle. Они идеально подходят для поиска развлекательного контента или коммерческих поисковых запросов. Тем не менее, найти узкоспециализированную научную информацию с помощью них, очень часто, бывает проблематично. Именно для таких случаев существуют специальные научные поисковые…

Читать далее Научные поисковые системыПродолжить

Полезные сервисы

SEO Винчестер. Обзор новой книги Михаила Шакина

Авторadmin

Всем привет! Не так давно Михаил Шакин выпустил новую книгу, которая называется SEO Винчестер. Сегодня я вкратце расскажу, о чем она, а также поделюсь своими впечатлениями от прочитанного. Для начала пару слов об авторе. Для тех, кто следит за развитием событий в области поисковой оптимизации, я думаю, представлять Михаила Шакина излишне. Для тех, кто только…

Для тех, кто только…

Читать далее SEO Винчестер. Обзор новой книги Михаила ШакинаПродолжить

Полезные сервисы

Крауд-маркетинг от ZenLink.ru: подробный обзор

Авторadmin

Крауд-маркетинг – один из главных трендов SEO последних лет. Сегодня мы поговорим о том, что это такое и как автоматизировать его с помощью zenlink.ru. В двух словах: что такое крауд-маркетинг и зачем он нужен Крауд-маркетинг это продвижение ссылками, максимально похожими на естественные ссылки, которые оставляют люди на форумах, досках объявлений, сервисах вопрос-ответ и сайтах с…

Читать далее Крауд-маркетинг от ZenLink.ru: подробный обзорПродолжить

Полезные сервисы

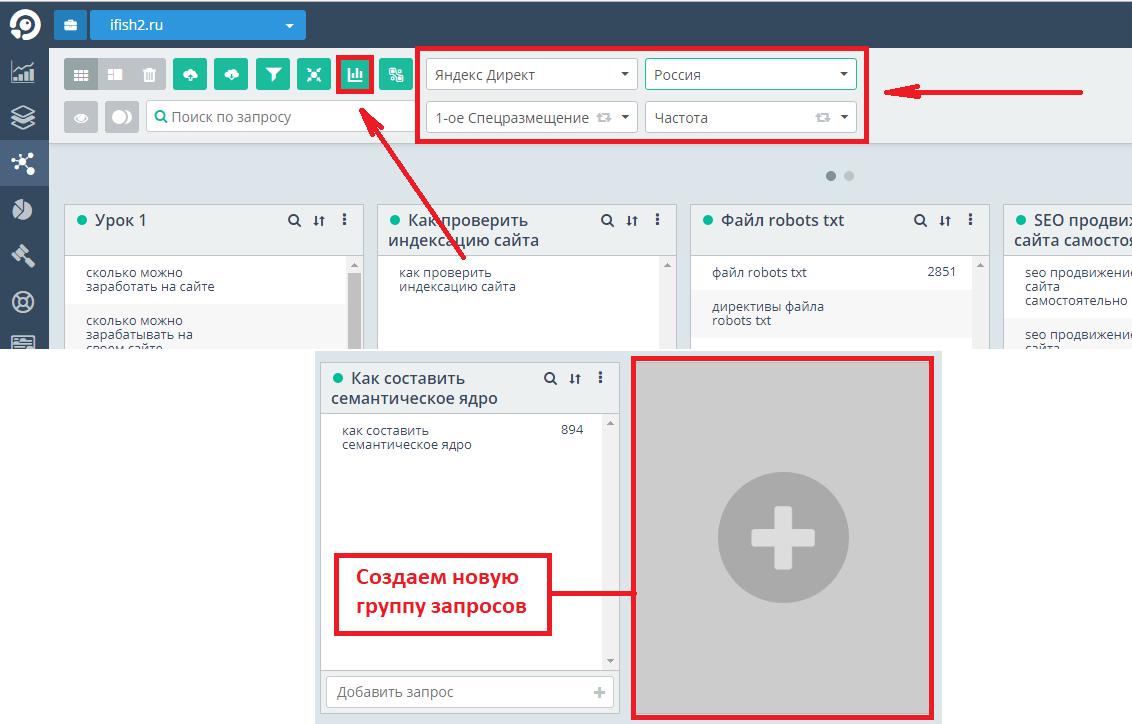

Как проверить позиции сайта в поисковых системах

Авторadmin

Всем привет. В прошлой статье мы узнали о том, как добавить сайт в поисковые системы. Теперь, когда он проиндексируется, можно начинать продвижение поисковых запросов. Молодой сайт я рекомендую продвигать по большому числу низкочастотных запросов. Это позволит относительно быстро получить неплохой целевой трафик. И тут возникает одна проблема, для того, чтобы оценить эффективность продвижения, необходимо знать…

В прошлой статье мы узнали о том, как добавить сайт в поисковые системы. Теперь, когда он проиндексируется, можно начинать продвижение поисковых запросов. Молодой сайт я рекомендую продвигать по большому числу низкочастотных запросов. Это позволит относительно быстро получить неплохой целевой трафик. И тут возникает одна проблема, для того, чтобы оценить эффективность продвижения, необходимо знать…

Читать далее Как проверить позиции сайта в поисковых системахПродолжить

Полезные сервисы

Как быстро проверить любой текст на уникальность

Авторadmin

Здравствуйте, многоуважаемые читатели моего блога! Наверное, среди вас не найдется человека, который бы никогда не пересекался с плагиатом и вовсе не знает что это, так как плагиат мы ежедневно встречаем, пользуясь интернетом. Поэтому, сервисы для проверки уникальности текста всегда будут востребованы. Онлайн проверка текста на уникальность Самый популярный онлайн сервис для проверки текста на плагиат…

Онлайн проверка текста на уникальность Самый популярный онлайн сервис для проверки текста на плагиат…

Читать далее Как быстро проверить любой текст на уникальностьПродолжить

Полное руководство по индексации содержимого страниц вашего сайта в 2023 году

SEO-специалисты должны знать, как наладить веб-индексацию. Ежедневно я проверяю индексацию веб-сайтов и веб-страниц с помощью специальных сервисов или вручную.

Существует три метода определения индексации сайтов

В настоящее время специалисты не используют разные методы, и у каждого есть свой предпочтительный метод проверки индексации страниц сайта.

Подробнее: Улучшение SEO WordPress: 11 советов по повышению рейтинга сайта

Поиск с использованием специального оператора URL-адрес веб-страницы, использующей протокол, чтобы увидеть, указана ли она в выводе.

Проверка URL-адресов в Google Search Console

Вам не нужно снова искать континенты, если вы хотите определить индексацию сайта в Google. Совершенно новая панель Google Webmaster предлагает отличный инструмент для проверки отдельных страниц.

Совершенно новая панель Google Webmaster предлагает отличный инструмент для проверки отдельных страниц.

Если страницы нет в индексе, будет показан этот результат

Вы можете попросить Google немедленно проиндексировать вашу страницу. Google тщательно проверит его и, если нет ограничений на индексацию или каких-либо других причин, отправит сайт на индексацию.

Если с вашей веб-страницей все в порядке и она была проиндексирована Google, будет показана следующая информация.

Индексация страниц на сайтах, прошедших массовую проверку

В большинстве случаев нужно смотреть на картину в целом: проверять индексацию всего сайта, а не его конкретной страницы.

Этого можно добиться многими способами, но я обычно использую два основных способа.

Первый заключается в использовании сайта оператора.

Вариант 2: Если вы не хотите думать о написании операторов перед вашим URL, вам следует воспользоваться сервисом Linkbox. Хотя есть много альтернатив, мне нравится этот.

Просто загрузите документы на сайт и проверка будет завершена.

Как остановить индексирование веб-сайтов?

Файл robots.txt — один из самых популярных способов запретить индексацию страниц. Что такое robots.txt? Если вы уже знаете ответ на этот вопрос, вам повезло.

Это проверенный временем и рекомендованный поисковыми системами метод. Можно разрешить индексацию всего сайта или только одного его раздела.

Чтобы весь сайт не индексировался поисковыми системами, добавьте 2 строки в файл вашего робота.

User-agent: *

Disallow: /

Это сообщает поисковым роботам, что веб-сайт не требуется искать. Если вы не хотите запрещать индексацию всего веб-сайта, а только отдельные страницы, виды страниц или разделов, используйте Disallow:/ более целенаправленно.

Давайте посмотрим на некоторые примеры.

Disallow: /wp-admin/

такой конструкции мы закрываем внутренний раздел сайта wp-admin, который в принципе не нужен нам в индексе.

Disallow: /blog/post

Это предотвратит индексацию статьи.

Как прекратить индексацию страниц сайта в WordPress?

Удалить индексацию из WordPress достаточно просто.

Нет необходимости создавать и затем заполнять файл robots.txt; все, что вам нужно сделать, это установить один флажок в панели администратора, чтобы поисковые системы знали, что сайт не может быть указан.

Убедитесь, что в разделе настроек чтения установлен флажок Запрашивать поисковые системы не выполнять массовую проверку индексации этой веб-страницы.

Ускорение индексации веб-страниц

Проведение экспериментов по ускорению индексации страниц — моя любимая часть всей работы.

Сайт постоянно меняется при оптимизации. Вам придется отправить новые страницы или переиндексировать страницы.

Каждый специалист уникален и у каждого свой набор процедур. Я предоставлю свой.

- Если страницы еще не проиндексированы или не новые, я добавляю их в инструмент индексации Linkbox.

- Затем я публикую страницу в социальных сетях и размещаю на них несколько гиперссылок web2.0.

- Если вас действительно беспокоит сайт и вы хотите ускорить процесс его индексации, вы можете отправить сообщение в тематические группы в социальных сетях, а также оставлять комментарии на тематических форумах или в блогах. Этот метод, однако, является третьим вариантом, так как первые два шага работают достаточно хорошо.

Я планирую попробовать переписать старые статьи и изменить дату публикации, чтобы вернуть их к жизни в ближайшем будущем. Это также можно использовать для восстановления старого контента, который больше не актуален. Вышеуказанные стратегии помогут проиндексировать новую страницу.

Сообщите нам, если у вас есть вопросы или предложения по ускорению или тестированию этого процесса.

Контент-маркетинг Google Rankingseo

PRV POST

NXT POST

Рекомендуемые сообщения

900 03Массовое извлечение статистики отчета о покрытии индекса из Search Console с помощью Node.

js

jsВ моей предыдущей статье я говорил о как получить пакетную информацию об индексации из Google Search Console с помощью инструмента проверки URL и Node.js. Этот инструмент отлично подходит для сбора индивидуальной информации о конкретных URL-адресах на вашем сайте. Однако Google также предоставляет владельцам сайтов более целостное представление о статусе индексирования их сайтов с помощью отчета о покрытии индексом.

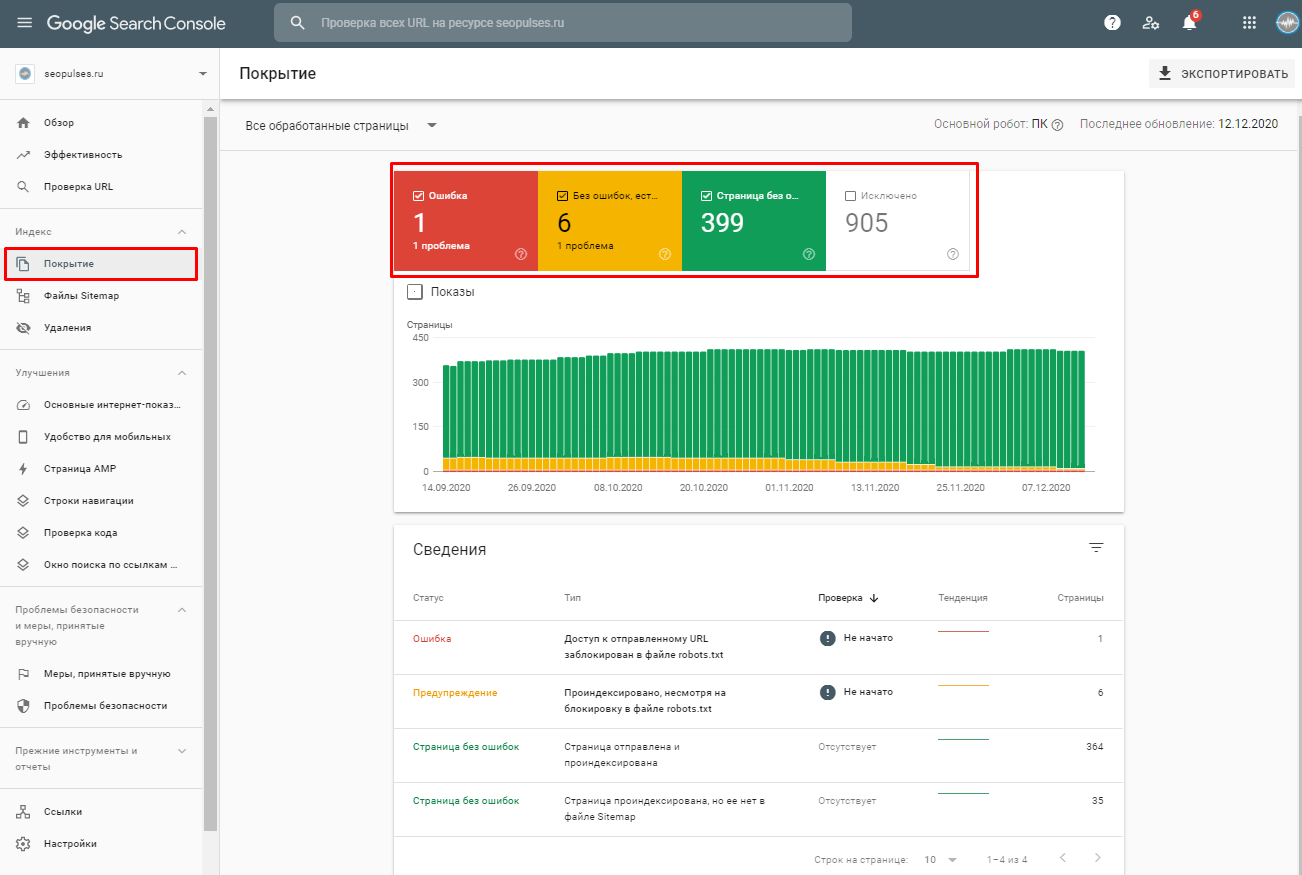

Вы можете проверить собственную документацию Google и видеоруководство, чтобы более подробно понять данные, представленные в этом разделе, но на самом верхнем уровне ключевые точки данных:

- Количество страниц, проиндексированных Google.

- Количество страниц, которые Google нашел, но не проиндексировал (из-за ошибки или намеренно исключил).

- Насколько велик ваш сайт с точки зрения Google (Действительно + Исключено + Ошибки).

На данный момент существует четыре основных категории: Ошибки , Действительны с предупреждением , Действительны и Исключенные подразделяются на 29 подкатегорий. Каждая из этих подкатегорий обеспечивает дополнительный уровень классификации, чтобы помочь владельцам сайтов и SEO-специалистам понять, почему ваши URL относятся к основной категории. Не все подкатегории будут видны, только те, которые относятся к вашему сайту.

Каждая из этих подкатегорий обеспечивает дополнительный уровень классификации, чтобы помочь владельцам сайтов и SEO-специалистам понять, почему ваши URL относятся к основной категории. Не все подкатегории будут видны, только те, которые относятся к вашему сайту.

К сожалению, параметр экспорта в представлении отчета о покрытии индекса (на рисунке выше) дает вам только цифры верхнего уровня для каждого отчета. Если вы хотите узнать и экспортировать, какие URL-адреса находятся в нескольких отчетах, вам нужно щелкнуть каждый отчет и экспортировать их один за другим.

Этот способ извлечения данных очень ручной и требует много времени. Поэтому я решил автоматизировать его с помощью Node.js и добавить еще несколько функций.

Установка и запуск сценария

Убедитесь, что на вашем компьютере установлен Node.js. На момент написания этого поста я использую версию 14.16.0. В этом скрипте я использую особый синтаксис, который можно использовать только начиная с версии 14, поэтому дважды проверьте, что у вас выше этой версии.

# Проверить версию узла узел -v

Загрузите скрипт с помощью git, интерфейса командной строки Github или просто скачайте код напрямую с Github.

# Гит клон git https://github.com/jlhernando/index-coverage-extractor.git # Интерфейс командной строки Github Клон репозитория gh https://github.com/jlhernando/index-coverage-extractor

Затем установите необходимые модули для запуска скрипта, набрав npm install в терминале

npm install

Чтобы извлечь данные о покрытии с вашего веб-сайта/ресурса, обновите файл credential.js, указав свои учетные данные Search Console.

После этого используйте свой терминал и введите npm start для запуска скрипта.

запуск н/мин

Сценарий регистрирует обработку в консоли, чтобы вы знали, что происходит.

Как и в автомате проверки URL, сценарий использует Playwright и работает в автономном режиме. Если вы хотите увидеть автоматизацию браузера в действии, просто измените параметр запуска на headless: false в файле index. js и сохраните его перед запуском скрипта.

js и сохраните его перед запуском скрипта.

Вывод

Сценарий создаст файл «coverage.csv» и файл «summary.csv».

Файл «coverage.csv» будет содержать все URL-адреса, извлеченные из каждого отдельного отчета о покрытии.

Файл «summary.csv» будет содержать количество извлеченных URL-адресов на отчет, общее количество, которое GSC сообщает в пользовательском интерфейсе (такое же или выше), и «коэффициент извлечения», который является делением между Извлеченные URL-адреса и общее количество URL-адресов, сообщенных GSC.

Я считаю, что эта дополнительная точка данных полезна, потому что GSC имеет ограничение на экспорт в 1000 строк в отчете. Следовательно, «коэффициент извлечения» дает вам точное представление о том, сколько URL-адресов вы смогли извлечь по сравнению с тем, сколько вы пропустили в этом отчете.

Будущие обновления

Есть несколько функций, которые, я думаю, было бы неплохо добавить в будущие версии. Например, извлеките дату «обновления» и измените скрипт как облачную функцию Google, чтобы хранить данные в BigQuery, только если дата отличается от предыдущей сохраненной даты.