Что такое индексация сайта, как ее проверить и как ускорить

Сайты — это фактически виртуальные места с файлами и контентом. Они расположены на хостингах и имеют уникальные адреса (домены). Для того, чтобы найти их в поиске, они должен быть «зарегистрированы» — проиндексированы в специальной базе данных поисковика. Что такое индексация и для чего она нужна? Ниже мы основательно разберемся в этом вопросе.

Что такое индексация

Индексация или индексирование страниц (веб-индексация, web-indexing) — это процесс сбора, проверки и ввода информации о содержимом сайта в базу данных поисковой системы. Эту сложную и трудоемкую работу поручают специальным роботам. Эти роботы обходят весь сайт и собирают информацию со страниц по прописанному алгоритму.

Для поисковых роботов, индексировать — значит обходить, изучать новые страницы и добавлять их в базу поисковика. Так как же работает индексация? При индексации учитываются внешние и внутренние ссылки, графические элементы, текстовый контент и т. д. Когда страница проверена, она включается в индекс поисковика и пользователи могут найти ее, введя нужные поисковые запросы.

д. Когда страница проверена, она включается в индекс поисковика и пользователи могут найти ее, введя нужные поисковые запросы.

Вся информация в базе данных собирается поисковыми роботами с сайтов в интернете. Пользователи обращаются в этот архив через поисковик и получают список сайтов с информацией по введенному поисковому запросу. Поисковые системы ранжируют сайты по собственным алгоритмам. Они учитывают полезность, тематику, поведенческие факторы посетителей и другие параметры. После просмотра краткой информации (заголовок + описание) о ресурсе, пользователь может нажать на ссылку в результатах поиска и перейти на выбранный сайт.

В конце 1990-х люди начали массово создавать сайты в интернете. На тот момент алгоритм поисковых систем только разрабатывался, поэтому индекс был аналогичен поиску по ключевым словам, найденным роботом на проверяемой странице. Поэтому в ТОПе поиска были сайты, которые чрезмерно оптимизированы и были совершенно бесполезны для пользователей. После 30 лет эволюции алгоритм поиска усложнился. Сегодня роботы обращают внимание не только на содержание и раскрытость темы, но и на ее качество, практичность для людей, доступность сайта для различных устройств, скорость загрузки и так далее.

Сегодня роботы обращают внимание не только на содержание и раскрытость темы, но и на ее качество, практичность для людей, доступность сайта для различных устройств, скорость загрузки и так далее.

На что влияет индексация

Благодаря индексированию в поисковых системах Яндекс и Google, сайт становится видимым для пользователей и потенциальных клиентов. Сами по себе лендинги, интернет-магазины или информационные сайты не имеют ценности. Их полезность определяет посетитель. При нахождении в индексе и регулярном обновлении, ресурсы растут в результатах поиска. Это увеличивает поток трафика и помогает развивать проекты. Боты поисковых систем оценивают не только качество контента, но и поведенческие факторы, посещаемость и участие. По этим показателям они могут определить полезность сайта. Чем лучше поведенческие факторы аудитории, тем выше рейтинг страницы. Первые 20 строк результатов поиска забирают 95% всего поискового трафика. Поэтому хорошая репутация в индексе поисковиков — залог успешного продвижения и высокой конверсии.

Как добавить сайт или страницу в индекс Яндекса и Гугла

Многие не понимают как открыть сайт для индексации поисковиками. На самом деле ее не нужно открывать, поисковые роботы сами найдут и добавят новую страницу, если она специально не закрыта (более подробно о закрытии страницы для индексации, читайте ниже). Для большинства пользователей Рунета индексация в поисковых системах означает добавление сайтов в базы данных Яндекс и Google. Обычно для развития своего проекта достаточно просто зарегистрировать ресурсы в этих поисковых системах. Индексирование, независимо от поисковой системы, выполняется двумя способами:

- Поисковый робот самостоятельно находит и проверяет созданный сайт или новую страницу. Многие эксперты считают этот вариант наиболее выгодным, поскольку если поисковая система сама хочет проиндексировать сайт, значит она признала его полезным. Как боты определяют полезность страницы: наличие актуальных входящих ссылок, трафика и вовлеченности посетителей.

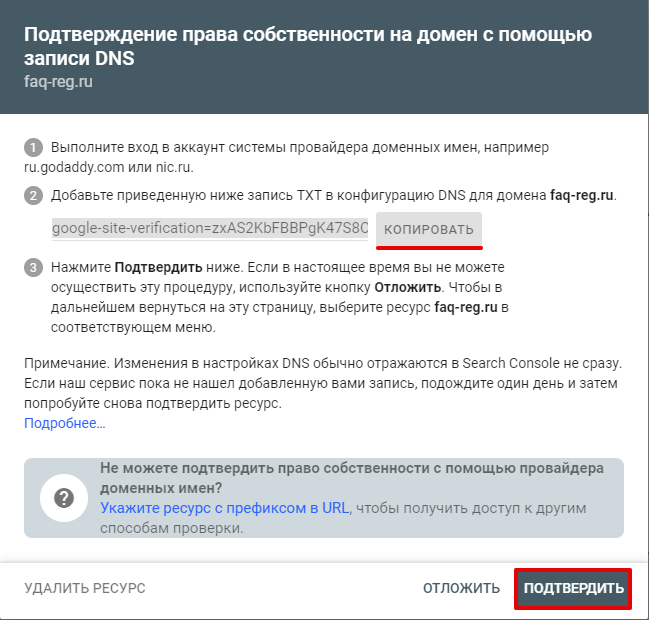

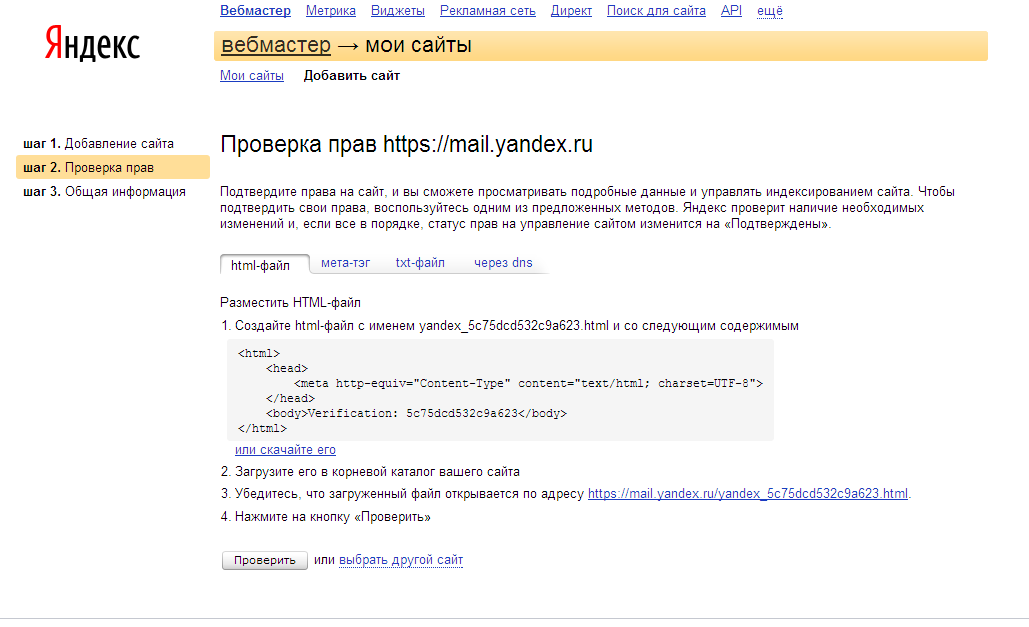

- Можно не ждать когда сайт найдут и проиндексируют поисковые роботы, а дать им адрес напрямую. Пользователь вручную отправляет сайт в очередь на индексацию, отправив заявку в поисковую систему. Созданные страницы добавляются в очередь на индексацию и ожидают когда поисковый робот заглянет на них, чтобы проиндексировать. Обычно добавляют URL-адрес домашней страницы, и робот сам сканирует весь ресурс, ориентируясь на карту сайта, меню и внутренние ссылки. Для ручного добавления сайтов в очередь на индексирование, используют Google Search Console и Яндекс.Вебмастер. Потребуется ввести URL сайта в форму и подтвердить права владельца. Этот вариант требует больше времени, но не требует финансовых затрат.

Для сканирования веб-сайтов используются разные поисковые роботы. Например, проверка новой страницы перед вводом в индекс выполняется основным роботом, который проверяет весь контент на ресурсе.

Кто индексирует быстрее: Яндекс или Google

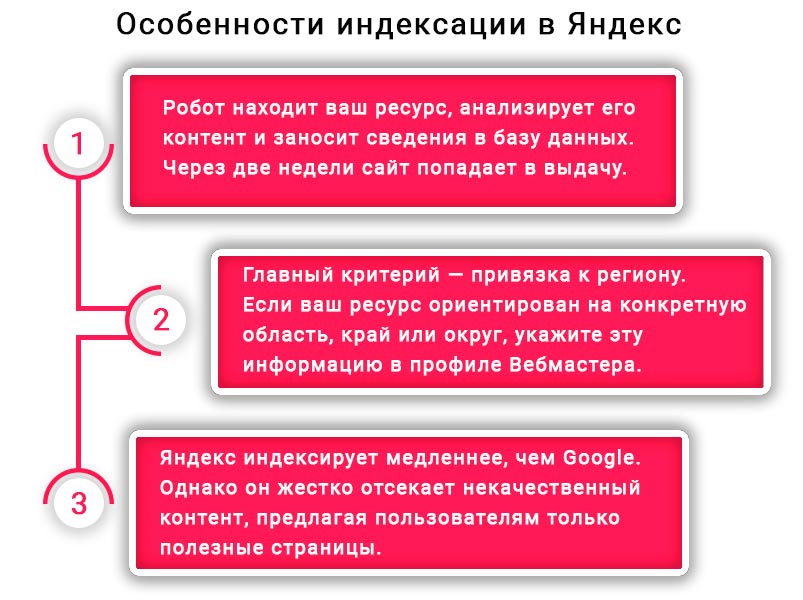

Алгоритм индексации и роботы Яндекса и Google имеют разную скорость обхода и страницы будут проиндексированы за разный промежуток времени. Специалисты считают, что Google быстрее проверяет страницы. Это связано с тем, что система сначала проводит всестороннее сканирование полезных и бесполезных страниц веб-сайта, но позволяет только высококачественным ресурсам попасть в результаты поиска. Следовательно, попадание в индекс Google не гарантирует место в поисковой выдаче.

Почему индексация сайта в Яндексе происходит долго? Поисковый робот проверяет только полезные материалы и отфильтровывает нежелательные страницы. Следовательно, индекс задерживается. В любом случае, проверка соответствия требованиям выполняется двумя системами: Яндекс выполняет ее сразу, а Google выполняет после добавления в индекс.

Как проверить индексацию

Три способа проверить индексацию сайта поисковиками:

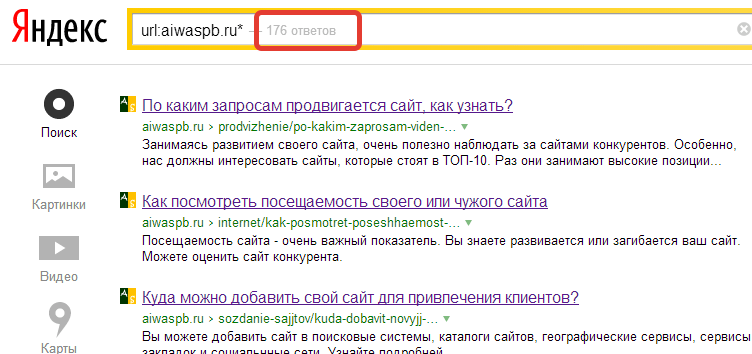

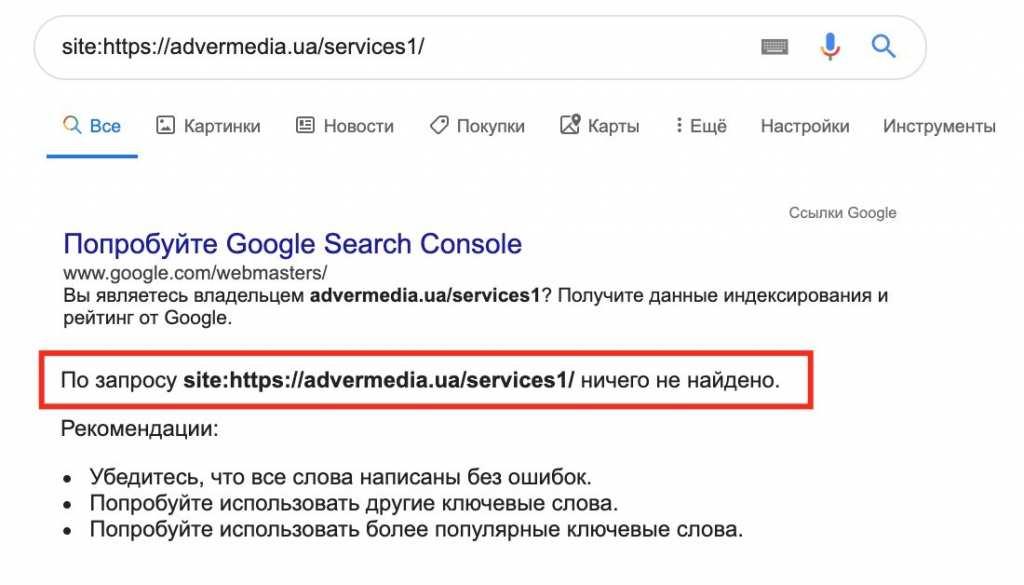

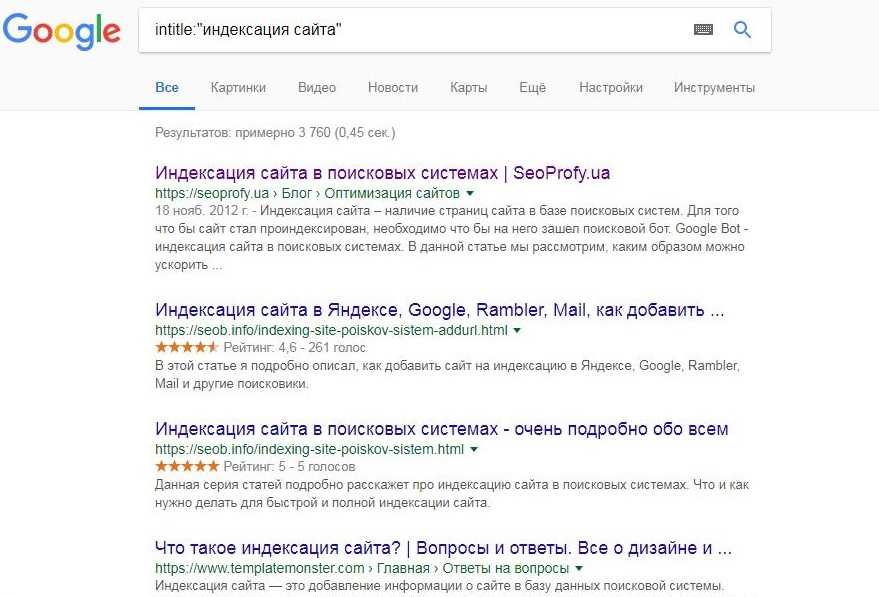

- Используйте специальный оператор, введенный в строку поиска. Для Яндекс и Гугл нужно прописать значение site: и добавить домен ресурса после двоеточия. Например: site:vk.com. Таким образом можно узнать количество проиндексированных страниц. Если значения в Гугле и Яндексе сильно различаются, то скорее всего сайт попал под фильтр.

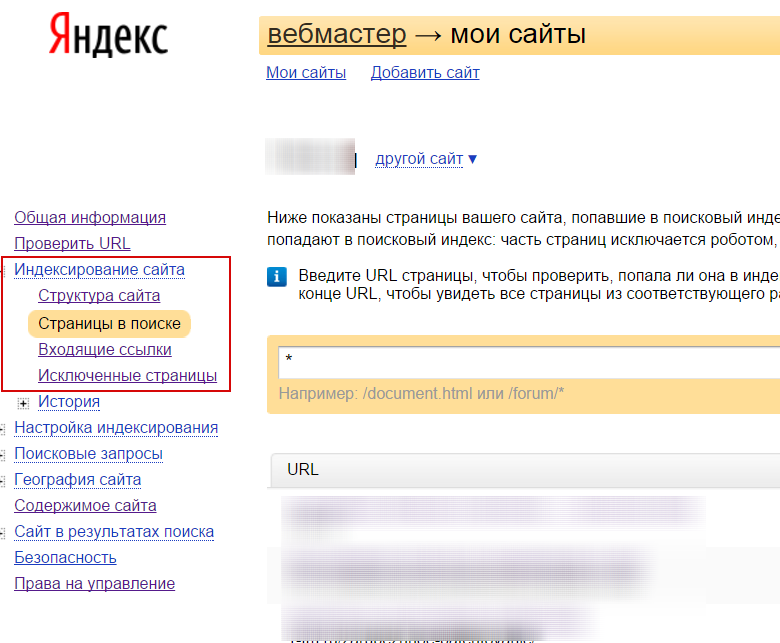

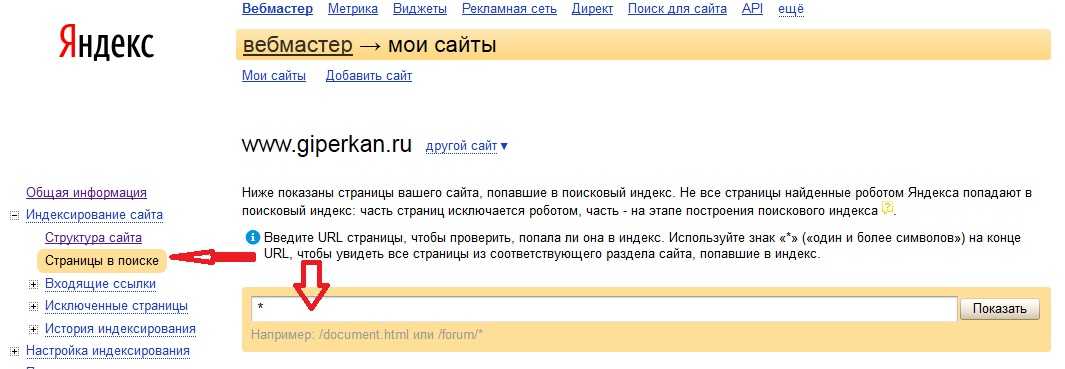

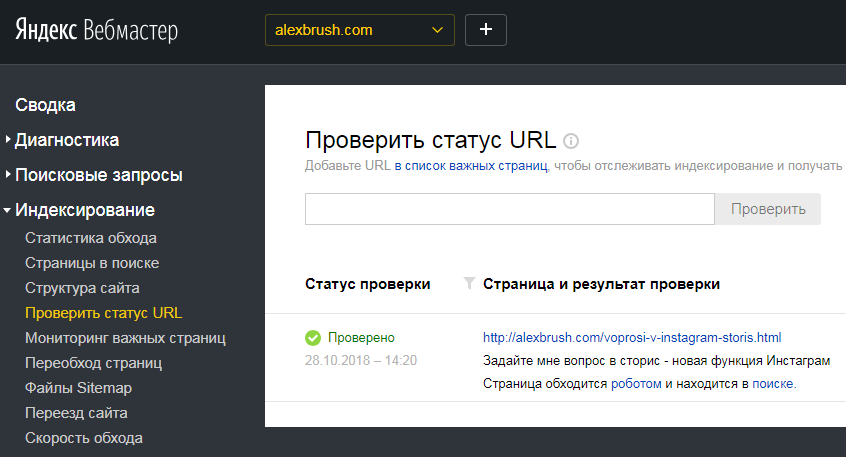

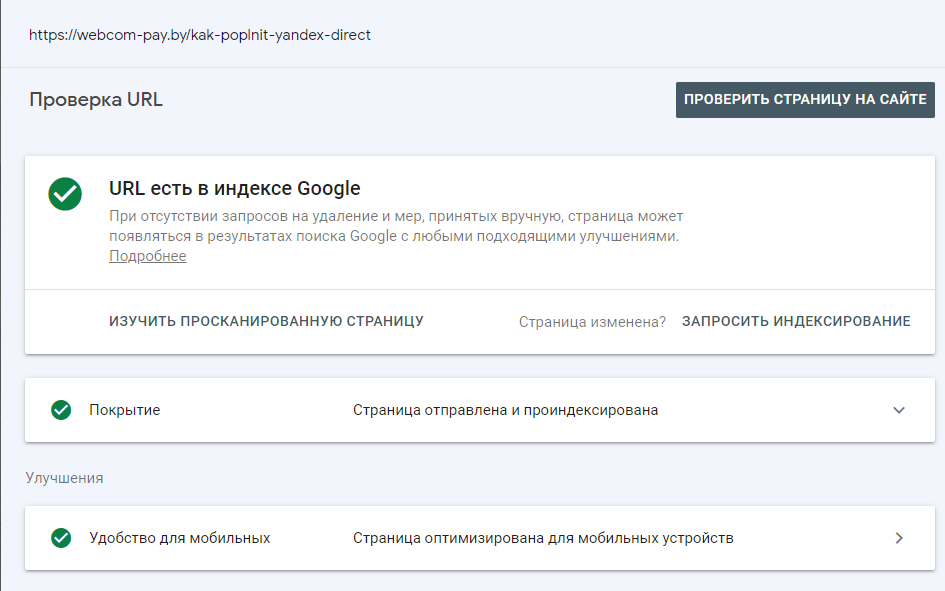

- Воспользуйтесь бесплатными инструментами для веб-мастеров, предоставляемыми поисковыми системами — Яндекс.Вебмастер или Google Search Console. Для Google: после подтверждения прав на сайт, откройте инструмент проверки URL и введите адрес сайта, индекс которого вы хотите проверить. Для Яндекс: после подтверждения прав на сайт, откройте раздел проверить статус URL в Яндекс.Вебмастере, введите адрес и нажмите «Проверить».

- Используйте расширения для браузера или специальные сервисы. Расширения для проверки индексации — это небольшие дополнения к вашему веб-браузеру, которые автоматически проверяют наличие страниц в индексе.

Популярным решением является RDS Bar.

Популярным решением является RDS Bar.

Как ускорить индексацию

Скорость, с которой страница появляется в результатах поиска, напрямую зависит от скорости, с которой робот поисковой системы проверяет наличие нового контента. Соответственно от этого зависит насколько быстро на сайте появятся посетители. Для поисковиков не все сайды одинаковы и грамотно настроенным сайтам поисковая система может отдавать предпочтение при индексации.

Скорость индексирования зависит от нескольких факторов:

- Авторитет сайта в интернете и его полезность для пользователей;

- Отсутствие ошибок при индексации;

- Качество и частота обновления контента;

- Наличие внутренних и внешних ссылок;

- Вложенные страницы;

- Правильно заполненные файлы sitemap.xml и robots.txt;

- Корректные ограничения в robots.txt.

Для ускорения индексации рекомендуются следующие действия:

- Выберите надежный и быстрый хостинг;

- Добавьте сайт в очередь на индекс через Яндекс.

Вебмастер и Google Search Console;

Вебмастер и Google Search Console; - Правильно настройте robots.txt. В этом файле нужно запретить доступ к техническим и сервисным страницам, а также просматривать другую информацию, которая бесполезна для посетителей;

- Создайте файл sitemap.xml и сохраните его в корневом каталоге сайта. В нем робот проверяет структуру страниц и следит за обновлениями контента;

- Проверьте код на главной и других страницах на наличие ошибок и дубликатов.

- Проверьте текстовый контент на наличие ключевых слов и их количество;

- Регулярно публикуйте новый полезный контент на сайте;

- Установите внутренние ссылки между страницами сайта (перелинковку). Это простой и эффективный вариант увеличения участия пользователей в проекте и, соответственно, «роста» результатов поиска;

- Настройте навигацию так, чтобы переходов к нужной странице из главного меню не превышал 3 кликов. Сегодня требования к юзабилити сайта становятся все выше и выше, потому что это напрямую влияет на поведенческие факторы посетителей.

Если расстояние до необходимой информации составляет 10-12 кликов, то 90% пользователей покинут такой сайт, так и не найдя то, что хотели;

Если расстояние до необходимой информации составляет 10-12 кликов, то 90% пользователей покинут такой сайт, так и не найдя то, что хотели; - Разместите ссылки на ресурсы в социальных сетях, тематических форумах, досках объявлений и других сайтах для увеличения посещаемости.

- Уменьшите вес изображений, потому что «тяжелая» графика замедляет скорость загрузки страницы и отрицательно сказывается на дальнейшем улучшении индексации и продвижении сайта в поиске.

Как закрыть сайт или страницу от индексации?

Выше мы узнали, что такое индексирование страниц сайта, зачем она нужна и как ускорить этот процесс. Теперь поговорим о том, как скрыть информацию на странице для предотвращения проверки и когда это нужно делать. Как правило, роботам запрещается сканировать технические и служебные страницы, конфиденциальную информацию, ресурсы, находящиеся в разработке, копии и т.д., чтобы предотвратить их публичный просмотр. Другими словами, чтобы добиться качественного прогресса в поиске, вам необходимо знать, какие данные отображать, а какие скрывать.

Вы можете предотвратить сканирование сайта роботами несколькими способами:

- Используйте файл robots.txt. В документе можно запретить индексацию отдельных страниц и сайта целиком. Этот файл устанавливает правила для поисковых роботов. Для запрета используются два основных оператора: User-agent и Disallow. User-agent указывает адресата, а Disallow запрещает посещение. Например, чтобы скрыть сайт от поисковых роботов, вы можете написать в robots.txt следующий код: User-agent: * и следующую строку Disallow: /.

- Указать специальные теги в файле robots.txt. Обычно этот параметр используется, чтобы скрыть конкретную страницу и предотвратить ее сканирование. Это теги noindex и nofollow, которые запрещают роботам поисковых систем проверять страницу или часть контента. Например, вы можете запретить роботам Гугла сканирование, использовав следующий код: <meta name=»googlebot» content=»noindex, nofollow» />.

Подводя итог

Индексирование имеет простую цель и далеко идущие последствия — добавление информации о сайте в базу данных поисковой системы. Прочитав статью, вы узнали что такое индексация сайтов в поисковых системах. Вы изучили основные моменты добавления, проверки и ускорения индексации сайта в поисковых системах. Вы узнали как и почему ботам нужно запрещать сканировать определенные страницы. Надеюсь материал был вам полезен, индексируйте ваши страницы с умом!

Прочитав статью, вы узнали что такое индексация сайтов в поисковых системах. Вы изучили основные моменты добавления, проверки и ускорения индексации сайта в поисковых системах. Вы узнали как и почему ботам нужно запрещать сканировать определенные страницы. Надеюсь материал был вам полезен, индексируйте ваши страницы с умом!

Что такое индексация сайта и как проиндексировать свой сайт в поисковых системах?

Что такое индексация и как проходит этот процесс в поисковых системах

Любой сайт — будь то корпоративный блог или магазин в e-commerce — проходит несколько важных этапов «рождения». После создания и первичного наполнения контентом, важно проиндексировать сайт поисковыми системами (далее — ПС). Как это происходит:

-

Роботы ПС «видят», что создан новый сайт (или страница).

-

Планируют его «осмотр».

-

Запрашивают контент сайта и анализирует его по ряду параметров.

-

Если все соответствует требованиям — сайт/страница попадает в индекс (своего рода «реестр» ПС), и включается в поисковую выдачу.

Когда пользователь вводит в поисковике запрос, сервис сверяет его с проиндексированными данными и выдает максимально релевантные страницы. Но если при индексации сайта были обнаружены проблемы (ошибки, низкая уникальность текстов, и др.) — ПС могут наложить «санкции» и понизить позиции сайта в выдаче. А то и вовсе исключить его из списка рекомендованных в поиске.

Технологии и алгоритмы индексации сайтов в поисковиках

Технология индексации сайта в Google

Google и Яндекс могут проиндексировать сайты по-разному. У Google действует правило «Mobile-first»: поисковые роботы (краулеры) рассматривают именно мобильную версию сайта и присваивают ей индекс. Поэтому если она проигрывает десктопной, содержит ошибки или не обладает полным функционалом — на нее могут быть наложены ограничения.

Поэтому если она проигрывает десктопной, содержит ошибки или не обладает полным функционалом — на нее могут быть наложены ограничения.

На частоту проверки сайта краулерами и на индексацию сайта в Гугл влияет так называемый «краулинговый бюджет»: чем он больше — тем чаще и быстрее проверяют сайт. Считается, что возраст сайта и частота обновления контента положительно влияют на размер «краулингового бюджета».

Технология индексации сайта в Яндекс

Яндекс принимает за основную десктопную версию сайта, проверяет и индексирует именно ее. Краулингового бюджета в этой ПС нет, показатели «доверия» к сайту или его цитируемость другими источниками не имеют подтвержденного значения. Приоритет отдается сайтам с более высокой посещаемостью и большим количеством страниц. При наполнении сайта контентом стоит помнить, что Яндекс не проверяет документы размером более 10 Мб.

Как проверить индексацию сайта?

Существует несколько способов проверить индексацию страниц вашего сайта:

-

С помощью плагинов проверки (SEO Magic, RDS bar и др.

-

Через специальные сайты-сервисы проверок: Netpeak Spider, Screaming Frog Seo Spider, Se Ranking, arsenkin.ru, serphunt.ru, raskruty.ru и др.

Факторы индексирования и их влияние на поисковые системы

На индексирование страниц и контента вашего сайта влияют несколько факторов:

-

Файл robots.txt. В нем содержатся «подсказки» для краулеров: какие страницы на сайте можно индексировать, а какие — нет. Влияние на индексацию этого файла зависит от типа ПС, но основные — Google и Яндекс, его все же учитывают.

-

Метатег <meta name=“robots” содержит (и при желании — позволяет настроить) команды для поисковых роботов, указывая им как лучше проиндексировать страницы.

-

В серверном программном обеспечении сайта можно добавить в заголовки X-Robots-Tag HTTP-ответы, содержащие настройки, указанные в файлах .

htaccess и httpd.conf. Прописанные в них команды будут выполняться всеми краулерами.

htaccess и httpd.conf. Прописанные в них команды будут выполняться всеми краулерами.

-

Тег <noindex> запрещает индексировать определенный контент — например, текст, при помощи пары тегов <noindex>…</noindex> (работает только для поисковой системы Яндекс).

-

Вывод контента Ajax. Если версия, отображаемая для пользователей, отличается от того, что находится в сохраненной копии, при этом в текстовой версии или коде сохраненной копии отсутствует контент, то это первый признак, что контент страницы может не индексироваться роботами ПС.

Что делать, если сайт не индексируется?

Если ваш интернет-сайт не индексируется продолжительное время — возможно, существуют проблемы с оптимизацией и стоит проверить некоторые аспекты:

1) Не закрыт ли сайт для индексации через:

- файл Robots.txt,

- метатег <meta name=“robots”,

- в файлах .

htaccess и httpd.conf.,

htaccess и httpd.conf., - X-robots-tag.

2) Если в указанных местах доступ не закрыт — стоит проверить, нет ли ошибок в теге rel canonical.

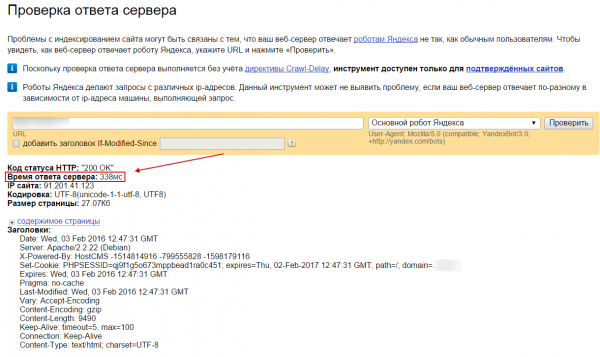

3) Проблемы могут возникать и на хостинге (например, слишком долгое время ответа сервера, или сервер дает неверный ответ на запрос ПС).

4) На сайте содержится неуникальный или контент низкого качества.

И только после проверки всех этих факторов можно искать причины в неверной работе самих ПС. Редко, но иногда сбои происходят именно на стороне поисковиков, но такая информация, как правило, быстро становится общедоступной.

Как ускорить индексацию сайта

Что можно предпринять для более быстрой индексации сайта поисковыми системами? Способов много, перечислим самые очевидные и действенные.

-

Установите автоматическое обновление карты сайта (sitemap). Особенно, если вам нужно быстро проиндексировать страницу в Google — эта ПС обращается к карте в первую очередь, в отличие от Яндекса, которая вначале «смотрит» на файл robots.

txt. Все новые страницы должны тут же заноситься в карту сайта.

txt. Все новые страницы должны тут же заноситься в карту сайта.

-

Тщательно проверьте страницы и размещенный контент. Сайт не должен содержать дубли страниц и контент с низким процентом уникальности. Эти аспекты «воруют» краулинговый бюджет, в результате чего роботы ПС могут просто не добраться до новых страниц, которым нужно индексироваться.

-

Проверьте, нет ли на сайте битых ссылок и каково количество внутренних редиректов. От первых нужно избавиться вовсе, количество вторых — свести к минимуму. Каждый из них также расходует бюджет поисковых роботов.

-

Еще раз проверьте, не закрыты ли добавленные страницы для индексации через robots.txt. Это важно для их дальнейшего продвижения.

-

Проверьте скорость загрузки страниц сайта при помощи PageSpeed Insight. И время ответа сервера, и скорость загрузки отдельных страниц должны быть минимальными (сервис сам измеряет эти показатели и выдаст вам рекомендации по устранению технических недостатков).

-

Проверьте качество внутренней перелинковки. Краулеры «путешествуют» по внутренним ссылкам так же, как и посетители, автоматически ускоряя скорость индексации страниц.

-

Выводите «превью» свежего контента на главную страницу — будь то текстовый материал или карточка с новым товаром. Так ваш контент окажется «на поверхности» сайта и будет быстрее замечен краулерами.

-

Следите за регулярностью обновления контента на сайте. Это относится не только к вновь публикуемым статьям, но и обновлению/корректировке старых.

|

Статью подготовил Сергей Лысенко, ведущий спикер Webcom Academy. |

Поделиться с друзьями:

Какой инструмент вы используете для проверки URL-адресов, которые не проиндексированы? | SEO Форум

Ваш браузер не поддерживает JavaScript.![]() В результате ваши впечатления от просмотра будут уменьшены, и вы будете переведены в режим только для чтения .

В результате ваши впечатления от просмотра будут уменьшены, и вы будете переведены в режим только для чтения .

Загрузите браузер, поддерживающий JavaScript, или включите его, если он отключен (например, NoScript).

- Дом

- SEO-тактика

- Техническое SEO

- Какой инструмент вы используете для проверки не проиндексированных URL-адресов?

Эта тема была удалена. Его могут видеть только пользователи с правами управления вопросами.

-

Какой ваш любимый инструмент для получения отчета о URL-адресах, которые не кэшируются/не индексируются в Google и Bing для всего сайта? В основном мне нужен список URL-адресов, не кэшированных в Google, и отдельный список для Bing.

Спасибо,

Марк

Я могу работать над созданием этого инструмента, если будет достаточно интереса.

- org/Comment»>

Обычно я просто использую поисковик гиперссылок Xenu (если у вас тысячи страниц), чтобы перечислить все URL-адреса, которые у вас есть, и затем я мог бы просмотреть их вручную, однако посмотрите на востребованную гитару. Я не сталкивался с автоматическим устройством. еще. Если все люди знают о каких-либо, я хотел бы признать, как должным образом.

-

В этом сообщении от Distilled упоминается, что плагин SEO для Excel имеет «Проверку индексации»:

https://www.distilled.net/blog/seo/awesome-examples-of-how-to-use-seotools-for- excel/Увы, после загрузки и установки оказалось, что эта функция удалена…

- org/Comment»>

Если я что-то не упустил, кажется, нет способа заставить Google показывать более 100 результатов на странице. На нашем сайте около 8000 страниц, и мне не нравится идея вручную экспортировать 80 SERP.

-

Энни Кушинг из Seer Interactive составила потрясающий список всех необходимых инструментов для SEO.

Вы можете получить его по ее ссылке, которая находится на http://bit.ly/tools-galore

В списке есть инструмент под названием scrapebox, который отлично подходит для этого. На самом деле у программного обеспечения много применений, оно также полезно для поиска потенциальных партнеров по ссылкам.

- org/Comment»>

Я бы посоветовал использовать Аудитор веб-сайтов из Advanced Web Ranking. Он может анализировать 10 000 страниц и сообщит вам гораздо больше информации, чем просто проиндексирована ли она Google или нет.

хм… Я думал, что есть способ перенести эти URL-адреса SERP в документы Google, используя какую-то функцию?

Я думаю, вам не нужен какой-либо инструмент для этого, вы можете напрямую перейти на google.com и выполнить поиск: Site:www.YourWebsiteNem.com Site:www.YourWebsiteName.com/directory сайт сканируется гугл или нет.

-

Я делаю что-то подобное, но использую Advanced Web Ranking, использую site:www.domain.com в качестве фразы, запускаю его для получения 1000 результатов и генерирую отчет Top Site Report в Excel, чтобы получить проиндексированный список.

Также помните, что вы можете сделать это с подкаталогами (или частичными путями URL), чтобы получить более 1000 страниц с сайта. Обычно я запускаю его один раз с site:www.domain.com, затем определяю наиболее часто встречающиеся подкаталоги, добавляю их в качестве дополнительных фраз в проект и запускаю второй раз, то есть: site:www.domain.com site: www.domain.com/dir1 сайт:www.domain.com/dir2 и т. д.

Еще не окончательный, но думаю, что он указывает, где находится значение.

-

У Дэвида Каузларика, на мой взгляд, лучший ответ. Если Google не проиндексировал его, и вы исследовали свою учетную запись веб-мастера Google, то, насколько я понимаю, нет ничего лучше. Это, безусловно, самый простой, быстрый и легкий способ определить результат поисковой выдачи.

re: Дэвид Каузларик

Мы создали внутренний инструмент, который делает это за нас, но в основном вы можете сделать это вручную.

Зайдите в Google, введите «site:YOURURLHERE» без кавычек. Вы можете проверить определенную страницу, сайт, поддомен и т. д. Конечно, если у вас есть тысячи URL-адресов, этот метод не идеален, но это можно сделать.

Удачи!

- org/Comment»>

Согласен, Xenu — чрезвычайно ценный инструмент для меня, которым я пользуюсь каждый день. Кроме того, как только вы получите список всех URL-адресов на своем сайте, вы можете сравнить два списка в Excel (два списка — это список страниц Xenu для вашего сайта и список страниц, которые были проиндексированы Google).

-

Отличное решение, Киран!

Я использую тот же метод, чтобы сравнить список URL из вывода Screaming Frog со столбцом URL Found из моего инструмента ранжирования ключевых слов — конечно, он не захватывает все страницы, которые могут быть проиндексированы.

На самом деле цель состоит не в том, чтобы получить полный список, а в том, чтобы «начертить» страницы, над которыми нужно поработать.

Я согласен, это не автоматизировано, но пока, насколько нам известно, выглядит как хороший и чистый вариант. Спасибо.

-

Увидел это и попробовал следующее, которое не автоматизировано, но является одним из способов сделать это.

- Сначала установите плагин SEO Quake

- Перейти к Google

- Отключить Живой поиск Google (http://www.google.com/preferences)

- Перейти к расширенному поиску установить количество отображаемых результатов (оцените количество страниц на вашем сайте)

- Затем запустите свой сайт: www.

example.com поисковый запрос

example.com поисковый запрос - Экспортировать это в CSV

- Импорт в Excel

- Один раз выполните преобразование данных в столбцы с помощью ; в качестве разделителя (это разделитель CSV)

- Это дает вам отформатированный список.

- Затем импортируйте файл sitemap.xml в другую вкладку в Excel

- Запустите vlookup между вкладками URL, чтобы пометить, какие из них находятся на карте сайта, или наоборот.

Не совсем автоматизирован, но работает.

Меня также интересует этот вопрос. Было бы очень полезно увидеть основной список всех URL-адресов на нашем сайте, которые не проиндексированы Google, чтобы мы могли принять меры, чтобы увидеть, каких аспектов страницы не хватает и что нам для этого нужно.

для индексации.

для индексации.Обычно я просто использую средство поиска ссылок Xenu (если у вас тысячи страниц), чтобы перечислить все имеющиеся у вас URL-адреса, а затем проверить их вручную, но я еще не сталкивался с автоматизированным инструментом. Если кто-то что-то знает, я бы тоже хотел узнать.

Manual не годится для больших сайтов. Если кто-то знает такой инструмент, было бы здорово узнать, какой/где найти. Или ….. Это сделало бы крутой инструмент SEOmoz pro

- org/Comment»>

Плохо — вы правы, он не отображает фактические URL-адреса. Поэтому я думаю, что лучшее, что вы можете сделать, это site:examplesite.com и посмотреть, что получится.

Это сообщит вам число проиндексированных, но все еще не скажет вам, какие из этих URL-адресов проиндексированы, а какие нет. Я думаю, мы все хотели бы этого!

Я бы использовал Инструменты Google для веб-мастеров, так как вы можете видеть, сколько URL-адресов проиндексировано на основе вашей карты сайта. Получив это, вы можете сравнить его со своим общим списком.

То же самое можно сделать с Bing.

То же самое можно сделать с Bing.Да, сейчас я делаю это вручную, поэтому искал что-то более эффективное.

-

Мы создали внутренний инструмент, который делает это за нас, но в основном вы можете сделать это вручную.

Зайдите в Google, введите «site:YOURURLHERE» без кавычек. Вы можете проверить определенную страницу, сайт, поддомен и т. д. Конечно, если у вас есть тысячи URL-адресов, этот метод не идеален, но это можно сделать.

У вас есть животрепещущий вопрос по SEO?

Подпишитесь на Moz Pro, чтобы получить полный доступ к вопросам и ответам, отвечать на вопросы и задавать свои.

Начать бесплатную пробную версию

Есть вопрос?

Просмотр вопросов

Посмотреть Все вопросыНовые (нет ответов)ОбсуждениеОтветыПоддержка продуктаБез ответа

От Все времяПоследние 30 днейПоследние 7 днейПоследние 24 часа

Сортировка по Последние вопросыНедавняя активностьБольше всего лайковБольшинство ответовМеньше всего ответовСамые старые вопросы

С категорией All CategoriesAffiliate MarketingAlgorithm UpdatesAPIBrandingCommunityCompetitive ResearchContent DevelopmentConversion Rate OptimizationDigital MarketingFeature RequestsGetting StartedImage & Video OptimizationIndustry EventsIndustry NewsIntermediate & Advanced SEOInternational SEOJobs and OpportunitiesKeyword ExplorerKeyword ResearchLink BuildingLink ExplorerLocal ListingsLocal SEOLocal Website OptimizationMoz BarMoz LocalMoz NewsMoz ProMoz ToolsOn-Page OptimizationOther SEO ToolsPaid Search MarketingProduct SupportReporting & AnalyticsResearch & TrendsReviews and RatingsSearch BehaviorSEO ТактикаТренды поисковой выдачиСоциальные сетиТехническое SEOВеб-дизайнБелое/черное SEO

Связанные вопросы

- schema.org/ItemList» data-nextstart=»» data-set=»»>

- Может ли кто-нибудь проверить мой сайт?

Могу ли я что-нибудь сделать, чтобы повысить свой рейтинг? 10stuffs.com

Техническое SEO | | Аншу1432

0

- Страницы не индексируются?

Здравствуйте! Я пытался выяснить, почему Google Search Console считает эти страницы неиндексируемыми: https://www.

visitflorida.com/en-us/eat-drink.html

https://www.visitflorida.com/en-us/florida-beaches/beach-finder.html

Moz и SEMrush сканируют страницы и не показывают ошибок, но GSC возвращает сообщение «заблокировано robots.txt», но я подтвердил, что это не так.

У кого-нибудь есть мысли?

6AYn1TL

visitflorida.com/en-us/eat-drink.html

https://www.visitflorida.com/en-us/florida-beaches/beach-finder.html

Moz и SEMrush сканируют страницы и не показывают ошибок, но GSC возвращает сообщение «заблокировано robots.txt», но я подтвердил, что это не так.

У кого-нибудь есть мысли?

6AYn1TLТехническое SEO | | Кен Шефер

0

- Случайно Нет Индекс

Всем привет! Мы контролируем несколько клиентских сайтов в моей компании. Разработчики случайно внедрили робота без индекса в код сайта, когда мы делали обновление HTTPS, не зная об этом (да, это правда). Десять дней спустя мы заметили, что трафик падает.

Через пару дней мы обнаружили теги отсутствия индекса, удалили их и перезагрузили карты сайта. Сайты снова начали ранжироваться по своим ключевым словам в течение дня или двух. Органический трафик по-прежнему значительно снижается, а другие ключевые слова, по которым они ранжируются, не находятся на том же месте, что и раньше, или вообще не находятся.

Если я загляну в консоль поиска Google, там будет сказано, что мы отправили, например, 4000 URL-адресов, и только 160 из них были проиндексированы. Мне кажется, что Google слишком долго переиндексирует остальные сайты? У кого-нибудь есть эта проблема?? Мы начинаем очень беспокоиться, поэтому любой вклад будет оценен. Я прочитал здесь статью от 2011 года о компании, которая сделала то же самое, и они ранжировались по своим ключевым словам в течение недели. С момента исправления прошло 8 дней.

Через пару дней мы обнаружили теги отсутствия индекса, удалили их и перезагрузили карты сайта. Сайты снова начали ранжироваться по своим ключевым словам в течение дня или двух. Органический трафик по-прежнему значительно снижается, а другие ключевые слова, по которым они ранжируются, не находятся на том же месте, что и раньше, или вообще не находятся.

Если я загляну в консоль поиска Google, там будет сказано, что мы отправили, например, 4000 URL-адресов, и только 160 из них были проиндексированы. Мне кажется, что Google слишком долго переиндексирует остальные сайты? У кого-нибудь есть эта проблема?? Мы начинаем очень беспокоиться, поэтому любой вклад будет оценен. Я прочитал здесь статью от 2011 года о компании, которая сделала то же самое, и они ранжировались по своим ключевым словам в течение недели. С момента исправления прошло 8 дней.Техническое SEO | | АлиМак26

0

- org/ListItem»> 301 Redirects, Sitemaps and Indexing — Как скрыть перенаправленные URL-адреса от поисковых систем?

На нашем сайте есть несколько страниц, подобных этой, http://www.spectralink.com/solutions, которые перенаправляют на более глубокую страницу, http://www.spectralink.com/solutions/work-smarter-not- Сильнее. Оба URL-адреса указаны в карте сайта, и обе страницы индексируются. Должны ли мы удалить эти перенаправляющие страницы с карты сайта? Должны ли мы предотвратить индексацию URL-адреса перенаправления? Если да, то как лучше всего это сделать?

Техническое SEO | | HeroDesignStudio

0

- org/ListItem»> URL-адрес категории Разбивка на страницы, где URL-адреса не меняются между страницами

Здравствуйте! Я работаю над сайтом электронной коммерции, где есть категории с несколькими страницами. Чтобы избежать проблем с нумерацией страниц, я думал об использовании тегов rel=next и rel=prev и cannonical. Я заметил сайт, на котором URL-адрес не меняется между страницами, поэтому, находитесь ли вы на странице 1, 2 или 3 одной и той же категории, URL-адрес не меняется. Будет ли это более чистым способом работы с нумерацией страниц?

Техническое SEO | | whiteonlySEO

0

- org/ListItem»> Как исправить эти нежелательные URL-адреса?

Прямо сейчас у меня есть wordpress, одностраничный веб-сайт, но Google также показывает wp-контент. Пожалуйста, проверьте ниже в Google. сайт: http://baltimoreelite.com/ Как я могу решить эту проблему?

Техническое SEO | | Маркнорманн

0

- Сайт проиндексирован, но не кэширован?

Около 2 недель назад я запустил новый веб-сайт, который, похоже, проиндексирован, но не кэшируется.

По данным Google Webmaster, большинство страниц проиндексированы, и я вижу их, когда ищу сайт: www.xxx.com.

Однако, когда я ввожу URL-адрес — cache:www.xxx.com, я получаю страницу ошибки 404 от Google.

По данным Google Webmaster, большинство страниц проиндексированы, и я вижу их, когда ищу сайт: www.xxx.com.

Однако, когда я ввожу URL-адрес — cache:www.xxx.com, я получаю страницу ошибки 404 от Google.

Я проверил больше известных веб-сайтов, и они кэшируются, поэтому я знаю, что здесь я проверяю правильно… Почему мой сайт должен быть проиндексирован, но не в кеше?Техническое SEO | | theLotter

0

- Как использовать относительную каноничность?

Привет, у меня есть несколько вопросов по этому поводу, и я думаю, что вы можете помочь мне в этом.

Здесь у меня есть пример моей проблемы:

нумерация страниц:

Предположим, что у меня есть новый с 2 страницами

http://www.espectador.com/noticias/208907/fernando-pereira-encuesta-de-cifra-prendio-una-lucecita-amarilla-en-el-pit-cnt

вы можете получить доступ к первой странице разными способами:

www.espectador.com/1v4_contenido.php?m=&id=250419&ipag=1

http://www.espectador.com/1v4_contenido.php?m=&id=250419

http://www.espectador.com/noticias/250419/alvaro-vega-fa-creo-que-cosmo-fue-usada-por-bqb-para-evitar-una-subasta-a-la-baja-y- asi-quedar-con-las-manos-libres

То же мета-описание, то же тело с разными URL-адресами.

Могу ли я использовать rel canonical в файле 1v4_contenido.php, который указывает на понятный URL-адрес? Техническое SEO | | информатика810

Здесь у меня есть пример моей проблемы:

нумерация страниц:

Предположим, что у меня есть новый с 2 страницами

http://www.espectador.com/noticias/208907/fernando-pereira-encuesta-de-cifra-prendio-una-lucecita-amarilla-en-el-pit-cnt

вы можете получить доступ к первой странице разными способами:

www.espectador.com/1v4_contenido.php?m=&id=250419&ipag=1

http://www.espectador.com/1v4_contenido.php?m=&id=250419

http://www.espectador.com/noticias/250419/alvaro-vega-fa-creo-que-cosmo-fue-usada-por-bqb-para-evitar-una-subasta-a-la-baja-y- asi-quedar-con-las-manos-libres

То же мета-описание, то же тело с разными URL-адресами.

Могу ли я использовать rel canonical в файле 1v4_contenido.php, который указывает на понятный URL-адрес? Техническое SEO | | информатика810 0

Как проверить индексацию вашего сайта в Google — Travelpayouts

Что такое индексация сайта?

По сути, индексация веб-сайтов — это процесс добавления сайта в базу данных поисковой системой.![]() Затем на основе полученной информации движок оценивает качество сайта и соответственно ранжирует его.

Затем на основе полученной информации движок оценивает качество сайта и соответственно ранжирует его.

Индексация веб-сайтов в Google — это первый шаг к их оптимизации для поисковых систем. Вы не можете получить высокий рейтинг, если ваш сайт даже не проиндексирован. Таким образом, необходимо постоянно отслеживать индексацию вашего сайта как для новых страниц, так и для существующего контента.

Если вы заметили, что многие страницы не проиндексированы, найдите возможную причину и устраните ее. Например, из-за нарушения правил Google ваш сайт может потерять индексацию, поэтому вам придется отправить запрос на повторное включение. Это, естественно, повлияет на трафик и доход, поэтому всегда важно следить за индексацией вашего сайта.

Как проверить индексацию веб-сайта

Чтобы проверить индексацию веб-сайта, используйте такие инструменты, как Google Search Console, URL Profiler или Google Index Checker.

Во-первых, вам нужно будет создать список URL-адресов страниц вашего сайта либо вручную, либо с помощью специальных инструментов или плагинов (таких как Google XML Sitemaps). Затем введите URL-адреса выбранного вами инструмента. Ниже приведен пример использования URL Profiler:

Затем введите URL-адреса выбранного вами инструмента. Ниже приведен пример использования URL Profiler:

Нажав «Запустить профилировщик», вы проверите, индексирует ли Google ваш веб-сайт. Программа сгенерирует электронную таблицу с проиндексированными страницами и ошибками, как вы можете видеть ниже:

При выборе подходящего инструмента учитывайте его цену и характеристики. Существуют разные варианты проверки индексных страниц сайта:

- Бесплатные инструменты (Google Search Console),

- Плата за URL (SEranking.com),

- Ежемесячная подписка (профилировщик URL).

Как улучшить индексацию вашего веб-сайта

Сканер решит, индексировать страницу или нет, в зависимости от ее ценности для пользователей. Таким образом, создавайте значимые страницы, а затем регулярно проверяйте статус индексации веб-сайта. Это позволит отслеживать прогресс и замечать проблемы на ранних стадиях.

Запрос на индексирование новой страницы

Сообщите Google о вашей новой странице, запросив ее индексацию. Такой запрос сработает только для вновь созданных страниц и не поможет, если Google уже посещал их и по каким-то причинам не проиндексировал.

Такой запрос сработает только для вновь созданных страниц и не поможет, если Google уже посещал их и по каким-то причинам не проиндексировал.

Перед запросом на индексацию обязательно:

- Добавить внутренние ссылки на новую страницу с релевантных и/или популярных страниц вашего сайта

- Добавить качественные обратные ссылки на новую страницу с других ресурсов

- Добавить новую страницу на карту сайта

Затем зайдите в Google Search Console и запросите индексацию:

- Откройте инструмент проверки URL

- Вставьте ссылку на страницу, которую хотите проверить

- Нажмите «Запросить индексацию»

Проверьте существующий контент

Контент — самая важная часть веб-сайта. Если у вас есть старые страницы, которые еще не были проиндексированы, это может указывать на проблему. Мы подготовили список самых распространенных ошибок в контенте и поделимся советами, как их избежать.

Обратные ссылки

Качественные обратные ссылки сообщают Google, что страница, на которую они ссылаются, была высоко оценена пользователями. Это не означает, что страницы без обратных ссылок никогда не будут проиндексированы, просто это может занять больше времени.

Это не означает, что страницы без обратных ссылок никогда не будут проиндексированы, просто это может занять больше времени.

Не забывайте следить за тем, откуда берутся ссылки. Источники низкого качества также могут плохо повлиять на индексацию. То же самое относится и к массовым ссылкам в комментариях к блогам, социальным сетям и т. д. Думая о том, как получить обратные ссылки для своего блога, лучше сосредоточиться на надежных и ценных ресурсах.

Содержание

Контент должен быть качественным и уникальным. Это важно не только для пользователей, но и для поисковых систем. Страница с низкой уникальностью статьи может быть признана сканером бесполезной и не будет проиндексирована.

Разделите страницы вашего сайта на важные и неважные с точки зрения индексации. Последние могут включать в себя технические или дублирующие страницы, важные для работы сайта, но не представляющие никакой ценности для пользователя. Если они будут проиндексированы, это может негативно повлиять на общий рейтинг вашего сайта:

- Это замедлит индексацию важных страниц.

- Важные страницы будут иметь меньший вес с точки зрения SEO.

- Меньшее доверие к сайту со стороны поисковых систем.

- Если у вас есть похожие страницы, важную страницу можно заменить на неважную.

Скорость загрузки

По словам Нила Пателя, 75% посетителей покинут страницу, если она загружается более трех секунд. Скорость загрузки страниц напрямую влияет на индексацию и ранжирование. Чем быстрее скорость, тем полезнее страница для пользователей. Кроме того, у сканеров есть ограничения по времени, поэтому они будут индексировать меньше страниц на сайте с низкой скоростью.

Проверьте скорость загрузки вашего сайта с помощью одного из следующих инструментов:

- PageSpeed Insights измеряет скорость загрузки, выделяет слабые места и дает рекомендации.

- Google Analytics также помогает проверить скорость вашего сайта. Нажмите «Поведение», затем «Скорость загрузки сайта». Он также имеет интеграцию с PageSpeed Insight.

- Serpstat Site Audit позволяет проверить скорость загрузки для мобильных и десктопных устройств. Вы получите сводку об ошибках, замедляющих скорость, и рекомендации по их устранению.

Вложение страниц

Вложенность страниц — еще один важный момент для индексации сайта. По сути, это структура вашего сайта:

Страницы, расположенные далеко от главной страницы, могут быть пропущены поисковыми роботами. Итак, убедитесь, что все страницы вашего сайта легко доступны.

Существует два типа размещения страниц, о которых нужно позаботиться:

- Вложение по кликам. Проверьте, сколько раз пользователю нужно кликнуть, чтобы попасть на страницу. Если это слишком глубоко в структуре, вы можете исправить это, упростив последнюю. В идеале все страницы должны быть в пределах трех кликов от главной страницы.

- Вложение по URL. Сканеры не любят длинные URL-адреса, поэтому убедитесь, что они короткие. В то же время, когда все страницы находятся на первом уровне вложенности, структура сайта также будет подозрительной для краулера.

Показатель отказов

Показатель отказов — это отношение пользователей, которые посетили более одной веб-страницы, к тем, кто посетил только одну и ушел. Показатель отказов варьируется от 10 до 90% в зависимости от ниши. Например, в интернет-магазинах показатель отказов составляет 20-40%, а в туристической нише в среднем около 37%.

Слишком высокий показатель отказов может указывать на определенные проблемы, такие как:

- Невыполнение запроса пользователя

- Плохой дизайн

- Оскорбительная реклама

- Неудобная навигация

- Низкая скорость загрузки страницы

- Проблемы с мобильностью

Устраните эти проблемы сайт.

Кодировка

Кодирование может стать еще одной основной проблемой как для поисковых роботов, так и для пользователей. Краулеры определяют кодировку на основе информации, полученной с сервера или содержимого веб-страницы. Если есть ошибка в кодировке, текст может не сканироваться.

Вот несколько причин ошибок кодирования:

- Нет тега Код ответа сервера

Код ответа сервера выдается сервером по запросу клиента. Существуют разные коды состояния ответа HTTP, самые популярные из них:

.- 200 – положительный, означает, что страница успешно загружена.

- 301 — перенаправление посетителя на другую страницу.

- 404 – страница не существует.

Для проверки кода ответа вы можете использовать Audit Serpstat, ScreamingFrog или Web Sniffer. Также вы можете проверить код ответа сервера прямо в Google Chrome. Нажмите F12, затем перейдите на вкладку «Сеть» и выберите «Документ». Обновите страницу и посмотрите код ответа сервера в столбце Статус.

Карта сайта

Все важные страницы, которые вы хотите проиндексировать, должны быть включены в карту сайта. Итак, возникает необходимость регулярно обновлять файл карты сайта и проводить проверки каждые 10-14 дней. Вы можете использовать Screaming Frog или любой другой инструмент для сканирования вашей карты сайта.

Не проведя аудит, вы можете пропустить ряд различных проблем, таких как:

- Дублирование страниц

- Замена страниц (пример — /home вместо / , когда они идентичны)

- Неактуальные адреса, например, адрес страницы с http при использовании https.

- Неверный URL страницы с www. когда вы используете страницы без www.

- Страницы перенаправления, страницы 404 или любые другие коды состояния ответа HTTP, отличные от 200.

Фильтры

Существует множество фильтров, которые Google использует для регулирования индексации и ранжирования. Некоторые из них уже стали частью автоматизированных алгоритмов, а другие работают с помощью человека. В некоторых случаях вы можете быстро понять, что попали под санкции, когда заметите сообщение в Google Search Console о своих нарушениях.

Но в других случаях вы можете даже не заметить какой-либо проблемы на ранней стадии. Вот почему так важно отслеживать производительность и рейтинг вашего сайта, например, с помощью одного из следующих инструментов:

- Датчик SEMRush помогает отслеживать позиции в рейтинге

- Инструмент Panguin SEO помогает проверить, не повлияли ли на ваш сайт обновления алгоритма Google

- Google Penalty Checker помогает проверить, не был ли ваш сайт наказан Google

Вирусы

Заражение вирусом может произойти на вашем веб-сайте несколькими способами:

- Ваш сайт был взломан с использованием уязвимостей

- Вирус переносится с компьютера веб-мастера на сайт через FTP-клиент

- Использование плагинов или надстроек из сомнительных источников

- Размещение рекламных баннеров, содержащих вредоносный код

Очевидно, что вирусы негативно влияют на индексацию и работу сайта.

Если на вашем сайте появится какой-либо вирус, вы можете быть оштрафованы поисковыми системами и вашим хостинг-провайдером. Ваш сайт может выпасть из индекса, уменьшится посещаемость и т.д.

Если на вашем сайте появится какой-либо вирус, вы можете быть оштрафованы поисковыми системами и вашим хостинг-провайдером. Ваш сайт может выпасть из индекса, уменьшится посещаемость и т.д.Чтобы решить эту проблему, вам нужно будет найти и удалить вирус. Затем вы должны связаться со службой поддержки из Google Search Console и сообщить им, что проблема устранена. Тогда будет необходимость просить хостинг-провайдера разблокировать вас. И, наконец, вам нужно запросить у Google повторную индексацию вашего сайта. После всех этих действий сайт начнет медленно восстанавливаться и набирать трафик.

Стойки

Ваш сайт оптимизирован для поисковых систем, но не индексируется Google? Проблема может быть в файле robots.txt. Проверьте этот файл, перейдите на сайт sitename.com/robots.txt и проверьте написанный там код. Убедитесь, что у вас нет похожих строк в коде:

- User-agent: Googlebot или просто *

- Disallow: /

Такие строки могут препятствовать индексации страниц.