Как проверить индексацию сайта и страниц в поисковых системах Яндекс и Google — Сollaborator

Оглавление

- Что такое индексация сайта

- Как проиндексировать сайт в Яндексе и Google

- Яндекс.Вебмастер

- Google Search Console

- Другие поисковые системы

- Как ускорить индексацию сайта в поисковых системах

- Скорость индексации зависит от:

- Пропишите правила индексации сайта в robots.txt

- Создайте и настройте карту сайта sitemap.xml

- Делайте внутреннюю перелинковку

- Как проверить индексацию сайта или отдельной страницы

- Поисковые операторы

- Плагины для проверки индексации страниц

- Сервисы для проверки индексации

- Панели вебмастера Search Console и Яндекс.

Вебмастер

Вебмастер

- Почему сайт или страницы не индексируется

- Как ускорить индексацию сайта или страниц

- Как ускорить индексацию страниц сайта в Гугле

- Как ускорить индексацию страниц сайта в Яндексе

- Как закрыть сайт от индексации

- Итоги

Индексация сайта (поисковая индексация сайта) – сканирование сайта и добавление его в базу данных (индекс поисковых систем).

Это если совсем просто и коротко. А если подробнее?

Важно! Если вы хотите получать аудиторию из поисковых систем – сайт должен быть открытым для индексации.

Поисковые системы типа Яндекса и Google сканируют страницы сайтов, чтобы классифицировать их и добавить в Индекс – базу данных. Поисковые роботы – пауки или краулеры – собирают информацию о тексте, видео, изображениях и другом доступном для сканирования контенте. Робот проверяет его на соответствие требованиям, отсеивает спам и добавляет полезный контент в свою базу.

Поисковые роботы – пауки или краулеры – собирают информацию о тексте, видео, изображениях и другом доступном для сканирования контенте. Робот проверяет его на соответствие требованиям, отсеивает спам и добавляет полезный контент в свою базу.

База данных поисковику нужна, чтобы выдавать пользователям верные результаты по запросам. Чем более релевантен сайт запросу, тем выше в списке результатов он находится, а значит и получает больше переходов.

В данной статье мы разберемся с самыми важными вопросами, связанными с индексацией сайта и страниц:

- Как узнать, проиндексирован ли сайт;

- Как проверить количество проиндексированных страниц сайта в поисковых системах Гугл и Яндекс;

- Как проверить индексацию страниц;

- Как ускорить индексацию сайта в Яндексе и Google;

- Какие поисковые операторы можно использовать;

- Как использовать robots.txt и sitemap.xml для быстрой индексации страниц.

Чтобы узнать подробно, как индексировать страницы или сайт и можно ли ускорить индексацию, пройдите бесплатные SEO курсы 2021 для начинающих от Сергея Кокшарова.

Чтобы проиндексировать сайт в Яндексе и Гугле, воспользуйтесь инструментами для вебмастеров: Яндекс.Вебмастером и Search Console. Поисковики индексируют сайты с разной скоростью. Например, Яндекс может «рассматривать» обычный сайт от недели до месяца, а вот Google сделает это максимум за неделю. Но чтобы не ждать, можно самому повлиять на скорость индексации.

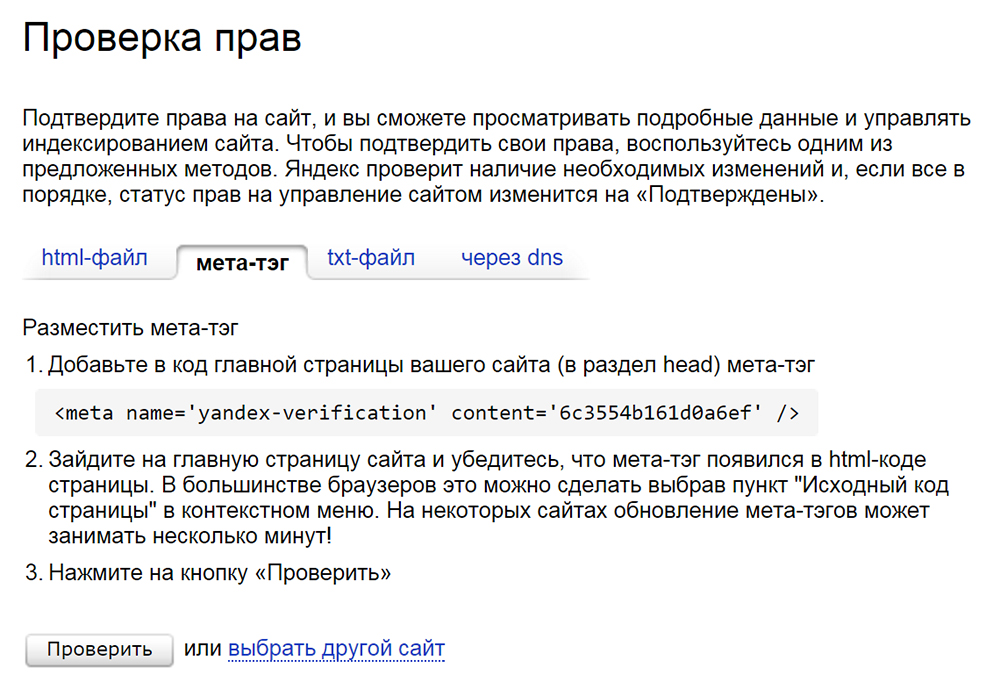

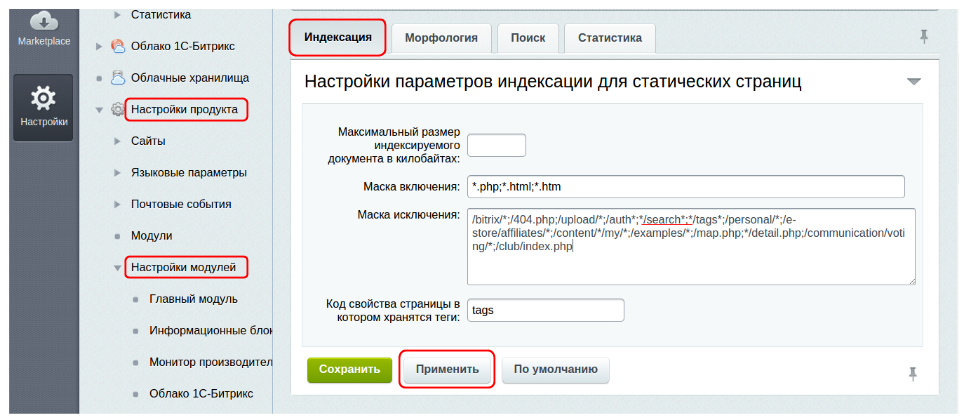

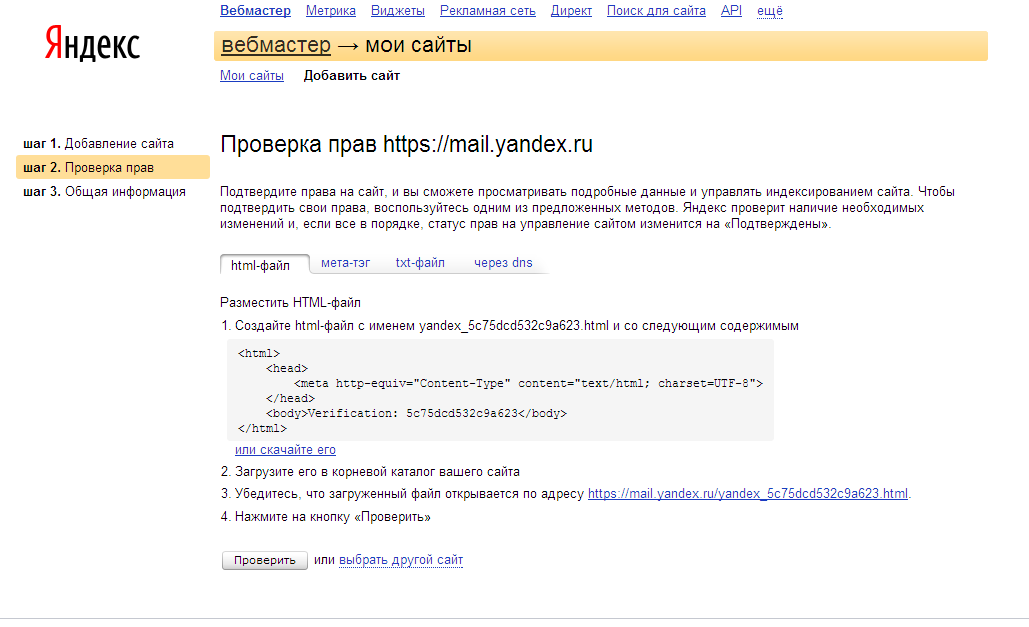

Чтобы добавить сайт в Яндекс.Вебмастер:

- Войдите в свой аккаунт на Яндексе или зарегистрируйте новый.

- Перейдите на сервис Вебмастер и впишите в поле адрес главной страницы вашего сайта.

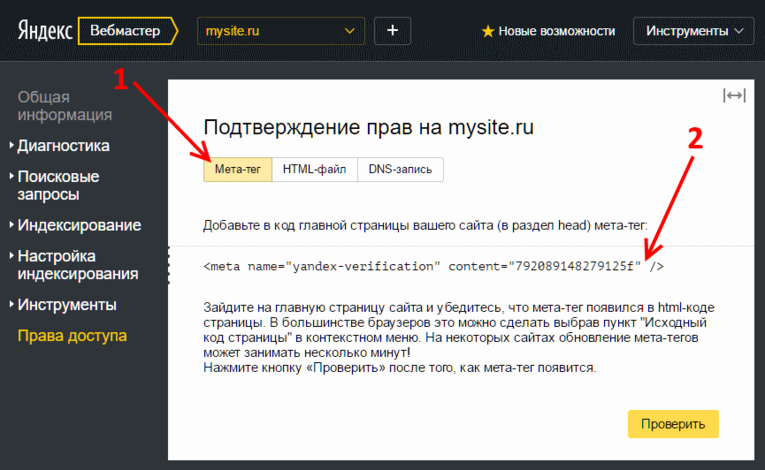

- Подтвердите, что вы владелец сайта. Сервис предложит вам добавить мета-тег в код страницы, либо другой способ подтверждения.

- Робот проверит наличие мета-тега, добавит сайт и покажет информацию о нем.

- Установите и привяжите к аккаунту Вебмастера Яндекс.Метрику, чтобы краулер использовал более точные данные.

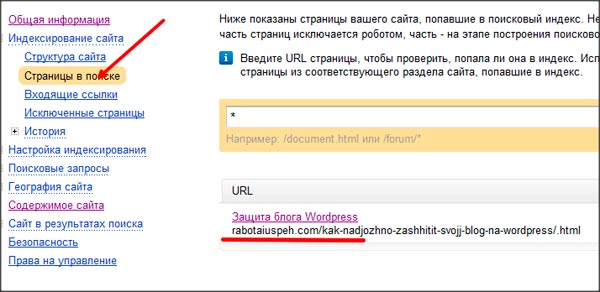

После добавления сайта в панель вебмастера — ожидайте его индексации. Отслеживать статус индексации страниц вы можете в следующем отчете:

Отслеживать статус индексации страниц вы можете в следующем отчете:

Проверка индексации страниц в Яндекс.Вебмастере

Чтобы добавить сайта в Google Search Console:

- Перейдите на страницу Search Console и войдите в свой аккаунт или зарегистрируйтесь.

- Добавьте сайт в систему.

- Подтвердите права на сайт.

Когда сайт проиндексируется, вы увидите отчет.

Проверка индексации страниц в Google

В основном пользователи рунета отдают предпочтение Google и Яндексу, но и несколько других поисковиков должны знать о вашем сайте, небольшие объемы трафика вы также можете получать оттуда.

Mail.ru имеет свой кабинет для вебмастеров. Вы можете добавить туда сайт по тому же принципу.

Рамблер пользуется теми же данными, которые собирает Яндекс, так что вам не понадобятся дополнительные настройки.

Yahoo и Bing имеют общий кабинет для вебмастеров, с тех пор как два поисковика объединились. Вам нужно зарегистрироваться, после чего перейти в настройки вебмастера и добавить адрес сайта. После откроется страница, где нужно добавить сведения о сайте. Пройдет несколько недель, прежде чем информация о сайте начнет отображаться.

Вам нужно зарегистрироваться, после чего перейти в настройки вебмастера и добавить адрес сайта. После откроется страница, где нужно добавить сведения о сайте. Пройдет несколько недель, прежде чем информация о сайте начнет отображаться.

- частоты обновления контента;

- внутренних и внешних ссылок;

- наличия трафика на сайт с других источников;

- технической оптимизации сайта;

- корректной настройки CMS системы.

Да, рано или поздно роботы сами найдут ваш сайт и проиндексируют его, но ждать можно долго. Помимо ручного добавления сайта в систему поиска, существуют другие рекомендации.

Как ускорить индексацию в поисковых системах:

- добавляйте новый уникальный контент регулярно;

- упрощайте навигацию по сайту;

- настройте robots.txt;

- создайте карту сайта для поисковых роботов;

- сделайте внутреннюю перелинковку;

- используйте внешние ссылки.

Чтобы научиться эффективно наращивать ссылочную массу, смотрите бесплатный курс по линкбилдингу от Игоря Рудника.

Главная рекомендация для ускорения индексации:

создайте sitemap.xml на вашем сайте и добавьте его в Google Search Console и в Яндекс.Вебмастер.Читайте также: Как проверить и ускорить индексацию страницы в Google, а также как отправить страницу на переиндексацию в Google Search Console

Файл robots.txt хранится в корневом каталоге сайта, он может быть только один. Это текстовый файл, в который записывают правила для каждого отдельного поискового бота или для всех сразу. Правилами можно «спрятать» от роботов технические страницы, сделать акцент на важных и т.д.

Проверить файл можно прямо в Search Console и Яндекс.Вебмастере.

У пауков ограниченное время на посещение сайта (краулинговый бюджет), и если дать ему обрабатывать все подряд страницы, то он может не успеть проиндексировать самые важные, «застряв» на технических.

Например, если у вас интернет-магазин, в robots.txt стоит закрыть от индексации внутренний поиск, корзины покупателей. Подробнее о работе с файлом можно прочесть в справке Google.

Как закрыть сайт от индексации в robots.txt, читайте в материале.

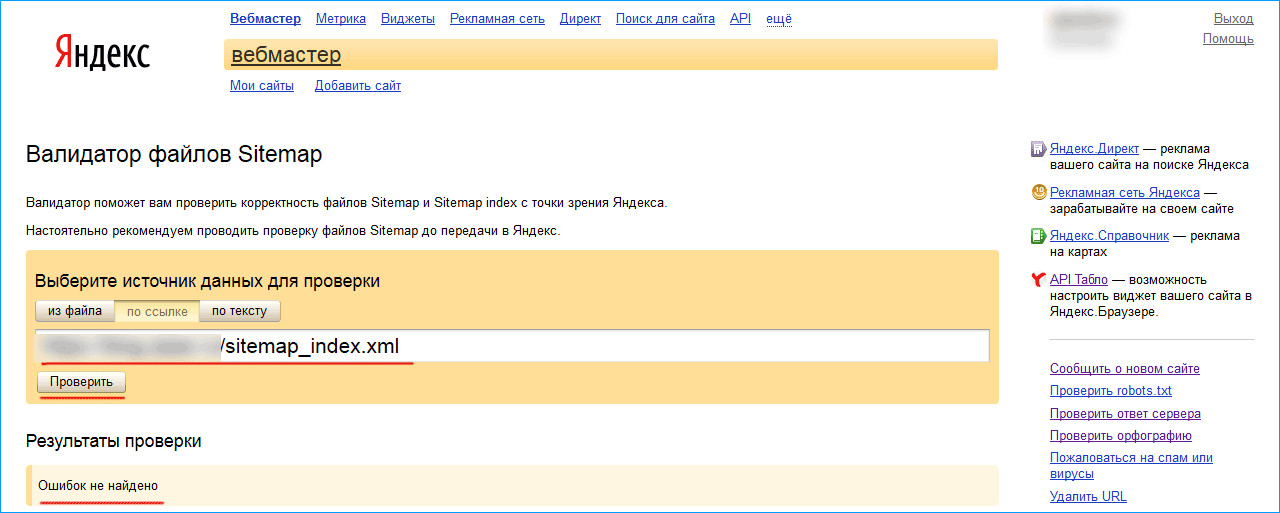

Sitemap.xml – карта сайта, куда нужно добавить все страницы, которые нужно проиндексировать. Карта поможет определить, где находятся страницы и частоту их обновления, приоритетность в структуре.

- Необходимо создать карту сайта.

- Указать в карте сайту правила индексации страниц: дату обновления страниц, приоритет страниц и другие параметры.

- Добачить карту сайта в панели для вебмастеров Google Search Console и Яндекс.Вебмастер.

Файл обычно располагается по адресу https://domain.com/sitemap.xml.

Карта сайта выглядит примерно вот так:

В файле используются специальные теги XML:

- <url></url> – обозначает начало и конец блока страницы;

- <code></loc> – указывает адрес страницы;

- <lastmod></lastmod> – указывает дату последнего обновления страницы;

- <code><priority> – указывает приоритет страницы;

- <changefreq></changefreq> – указывает частоту обновления страницы с помощью:

- never – никогда;

- yearly – раз в год;

- monthly – каждый месяц;

- weekly – каждую неделю;

- daily – каждый день;

- hourly – каждый час.

Для больших сайтов имеет смысл создать несколько карт.

Внутренняя перелинковка – это ссылки на другие страницы вашего сайта. С ее помощью вы формируете структуру, которая помогает пользователям ориентироваться на сайте.

Внтрення перелинковка ускоряет индексацию страниц, так как роботы сами проходят по ссылкам и проверяют их. Роботы сканируют сначала главную страницу и материалы с высокой приоритетностью. Грамотная перелинковка направит роботов на нужные страницы и значительно ускорит индексацию новых материалов.

Главные рекомендации по перелинковке:

- Не делайте страницы с глубоким уровнем вложенности; идеальный вариант, это чтобы к любой странице сайта можно было добраться в 3 клика с главной страницы.

- Используйте принцип “Википедии” – активно ставьте ссылки внутри статей и других страниц.

- Избегайте одиноких страниц, на которые не ссылаются другие страницы.

Если кто-то ссылается на ваш сайт, значит ему доверяют. Чем больше внешних ссылок (бэклинков) на ваш сайт, тем больше вероятность получить внимание поискового бота. О том, как покупать ссылки для продвижения сайта, мы писали ранее. А если вы только разбираетесь в основах линкбилдинга, советуем почитать статью и посмотреть видео-урок, что такое линкбилдинг.

Чем больше внешних ссылок (бэклинков) на ваш сайт, тем больше вероятность получить внимание поискового бота. О том, как покупать ссылки для продвижения сайта, мы писали ранее. А если вы только разбираетесь в основах линкбилдинга, советуем почитать статью и посмотреть видео-урок, что такое линкбилдинг.

Чаще остальных ресурсов боты сканируют соцсети и новостные порталы, ведь они обновляются чуть ли не каждую секунду. Ссылки с них на ваш сайт сработают лучше всего.

Сайты с самой высокой скоростью сканирования ссылок:

- Twitter,

- Facebook,

- Вконтакте.

Яндекс больше любит связку ВК + Twitter. Попробуйте также размещать ссылки на тематических форумах. Чем больше пользователи будут взаимодействовать с постом со ссылкой и самой ссылкой, тем быстрее краулеры обратят на нее внимание.

Постоянно следите за тем, какие появляются внешние ссылки. Узнайте, как проверить обратные ссылки на сайт, как посмотреть внешние ссылки конкурента, какие есть бесплатные и платные сервисы.

Есть несколько способов проверить, как проверить индексацию сайта или отдельной страницы в поисковых системах.

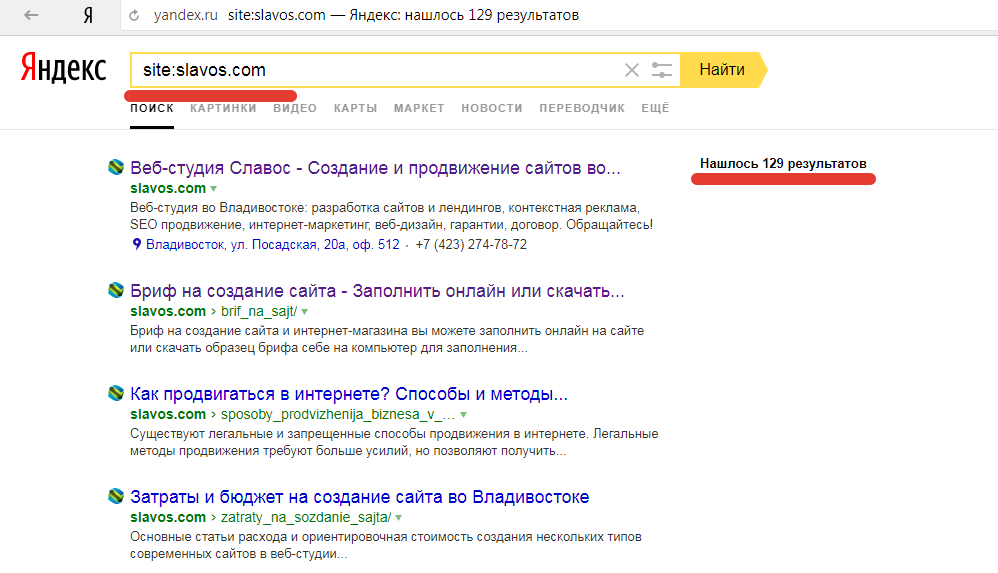

С помощью поисковых операторов можно проверить индексацию сайта, количество страниц в индексе, индексацию отдельной страницы. С помощью поисковых операторов можно проверить количество проиндексированных страниц любого сайта, что очень важно при анализе сайтов конкурентов.

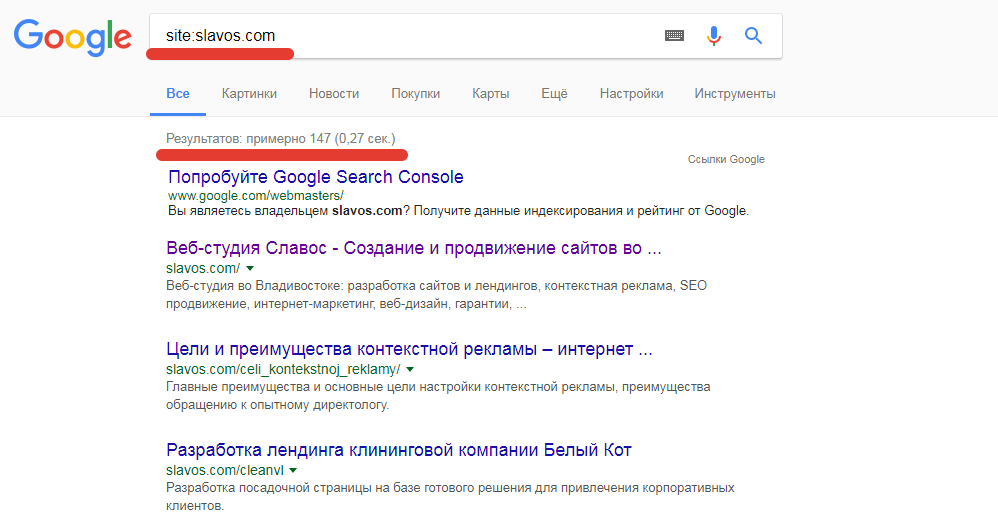

1. site: — оператор для проверки индексации сайта в поисковых системах Яндекс или Google. Введите в строку поиска текст «site:[адрес вашего сайта]«, чтобы узнать количество индексируемых страниц.

Количество проиндексированных страниц в Google

Количество проиндексированных страниц в Яндексе

Обратите внимание! Если количество проиндексированных страниц в поисковых системах Гугл и Яндекс сильно отличается, это может говорить о проблемах на сайте, о санкциях поисковых систем.

2. ulr: — оператор для проверки индексации страницы в поисковой системе Яндекс. Введите в строку поиска «ulr:[адрес проверяемой страницы]«, чтобы узнать, проиндексирована ли страница.

ulr: — оператор для проверки индексации страницы в поисковой системе Яндекс. Введите в строку поиска «ulr:[адрес проверяемой страницы]«, чтобы узнать, проиндексирована ли страница.

Проверяем индексацию страницы в Яндексе

3. inulr: — оператор для проверки индексации страницы в поисковой системе Google. Введите в строку поиска «inulr:[адрес проверяемой страницы]«, чтобы узнать, проиндексирована ли эта страница.

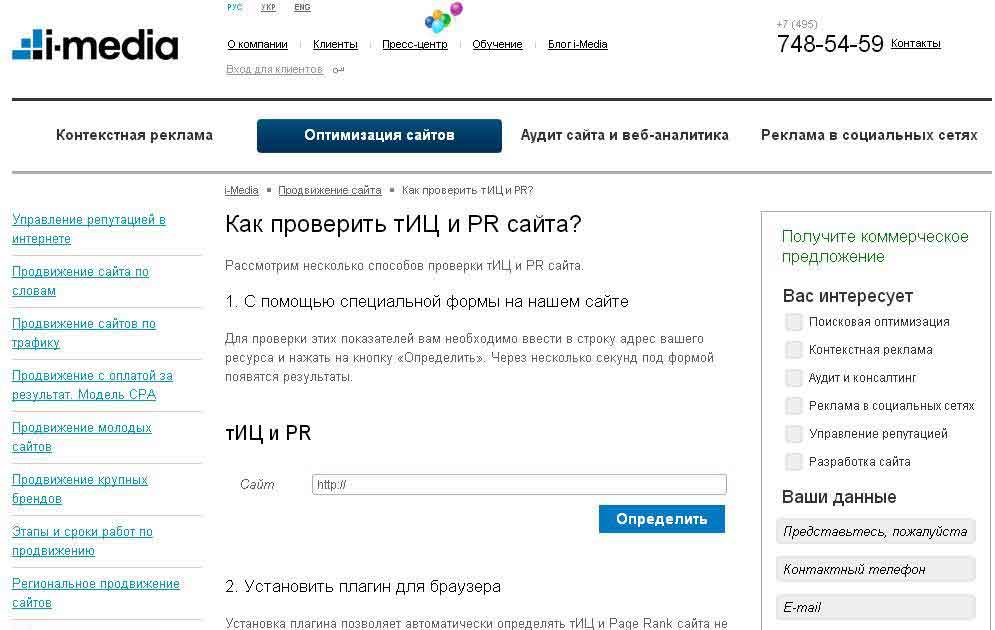

Многие SEO-специалисты пользуются плагинами и расширениями для проверки индексации, например RDS Bar. Его можно установить как расширение в браузер и проверить, открыта ли конкретная страница для индексации. Также RDS Bar позволяет проверить метатеги сайта, ИКС, узнать, нет ли запрета на индексацию текста или ссылок на странице, узнать другие важные параметры сайта или отдельных страниц.

На скриншоте — плагин RDS bar для Google Chrome

Второй популярный плагин — Seo Magic — также показывает количество страниц в индексе Яндекса и Google. При нажатии на интересующую цифру открывается выдача поисковой системы.

При нажатии на интересующую цифру открывается выдача поисковой системы.

Также популярны автоматические сервисы, которые массово собирают данные об индексации, такие как Netpeak Spider . Он может просканировать весь сайт, собрать все страницы. А Netpeak Checker выдаст сведения об индексации, информацию об ошибках и порекомендует, как от них избавиться. Софтина платная.

Бесплатный сервис PR-CY проверит, сколько страниц проиндексировано в посиковых системах Гугл и Яндекс.

Проверить индексацию страниц можно и в панелях вебмастеров Google и Яндекс.

Вы можете проверить:

- количество проиндексированных страниц;

- динику индексации страниц поисковыми страницами;

- страницы, которые исключены из поиска;

- причины, почему страницы исключены из поиска.

Для Google зайдите в Search Console и на вкладке «Обзор» выберете график «Покрытие». График отображает разными цветами количество страниц без ошибок, с ошибками. Можно рассмотреть, какие ошибки мешают индексации. Новую страницу или исправленную можно отправить на индексацию кнопкой «Запросить индексирование».

Можно рассмотреть, какие ошибки мешают индексации. Новую страницу или исправленную можно отправить на индексацию кнопкой «Запросить индексирование».

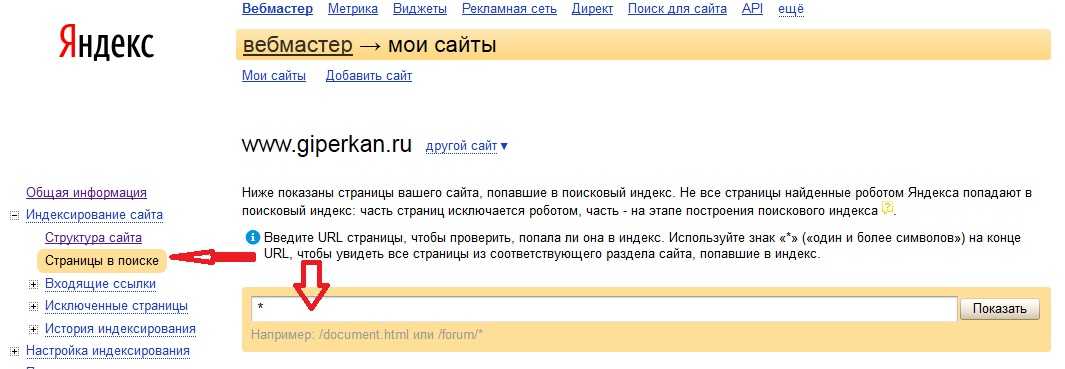

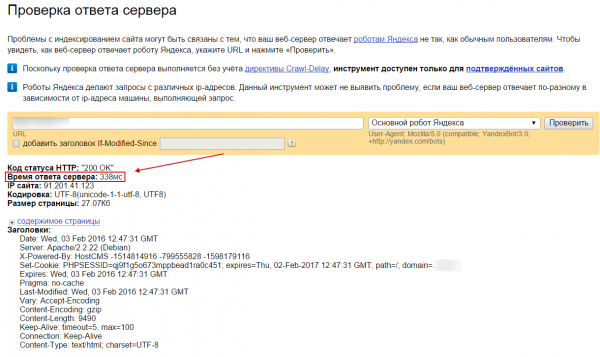

В Яндекс.Вебмастер переходите на «Индексирование сайта», затем на «Страницы в поиске», где вы увидите количество страниц в поиске.

Сайт или отдельные страницы могут не индексироваться поисковыми системами по ряду причин.

1. Поисковик еще не знает о сайте или странице. Прошло мало времени с момента появления страницы. Стоит подождать минимум две недели, чтобы сайт проиндексировался. Если сайт редко обновляется и на него нет внешних ссылок, поисковой бот просто не сможет узнать о нем.

2. Некоторые разделы закрыты для пауков. Это может происходить по желанию владельца сайта через robots.txt. Также возможно ваш сайт находится в черном списке – он может быть под санкциями или распространять вирусы.

3.

Техническая ошибка на странице или сайте. Возможные ошибки:

- некорректные HTTP-заголовки;

- некорректные редиректы;

- неверно указанная кодировка, которую робот увидит как набор бессмысленных символов;

- ошибки сканирования, на которые указывают сами поисковики в панелях для вебмастеров;

- отсутствие или некорректная настройка sitemap.xml.

4. Плохое качество документов. Неуникальный контент, внутренние дубли, малый объем уникального текста, шаблонность в документах раздела, медленная скорость загрузки.

Чтобы проиндексировать новую страницу сайта или отправить на переиндексацию страницу, которую вы изменили, воспользуйтесь инструментами вебмастера Search Console и Яндекс.Вебмастер.

1. В Google Search Console перейдите в раздел «Проверка URL».

2. Введите страницу, которую нужно проверить и отправить на переиндексацию.

3. Нажимайте на кнопку «Запросить индексирование».

Данный инструмент также подходит для проверки индексации страниц своего сайта.

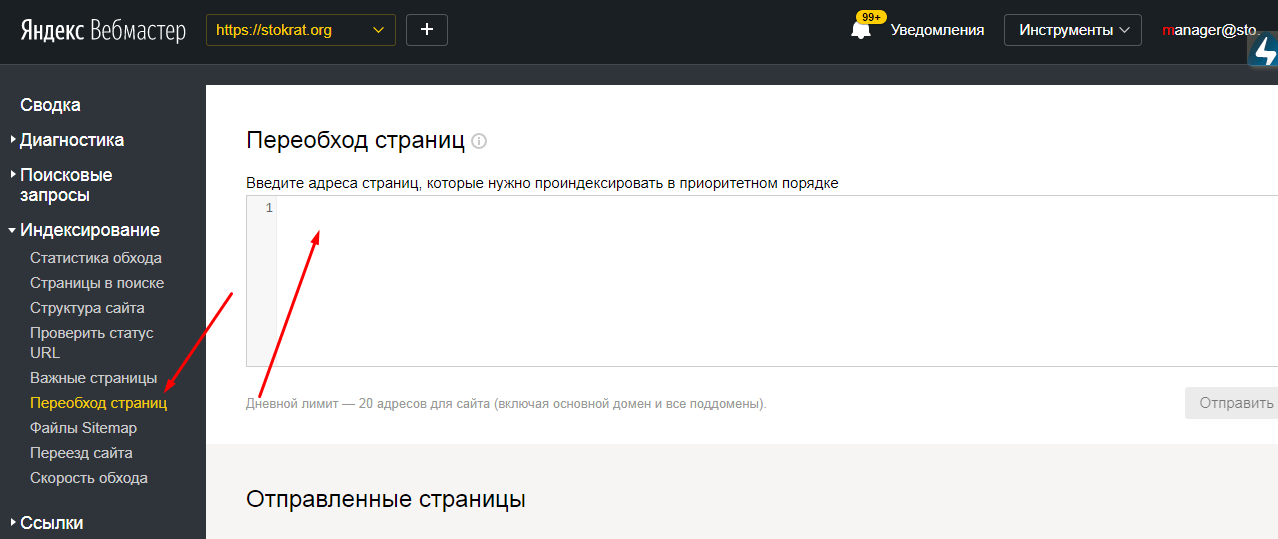

1. В Яндекс.Вебмастере перейдите в раздел Индексация -> Переобзод страниц

2. Добавите страницу, которую нужно проиндексировать.

3. Нажмите кнопку «Отправить».

Дневной лимит — 210 страниц (вкючая поддомены и поддомены).

Через файл robots.txt можно запретить индексацию страниц или всего сайта для конкретного поисковика или для всех сразу, используя директиву Disallow:

Если хотите закрыть конкретные разделы, укажите их:

Disallow: /news

Иногда Google игнорирует такой запрет, проверьте это через кабинет вебмастера. Если страницы все еще индексируются, переходите к следующему способу.

С помощью метатега Robots можно не дать роботам просканировать контент и закрыть текст от индексации. Для этого нужно в раздел <head> страницы добавить строку:

<noindex>[текст]</noindex>

Закрыть всю страницу от индексации можно, добавив строку

<meta name="robots" content="none"/>

Перед закрытием сайта от индексации желательно проверить методы в панелях вебмастеров.

Если вы понимаете принцип индексации и для чего она нужна, вы легко сможете правильно настроить сайт для поисковиков. Корректно настройте в robots.txt и карту сайта, избавьтесь от технических ошибок и позаботьтесь о качественном контенте, чтобы поисковики высоко ценили ваш сайт.

Остались вопросы? Задавайте их в комментариях😀

Как проверить индексацию сайта?

В этом выпуске вы узнаете, что такое индексация сайта, для чего нужно проверять индексацию сайта, на что надо обращать внимание при проверке индексации сайта.

Присоединяйтесь к нам:

► Наш Youtube канал: youtube.com

► Наша группа в VK: vk.com

► Наш сайт: webprodazhi

===========================

Содержание видео:

Как проверить индексацию сайта? Все ли страницы сайта добавлены в поисковые системы?

Что такое индексация сайта? Это добавление информации с Вашего сайта в поисковые системы для отображения в результатах поиска.

Нас интересуют — Гугл, Яндекс, Майл, Рамблер.

Статистика представлена по России за май 2018 года и взята с сайта liveinternet. Все ссылки будут в описании. Как же проверить индексацию сайта в каждой поисковой системе?

Для проверки в гугл добавляем сайт в Гугл Вебмастер, переходим в «Индекс Гугл», выбираем «Статус индексирования». Нажимаем кнопку «Расширенные данные» и обращаем внимание на показатели – Проиндексировано, Заблокировано, Удалено. Ниже смотрим список страниц сайта к каждому блоку. Что делать с полученными данными? Обсудим в конце ролика.

Для проверки в Яндексе добавляем сайт в Яндекс Вебмастер, переходим в «Индексирование», выбираем «Страницы в поиске». Нажимаем кнопку «История» и обращаем внимание на количественные показатели. Нажимаем кнопку «Исключенные» и здесь обращаем внимание на показатели – Дубль, Недостаточно качественная, Ошибка HTTP, Запрет в robots.txt.

Для проверки в Mail.ru добавляем сайт в Mail.ru Вебмастер, переходим в структуру сайта, где показаны загруженные страницы и разделы сайта. Обращаем внимание на Скачано, В индексе.

Обращаем внимание на Скачано, В индексе.

Для проверки в рамблер следим за индексацией сайта в Яндексе. Сейчас рамблер использует поисковую базу Яндекса.

Для каждой поисковой системы проанализируем полученные данные. Например, если на сайте 30 страниц, а в поисковой системе 22 страницы, из них в индексе 10 страниц, то нужно разобраться с вопросами:

Почему 8 страниц не проиндексировано?

По какой причине 12 страниц исключены из индекса? Причины могут быть разные, например, дубль, некачественный текст, ошибка ответа сервера, запрет на индексацию и т.д.

Все эти проблемы разберем в следующих видео.

После устранения всех проблем добиваемся ситуации, когда все 30 страниц находятся в индексе. Это идеальная ситуация, к ней надо стремиться.

===========================

Ссылки из видео:

https://www.liveinternet.ru/stat/ru/searches.html?period=month

https://www.google.com/webmasters/tools/

https://webmaster. yandex.ru/sites/

yandex.ru/sites/

https://webmaster.mail.ru

5 наиболее распространенных проблем индексации Google в зависимости от размера веб-сайта

Google не скрывает, что индексирует не все страницы, которые может найти. Используя консоль поиска Google, вы можете увидеть страницы вашего сайта, которые не проиндексированы.

Консоль поиска Google также предоставляет полезную информацию о конкретной проблеме, из-за которой страница не может быть проиндексирована.

К этим проблемам относятся ошибки сервера, ошибки 404 и намеки на то, что на странице может быть недостаточное или дублированное содержимое.

Но мы никогда не увидим данных, показывающих, какие проблемы наиболее распространены во всей сети.

Итак… Решил сам собрать данные и составить статистику!

В этой статье мы рассмотрим наиболее распространенные проблемы индексации, из-за которых ваши страницы не отображаются в поиске Google.

Индексирование 101

Индексирование похоже на создание библиотеки, за исключением того, что Google имеет дело не с книгами, а с веб-сайтами.

Если вы хотите, чтобы ваши страницы отображались в поиске, они должны быть должным образом проиндексированы. Проще говоря, Google должен найти их и сохранить.

Затем Google может проанализировать их содержание, чтобы решить, для каких запросов они могут быть актуальны.

Индексирование является необходимым условием для получения органического трафика от Google. Чем больше страниц вашего сайта индексируется, тем больше у вас шансов появиться в результатах поиска.

Вот почему вам очень важно знать, может ли Google индексировать ваш контент.

Вот что я сделал для выявления проблем с индексированием

Мои повседневные задачи включают оптимизацию веб-сайтов с технической точки зрения SEO, чтобы сделать их более заметными в Google, и в результате у меня есть доступ к нескольким десяткам сайтов в поиске Google. Консоль.

Я решил использовать это, чтобы, надеюсь, сделать популярные проблемы с индексацией… ну, менее популярными.

Для прозрачности я разбил методологию, которая привела меня к некоторым интересным выводам.

Методология

Я начал с создания выборки страниц, объединив данные из двух источников:

- Я использовал данные наших клиентов, которые были мне легко доступны.

- Я попросил других специалистов по поисковой оптимизации поделиться со мной анонимными данными, опубликовав опрос в Твиттере и связавшись напрямую с некоторыми оптимизаторами.

оптимизаторов, мне нужно 3-10 минут вашего времени.

Можете ли вы помочь мне с исследованием индексации и поделиться со мной некоторыми неконфиденциальными статистическими данными GSC?

Когда я найду интересные идеи, я опубликую об этом статью.Заранее спасибо! Пожалуйста, R/T

🙏🙏 https://t.co/vAwMulQtsx

— Томек Рудзки (@TomekRudzki) 9 ноября 2020 г.

Оба источника информации оказались полезными.

За исключением неиндексируемых страниц

В ваших интересах не индексировать некоторые страницы. К ним относятся старые URL-адреса, статьи, которые больше не актуальны, параметры фильтрации в электронной торговле и многое другое.

К ним относятся старые URL-адреса, статьи, которые больше не актуальны, параметры фильтрации в электронной торговле и многое другое.

Веб-мастера могут убедиться, что Google их игнорирует несколькими способами, включая файл robots.txt и тег noindex.

Принятие во внимание таких страниц отрицательно повлияет на качество моих выводов, поэтому я удалил из выборки страницы, соответствующие любому из следующих критериев:

- Заблокирован файлом robots.txt.

- Помечен как noindex.

- Перенаправлено.

- Возврат кода состояния HTTP 404.

Исключение неценных страниц

Чтобы еще больше повысить качество моего образца, я рассмотрел только те страницы, которые включены в карты сайта.

Исходя из моего опыта, карты сайта являются наиболее четким представлением ценных URL-адресов с данного веб-сайта.

Конечно, есть много веб-сайтов, которые содержат мусор в своих картах сайта. Некоторые даже включают одни и те же URL-адреса в свои карты сайта и файлы robots. txt.

txt.

Но я позаботился об этом на предыдущем шаге.

Категоризация данных

Я обнаружил, что популярные проблемы с индексацией зависят от размера веб-сайта.

Вот как я разделил данные:

- Небольшие веб-сайты (до 10 тыс. страниц).

- Средние сайты (от 10к до 100к страниц).

- Крупные сайты (до миллиона страниц).

- Огромных сайтов (более 1 миллиона страниц).

Из-за различий в размерах сайтов в моей выборке мне пришлось найти способ нормализовать данные.

Один очень большой веб-сайт, борющийся с определенной проблемой, может перевесить проблемы, которые могут возникнуть на других, более мелких веб-сайтах.

Поэтому я просмотрел каждый веб-сайт в отдельности, чтобы разобраться с проблемами индексации, с которыми они сталкиваются. Затем я присвоил баллы проблемам индексации в зависимости от количества страниц, затронутых данной проблемой на данном веб-сайте.

Вердикт…

Вот пять основных проблем, которые я нашел на веб-сайтах всех размеров.

- Просканировано — в настоящее время не проиндексировано (проблема качества).

- Дублированный контент.

- Обнаружено — в настоящее время не проиндексировано (проблема с бюджетом сканирования/качеством).

- Мягкий 404.

- Проблема со сканированием.

Давайте разберем их.

Качество

Проблемы с качеством включают в себя недостаточное содержание ваших страниц, вводящие в заблуждение или чрезмерно предвзятые.

Если на вашей странице нет уникального ценного контента, который Google хочет показать пользователям, вам будет трудно его проиндексировать (и не стоит удивляться).

Дублированный контент

Google может распознать некоторые из ваших страниц как дублированный контент, даже если вы этого не хотели.

Распространенной проблемой являются канонические теги, указывающие на разные страницы. В результате исходная страница не индексируется.

Если у вас есть дублированный контент, используйте атрибут канонического тега или перенаправление 301.

Это поможет вам убедиться, что одни и те же страницы вашего сайта не конкурируют друг с другом за просмотры, клики и ссылки.

Бюджет сканирования

Что такое бюджет сканирования? В зависимости от нескольких факторов робот Googlebot будет сканировать только определенное количество URL-адресов на каждом веб-сайте.

Это означает, что оптимизация жизненно важна; не позволяйте ему тратить свое время на страницы, которые вам не нужны.

Soft 404s

404 ошибки означают, что вы отправили на индексацию удаленную или несуществующую страницу. Мягкие 404 отображают информацию «не найдено», но не возвращают серверу код состояния HTTP 404.

Распространенной ошибкой является перенаправление удаленных страниц на другие, нерелевантные.

Множественные перенаправления также могут отображаться как программные ошибки 404. Стремитесь максимально сократить цепочки переадресации.

Проблема со сканированием

Существует много проблем со сканированием, но важной из них является проблема с robots. txt. Если робот Googlebot найдет файл robots.txt для вашего сайта, но не сможет получить к нему доступ, он вообще не будет сканировать сайт.

txt. Если робот Googlebot найдет файл robots.txt для вашего сайта, но не сможет получить к нему доступ, он вообще не будет сканировать сайт.

Наконец, давайте посмотрим на результаты для разных размеров сайтов.

Небольшие веб-сайты

Размер выборки: 44 сайта

- Просканировано, в настоящее время не проиндексировано (проблема с качеством или краулинговым бюджетом).

- Дублированный контент.

- Проблема с бюджетом сканирования.

- Мягкий 404.

- Проблема со сканированием.

Средние веб-сайты

Размер выборки: 8 сайтов

- Дублированный контент.

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- soft 404 (проблема качества).

- Проблема со сканированием.

Крупные веб-сайты

Размер выборки: 9 сайтов

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Дублированный контент.

- Мягкий 404.

- Проблема со сканированием.

Крупные веб-сайты

Размер выборки: 9 сайтов

- Просканировано, в настоящее время не проиндексировано (проблема качества).

- Обнаружен, в настоящее время не проиндексирован (проблемы с бюджетом сканирования/качеством).

- Дублированный контент (дублированный, отправленный URL-адрес не выбран в качестве канонического).

- Мягкий 404.

- Проблема со сканированием.

Основные выводы по общим проблемам индексации

Интересно, что, согласно этим выводам, два размера веб-сайтов страдают от одних и тех же проблем. Это показывает, насколько сложно поддерживать качество в случае больших веб-сайтов.

- Больше 100 тыс., но меньше 1 миллиона.

- Более 1 миллиона.

Выводы, однако, таковы:

- Даже относительно небольшие веб-сайты (более 10 000) могут быть не полностью проиндексированы из-за недостаточного краулингового бюджета.

- Чем больше веб-сайт, тем острее становятся проблемы с бюджетом/качеством сканирования.

- Проблема с дублированием содержимого является серьезной, но ее характер меняется в зависимости от веб-сайта.

П.С. Примечание о неизвестных URL-адресах для Google

Во время моего исследования я понял, что есть еще одна распространенная проблема, которая препятствует индексации страниц.

Возможно, он не заслужил своего места в приведенном выше рейтинге, но по-прежнему важен, и я был удивлен, увидев, что он по-прежнему так популярен.

Я говорю о страницах-сиротах.

Некоторые страницы вашего веб-сайта могут не иметь внутренних ссылок, ведущих на них.

Если робот Googlebot не может найти страницу на вашем веб-сайте, он может вообще ее не найти.

Какое решение? Добавьте ссылки со связанных страниц.

Вы также можете исправить это вручную, добавив потерянную страницу в карту сайта. К сожалению, многие веб-мастера до сих пор пренебрегают этим.

Дополнительные ресурсы:

- 11 SEO-советов и рекомендаций по улучшению индексации

- GoogleBot не индексирует нужные страницы? Google предлагает 5 способов исправить ошибку

- Продвинутое техническое SEO: полное руководство

Категория SEO

Консоль поиска Google: как исправить проблемы «В настоящее время не проиндексированы»

Вы когда-нибудь просматривали отчет консоли поиска Google и задавались вопросом, почему Google просканировал ваш сайт, но не проиндексировал определенные страницы?

Что такое ошибки индексации в Google?Нажав Узнать больше в отчете о покрытии, вы найдете объяснения ошибок индексации Google в справочном документе GSC:

- Просканировано – в настоящее время не проиндексировано не индексируется. Google также заявляет, что нет необходимости повторно отправлять URL-адреса, поскольку они могут быть проиндексированы в будущем.

- Обнаружено – в настоящее время не проиндексировано: Google присваивает эту категорию URL-адресам, которые еще не просканированы (но будут просканированы позже), вероятно, потому, что это может привести к перегрузке сайта во время последнего сканирования. Таким образом, дата последнего сканирования отсутствует в отчете для этих URL-адресов.

Отчет GSC о покрытии: проблемы с индексацией (и сколько ваших страниц они затронуты)

Совет для профессионалов: Учитывая приведенные выше статусы, нет необходимости вручную запрашивать повторную индексацию страницы, поскольку Google утверждает, что в конечном итоге он будет переоценен.

Как исправить ошибки индексации?Вот что думает Джон Мюллер:

Помимо справочного документа GSC, мы также можем раскрыть подсказки от старшего аналитика тенденций Google для веб-мастеров Джона Мюллера, который делится в Интернете своими ответами на часто задаваемые вопросы о Google SEO.

Отвечая на вопрос о том, что делать со статусом Обнаружено — в настоящее время не проиндексировано во время видеовстречи в Центре веб-мастеров Google в рабочее время, Джон заявил, что наиболее вероятной причиной того, что Google не сканирует или не индексирует веб-страницу, может быть одна из следующих:

- Веб-страница автоматически генерирует слишком много вариантов URL.

- Веб-страница имеет плохую структуру внутренних ссылок.

С этой целью он советует свести количество веб-страниц к минимуму (то есть качество важнее количества), чтобы улучшить общее качество сайта.

Что касается Crawled — в настоящее время не проиндексированной проблемы , Джон сказал, что для Google нормально не индексировать все веб-страницы на веб-сайте, сославшись на то, что невозможно заставить поисковый робот Google проиндексировать конкретную страницу.

Если на веб-странице есть эта проблема, скорее всего, это проблема всего сайта, а не отдельная проблема этой страницы, поэтому крайне важно оптимизировать структуру сайта и обеспечить его высочайшее качество.

Для всех URL-адресов с ошибками Google четко указывает, что необходимо исправить, и помогает повторно проверить ту же проблему после ее устранения.

В ожидании повторной проверки Google вот три обязательных действия, которые необходимо выполнить, чтобы проверить индексацию вашего сайта, прежде чем оценивать наилучший подход к решению ваших проблем с индексацией — или нужно ли вам их решать вообще.

Проанализируйте уязвимые URL-адреса

Как сказал Джон Мюллер, Google обычно не индексирует некоторые из ваших веб-страниц, поскольку его алгоритм обслуживает только наиболее релевантные результаты на странице результатов поисковой системы (SERP).

Таким образом, статус , не проиндексированный в настоящее время , не требует ваших немедленных действий, если только он не затрагивает страницы, которые считаются наиболее важными для вашего бизнеса, например целевую страницу регистрации, предназначенную для конверсии клиентов.

Чтобы решить, какие действия предпринять, вы можете экспортировать список уязвимых URL-адресов из GSC и установить приоритет для тех, которые вы хотите проиндексировать в Google. Классифицируя затронутые URL-адреса, вы также можете выявить закономерности того, где возникает проблема индексации на вашем сайте, и какие типы веб-страниц — например, URL-адреса блогов — обычно не индексируются.

Проверить, является ли ошибка индексирования допустимой.

Далее, вы должны всегда выполнять проверку статуса индекса для своих URL-адресов, поскольку URL-адреса, отмеченные Google как , исключены из , в конце концов, часто могут оказаться в его индексе.

Примечание . Статус исключено относится к страницам, которые либо являются дубликатами проиндексированных страниц, либо заблокированы от индексации каким-либо механизмом на вашем сайте.

Вы можете использовать оператор поиска по сайту Google, чтобы проверить, какие из ваших URL-адресов отображаются в его поисковой выдаче, а затем отфильтровать их по тому, были ли они проиндексированы или нет.

Проведите живое тестирование URL-адресов

Чтобы убедиться, что Google проиндексирует ваши высокоприоритетные URL-адреса в следующий раз при их сканировании, вам также следует провести живое тестирование URL-адресов в инструменте проверки URL-адресов Google, чтобы убедиться, что Google может индексировать ваши страницы без каких-либо проблем со сканированием.

Инструмент Google для проверки URL-адресов, проверяющий индексируемость URL-адреса

Как вы решаете C в настоящее время не проиндексированные проблемы?Увеличение внутренних ссылок

Плохая структура ссылок затрудняет обнаружение Google ваших веб-страниц, которые необходимо просканировать. Таким образом, для высокоприоритетных страниц, которые вы хотите, чтобы Google сканировал, вы можете добавить больше внутренних ссылок со страниц, которые находятся выше в архитектуре вашего сайта.

Увеличение количества внутренних ссылок, ведущих на веб-страницу, помогает по двум причинам:

- Большее количество внутренних ссылок, ведущих на веб-страницу, означает, что сканерам поисковых систем будет легче найти страницу.

- Больше внутренних ссылок, ведущих на веб-страницу, свидетельствует о важности этой страницы для Google.

Улучшение качества контента

Решение Google не индексировать страницу также может свидетельствовать о том, что ее содержание не соответствует стандартам качества Google. Следовательно, вы должны создавать уникальный контент с релевантными, высокоэффективными ключевыми словами, чтобы увеличить шансы вашей веб-страницы на индексацию.

Вот несколько важных советов по оптимизации вашего контента:

- Создавайте оригинальный контент, уникальный для вашего бренда, нацеленный на высокоэффективные ключевые слова.

- Добавьте больше контекста, чтобы избежать неполноценного контента, который может повредить вашему рейтингу.

- Выделиться в поисковой выдаче, предоставляя контент, который более ценен для пользователей, чем то, что могут предоставить ваши конкуренты в поисковой выдаче.

- Поймите, кто ваши посетители, и удовлетворите их поисковые запросы.

Выполнение обрезки контента

При запуске нового веб-сайта или проведении модернизации сайта вы можете обнаружить, что некоторые URL-адреса попадают в Discover — в настоящее время не проиндексированы 9Категория 0304 из-за перегрузки контента. Это означает, что ваш веб-сайт содержит гораздо больше контента, чем Google готов выделить для сканирования.

Перегрузка контента может произойти, когда сайт случайно автоматически генерирует много URL-адресов или имеет слишком много индексированных страниц с небольшой SEO-ценностью, таких как теги и страницы категорий.

Вот несколько способов решения проблемы перегрузки содержимым:

- Использование канонических тегов для объединения сигналов ранжирования и указания Google, какой URL-адрес представляет собой основную копию страницы.

- Обновите файл robots.txt, чтобы Google не сканировал низкоприоритетные страницы, по которым вы не хотите ранжироваться.

- Объединяйте и перепрофилируйте короткие статьи с похожим содержанием и темами в развернутые материалы.

Вебмастер

Вебмастер