Скопировать любой сайт с помощью Httrack website copier

- Post author:wmadmin

- Запись опубликована:06.10.2022

- Post category:Рубрика для вебмастеров

Занимаясь различными способами заработка в интернете, например, арбитражем трафика, нередко требуется скопировать одностраничные сайты. Зачем создавать лендинги, когда их можно позаимствовать? Сделать это не сложно, тем более уже созданы специальные программы для этого.

Как скопировать любой сайт? Сначала нужно скачать его на компьютер, а потом перенести на хостинг, предварительно внеся изменения (например, изменив ссылки). Всего несколько минут уходит на это, если использовать Httrack website copier. Это бесплатная утилита, у которой есть русская версия.

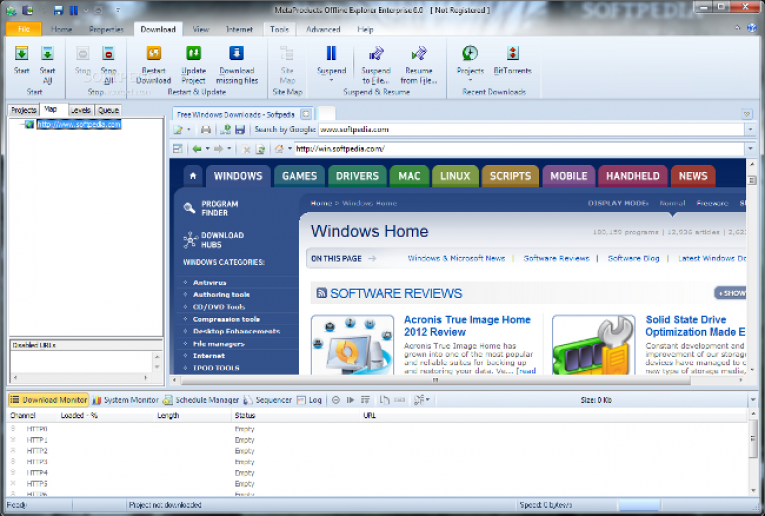

У Httrack website copier есть много аналогов, в большинстве своем они платные (например, Offline Explorer). Платить не надо, функционала этой программы хватает. Скачивайте её с официального сайта (httrack), учитывая версию своей операционной системы.

Платить не надо, функционала этой программы хватает. Скачивайте её с официального сайта (httrack), учитывая версию своей операционной системы.

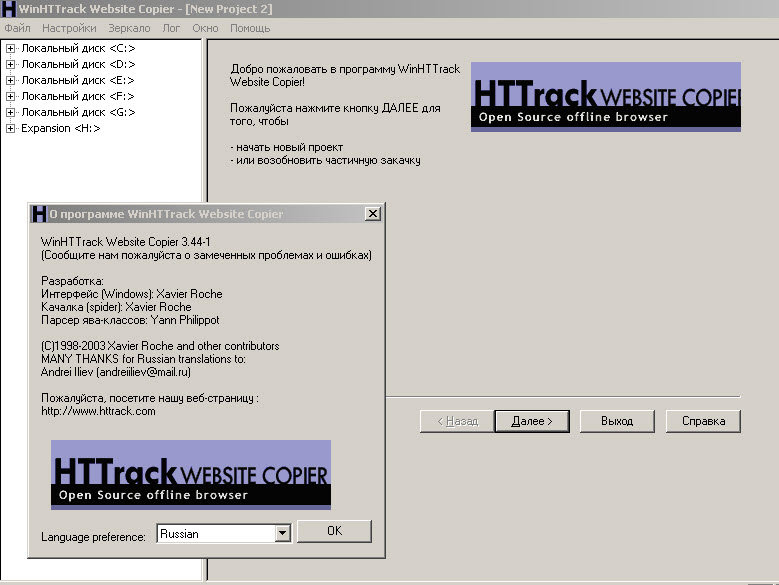

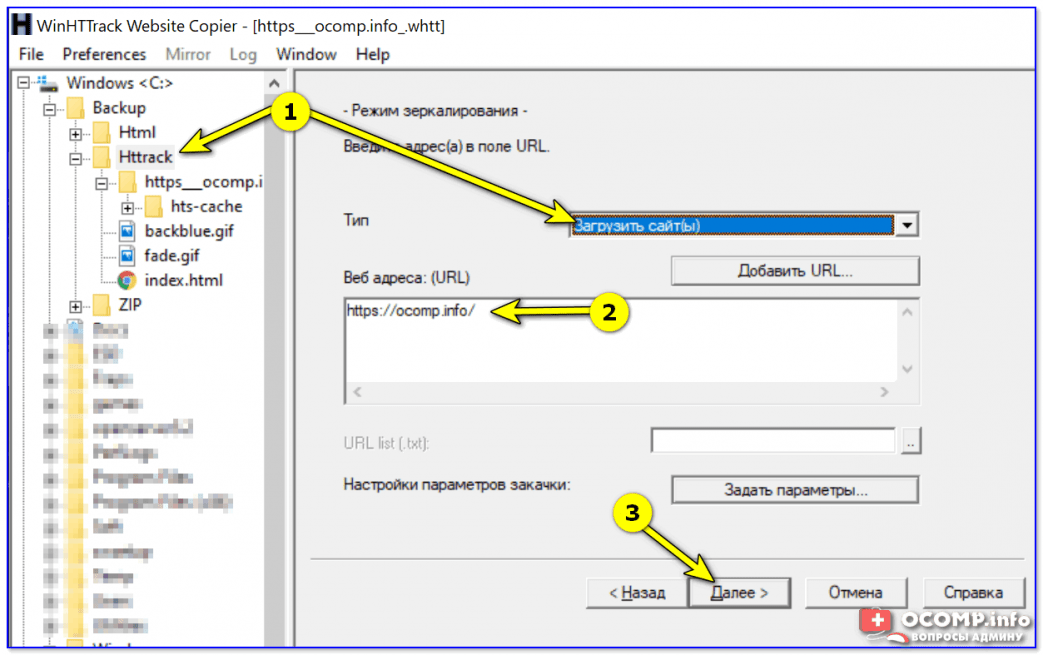

Устанавливается она как любая другая программа, а после запуска нужно проделать следующие действия:

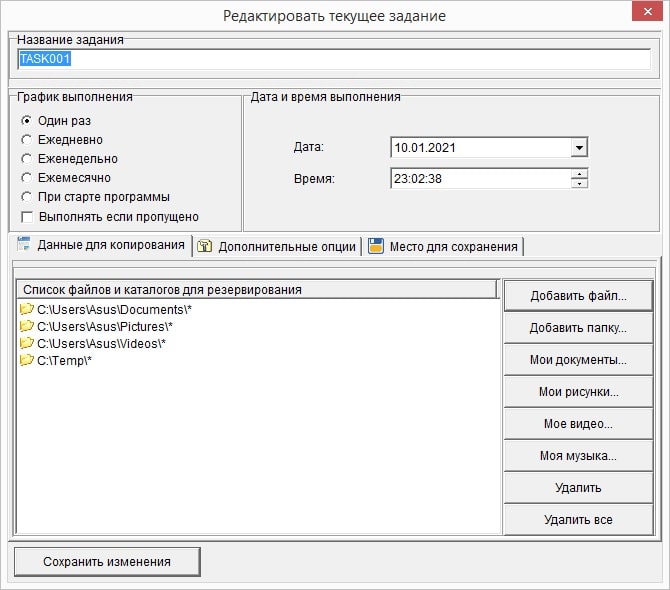

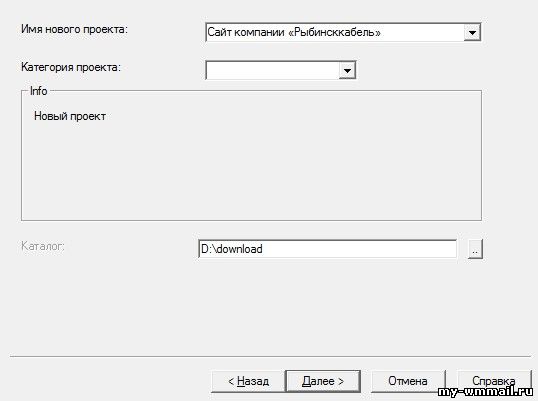

- Создавайте новый проект, имя указывайте произвольное. Категорию можно оставить пустой. Выбирайте папку, куда сохранятся данные и жмите далее:

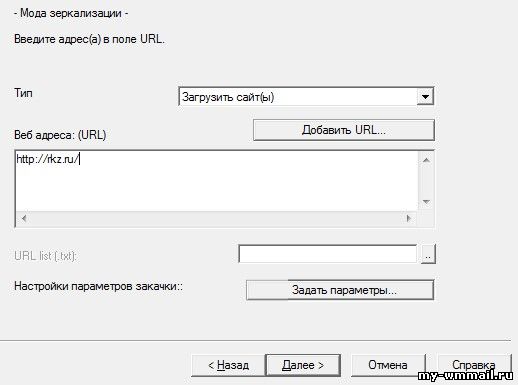

- Дальше выбираете тип операции, оставляйте без изменения загрузку сайта и прописывайте адрес ресурса:

- На предыдущем шаге, перед нажатием Далее, необходимо открыть Задать параметры. Там открывайте вкладку с фильтрами, чтобы избавиться от весомых и ненужных файлов:

- Также зайдите на вкладку с ограничениями, чтобы указать, насколько далеко от указанной страницы нужно загружать сайт. Если это одностраничный сайт, настройки не трогайте:

- Если хотите, чтобы сайт загрузился максимально быстро, установите флажки на вкладке Линки, как это показано на изображении:

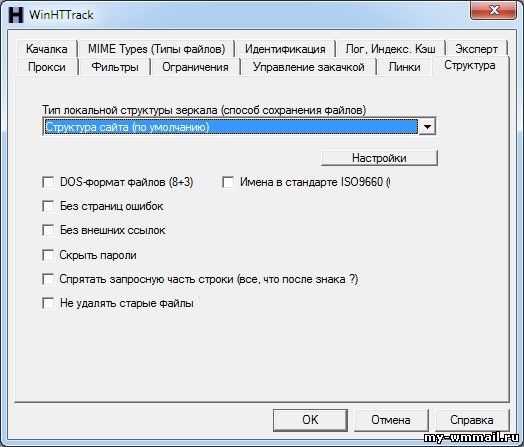

- Последняя дополнительная настройка это выбор способа сохранения файлов.

Выбирайте структуру сайта на вкладке Структура:

Выбирайте структуру сайта на вкладке Структура: - Когда все параметры настроены, можно жать кнопку ОК и возвращаться к продолжению загрузки. Всё, что остается сделать, это оставить галочку на первом пункте и нажать Готово:

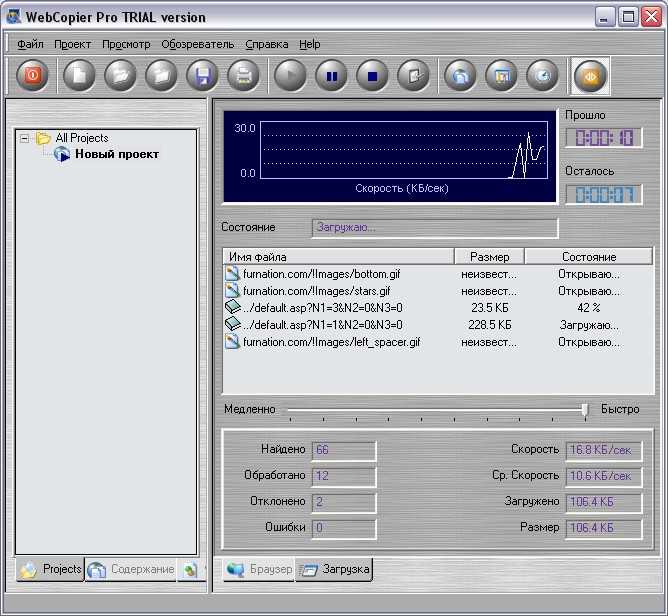

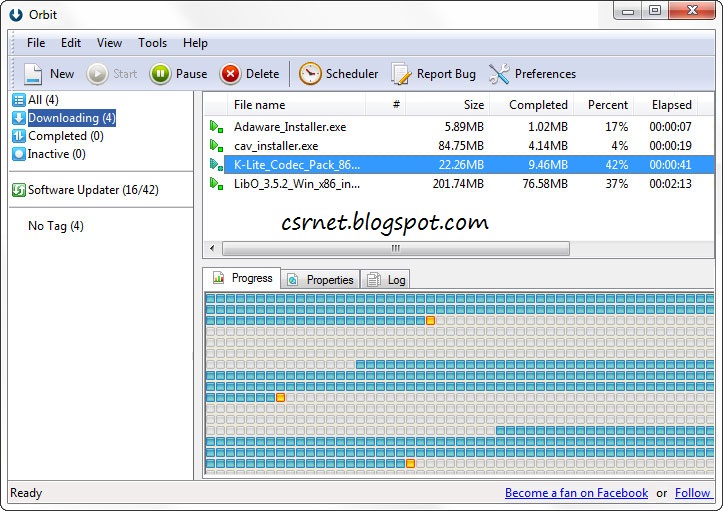

- Начнется процедура загрузки файлов, нужно дождаться, пока она закончится. Время зависит от объема данных:

- Теперь на вашем компьютере появится папка, в которой сохранены все данные копируемого сайта. Можете зайти в неё и открыть файл HTML в браузере, чтобы проверить, всё ли правильно отображается:

Последний шаг копирования сайта, это его перенос на хостинг. Там всё просто, копируете данные и привязываете заранее арендованный домен. Всё, можно ввести адрес сайта и проверить, всё ли получилось.

Программа Httrack website copier помогает, как сохранить страницу сайта, так и загрузить его полностью. С помощью этой простой утилиты, можно использовать любые красивые одностраничники и повышать конверсию, только не забывайте вносить изменения в код, как минимум, редактируя внешние ссылки.

Читайте другие статьи:

- Как защитить контент от копирования?

- Dynamicdrive – лучшая защита сайта

- Как заработать на информации?

Поделиться:

Новинки IT-индустрии, обзоры и тесты компьютеров и комплектующих

- ПК и комплектующие

- Настольные ПК и моноблоки

- Портативные ПК

- Серверы

- Материнские платы

- Корпуса

- Блоки питания

- Оперативная память

- Процессоры

- Графические адаптеры

- Жесткие диски и SSD

- Оптические приводы и носители

- Звуковые карты

- ТВ-тюнеры

- Контроллеры

- Системы охлаждения ПК

- Моддинг

- Аксессуары для ноутбуков

- Периферия

- Принтеры, сканеры, МФУ

- Мониторы и проекторы

- Устройства ввода

- Внешние накопители

- Акустические системы, гарнитуры, наушники

- ИБП

- Веб-камеры

- KVM-оборудование

- Цифровой дом

- Сетевые медиаплееры

- HTPC и мини-компьютеры

- ТВ и системы домашнего кинотеатра

- Технология DLNA

- Средства управления домашней техникой

- Гаджеты

- Планшеты

- Смартфоны

- Электронные ридеры

- Портативные медиаплееры

- GPS-навигаторы и трекеры

- Носимые гаджеты

- Автомобильные информационно-развлекательные системы

- Зарядные устройства

- Аксессуары для мобильных устройств

- Фото и видео

- Цифровые фотоаппараты и оптика

- Видеокамеры

- Фотоаксессуары

- Обработка фотографий

- Монтаж видео

- Программы и утилиты

- Операционные системы

- Средства разработки

- Офисные программы

- Средства тестирования, мониторинга и диагностики

- Полезные утилиты

- Графические редакторы

- Средства 3D-моделирования

- Мир интернет

- Веб-браузеры

- Поисковые системы

- Социальные сети

- «Облачные» сервисы

- Сервисы для обмена сообщениями и конференц-связи

- Разработка веб-сайтов

- Мобильный интернет

- Полезные инструменты

- Безопасность

- Средства защиты от вредоносного ПО

- Средства управления доступом

- Защита данных

- Сети и телекоммуникации

- Проводные сети

- Беспроводные сети

- Сетевая инфраструктура

- Сотовая связь

- IP-телефония

- NAS-накопители

- Средства управления сетями

- Средства удаленного доступа

- Корпоративные решения

- Системная интеграция

- Проекты в области образования

- Электронный документооборот

- «Облачные» сервисы для бизнеса

- Технологии виртуализации

Наш канал на Youtube

Архив изданий

| 1999 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | |

| 2000 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2001 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2002 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2003 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2004 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2005 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2006 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2007 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2008 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2009 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2010 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 2011 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | |

| 2013 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

- О нас

- Размещение рекламы

- Контакты

Популярные статьи

Моноблок HP 205 G4 22 AiO — одно из лучших решений для офисной и удаленной работы

В настоящем обзоре мы рассмотрим модель моноблока от компании HP, которая является признанным лидером в производстве компьютеров как для домашнего использования, так и для офисов.

Logitech G PRO X Superlight — легкая беспроводная мышь для профессиональных киберспортсменов

Швейцарская компания Logitech G представила беспроводную игровую мышь Logitech G PRO X Superlight. Новинка предназначена для профессиональных киберспортсменов, а слово Superlight в ее названии указывает на малый вес этой модели, который не превышает 63 г. Это почти на четверть меньше по сравнению с анонсированным пару лет тому назад манипулятором Logitech G PRO Wireless

Материнская плата для домашнего майнинга ASRock h210 Pro BTC+

Как показало недавнее исследование Кембриджского университета — количество людей, которые пользуются сегодня криптовалютами, приближается к размеру населения небольшой страны и это только начало, мир меняется. Поэтому компания ASRock разработала и выпустила в продажу весьма необычную материнскую плату — h210 PRO BTC+, которую мы и рассмотрим в этом обзоре

Верхняя панель клавиатуры Rapoo Ralemo Pre 5 Fabric Edition обтянута тканью

Компания Rapoo анонсировала в Китае беспроводную клавиатуру Ralemo Pre 5 Fabric Edition. Новинка выполнена в формате TKL (без секции цифровых клавиш) и привлекает внимание оригинальным дизайном. Одна из отличительных особенностей этой модели — верхняя панель, обтянутая тканью с меланжевым рисунком

Новинка выполнена в формате TKL (без секции цифровых клавиш) и привлекает внимание оригинальным дизайном. Одна из отличительных особенностей этой модели — верхняя панель, обтянутая тканью с меланжевым рисунком

Изогнутый экран монитора MSI Optix MAG301 CR2 обеспечит максимальное погружение в игру

Линейку компьютерных мониторов MSI пополнила модель Optix MAG301 CR2, адресованная любителям игр. Она оборудована ЖК-панелью типа VA со сверхширокоформатным (21:9) экраном изогнутой формы (радиус закругления — 1,5 м). Его размер — 29,5 дюйма по диагонали, разрешение — 2560×1080 пикселов

Комплект SilverStone MS12 позволяет превратить SSD типоразмера M.2 2280 в портативный накопитель

Каталог продукции компании SilverStone пополнил комплект MS12. Он позволяет создать портативный накопитель на базе стандартного SSD типоразмера M.2 2280 с интерфейсом PCI Express

SSD-накопители ADATA XPG Spectrix S20G сочетают производительность с эффектным дизайном

Компания ADATA Technology анонсировала твердотельные накопители серии XPG Spectrix S20G. Они предназначены для оснащения игровых ПК и, как утверждают их создатели, сочетают высокую производительность и эффектный внешний вид

Они предназначены для оснащения игровых ПК и, как утверждают их создатели, сочетают высокую производительность и эффектный внешний вид

Видеокарта ASUS GeForce RTX 3070 Turbo оснащена системой охлаждения с одним центробежным вентилятором

Линейку видеоадаптеров ASUS на базе графических процессоров NVIDIA пополнила модель GeForce RTX 3070 Turbo (заводской индекс TURBO-RTX3070-8G), предназначенная для оснащения игровых ПК. Одной из особенностей новинки является конструкция системы охлаждения

КомпьютерПресс использует

13 лучших загрузчиков веб-сайтов для просмотра в автономном режиме🤴

Загрузчик веб-сайтов — это ваш лучший вариант для клонирования всего веб-сайта самым простым и быстрым способом. Есть несколько преимуществ использования загрузчика. Это программное обеспечение может помочь вам следующим образом:

1. Вы можете легко просматривать и читать сайты с большим количеством маленьких страниц, которые в противном случае могут быть затруднены из-за медленного соединения.

2. Также иногда люди влюбляются в шаблон популярного веб-сайта и хотят использовать его в качестве справочного сайта для создания своего собственного портала.

Для этого разработчикам веб-сайтов требуется такое программное обеспечение для круглосуточного доступа к данным. Таким образом, тестировщики и разработчики могут сделать копию вашего сайта на локальном сервере, чтобы проанализировать или изменить его, не вмешиваясь в реальный сайт.

3. Через некоторое время некоторые веб-сайты перестают быть доступны онлайн. Вы, очевидно, не сможете снова получить важную информацию с этого сайта. Так что лучше скачать их для оффлайн просмотра.

Итак, какой бы ни была ваша причина, загрузчик веб-сайта необходим для всех, кому необходимо архивировать сайт. С помощью этого программного обеспечения вы можете загрузить целый веб-сайт для просмотра в автономном режиме в любое удобное для вас время.

Лучшие инструменты для загрузки веб-сайтов: наш лучший выбор 👌 Вот список лучших программ для загрузки всех данных веб-сайтов для просмотра в автономном режиме.

HTTrack является одним из самых надежных веб-сайтов, загружающих программное обеспечение для тех, кто ищет бесплатный вариант. Программное обеспечение имеет гладкий пользовательский интерфейс.

Вы можете легко загрузить программное обеспечение и сохранить его в своем локальном каталоге. Он будет получать HTML, графику и другие файлы прямо с сервера на ПК и периодически собирать все каталоги.

Загрузчик имеет простой процесс. Вы должны ввести URL-адрес сайта и нажать кнопку «Далее»; процесс имитации начнется мгновенно. Однако загрузка завершится через несколько минут, часов или дней, в зависимости от размера загружаемого сайта.

Способен построить соответствующую ссылочную структуру оригинального сайта. В браузере вы можете запустить любую страницу по вашему выбору с зеркального веб-сайта, и вы готовы просматривать данные ссылки на ссылку точно так же, как вы видите их в Интернете.

Еще одна особенность этого программного обеспечения заключается в том, что приостановленные сайты могут перезапускаться, и оно даже начинает обновлять уже существующий зеркальный сайт.

- Программное обеспечение предлагает встроенные руководства, помогающие пользователям в случае необходимости.

- Он также поставляется с возможностью настройки.

- Может получить ссылочную структуру исходного сайта.

- Это программное обеспечение совместимо со многими версиями Windows, например, с Windows 2000 по Windows 10.

- Имеет длительный процесс загрузки.

- Программное обеспечение не подходит для PHP-сайтов.

HakTip — зеркало веб-сайтов с помощью HTTrack

Посмотрите это видео на YouTube

Macintosh представляет вам приложение SiteSucker , которое автоматически загружает сайты из браузера.

Этот сайт работает путем асинхронной репликации изображений, веб-страниц, таблиц стилей, PDF-файлов и других файлов сайта на локальный жесткий диск. Короче говоря, он копирует структуру каталогов веб-сайта.

Короче говоря, он копирует структуру каталогов веб-сайта.

Программа проста в использовании. Вам просто нужно вставить URL-адрес сайта, который вы хотите воспроизвести, и нажать клавишу возврата. SiteSucker начнет загружать для вас весь сайт.

Этот загрузчик сайтов также используется для создания локальных копий любого сайта.

SiteSucker по умолчанию локализует загружаемые файлы; таким образом, позволяя вам просматривать веб-сайт в автономном режиме. С помощью этого инструмента вы даже можете загружать веб-сайты без каких-либо изменений.

Это также позволяет вам создать документ, который вы можете использовать для загрузки в любое время. При выборе команды «Сохранить» этот инструмент может приостановить загрузку в середине загрузки и сохранить ее статус в документе.

Кроме того, вы можете возобновить загрузку с того места, где вы ее остановили, просто нажав на кнопку «Возобновить».

Плюсы:-- Это программное обеспечение имеет быстрый процесс загрузки.

- Позволяет пользователю приостанавливать и останавливать загрузку в любое время между процессом.

- Вы можете хранить все данные о скачанном сайте в файле документа.

- Программа сохраняет исходную структуру папок.

- С помощью этой программы можно загрузить только ограниченное количество файлов.

- Это программное обеспечение совместимо только с устройствами iOS и MAC.

Как сохранить любой веб-сайт в автономном режиме на Mac!

Посмотреть это видео на YouTube

Этот загрузчик веб-сайтов имеет простой процесс загрузки целых веб-сайтов или отдельных файлов. Таким образом, это один из лучших загрузчиков веб-сайтов, доступных в Интернете.

В режиме офлайн-браузера NCollector Studio Lite можно загружать сайты для чтения офлайн. Он также преобразует каждую внутреннюю ссылку в локальную ссылку.

Кроме того, в программном обеспечении вы найдете режим сканирования, который сканирует различные веб-сайты в поисках широкого спектра файлов, таких как изображения, документы, видео, музыка и многое другое. Вы получаете загруженные файлы в своих собственных настроенных настройках.

Программное обеспечение также позволяет загружать изображения с помощью поисковых сервисов Google и Bing. Кроме того, он может отражать веб-сайт, в котором он архивирует полностью утилитарный снимок определенного сайта без каких-либо изменений на новом сервере или хосте. Работает только в Windows.

Плюсы:-- NCollector Studio Lite доступен в четырех режимах: автономный браузер, поиск, зеркальный веб-сайт и сканер.

- Программное обеспечение указывает поисковую фразу, а также поисковую систему без какой-либо настройки.

- Этот загрузчик веб-сайта прост в использовании как для экспертов, так и для домашних пользователей.

- Он также поддерживает Shockwave Flash.

- Бесплатна только облегченная версия этого программного обеспечения, которая также предлагает ограниченные возможности.

- Зеркальный режим программного обеспечения не может переводить ссылки для их использования в автономном режиме.

Cyotek WebCopy — еще один замечательный инструмент в этом списке. Это программное обеспечение будет поддерживать частичную или полную репликацию сайта на локальном компьютере в соответствии с вашими потребностями. Вы можете просматривать его в автономном режиме, когда вам удобно.

Загрузчик веб-сайта начинает анализировать веб-сайт для переноса всего веб-контента на жесткий диск вашей системы.

Программное обеспечение также автоматически переназначает различные ресурсы в процессе. Он включает в себя таблицы стилей, веб-страницы или изображения с локальными путями.

Это программное обеспечение также позволяет вам установить свои предпочтения, которые варьируются от выбора сегментов сайта, которые вы хотите загрузить, до использования его общих настроек.

Далее загрузчик копирует все идентифицированные ресурсы и даже продолжает просматривать другие. Следовательно, полное сканирование веб-сайта выполняется для копирования всего, что оно обнаруживает, при попытке установить достоверную имитацию этого конкретного сайта.

В общем, загрузчик веб-сайта оценивает HTML-маржу портала загрузки и пытается получить каждый связанный ресурс.

Плюсы:-- Это программное обеспечение будет исследовать все связанные ресурсы, такие как другие страницы, изображения, видео и загрузки файлов, чтобы сохранить их в вашей компьютерной системе.

- Инструмент просканирует весь веб-сайт, чтобы загрузить все, что обнаружит.

- Он имеет параметр конфигурации, чтобы указать, какие разделы веб-сайта реплицировать.

- Cyotek WebCopy — абсолютно бесплатное программное обеспечение.

- Загрузчик веб-сайта не включает виртуальный DOM или какой-либо анализ JavaScript.

- Работает только в Windows и Vista SP2.

Как следует из названия, он позволяет просматривать любой веб-сайт в автономном режиме. Offline Explorer — один из премиальных инструментов для загрузки и архивирования веб-сайта. Он работает на технологии загрузки высокого уровня и может похвастаться надежными функциональными возможностями.

Offline Explorer — это сверхбыстрое программное обеспечение, которое быстро загружает сайты. Кроме того, он имеет гладкий интерфейс, который делает его простым в использовании.

Вы даже можете скачать отдельные разделы, а не весь сайт. Это означает, что вы можете установить уровни ссылок для перехода и запретить определенные видео, изображения, архивы и другие.

Вы также можете настроить расширенные команды исключения в зависимости от каталогов, имен файлов и т. д. Программное обеспечение сохранит загруженный веб-сайт прямо на ваш жесткий диск или даже на флэш-диски или DVD-диски.

Еще некоторые преимущества, связанные с этим загрузчиком веб-сайтов, включают поддержку защищенных паролем сайтов, поиск по ключевым словам, создание карты сайта, встроенный просмотр веб-страниц, управление дисковым пространством, поддержку BitTorrent и другие.

Плюсы:-- Вы можете автоматически и регулярно архивировать свой любимый веб-сайт с помощью Offline Explorer.

- Программное обеспечение позволяет пользователям создавать несколько проектов.

- Вы можете реплицировать весь сайт или только несколько необходимых файлов с помощью Offline Explorer.

- Вы получаете только 30-дневный пробный период, который также ограничен только 2000 загруженными файлами.

- Поддерживает только ОС Windows.

Во время нашего исследования лучших инструментов для загрузки веб-сайтов для просмотра в автономном режиме мы нашли видео о « Почему вы никогда не должны посещать темную сеть », которое стоит посмотреть. 🏆🤴

🏆🤴

Почему вы никогда не должны посещать Даркнет

Посмотреть это видео на YouTube

Teleport Pro — это многопоточный, полностью автоматизированный веб-сканер, извлекающий файлы. Используя этот загрузчик веб-сайта, вы можете легко получить доступ и запустить до 10 потоков поиска. Кроме того, программа позволяет копировать сайты, защищенные паролем.

Программное обеспечение может управлять веб-сайтом любого размера без каких-либо сбоев. Он может очищать все типы файлов, доступные на любом веб-сайте.

Инструмент позволяет даже создать дубликат веб-сайта со всеми файлами и подкаталогами. Таким образом, вы также можете искать на сайте файл определенного размера и типа. Кроме того, просмотр всех страниц с центрального сайта и перечисление всех страниц с веб-сайта являются его другими примечательными функциями.

Плюсы:-- С помощью этого вы можете скачать весь сайт или его часть на локальный диск.

- Вы можете фильтровать файлы по их типу и выполнять поиск по ключевым словам, запустив это программное обеспечение.

- Программное обеспечение также позволяет пользователям создавать зеркало любого веб-сайта.

- Этот загрузчик сайта сложен в использовании.

- Это не бесплатное программное обеспечение.

Некоторые люди предпочитают просматривать веб-страницы с мобильных устройств, а не с компьютера или ноутбука. Итак, для этих Offline Pages Pro — лучший вариант.

Это приложение позволит вам сохранить любой веб-сайт на вашем смартфоне, чтобы просматривать его в автономном режиме. На самом деле, это отличный ход для чтения сайта, если нет подключения к интернету.

Это приложение также загрузит формат веб-сайта. Таким образом, вы получаете копию настоящего онлайн-сайта.

Пользоваться этим программным обеспечением просто. Вам просто нужно нажать на кнопку рядом со строкой веб-адреса, когда вы хотите загрузить веб-страницу. Вот и все; веб-страницы будут сохраняться на вашем устройстве в течение короткого времени для просмотра в автономном режиме.

Вам просто нужно нажать на кнопку рядом со строкой веб-адреса, когда вы хотите загрузить веб-страницу. Вот и все; веб-страницы будут сохраняться на вашем устройстве в течение короткого времени для просмотра в автономном режиме.

Не говоря уже о том, что Pro-версия приложения позволяет вам помечать страницы, чтобы вы могли легко найти их позже в вашей организованной системе. Вы также получаете возможность автоматически обновлять сохраненные веб-сайты на регулярной основе.

Плюсы:-- В отличие от других приложений для телефона, программа скопирует всю веб-страницу на ваш мобильный телефон.

- Вы получите все документы, изображения, видео и интерактивность на стороне клиента, скопированные на ваш телефон.

- Процесс сохранения достаточно прост, чтобы мгновенно загрузить любой сайт.

- Вы можете обновить все загруженные вами сайты до текущего формата с помощью этого загрузчика веб-сайтов для мобильных устройств.

- Чтобы приобрести это приложение, необходимо совершить разовую покупку.

- Это приложение поддерживает только устройства iOS.

Это больше похоже на уловку, чем на реальное программное обеспечение. Это совершенно бесплатный загрузчик веб-сайтов. Если вы ищете многофункциональное программное обеспечение для загрузки веб-сайтов, WebAssistant Proxy Offline Browser — идеальный инструмент для вас.

Построенный на Java, он эффективно передает весь веб-трафик и позволяет пользователям создавать копии всех просматриваемых веб-страниц четко и немедленно. Эти загруженные файлы будут доступны для автономного использования в любое время.

Вы заметите исходный веб-контент, а архив, созданный программным обеспечением, в точности аналогичен исходному веб-сайту.

Таким образом, вы можете удобно искать свои страницы даже при отсутствии подключения к интернету. Кроме того, инструмент позволяет использовать закладки и в автономном режиме.

Прокси-серверы также будут обновлять кэшированные веб-страницы, а новые страницы будут добавляться автоматически, как только вы вернетесь в онлайн-режим.

Загрузчик дает доступ к точному положению загруженных веб-страниц. Наконец, это позволит вам анализировать HTML-страницы как из архива, так и из Интернета.

Плюсы:-- Вы также получите пометку ссылок на источники архивов кеша для быстрого доступа.

- Автономный браузер WebAssistant Proxy может автоматически создавать кэш посещенных страниц, который вы можете использовать на разных компьютерах.

- Эффективно работает в онлайн и оффлайн режимах.

- Загрузчик совместим с Mac OS X, Windows, Unix, Linux и Solaris.

- Возможно, вам придется выполнить несколько тестов, чтобы понять процесс, прежде чем создавать реплику сайта.

Все мы знаем, что поисковая оптимизация является наиболее важной стратегией, помогающей любому сайту наладить связи с авторитетными сайтами. Если вы тоже хотите генерировать такие ссылки, Web Reaper — универсальное решение.

Если вы тоже хотите генерировать такие ссылки, Web Reaper — универсальное решение.

Этот загрузчик веб-сайтов может сканировать веб-сайт и загружать каждую веб-страницу, изображение и другие объекты для просмотра в автономном режиме. Вы можете загрузить версию в виде локального каталога, который работает как полностью просматриваемая платформа. Вы также можете просмотреть его с помощью любого веб-браузера.

Кроме того, загрузчик веб-сайтов позволяет вам просматривать веб-сайты с помощью IE в автономном режиме. Он применяет метод многопоточной загрузки.

WebReaper может загружать и исправлять SWF-фильмы для локального просмотра. Вы можете использовать мастер создания фильтров вместе с 12 фильтрами, чтобы легко настроить разделы веб-сайта, которые вы хотите получить для просмотра в автономном режиме.

Загрузчик WebReaper даже поддерживает веб-аутентификацию и прокси для доступа к защищенным и заблокированным сайтам.

Таким образом, с помощью этого инструмента вы получите все необходимые данные, чтобы превзойти конкурентов в своей нише и ранжировать свой сайт в соответствии с последними нормами.

- Web Reaper включает в себя инструменты, которые дадут вам точные результаты, необходимые для ранжирования вашего сайта.

- Отличительной чертой этого инструмента является то, что он может загружать сайты из двух мест.

- Этот загрузчик веб-сайта поддерживает ShockWave Flash.

- Программное обеспечение доступно бесплатно как для коммерческого, так и для личного использования.

- Режим кэширования Internet Explorer для загрузки сайта ограничен Internet Explorer.

- Этот загрузчик с веб-сайта поддерживает только операционные системы Windows.

Как следует из названия, SurfOffline — это действительно профессиональный инструмент, обладающий всеми необходимыми функциями. Его пользовательский интерфейс не является удобным для пользователя. Вы увидите режим офлайн/онлайн для посещения веб-сайта.

Программное обеспечение может эффективно загружать весь сайт, включая изображения, аудио, видео и многое другое. Изюминкой этого загрузчика веб-сайтов является то, что он может загружать как защищенные паролем веб-сайты, так и веб-страницы.

Он имеет встроенный браузер, который будет поддерживать сеансы и файлы cookie, позволяя вам загружать эти защищенные паролем сайты.

Плюсы: —- SurfOffline Professional — это легкий загрузчик веб-сайтов по сравнению с другими инструментами в списке.

- Отличное универсальное программное обеспечение для сбора всех данных с веб-сайта.

- Он поддерживает прокси-серверы, аутентификацию HTTP и FTP, файлы cookie, CSS, CSS2, синтаксический анализ JavaScript и Macromedia Flash.

- Загрузчик не является бесплатным.

- Несколько сложно просматривать сайт в загрузчике.

Далее в нашем списке лучших загрузчиков веб-сайтов находится программа GetLeft , которая доступна на 13 различных языках. Программное обеспечение является идеальным выбором для копирования небольших файлов или сайтов любого типа.

Программное обеспечение является идеальным выбором для копирования небольших файлов или сайтов любого типа.

GetLeft моментально копирует все данные с нужного сайта для оффлайн чтения. Прежде чем он начнет загрузку, вы можете отфильтровать большие файлы по одному или выбрав их тип на карте сайта. Однако пользоваться программным обеспечением непросто, а значит, с ним справятся только профессионалы.

Это программа для экономии времени, позволяющая планировать загрузку. Кроме того, вы можете приостановить и перезапустить процесс копирования, когда захотите.

Плюсы:-- Это программное обеспечение займет меньше места в вашей системе, чем другие программы в списке.

- Программное обеспечение поддерживает операционные системы Windows 95, Windows 98, Windows 98 SE, Windows 7, Windows 8, Windows 2000, Windows 2003, Windows ME, Windows NT и Windows XP.

- GetLeft также сэкономит место на диске.

- Это бесплатное программное обеспечение с открытым исходным кодом.

- Вам нужно приложить некоторые усилия, чтобы изучить процесс, прежде чем его использовать. Следовательно, он не предназначен для домашних пользователей.

- Это программное обеспечение не может рекурсивно загружать несколько файлов.

Вы хотите просматривать любой веб-сайт как онлайн, так и офлайн? Этот инструмент может помочь вам в этом. После завершения загрузки сайта вы можете просмотреть его в автономном или онлайн-режиме по своему усмотрению.

Website Extractor может похвастаться расширенным интерфейсом и индивидуальными настройками. Это удобное программное обеспечение, разработанное для упрощения копирования веб-сайтов. Вы можете скопировать сайт, включив или исключив любой раздел в соответствии с вашими требованиями.

Website Extractor включает в себя все основные функции, необходимые загрузчику веб-сайтов. Вы также найдете некоторые эксклюзивные функции, такие как выбор страны загрузки веб-сайта. Этот веб-сайт имеет некоторые функции, аналогичные тем, которые вы получите в Offline Explore.

Вы также найдете некоторые эксклюзивные функции, такие как выбор страны загрузки веб-сайта. Этот веб-сайт имеет некоторые функции, аналогичные тем, которые вы получите в Offline Explore.

Загрузка какого-либо файла остановлена из-за плохого соединения или ошибок передачи? Одной из лучших особенностей этого программного обеспечения является то, что оно позволяет автоматически копировать любые данные. Наконец, это программное обеспечение может извлекать около 100 файлов одновременно.

Таким образом, это веб-сайт, который экономит время и загружает вас по сравнению с любым обычным инструментом.

Плюсы: —- С помощью Website Extractor вы можете загрузить любой веб-сайт именно так, как вы хотите, поскольку он предлагает возможность настройки.

- Это программное обеспечение позволяет запускать или останавливать загрузку по расписанию и типу файла.

- Вы можете скачать каталог, типы файлов, их размер, имена доменов и файлов и любые другие элементы.

- Все извлеченные программой файлы сохраняются только в выбранном вами каталоге.

- Программное обеспечение имеет ограниченный по времени пробный период.

Я нашел отличный инструмент для браузера, который позволяет сохранять веб-страницы, чтобы вы могли вернуться к ним, даже когда вы не в сети. Он называется Single File Z (посетите здесь), и на его странице GitHub есть ссылки на надстройки Firefox и Chrome.

Если название кажется знакомым, то это потому, что оно является ответвлением расширения Single File для Firefox, Chrome и Edge от одного и того же разработчика. Эта более новая версия Z похожа, но имеет несколько настроек — в первую очередь размер загрузки намного меньше.

Еще одна интересная особенность заключается в том, что вы можете установить расширение в разных браузерах (например, Chrome и Firefox) и включить параметр «Разрешить доступ к URL-адресам файлов». Это означает, что если вы сохраните веб-страницу в Chrome, вы сможете открыть ее в Firefox.

Это означает, что если вы сохраните веб-страницу в Chrome, вы сможете открыть ее в Firefox.

Есть два способа сохранить веб-страницу. Если расширение Single File Z находится в вашей адресной строке, нажмите кнопку расширения. После обработки страницы вы можете сохранить HTML-файл на свой компьютер.

SingleFile Demo

Посмотреть это видео на YouTube

Другой способ — щелкнуть страницу правой кнопкой мыши. Один файл Z появляется в раскрывающемся меню, и при наведении на него появляется несколько вариантов сохранения. Помимо простого сохранения страницы, вы можете сохранить выбранные области вместе с открытыми, закрепленными или всеми вкладками. Есть даже функция автосохранения.

Если вы предприниматель и хотите построить компанию на пустом месте, вы можете также извлечь данные и информацию из других веб-сайтов. Практика извлечения данных с различных веб-сайтов называется Web Scraping.

Очистка веб-страниц разрешена не на всех веб-сайтах, но перед этим вы можете запросить владельца веб-сайта, и если у вас есть разрешение, вы можете удалить этот веб-сайт, чтобы проанализировать данные и творить с ним чудеса.

В этой статье мы собираемся обсудить различные методы, которые мы можем использовать для парсинга веб-сайта.

Использование служб парсинга: —Один из самых простых и эффективных способов парсинга веб-сайта для компании — это использование службы парсинга веб-страниц . Существуют разные сервисы для разных масштабов работ.

Используйте Scrapinghub, если вы хотите работать в больших масштабах, этот сервис позволит разработчику собрать огромное количество данных.

Если вы не собираете огромное количество данных и хотите, чтобы что-то работало в меньшем масштабе, вам следует выбрать PareseHub.

PareseHub — это просто и недорого. Вы получите бесплатный план на 200 страниц, и оттуда вы сможете изучить, а затем рассмотреть возможность соблюдения его системы ценообразования.

Используйте Google Spreadsheet для веб-скрейпинга:- Google Spreadsheet не только служит приложением для управления данными, но также может помочь пользователям в очистке веб-сайта.

Чтобы удалить веб-сайт с помощью таблицы Google, выполните следующие действия: —

Шаг 1: Сначала вам нужно найти веб-сайт, который вы хотите удалить, а затем скопировать URL-адрес для этого конкретного раздела.

Шаг 2: Откройте электронную таблицу, переименуйте ее и вставьте URL-адрес в первую строку первого столбца.

Шаг 3: Так как мы используем Bloomberg.com в качестве примера, мы собираемся рассчитать валютный рейтинг. В этом примере мы собираемся отказаться от стоимости доллара США по отношению к канадскому доллару.

Шаг 4: Создайте отдельные разделы для каждого объекта. (Валюта, Дата, Курс спот, Валюта, Курс спот)

Шаг 5: Теперь посетите этот Bloomberg.com, кросс-курсы, здесь вам нужно извлечь исходный код, для этого перейдите к валюте USD/CAD и щелкните объект правой кнопкой мыши, чтобы извлечь исходный код, завернутый в тег привязки. Если вы можете скопировать HTML-код, сделайте это или нажмите «Изменить HTML», а затем скопируйте код.

Шаг 6: Вставьте скопированный HTML-код под вставленным URL-адресом.

Шаг 7: Теперь давайте перейдем к введенному объекту, в разделе «Валюта» введите валюту (доллары США и канадские доллары). на вкладке «Данные» вам нужно вставить команду времени NOW(). Теперь под спотовой ставкой (1) вставьте команду « =importXML(A1»//a[@href=’/quote/USDCAD:CUR’]») ».

Шаг 8: Теперь давайте перейдем к разделу, где вы вошли в CAD, под его разделом Cross Rate вставьте 1/D4 ( это место предыдущего кросс-курса). Это даст вам значение Cros Rate по отношению к валюте CAD.

Точно так же вы можете двигаться дальше, просто изменив валюту в последующих записях.

Используйте библиотеку Python для просмотра веб-страниц:- Python считается языком программирования будущего. Если вы хотите выполнять веб-скрейпинг на python, у вас есть два метода, мы собираемся обсудить оба метода.

Scrapy — это библиотека Python, которая используется для извлечения информации с веб-страниц. В библиотеке Scrapy есть пауки, которые ползают по веб-сайту, чтобы отслеживать его.

Пауки используются для определения того, как веб-сайт должен быть удален для получения информации. Они позволяют нам определить, какую информацию мы должны извлечь из веб-сайта. Что касается его связи с Python, Spiders — это классы, которые состоят из всей логики, необходимой для извлечения данных.

Далее следует Селектор. Селекторы — это механизм, используемый для выбора данных с помощью базового HTML-кода веб-страницы.

Прежде чем перейти к мясу, которое является кодом, мы должны узнать еще одну вещь, это Предмет. Элементы — это данные, извлеченные из селектора.

В первую очередь необходимо установить Microsoft Visual Studio, это поможет в наборе кода.

Учебное пособие по Python Scrapy — Кошки и пауки? Веб-скрейпинг Reddit с помощью Scrapy [2020]

Посмотреть это видео на YouTube

Вы хотите получить доступ к онлайн-платформе, но у вас нет доступа в Интернет? Или вам нужно сохранить резервную копию вашего собственного сайта? Возможно, вы разработчик веб-сайта, которому нужно воспроизвести сайт, заданный вашим клиентом.

Как бы то ни было, загрузчик с веб-сайта — ваш спаситель. Таким образом, инструменты, рассмотренные в приведенном выше списке, являются вашими лучшими вариантами для воспроизведения полного веб-сайта для просмотра в автономном режиме в более позднее время. Надеюсь, вы нашли свое идеальное программное обеспечение!

WebHTTrack Website Copier » Linux Magazine

WebHTTrack создает резервные копии полных веб-сайтов для автономного доступа и автоматически изменяет ссылки.

Несмотря на повсеместный доступ к Интернету, у пользователей часто есть веские причины для создания автономных копий веб-сайтов — будь то для архивирования или предоставления содержимого в вашей внутренней сети. Однако ручное зеркальное отображение может занимать много времени и быть громоздким. Могут помочь такие инструменты, как WebHTTrack, которые позволяют удобно обновлять контент.

Однако ручное зеркальное отображение может занимать много времени и быть громоздким. Могут помочь такие инструменты, как WebHTTrack, которые позволяют удобно обновлять контент.

На нашем лабораторном компьютере с Linux Mint 12 установка прошла легко. я набрал

sudo apt-get install httrack webhttrack

для установки пакетов и зависимостей. На веб-сайте программы предлагаются пакеты для Debian, Ubuntu, Gentoo, Red Hat, Mandriva, Fedora и FreeBSD, также доступны версии для Windows и Mac OS X. Каждый пакет содержит вариант командной строки под названием HTTrack (полезно ) и графический интерфейс под названием WebHTTrack (или WinHTTrack в Windows).

Всегда к вашим услугам Чтобы запустить интерфейс, либо найдите его непосредственно в меню «Приложения», либо просто введите webhttrack в командной строке, чтобы запустить локальный веб-сервер на порту 8080, откройте браузер по умолчанию и загрузите графический мастер, который проведет вас через процесс (рис. 1).

1).

Рисунок 1: Простой мастер помогает с загрузкой.

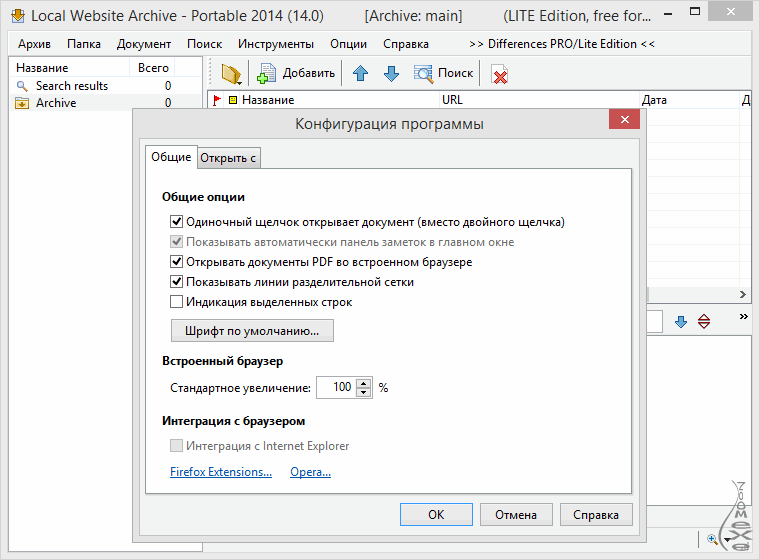

Для загрузки веб-сайтов сначала необходимо определить имя проекта и связанную с ним категорию или выбрать существующую запись. Инструмент перечисляет сохраненные сайты в группах, что полезно, особенно в больших архивах, поскольку помогает отслеживать загрузки. Вы можете указать WebHTTrack, где создать этот архив, определив Базовый путь ; соответствующие подкаталоги создаются автоматически.

На следующей странице введите веб-сайт для зеркалирования; В качестве примера я использую веб-сайт Document Foundation. Соответствующие адреса можно либо ввести непосредственно в соответствующие поля, либо указать текстовый файл с одним URL-адресом в строке. Инструмент поддерживает адреса FTP, HTTP и HTTPS, для которых можно ввести полный путь (например, http://www.documentfoundation.org ) или ограничиться отдельными подкаталогами (например, http://www.documentfoundation. org/foundation/). Страницы, защищенные паролем, лучше всего добавлять, нажав кнопку Добавить URL .

org/foundation/). Страницы, защищенные паролем, лучше всего добавлять, нажав кнопку Добавить URL .

WebHTTrack предлагает несколько режимов загрузки исходного контента. Автоматическое копирование веб-сайта запускается без каких-либо вопросов, в то время как Запрос на копирование веб-сайта является более подробным и задает вам вопросы, если вы сомневаетесь. Загрузка специальных файлов позволяет защитить отдельные файлы, не переходя по содержащимся в них ссылкам, и Переход ко всем ссылкам удобен для сохранения закладок, потому что в каждом случае сохраняются все ссылки на первой странице. Напротив, Тестовые ссылки на страницах ничего не скачивают, а только проверяют, действительны ли ссылки.

За незаметной кнопкой Настройки скрываются многочисленные опции, позволяющие настроить практически каждую деталь. Помимо прочего, вы можете указать порядок загрузки файлов. Кроме того, вы можете настроить способ, которым WebHTTrack хранит документы локально в сборка (рис. 2).

2).

Рис. 2. Реструктурируйте сайт с помощью параметров сборки.

По умолчанию структура каталогов отражается 1:1 в соответствующих подкаталогах, но вы также можете выбрать структуру по типу файла, например, чтобы изображения и PDF-файлы были разделены. Если данных структур недостаточно, вы можете просто ввести собственные пути на основе переменных. WebHHTrack заботится о перезаписи ссылок и удаляет страницы с ошибками или пароли по запросу.

В зависимости от доступной полосы пропускания вы можете использовать Flow Control и настроить количество одновременных подключений, а также время ожидания и повторные попытки в случае ошибки. Эти настройки помогают создавать резервные копии медленных серверов, не подвергая их чрезмерным попыткам доступа.

В качестве встроенной подушки безопасности можно установить Ограничения для общего размера, скорости передачи и времени передачи. Дополнительные настройки, в первую очередь предназначенные для продвинутых пользователей, доступны в Типы MIME , Идентификатор браузера , Паук и Журнал, Индекс, Кэш вкладки. В некоторых сетях может быть актуально использование Proxy .

В некоторых сетях может быть актуально использование Proxy .

Правила сканирования — это мощная функция, позволяющая точно указать желаемое содержимое. По умолчанию резервируются все страницы ниже указанного URL-адреса, включая содержащиеся на них ссылки. Но, например, на веб-сайте LibreOffice, который также содержит ссылки для скачивания, это будет означать, что в дополнение к фактической домашней странице также будут захвачены многочисленные программные файлы. Чтобы более точно указать, что вы хотите скачать и что вы хотите проверить на наличие ссылок, вы можете определить фильтры.

Например, чтобы загрузить все ссылки, кроме тех, которые указывают на файлы PDF, вы должны отфильтровать -*.pdf . Однако, чтобы исключить PDF-файлы только с сайта Document Foundation, необходимо правило -www.documentfoundation.org/*.pdf . Точно так же -www.documentfoundation.org/themes/*.css пропускает не только все файлы CSS, но и изображения, на которые они ссылаются.

Вместо предоставления отрицательного списка вы можете определить положительный список, чтобы явно обозначить содержимое для резервного копирования; например, -* +*.htm* +www.documentfoundation.org/*.pdf захватывает только PDF-документы, опубликованные на домашней странице Document Foundation.

Предварительный код -* исключает все типы, не указанные специально; однако для анализа отдельных страниц на наличие ссылок дополнительно необходимо указать +*.htm* . Фильтры обрабатываются слева направо; элемент, указанный последним, имеет наивысший приоритет. Правило, такое как -* +www.documentfoundation.org/*.htm* -www.documentfoundation.org/*.html5 загружает ссылки на .htm и .html , но не на .html5 . WebHTTrack интеллектуален и переписывает ссылки на файлы, которые не были загружены, чтобы их можно было напрямую связать онлайн. Например, если вы исключите PDF-файлы из загрузки, щелчок по соответствующей ссылке приведет вас к онлайн-версии, поэтому это решение идеально подходит для часто обновляемых документов. Фильтры также могут помочь установить ограничения по размеру. Например, -*.zip[>1024] -*.pdf[<2048] предусматривает, что никакие ссылки на ZIP-файлы размером более 1 МБ не загружаются, а ссылки на PDF-файлы не загружаются, если они не превышают 2 МБ. Параметры также можно комбинировать; например, -*.png[<5>100] позволяет использовать только файлы PNG размером от 5 до 100 КБ и, таким образом, исключает как миниатюры, так и большие изображения. Для экспертов WebHTTrack предлагает возможность выбора по типу MIME и использование регулярных выражений для уточнения фильтров.

Фильтры также могут помочь установить ограничения по размеру. Например, -*.zip[>1024] -*.pdf[<2048] предусматривает, что никакие ссылки на ZIP-файлы размером более 1 МБ не загружаются, а ссылки на PDF-файлы не загружаются, если они не превышают 2 МБ. Параметры также можно комбинировать; например, -*.png[<5>100] позволяет использовать только файлы PNG размером от 5 до 100 КБ и, таким образом, исключает как миниатюры, так и большие изображения. Для экспертов WebHTTrack предлагает возможность выбора по типу MIME и использование регулярных выражений для уточнения фильтров.

После настройки адресов, фильтров и других параметров, наконец, можно нажать Star t > > , чтобы указать WebHTTrack начать загрузку. В зависимости от объема и сложности сайта этот процесс занимает некоторое время; окно состояния (рис. 3) информирует вас о ходе выполнения.

Рисунок 3: Загрузка WebHTTrack на полной скорости.

Программа будет переходить по каждой ссылке по указанным адресам, скачивать нужный контент согласно фильтрам и записывать файлы. По мнению авторов, сайты с Flash-контентом, CGI-скриптами, Java-апплетами и JavaScript вызывают проблемы, поскольку их не всегда легко проанализировать. Если возможно, WebHTTrack попытается определить тип файла и соответствующим образом переименовать его (например, системы управления контентом, которые часто используют URL-адреса PHP для обслуживания обычных файлов HTML).

После завершения работы инструмента (рисунок 4) мастер предлагает показать вам лог-файл, чтобы убедиться, что все заработало — там будут указаны все ошибки, несуществующие файлы и другие проблемы.

Рисунок 4: Готово!

Обзор всех локально зеркалируемых страниц см. в файле index.html в корневом каталоге — на этом этапе в игру возвращаются ранее упомянутые категории, поскольку они обеспечивают структуру архива (рис. 5). .

5). .

Рисунок 5: Со временем вы можете создать небольшую библиотеку локальных сайтов.

В дополнение к разовым загрузкам WebHTTrack также поддерживает обновления ранее загруженного контента. Для этого он создает локальный кеш и пытается при выборе режима * Обновить существующую загрузку загружать только те файлы, которые изменились с момента последнего запуска. Элементы, которых больше нет на сервере, удаляются; однако вы можете выбрать соответствующие параметры, чтобы отключить эту функцию.

Назад к корнямWebHTTrack, в принципе, является лишь графическим интерфейсом для реальной рабочей лошадки, программы командной строки под названием HTTrack, которая особенно хорошо подходит для написания сценариев. Все параметры, предоставляемые мастером, доступны в качестве параметров, как показано в обширной онлайн-документации. Например,

httrack http://www.documentfoundation.org -* +*.htm* +*.pdf -O /home/floeff/websites

загружает все файлы PDF с веб-сайта Document Foundation в подкаталог.