ТОП лучших способов, как скопировать сайт

Сейчас очень сложно прожить без стабильного и регулярного подключения к интернету – человеку может понадобиться проверить информацию, посмотреть погоду или уточнить свое местоположение на карте. Но иногда возникает такая ситуация, когда нужен целый сайт или какая-то его страница, а доступа к интернету нет.

Часто такая проблема встает перед путешественниками, которым нужно скачать путеводитель по незнакомому городу с картами и подробным расписанием маршрута. Но если доступа к сети нет, им приходится заранее делать скриншоты или выписывать нужную информацию. Это не совсем удобно, занимает много времени и в бесконечных скриншотах путешественник легко запутается.

Кроме того, сохранение сайта может понадобиться вам во многих случаях. Например, если вы находитесь дома с регулярным подключением к сети хотите, чтобы информация сохранялась на вашем компьютере, даже если ее кто-то удалит с сайта. Причин может быть много, в конце-концов, это просто удобно.

Есть несколько простых способов того, как скачать сайт к себе на устройство для того, чтобы можно было его открыть и без доступа к сети. Мы расскажем подробнее про каждый из них и поделимся самыми простыми и верными способами сохранить веб-страницу себе.

Постраничное сохранение

Парадоксально, но этим самым простым способом сохранения сайта к себе на компьютер вы могли пользоваться даже если не знали о его существовании, когда случайно сохранял сайт с помощью комбинации клавиш. Возможность сохранить к себе сайт на компьютер с этим способом есть в любом популярном браузере. Для этого вам нужно нажать комбинацию клавиш Ctrl+S. После этого пользователю должно открыться окно, где нужно ввести название сайта, под которым он сохранится на компьютере. Также стоит выбрать папку, в которую пойдет страница сайта.

Это очень простой и удобный способ, однако в таком методе сохранения есть недостаток. Он сохраняет только одну страницу, по сути это – длинный скриншот, но в более хорошем качестве. Если вам нужно сохранить больше, чем пару страниц для своих потребностей, то вы будете долго это делать и в результате можете запутаться в бесконечных страницах.

Если вам нужно сохранить больше, чем пару страниц для своих потребностей, то вы будете долго это делать и в результате можете запутаться в бесконечных страницах.

Поэтому если вам нужно сохранить целый большой сайт с кучей страниц, на которых важная для вас информация, то нужно подключать не постраничное сохранение, а обращаться к современным способам – через онлайн-сервисы или с помощью программ.

Использование онлайн-сервисов

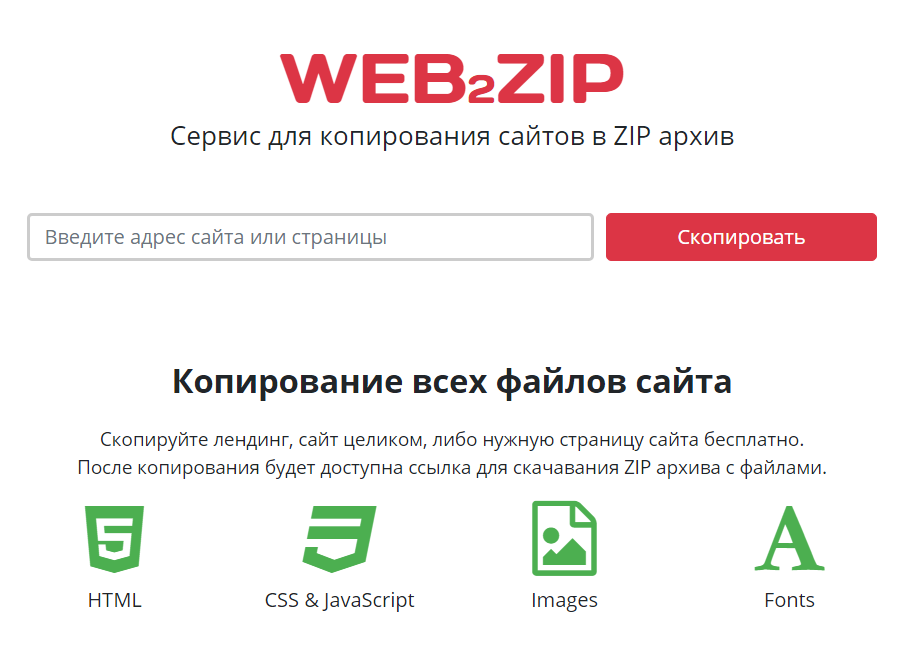

Онлайн-ресурсы для сохранения страниц в браузере – самый простой способ того, как скопировать сайт. Это не только быстро, не требует установки дополнительного ПО на ваш компьютер и это бесплатно. Нужно всего-лишь зайти на интересующий вас ресурс, ввести в отведенное для этого места адрес сайта, запустить скачивание и выбрать место, куда это будет скачиваться.

Есть бесплатные и платные ресурсы. Платных намного больше и они удобнее, а бесплатных не так много, иногда они работают очень медленно, но для простого пользователя будут полезными, особенно если вы не часто скачиваете сайты. Для того, чтобы вам было понятнее, предлагаем подробнее рассмотреть бесплатные онлайн-сервисы.

Для того, чтобы вам было понятнее, предлагаем подробнее рассмотреть бесплатные онлайн-сервисы.

Webparse.ru

Этот ресурс можно только условно назвать бесплатным. Им очень удобно пользоваться и он хорошо и быстро скачивает сайт, но бесплатно это можно сделать только один раз, потом за использование ресурса придется платить. Но если ситуации, когда вам нужно скачать сайт целиком и сделать это максимально быстро и удобно, у вас случаются очень редко, советуем воспользоваться данным сайтом.

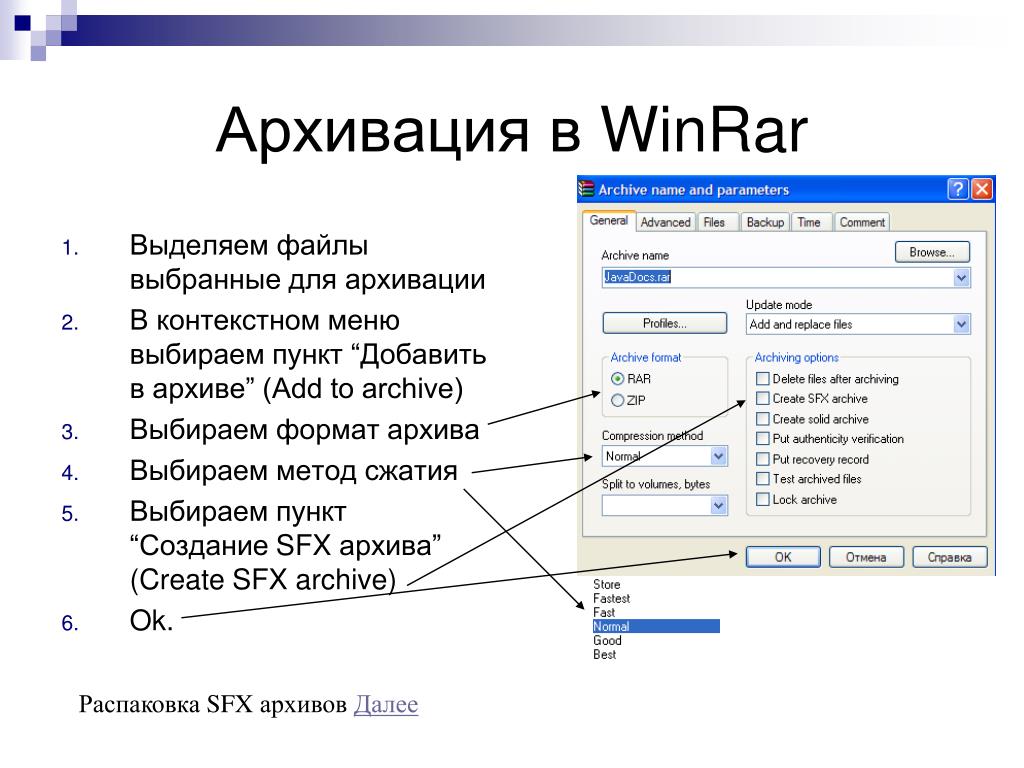

Основное его преимущество в том, что он работает практически молниеносно и если вам очень нужно скачать сайт и быстрее уходить из дома туда, где не будет доступа к интернету, такой вариант очень хорошо подойдет. После скачивания сайта у вас в загрузках будет висеть архив с этой информацией. Однако сайт может скачаться не полностью, особенно, если у него очень большая структура. Поэтому если вы подозреваете, что не все могло скачаться, то разархивируйте папку и посмотрите, есть ли там та информация, которая нужна вам. И если нет – скачайте постраничным сохранением.

И если нет – скачайте постраничным сохранением.

Web2PDFConvert.com

Есть и другие способы сохранения сайтов на свой компьютер с помощью онлайн-ресурсов. Так, удобно пользоваться Web2PDFConvert.com. Он создаст PDF-файл, в котором будут страницы необходимого сайта. Конечно, часть функция (таких как гиперссылки, например), вы потеряете, но если сайт вам нужен только для текстовой информации, то им пользоваться удобно. Самое главное, что скачивается все быстро и бесплатно.

Специализированные программы

Самый лучший вариант того, как можно скачать сайт и не потерять большее количество информации и функционала из него – это поставить себе на компьютер специальную программу для скачивания и поставить весь сайт целиком на загрузку. Однако хотим сразу сказать про недостатки этого метода:

- Программа требует установки, на что идет время.

- Вы также потратите время на то, чтобы разобраться с функционалом и использованием.

- Программа занимает место на компьютере.

- Многие из таких программ платные, хотя и имеют бесплатные аналоги.

- Не все программы можно найти на ваше ПО. Многие из них разработаны только для ОС Windows.

Однако программа скачивает все быстрее и качественнее и в целом в использовании любая из нижеописанных прогам удобнее в использовании, чем онлайн-сервисы, несмотря на то, что придется скачивать и устанавливать.

WinHTTrack WebSite Copier

Эта программа является одной из самых популярных утилит среди тех, что разрабатывались для сохранения копий сайтов.

Для того, чтобы приступить к работе с программой, нужно скачать ее с официального сайта (смотрите внимательно, выберите нужную версию под свою платформу). После установки стоит запустить программу и выбрать, на каком языке вам удобнее в ней работать. Есть даже русский для тех, кто не хочет работать на иностранном.

Интерфейс простой и интуитивно понятный, так что разобраться в нем не сложно. В первом их окон нужно назвать будущий файл, выбрать его категорию и указать, куда надо скачивать. После этого нужно просто ввести веб-адрес сайта, который вы хотите загрузить.

После этого нужно просто ввести веб-адрес сайта, который вы хотите загрузить.

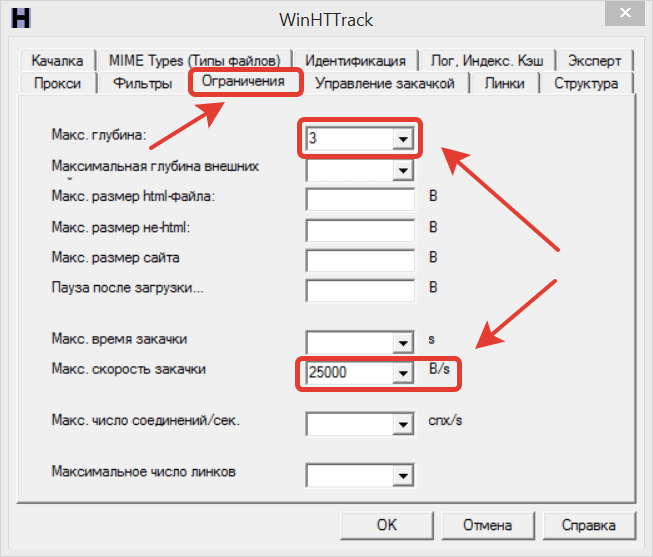

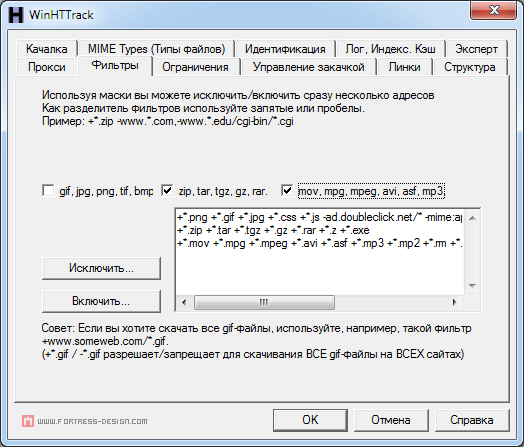

В программе есть много настроек, через которые вы можете регулировать, например, глубину просмотра сайта. Также удобно то, что можно выставить фильтры и определить, что именно скачивать, а что – не стоит. Так, вы можете не скачивать изображения, а скачать только текст.

Вообще, настроек для скачивания много и мы рекомендуем просмотреть их все перед тем, как скачивать, так весь процесс пройдет гораздо комфортнее для вас и вы сможете максимально оптимизировать все. После того, как вы поставили настройки и выбрали нужное имя и место, нажмите “Готово” и ожидайте, пока сайт скачается. Чтобы просмотреть его, нажмите на файл index.htm.

Cyotek WebCopy

Это программа на английском языке, которая обладает очень многими возможностями, вы в этой программе можете подстраивать под себя настройки скачивания и удобно загружать сайт, который вам необходим.

Чтобы скачать, нужно просто выбрать настройки для скачивания, а потом указать адрес загрузки и нажать “Copy Website”.

Когда программа все сделает, вам останется только найти файл “index.htm”. Он и будет начальной страницей сайта, который вы скачали себе для просмотра в режиме офлайн.

Однако, есть у удобной программы для скачивания и недостатки. Русский язык в интерфейсе не предусмотрен и это может стать серьезной проблемой для тех, кто не владеет иностранным языком на достаточном для работы в программе уровня. Также стоит заранее предупредить пользователей, что программа работает только на Windows, начиная с Vista. Поэтому если у вас другая операционная система, придется искать аналоги программы.

Teleport Pro

Программу можно назвать пионером среди подобных ей, однако она платная. Впрочем, для тех, кому нужно скачать всего пару сайтов и кто не планирует пользоваться программой дольше нескольких дней, есть демонстрационная версия. Этот тестовый период поможет вам бесплатно воспользоваться программой и удалить ее потом за ненадобностью.

После того, как вы установили и запустили программу, вам должно открыться главное окно для загрузки. Через него нужно выбрать, как именно вы хотите загрузить сайт на свой компьютер. Так, предусмотрены варианты сохранения определенных страниц или только некоторых типов файлов.

Через него нужно выбрать, как именно вы хотите загрузить сайт на свой компьютер. Так, предусмотрены варианты сохранения определенных страниц или только некоторых типов файлов.

После того, как вы выбрали все необходимые для себя настройки, вам стоит создать в программе новый проект, который вы назовете так, как вам будет удобно и понятно. Далее нужно ввести адрес и выбрать глубину скачивания сайта, которая вам необходима. По умолчанию она стоит 3, но вы можете поставить больше или меньше при желании. Когда все выставлено, нужно нажать на “Далее”, выбрать папку для сохранения и нажать на синий треугольник с надписью “Start”.

Offline Explorer

Программа также платная, но очень удобная благодаря тому, что в ней есть возможность переключить интерфейс на русский язык. Пробная версия программы доступна для пользователя бесплатно в течение месяца, но можно скачать только до 2000 файлов в тестовый период. Если захотите купить программу для дальнейшего использования, учтите, что у нее есть три разновидности – Standard, Pro и Enterprise. Самая простая версия обойдется пользователю в 60 долларов, а самая дорогая – в 600.

Самая простая версия обойдется пользователю в 60 долларов, а самая дорогая – в 600.

Для работы нужно создать новый проект, указать адрес, отфильтровать настройки сохранения. Работа проходит примерно так же, как и во всех аналогах.

После того, как вы все выставили и подготовились к скачиванию, нажмите на пункт “Загрузить” и ждите загрузки.

Программа многофункциональна. В ней вы можете загружать сразу несколько сайтов с системой многопоточной загрузки и выбирать из огромного количества настроек. Но все это доступно в более дорогих версиях утилиты.

Webcopier

Эта программа также распространяется платно, однако удобно то, что у нее есть бесплатный период на 15-дней. Если вам не нужно качать сайты постоянно, то можете воспользоваться в пределах 15 дней, а потом удалить за ненадобностью. Удобно то, что система кроссплатформенная, она есть для Windows и Mac OS.

Работать в ней так же просто, как и во всех аналогичных, которые мы описывали выше. Вам нужно только создать новый файл-проект, после чего ввести URL сайта, который вы хотите скачать.

Программа может попросить вас ввести имя и пароль пользователя, который зарегистрирован на сайте, предназначенном для скачивания. Это нужно для того, чтобы система могла скачать сайт так, как его видит зарегистрированный пользователь со своего аккаунта. Кроме того, вы можете выставить в настройках, что скачивать, а что не стоит. После того, как вы все заполните, останется только нажать “Start download”.

Весь процесс скачивания вы сможете отслеживать с помощью графика, который в режиме реального времени будет строить программа. Там можно наблюдать скорость скачивания, а также из графика вы узнаете, как долго осталось качать.

Сохранение в Google Chrome для Android

Сохранить страницу сайта в телефоне очень просто, однако таким методом вы сохраняете только одну из страниц сайта в браузере. Если хотите сохранить больше – вам придется делать это поштучно. Такой метод подойдет, если вы надолго уходите из дома, но вам нужна справочная информация, которую вы не хотите переписывать, то это очень удобно.

Для того, чтобы скачать сайт, вам нужно зайти на него через мобильное приложение браузера Google Chrome. Если вы пользуетесь другим, вы можете скачать браузер из Google Play Store.

Откройте веб-страницу, которую вам необходимо скачать на свой телефон. После нужно нажать справа вверху возле названия сайта знак в виде трех пунктирных точек. После этого вам будет доступна кнопка “Скачать”, после того, как вы нажмете на нее, телефон автоматически сохранит страницу, на которой вы сейчас находитесь.

Опции, куда именно скачать, в телефоне нет, обычно все сохраняется в папку загрузок или в папку, которая у вас установлена для скачивания по умолчанию. Стоит отметить что для того чтобы страница скачалась, вам нужно иметь постоянное стабильное подключение все время загрузки. Скачивается она довольно быстро, но если произойдет сбой интернета, может вообще ничего не загрузиться.

Выводы

Как видите, с современными технологиями вы можете не только найти всю необходимую для себя информацию, но и иметь к ней доступ без подключения к сети, если заранее позаботитесь о том, чтобы скачать все необходимое себе на устройство.

У вас есть очень много способов сохранения сайта – от онлайн-ресурсов до специальных программ, если приходится делать это часто и в большом количестве. У онлайн0есурсов и бесплатных расширений функционал скромный, но обычному пользователю его зачастую достаточно для бытовых действий. Если вам нужен большой функционал, так как сохранение сайта необходимо для вашей работы или учебы – приобретите платные программы, с которыми это будет делать очень удобно и просто.

Но мы не советуем покупать ни одно приложение прежде, чем вы ознакомитесь с ним и поймете все плюсы и минусы. Тем более, что некоторые программы стоят слишком дорого и не имеют намного больше функционала, чем бесплатные аналоги утилит. Скачивайте и тестируйте на практике пробную версию и выбирайте для себя то, что понравилось в использовании больше всего. Ведь деньги за скачанную программу вам никто не вернет, даже если вам не понравится ее использовать.

Если у вас есть свои способы того, как скачать сайт себе на компьютер или телефон – делитесь ими в комментариях, а если есть вопросы – можете задать их там же.

Скопировать любой сайт с помощью Httrack website copier

- Post author:wmadmin

- Запись опубликована:06.10.2022

- Post category:Рубрика для вебмастеров

Занимаясь различными способами заработка в интернете, например, арбитражем трафика, нередко требуется скопировать одностраничные сайты. Зачем создавать лендинги, когда их можно позаимствовать? Сделать это не сложно, тем более уже созданы специальные программы для этого.

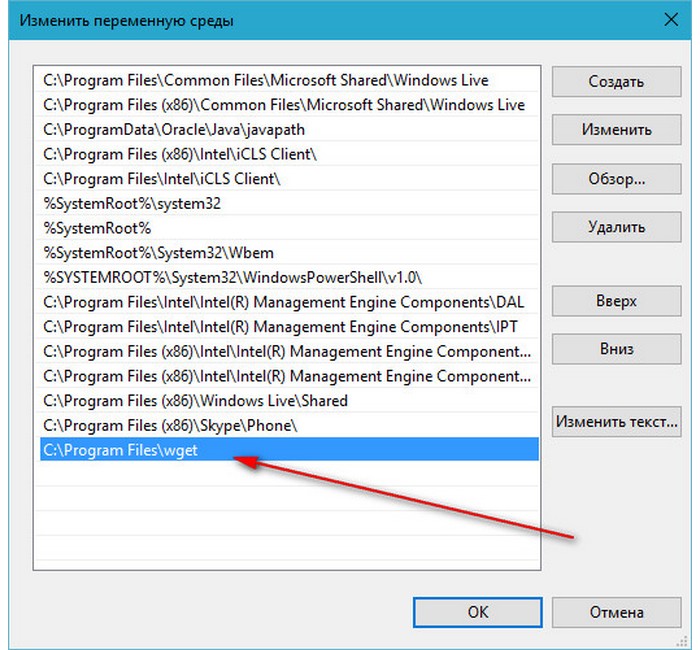

Как скопировать любой сайт? Сначала нужно скачать его на компьютер, а потом перенести на хостинг, предварительно внеся изменения (например, изменив ссылки). Всего несколько минут уходит на это, если использовать Httrack website copier. Это бесплатная утилита, у которой есть русская версия.

У Httrack website copier есть много аналогов, в большинстве своем они платные (например, Offline Explorer). Платить не надо, функционала этой программы хватает. Скачивайте её с официального сайта (httrack), учитывая версию своей операционной системы.

Платить не надо, функционала этой программы хватает. Скачивайте её с официального сайта (httrack), учитывая версию своей операционной системы.

Устанавливается она как любая другая программа, а после запуска нужно проделать следующие действия:

- Создавайте новый проект, имя указывайте произвольное. Категорию можно оставить пустой. Выбирайте папку, куда сохранятся данные и жмите далее:

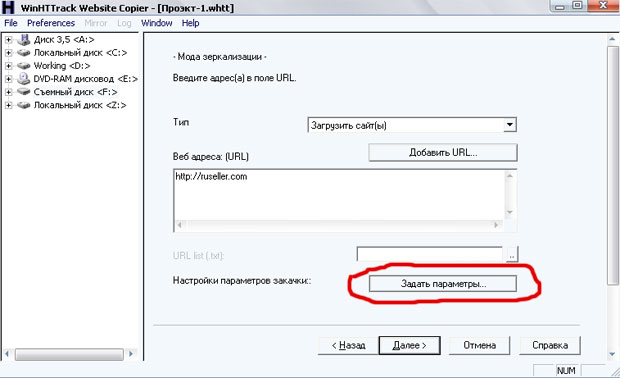

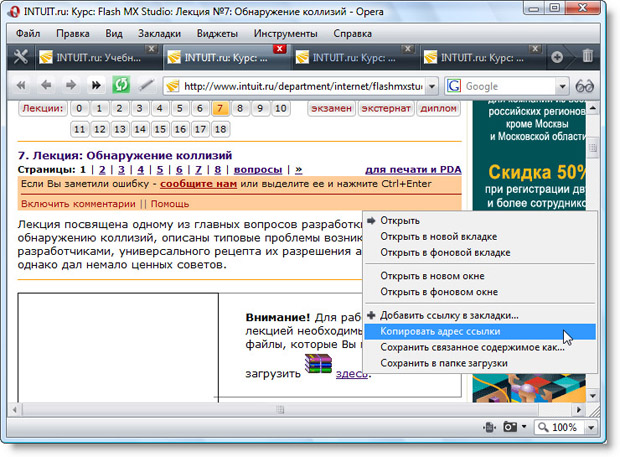

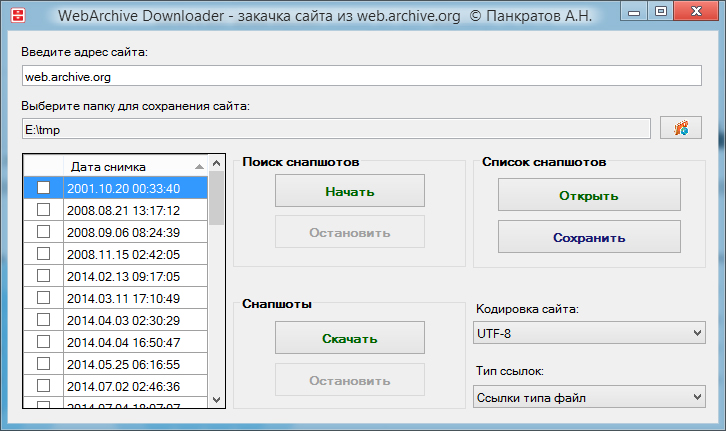

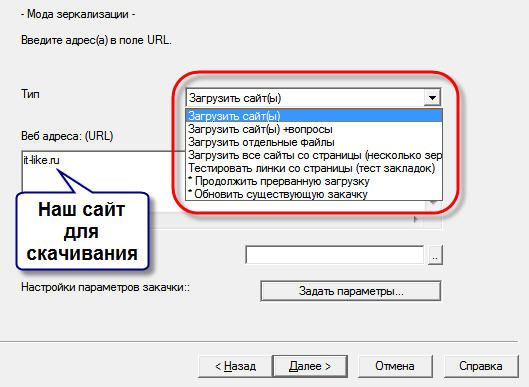

- Дальше выбираете тип операции, оставляйте без изменения загрузку сайта и прописывайте адрес ресурса:

- На предыдущем шаге, перед нажатием Далее, необходимо открыть Задать параметры. Там открывайте вкладку с фильтрами, чтобы избавиться от весомых и ненужных файлов:

- Также зайдите на вкладку с ограничениями, чтобы указать, насколько далеко от указанной страницы нужно загружать сайт. Если это одностраничный сайт, настройки не трогайте:

- Если хотите, чтобы сайт загрузился максимально быстро, установите флажки на вкладке Линки, как это показано на изображении:

- Последняя дополнительная настройка это выбор способа сохранения файлов.

Выбирайте структуру сайта на вкладке Структура:

Выбирайте структуру сайта на вкладке Структура: - Когда все параметры настроены, можно жать кнопку ОК и возвращаться к продолжению загрузки. Всё, что остается сделать, это оставить галочку на первом пункте и нажать Готово:

- Начнется процедура загрузки файлов, нужно дождаться, пока она закончится. Время зависит от объема данных:

- Теперь на вашем компьютере появится папка, в которой сохранены все данные копируемого сайта. Можете зайти в неё и открыть файл HTML в браузере, чтобы проверить, всё ли правильно отображается:

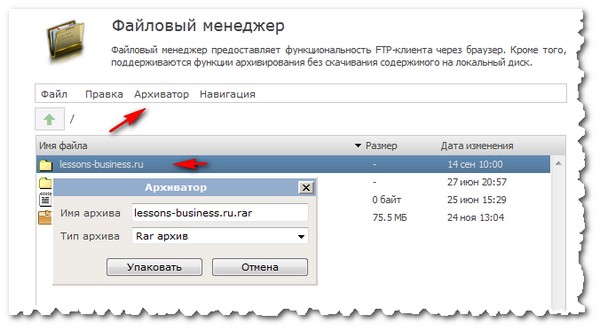

Последний шаг копирования сайта, это его перенос на хостинг. Там всё просто, копируете данные и привязываете заранее арендованный домен. Всё, можно ввести адрес сайта и проверить, всё ли получилось.

Программа Httrack website copier помогает, как сохранить страницу сайта, так и загрузить его полностью. С помощью этой простой утилиты, можно использовать любые красивые одностраничники и повышать конверсию, только не забывайте вносить изменения в код, как минимум, редактируя внешние ссылки.

Читайте другие статьи:

- Как защитить контент от копирования?

- Dynamicdrive – лучшая защита сайта

- Как заработать на информации?

Что такое веб-риппер и лучшие бесплатные рипперы веб-сайтов

Есть три возможные причины, по которым вы читаете эту статью:

👉 1. Вы активно ищете веб-риппер.

👉 2. Некоторые друзья-гики упомянули веб-рипперы, а вы постеснялись признаться в своем невежестве, поэтому погуглили.

👉 3. Вы начали копаться в одной из этих печально известных кроличьих нор в Интернете, и к настоящему времени вы не помните, как начался этот веб-поиск, где вы живете или как вас зовут.

Какой бы ни была причина, по которой вы здесь оказались, мы ответим на ваши вопросы о рипперах веб-сайтов. Таким образом, вы либо:

Таким образом, вы либо:

A. Найдёте то, что ищете,

B. Почувствуете себя в состоянии поговорить с друзьями о веб-рипперах, не выглядя при этом идиотом, или

C. Наконец-то выберетесь из этой кроличьей норы и вернётесь в цивилизацию. .

Что такое риппер сайта?

Программа для копирования веб-сайтов — это программа, которая копирует весь веб-сайт или его части, чтобы вы могли загрузить его для чтения и анализа в автономном режиме. Вы можете копировать и извлекать данные, изображения, файлы и ссылки и загружать эти данные на свой компьютер. Но зачем кому-то это может понадобиться? Вот четыре причины скачать веб-сайт:

- Вы можете просматривать сайт без подключения к Интернету

- Вы можете сохранить загруженную копию своего веб-сайта в качестве резервной копии

- Вы можете загрузить исходные файлы и перенести свой сайт на новый сервер

- Вы можете использовать веб-данные для в образовательных целях, таких как изучение исходного кода

Как скопировать веб-сайт?

Это что и почему из пути, но как вы копируете веб-сайт? Для этого вам понадобится программное обеспечение для извлечения данных. Существует несколько инструментов для распаковки веб-сайтов, которые могут выполнить эту работу, но чтобы помочь вам выбрать, мы сузили список до пяти (в пятом вас ждет приятный сюрприз) 😉

Существует несколько инструментов для распаковки веб-сайтов, которые могут выполнить эту работу, но чтобы помочь вам выбрать, мы сузили список до пяти (в пятом вас ждет приятный сюрприз) 😉

HTTrack

HTTrack — мощный инструмент, позволяющий загружать веб-сайты для просмотра в автономном режиме. Начните с Мастера 🧙♂️ и выберите необходимое количество подключений и элементы, которые вы хотите извлечь. Инструмент создаст каталог веб-сайта с HTML-кодом, файлами и изображениями сервера и передаст его на ваш компьютер. Когда вы откроете страницу скопированного веб-сайта, вы сможете просматривать ее так же, как в Интернете.

Основные преимущества: Полностью настраиваемый; имеет собственную интегрированную справочную системуОсновные недостатки: Не позволяет скачать ни одну страницу сайта; требует времени и усилий, чтобы исключить ненужные типы файлов

SiteSucker

SiteSucker может показаться оскорблением, но на самом деле это очень полезный веб-риппер. Однако это только для компьютеров Mac. SiteSucker копирует отдельные веб-страницы, таблицы стилей, изображения и PDF-файлы и позволяет загружать их на локальный жесткий диск. Все, что вам нужно сделать, это ввести URL-адрес веб-сайта и нажать Enter. Вы можете приостанавливать и возобновлять загрузку, а также доступен ряд языков: французский, испанский, немецкий, итальянский и португальский.

Однако это только для компьютеров Mac. SiteSucker копирует отдельные веб-страницы, таблицы стилей, изображения и PDF-файлы и позволяет загружать их на локальный жесткий диск. Все, что вам нужно сделать, это ввести URL-адрес веб-сайта и нажать Enter. Вы можете приостанавливать и возобновлять загрузку, а также доступен ряд языков: французский, испанский, немецкий, итальянский и португальский.

Основные недостатки: Только для Mac

Cyotek WebCopy

Cyotek WebCopy — это бесплатный инструмент, который может частично или полностью копировать веб-сайты на ваш локальный жесткий диск, сканируя указанный сайт и загружая его на твой компьютер. Он переназначает ссылки на изображения, видео и таблицы стилей, чтобы они соответствовали локальным путям. Он имеет сложную конфигурацию, которая позволяет вам определить, какие части веб-сайта следует копировать.

Основные недостатки: Не может обрабатывать сайты, использующие JavaScript или динамические функции; может очищать только то, что появляется в браузере

Getleft

Getleft — бесплатная загружаемая программа для Windows. При этом вы можете загружать полные веб-сайты, просто указав URL-адрес. Он поддерживает 14 языков и редактирует исходные страницы и ссылки на внешние сайты, чтобы вы могли эмулировать онлайн-просмотр на своем жестком диске. Вы также можете возобновить прерванную загрузку и использовать фильтры, чтобы выбрать файлы для загрузки.

Основные преимущества: Интуитивно понятный интерфейс с несколькими вариантами загрузки отдельных страниц или целых веб-сайтов; несколько языковых опцийОсновные недостатки: Может обрабатывать только HTML; не могу скачать файлы, встроенные в JavaScript

Универсальные парсеры

Теперь пришло время раскрыть тот сюрприз, который мы скрывали! Наша пятая запись на самом деле представляет собой список из 5 парсеров. Все веб-рипперы используют веб-сканирование и сбор данных, поэтому эти инструменты очень пригодятся, если вы хотите извлечь и загрузить веб-данные. Пять парсеров ниже — самые мощные инструменты на платформе Apify. С их помощью вы можете извлекать практически любые данные (при условии, что это законно) с любого веб-сайта в любом масштабе.

Все веб-рипперы используют веб-сканирование и сбор данных, поэтому эти инструменты очень пригодятся, если вы хотите извлечь и загрузить веб-данные. Пять парсеров ниже — самые мощные инструменты на платформе Apify. С их помощью вы можете извлекать практически любые данные (при условии, что это законно) с любого веб-сайта в любом масштабе.

Универсальные веб-скраперы · Apify

Счищайте любой веб-сайт с помощью универсальных скребков. Puppeteer или Playwright Scraper для полных браузерных задач или Vanilla JS и Cheerio Scraper, если нет динамического контента.

ApifyЧтобы начать работу с любым из следующих инструментов, вам нужно только указать парсеру, какие страницы он должен загружать и как извлекать данные с каждой страницы. Парсеры начинают с загрузки страниц, указанных с помощью URL-адресов, и могут переходить по ссылкам страниц для рекурсивного сканирования целых веб-сайтов.

Web Scraper

Web Scraper — универсальный простой в использовании инструмент для сканирования веб-страниц и извлечения из них структурированных данных с помощью нескольких строк кода JavaScript. Он загружает веб-страницы в браузере Chromium и отображает динамический контент.

Он загружает веб-страницы в браузере Chromium и отображает динамический контент.

Cheerio Scraper

Cheerio Scraper — это готовое решение для сканирования веб-сайтов с использованием простых HTTP-запросов. Быстрая и легкая альтернатива Web Scraper, веб-скрапинг Cheerio подходит для веб-сайтов, которые не отображают контент динамически. Он извлекает HTML-страницы, анализирует их с помощью библиотеки Cheerio Node.js и позволяет быстро извлекать из них любые данные.

Vanilla JS Scraper

Vanilla JS Scraper — это не-jQuery альтернатива Cheerio Scraper, которая хорошо подходит для парсинга веб-страниц, которые не полагаются на клиентский JavaScript для обслуживания своего контента. Это может быть до 20 раз быстрее, чем полнобраузерное решение, такое как Puppeteer.

Puppeteer Scraper

Puppeteer Scraper — это полнофункциональное браузерное решение, поддерживающее вход на веб-сайт, рекурсивное сканирование и пакетные URL-адреса в Chrome. Как следует из названия, этот инструмент использует библиотеку Puppeteer для программного управления безголовым браузером Chrome и может заставить его делать практически все что угодно. Puppeteer — это библиотека Node.js, поэтому для использования этого мощного инструмента требуется знание Node.js и его парадигм.

Puppeteer — это библиотека Node.js, поэтому для использования этого мощного инструмента требуется знание Node.js и его парадигм.

Playwright Scraper

Драматургический аналог Puppeteer Scraper, Playwright Scraper отлично подходит для создания решений для парсинга и веб-автоматизации. Он поддерживает функции помимо браузеров на основе Chromium, обеспечивая полный программный контроль над Firefox и Safari. Как и в случае с Puppeteer Scraper, этот инструмент требует знания Node.js.

Решение для кроличьей норы

Если ни один из вышеперечисленных инструментов не соответствует вашим требованиям, или если они кажутся вам слишком сложными, вместо того, чтобы спускаться в другую кроличью нору через постоянно расширяющуюся вселенную Сети за этим неуловимым идеальное решение, у нас есть идея получше. Свяжитесь с нами в Apify и дайте нам знать, что вам нужно. Мы будем рады обсудить ваш случай и разработать инструмент или решение именно для вас!

15 лучших загрузчиков веб-сайтов 2022 года

Вы ищете лучший загрузчик веб-сайтов для преобразования веб-сайта в автономный документ? Тогда вы находитесь на правильной странице, так как статья ниже будет использоваться для обсуждения некоторых из лучших загрузчиков веб-сайтов на рынке.

Технологии настолько продвинулись вперед, что некоторые вещи, о которых мы даже не думали, стали недоступны. Одним из них является возможность загрузить веб-сайт и иметь локальную копию, к которой можно получить доступ в любое время, даже без подключения к сети. Веб-сайты предназначены для доступа в Интернете, и если вы хотите получить доступ к локальной копии, вам придется сохранять для чтения в автономном режиме для каждой страницы веб-сайта, что может быть пустой тратой времени, повторяться и подвержено ошибкам.

Однако с помощью загрузчика веб-сайта вы можете за считанные минуты загрузить полный веб-сайт и сохранить его локально. В этой статье мы расскажем вам о некоторых из лучших загрузчиков веб-сайтов на рынке, которые вы можете использовать для загрузки веб-сайтов.

Что такое загрузчики веб-сайтов?

Скачанный веб-сайт представляет собой программу для ЭВМ либо в виде простого скрипта, либо в виде полноценного устанавливаемого программного обеспечения, предназначенного для обеспечения локального доступа к веб-сайту в памяти компьютера путем загрузки его страниц и их сохранения.

На самом базовом уровне загрузчик веб-сайта работает как сканер — он отправляет запросы на веб-страницу, сохраняет ее локально, а затем удаляет внутренние URL-адреса со страницы и добавляет их в список URL-адресов для сканирования — и процесс продолжается до тех пор, пока не будет найден новый внутренний URL. Мое первое знакомство с загрузчиком веб-сайтов произошло, когда я получил полные учебные пособия по программированию W3schools, присланные мне другом. И с тех пор меня увлекла сама идея загрузки веб-сайта.

- Создание поискового робота с использованием Selenium и прокси

- Как создать веб-краулер с помощью Python?

Если у вас есть навыки кодирования, вы можете разработать его самостоятельно, поскольку это несложно — все, что вам нужно, — это навыки отправки HTTP-запросов, обработки файлов и обработки исключений. Есть много причин, по которым вы хотите, чтобы веб-сайт был доступен локально, но наиболее популярные причины включают возможность доступа к нему локально и заранее сэкономить плату за сеть или даже доставить его тому, у кого нет частого доступа к Интернету. Одна вещь, которую вам нужно знать о загрузке веб-сайта, заключается в том, что локальная копия может быстро устареть, поскольку обновления веб-сайтов не переносятся на загруженную копию.

Одна вещь, которую вам нужно знать о загрузке веб-сайта, заключается в том, что локальная копия может быстро устареть, поскольку обновления веб-сайтов не переносятся на загруженную копию.

Лучший загрузчик веб-сайтов на рынке

Когда дело доходит до загрузки веб-сайта, вам доступно множество загрузчиков веб-сайтов. Однако некоторые из них не так эффективны, как другие, и поэтому мы хотим обсудить некоторые из лучших загрузчиков веб-сайтов, чтобы вы могли быстро сделать правильный выбор. Ниже приведены некоторые из лучших загрузчиков веб-сайтов на данный момент.

Website Ripper Copier

Website Ripper Copier — один из лучших загрузчиков веб-сайтов, который можно использовать для преобразования веб-сайта в локально доступные документы. Website Ripper Copier поставляется с надежными и расширенными функциями, которые упрощают загрузку полных веб-сайтов.

Одна вещь, которая вам понравится в этом инструменте, это то, что загруженный веб-сайт можно перемещать, и все будет в порядке. Website Ripper Copier — это платный инструмент, но оплата, которую вы сделаете, того стоит — благодаря функциям, которые он предоставляет. Он разработан для современной сети и поддерживает веб-сайты JavaScript и AJAX, извлечение ссылок из ссылок, веб-куки, аутентификацию и многое другое.

Website Ripper Copier — это платный инструмент, но оплата, которую вы сделаете, того стоит — благодаря функциям, которые он предоставляет. Он разработан для современной сети и поддерживает веб-сайты JavaScript и AJAX, извлечение ссылок из ссылок, веб-куки, аутентификацию и многое другое.

Архив местного веб-сайта

Локальный архив веб-сайтов — один из инструментов, разработанных Aignesberger Software. Среди других их продуктов — Site Watcher, AM-deadLink и AM-Note. Их продукт Local Website Archive можно использовать для загрузки полного веб-сайта.

Этот инструмент доступен в двух версиях: бесплатной и платной. Хотя бесплатная версия будет работать, вам будет доступно больше функций, если вы выберете их платный план. Некоторые из функций, которыми можно пользоваться в качестве платного пользователя, включают блокировку рекламы, возможность архивировать веб-сайт в виде документа PDF, улучшенную производительность, поиск дубликатов, пометку страницы как прочитанной и непрочитанной, а также оценку документов.

Загрузчик веб-сайтов

Загрузчик веб-сайтов — это еще один инструмент, который можно использовать для локального архивирования веб-сайтов. Одна вещь, которая вам понравится в инструменте загрузки веб-сайтов, заключается в том, что он доступен как онлайн-инструмент и, как таковой, не зависит от платформы.

Несмотря на то, что это веб-инструмент, он загружает все необходимые ресурсы в каталог веб-сайта — это означает, что файлы JavaScript, файлы CSS и даже изображения загружаются для вас локально, чтобы вы локально придавали ощущение локальной копии электронной копии сайта. Еще одна вещь, которая вам понравится в этом инструменте, это то, что его можно использовать совершенно бесплатно.

SitePuller

Когда дело доходит до загрузки веб-сайта и создания его и всех его ресурсов, включая изображения, доступными локально, веб-приложение SitePuller не является легкой задачей. Этот инструмент доступен в Интернете и не требует от вас установки какого-либо программного обеспечения для использования — вы можете получить к нему доступ из любого браузера по вашему выбору — с любой операционной системой и платформой.

Этот инструмент преобразует веб-сайт в zip-файл за считанные минуты. Веб-сайт SitePuller также поддерживает загрузку веб-сайтов с Wayback Machine, что удобно для загрузки веб-сайтов, которые больше не доступны. Этот инструмент также поможет вам скопировать шаблон веб-сайтов.

Cyotek WebCopy

Cyotek WebCopy — это простой в использовании минималистичный загрузчик веб-сайтов, который поставляется без ценника — все, что вам нужно, это загрузить и начать использовать.

Этот инструмент проверит HTML-разметку веб-сайта и попытается обнаружить все связанные ресурсы, такие как другие страницы, изображения, видео, файлы, и загрузить все на ваше устройство, чтобы не было никакой разницы между загруженной копией и реальный веб-сайт на момент загрузки.

Хотя этот инструмент бесплатный, минималистичный и простой в использовании, у него есть один недостаток — он плохо работает с веб-сайтами, богатыми JavaScript.

HTTrack Website Copier

HTTrack Website Copier поможет вам создать локальную копию веб-сайта путем рекурсивного поиска URL-адресов на сайте, загрузки страниц и других ресурсов сайта (изображений, CSS и JS). файлов) до тех пор, пока не появится новый URL для сканирования.

файлов) до тех пор, пока не появится новый URL для сканирования.

Этот инструмент существует уже некоторое время и помог многим пользователям Интернета преобразовать веб-сайт в автономный сайт. Основная неудача, которую я вижу в этом проекте, заключается в том, что он кажется заброшенным, поскольку последний раз он обновлялся в 2017 году. Инструмент доступен как для Windows, так и для Linux, а размер файла довольно мал. Установка быстрая, а использование простое.

SiteSucker

Приложение SiteSucker — это приложение для Macintosh, доступное для платформ Mac и iOS. С помощью SiteSucker вы можете загрузить веб-сайт и сделать его локально доступным в Интернете. Это позволит вам поделиться веб-сайтом и предоставить пользователям, не имеющим доступа к Интернету, доступ к нему, как если бы они были подключены к Интернету.

Он загружает все активы веб-сайта, включая изображения, видео и файлы, и дублирует структуру сайта локально, создавая ощущение, что вы получаете доступ к нему в Интернете, в то время как на самом деле вы делаете это в автономном режиме. Этот инструмент доступен на многих международных языках, а также имеет профессиональную версию с расширенными функциями.

Этот инструмент доступен на многих международных языках, а также имеет профессиональную версию с расширенными функциями.

SurfOffline

Должен признаться, мне нравится название этого загрузчика сайта из-за его творчества. Однако дело не только в названии — загрузчик также является одним из лучших загрузчиков на рынке. Одна вещь, которую вы заметите, это простой интерфейс, с которым поставляется этот инструмент, хотя на самом деле это продвинутый инструмент с мощными функциями.

Мастер установки проведет вас через настройку загрузки для веб-сайтов. Вы можете использовать его для загрузки всего веб-сайта или его части. Он быстрый и может обрабатывать около 100 страниц одновременно, что позволяет загружать его за короткий промежуток времени.

Веб-сайт eXtractor

Инструмент для веб-сайта eXtractor является одним из лучших загрузчиков веб-сайтов, которые вы можете использовать для простой и эффективной загрузки всего веб-сайта или его части. Инструмент имеет интуитивно понятный дизайн, в котором легко разобраться даже новичкам.

Инструмент имеет интуитивно понятный дизайн, в котором легко разобраться даже новичкам.

Пока он работает, я чувствую, что разработчикам нужно немного поработать, поскольку в настоящее время у инструмента нет собственного веб-сайта — его можно загрузить только со сторонних веб-сайтов. Если инструмент бесплатный, я пойму, но для платного инструмента не иметь веб-сайта — это то, чего я не понимаю. С точки зрения производительности, Website eXtractor можно назвать превосходным, поскольку он может загружать около 100 файлов за раз.

Web2Disk

Web2Disk сделает веб-сайт доступным локально для просмотра без доступа в Интернет после завершения его загрузки. Вы можете свободно перемещать папку и использовать ее где угодно.

С помощью этого инструмента вы можете скопировать веб-сайт на компакт-диск или USB-диск, и он будет работать нормально — используются относительные ссылки, поэтому перемещение папки с содержимым веб-сайта не нарушит работу сайта. Этот инструмент не бесплатный — он имеет свою цену, но вы можете использовать его бесплатную пробную версию для начала, а если вам это нравится, вы можете совершить покупку.

Этот инструмент не бесплатный — он имеет свою цену, но вы можете использовать его бесплатную пробную версию для начала, а если вам это нравится, вы можете совершить покупку.

NCollector Studio

NCollector Studio является продуктом Colluna Software. Это программное обеспечение является одним из приложений, которые вы можете использовать для преобразования веб-сайта в документ, к которому вы можете получить доступ локально.

NCollector — это комплексное решение, отвечающее вашим потребностям, независимо от того, являетесь ли вы профессионалом или домашним пользователем. Это программное обеспечение может не быть популярным по сравнению с теми, которые обсуждались выше, но оно работает достаточно хорошо. Этот инструмент необходимо загрузить и установить, прежде чем вы сможете его использовать.

Offline Explorer

Offline Explorer — это еще один загрузчик веб-сайтов, который вы можете использовать для загрузки веб-сайтов в локальное хранилище и доступа к ним в автономном режиме, как если бы вы обращались к ним онлайн. Этот инструмент можно считать дорогим, учитывая, что многие из загрузчиков в списке бесплатны. Лицензионный сбор для Offline Explorer составляет 79 долларов.

Этот инструмент можно считать дорогим, учитывая, что многие из загрузчиков в списке бесплатны. Лицензионный сбор для Offline Explorer составляет 79 долларов.

Однако этот инструмент обладает расширенными функциями. Некоторые из его функций включают в себя простоту и гибкость, наличие хромового движка, возможность даже захватывать сайты социальных сетей, возможность устанавливать приоритет для файлов и многое другое.

Archivarix

Программа Archivarix очень проста в использовании. С инструментами, предоставляемыми Archivarix, вы можете сделать многое, связанное с копированием веб-сайта. Некоторые из инструментов, которые вы можете получить от Archivarix, включают инструмент для восстановления веб-сайта с Wayback Machine, загрузку работающего веб-сайта и плагин WordPress.

С помощью этого инструмента вы можете не только загрузить веб-сайт и сделать его локально доступным в автономном режиме, но вы также можете загрузить веб-сайт, который когда-то был онлайн, но был отключен — при условии, что веб-сайт был захвачен веб-архивом Wayback Machine.

Webscrapbook

Глядя на приведенный выше список, вы видите, что в нем нет расширения для браузера — если вы ищете расширение для браузера, то Webscrapbook — это предпочтительный загрузчик. Webscrapebook — это расширение для браузера Firefox, которое можно использовать для загрузки веб-сайта и его локального доступа в автономном режиме в локальном хранилище или для копирования на компакт-диск или USB-накопитель.

Одна вещь, которую вам нужно знать о Webscrapebook, это то, что вам нужно будет найти руководство по его установке. ссылка на него выше для GitHub; вам нужно будет загрузить и установить его на свой Firefox, чтобы использовать его.

WebWhacker

Загрузка веб-сайта WebWhacker 5.0 является последней в нашем списке. Это программное обеспечение существует уже некоторое время, и большое количество пользователей Интернета использовали его для преобразования веб-сайтов в локальные сайты, доступные для просмотра в автономном режиме.