Распространенные ошибки — Вебмастер. Справка

Одним из важнейших свойств интернета является свобода представления информации и большое разнообразие всевозможных форматов. Поисковая система Яндекс стремится корректно индексировать и ранжировать все документы, которые ей доступны. Однако, к сожалению, все еще возможны ситуации, когда та или иная информация будет воспринята нашими роботами не так, как это предполагалось вебмастерами:

Навигация через скрипты. Наиболее распространенным способом размещения ссылки является HTML тег <A>. Но существуют и другие способы навигации между страницами. Например, можно использовать технологии JavaScript или Flash. Робот Яндекса не переходит по таким ссылкам, поэтому следует дублировать ссылки, реализованные при помощи скриптов, обычными текстовыми ссылками.

Использование <iframe>. Для корректного ранжирования документа не рекомендуется использовать тег <iframe>, так как поисковый робот Яндекса не индексирует документы, подгружаемые в него.

Избыточное автоматическое перенаправление (редиректы). По возможности избегайте использования редиректов. Редирект может быть полезен только в том случае, если адреса страниц меняются по техническим причинам и необходимо перенаправить пользователя на новый адрес страницы. Подробно см. в разделе Обработка редиректов.

Адреса страниц. Каждая страница должна быть доступна по единственному и постоянному адресу. Желательно, чтобы адреса страниц сайта не содержали идентификаторы сессий, по возможности они также должны быть избавлены от списков cgi-параметров, заданных в явном виде.

Клоакинг. Избегайте ситуаций, когда поисковый робот индексирует одно содержание страницы, а пользователь при обращении к этой странице получает другое. Например, в версиях сайта для разных регионов, о которых будет рассказано в разделе «Региональность».

Изображения вместо текста.

Избегайте создания страниц, не содержащих текст. Если главная страница сайта выполнена в виде изображения, являющегося ссылкой на основную часть сайта, и сама не содержит текста, это может помешать ранжированию сайта. Это происходит из-за того, что большинство внешних ссылок, как правило, ведут на главную страницу сайта, и если это документ без текста, надежность определения содержания документа несколько уменьшается.

Избегайте создания страниц, не содержащих текст. Если главная страница сайта выполнена в виде изображения, являющегося ссылкой на основную часть сайта, и сама не содержит текста, это может помешать ранжированию сайта. Это происходит из-за того, что большинство внешних ссылок, как правило, ведут на главную страницу сайта, и если это документ без текста, надежность определения содержания документа несколько уменьшается.Soft 404. Одна из распространенных ошибок заключается в замене сообщения об ошибке 404 (страница не найдена) для несуществующих страниц на страницу-заглушку, которая возвращается с кодом ответа 200 (ОК). В этом случае поисковая система считает, что страница с некорректным адресом существует, и не удаляет ее из своей базы. Это приводит к более медленному индексированию полезных страниц на сайте.

Движок сайта. Следите за корректностью работы программного обеспечения сайта — ошибки в скриптах сайта могут привести к тому, что одни и те же страницы при переходе на них из разных разделов будут иметь разные адреса.

Это может негативно отразиться на индексировании сайта. Кроме того, ошибки в «движках» могут быть использованы злоумышленниками (например, для размещения ссылки на вредоносный сайт).

Это может негативно отразиться на индексировании сайта. Кроме того, ошибки в «движках» могут быть использованы злоумышленниками (например, для размещения ссылки на вредоносный сайт).

Узнавать об ошибках индексирования, если таковые возникают, можно в сервисе Яндекс.Вебмастер.

Примечание.Чем проще и понятнее будет устроен ваш сайт, тем лучше он будет индексироваться.

К следующему разделу

Как проверить индексацию всего сайта и конкретной страницы в Яндексе и Google: инструкция по сервисам и рекомендации

Технические доработки под требования SEO и оптимизация структуры сайта – это первостепенные моменты в продвижении ресурса, но если поисковые системы не знают о нем, то есть он не проиндексирован, то продвижение невозможно.

Что же такое индексация? Это добавление поисковыми роботами собранных сведений о ресурсе в базы данных. Дальнейшее ранжирование происходит уже по проиндексированным страницам. Предлагаем несколько простых и понятных способов проверки страниц, которые «видят» поисковые системы.

Предлагаем несколько простых и понятных способов проверки страниц, которые «видят» поисковые системы.

Рассмотрим каждый вариант подробнее.

Оглавление:

-

Проверка индексирования сайта через панель Яндекс.Вебмастера и Google Search Console

-

Проверка количества проиндексированных страниц в ПС при помощи операторов

-

Анализ индексации сайта при помощи плагинов и расширений

-

Отслеживание проиндексированных страниц с помощью online сервисов

-

Программы для контроля индексации сайта

-

Проверка индексации страницы

-

Почему сайт может не индексироваться

-

Выводы SEO-специалиста Веб-центра

1.

Проверка индексирования сайта через панель Яндекс.Вебмастера и Google Search Console

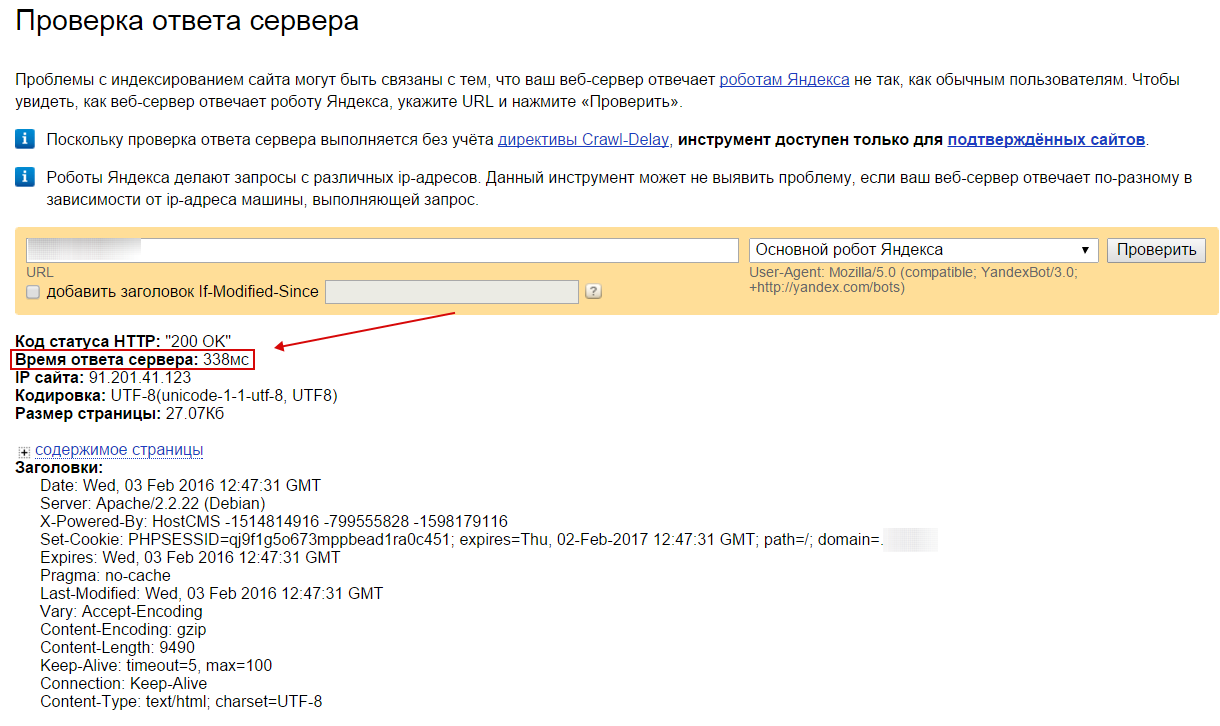

Проверка индексирования сайта через панель Яндекс.Вебмастера и Google Search ConsoleБесплатный и достоверный способ с использованием сервисов для вебмастеров.

Яндекс.Вебмастер

В первую очередь выполняем авторизацию в аккаунте Яндекса и входим в сервис Вебмастер. Далее вводим url ресурса и нажимаем кнопку «Добавить».

Добавление сайта в вебмастер Яндекса

После прохождения верификации переходим в панель и нажимаем вкладку «Индексирование» – «Страницы в поиске». Тут представлены страницы веб-сайта, участвующие в поиске Яндекса.

Просмотр страниц в поиске Яндекса через панель для вебмастеров

Также количество загруженных и проиндексированных страниц можно посмотреть в сервисе на странице «Мои сайты».

Просмотр количества страниц в поиске на вкладке «Мои сайты»

Для анализа список страниц можно скачать из сервиса файлом в форматах . xls и .csv.

xls и .csv.

Google Search Console

Аналогично вебмастеру Яндекса проходим авторизацию в аккаунте Google, входим в сервис search.google, вводим url сайта и нажимаем кнопку «Добавить ресурс».

Пример верификации в панели вебмастеров в Гугл

После подтверждения прав на сайт для проверки индексации ресурса в панели Вебмастера Гугл переходим во вкладку «Индекс» – «Покрытие».

Просмотр страниц в ПС Гугл через панель для вебмастеров

Нужно учитывать, что информация в Google Search Console примерная, так как в отчете показывается статистика после последнего обхода, то есть количество страниц может быть другим на текущий момент проверки.

Примеры проверки индексации сайта

На скриншоте – сайт, у которого нет проблем с индексацией в Яндексе

На скриншоте – сайт, у которого регулярно удаляются страницы из поиска Яндекса

На скриншоте – сайт, у которого регулярно удаляются страницы из поиска Гугл

2.

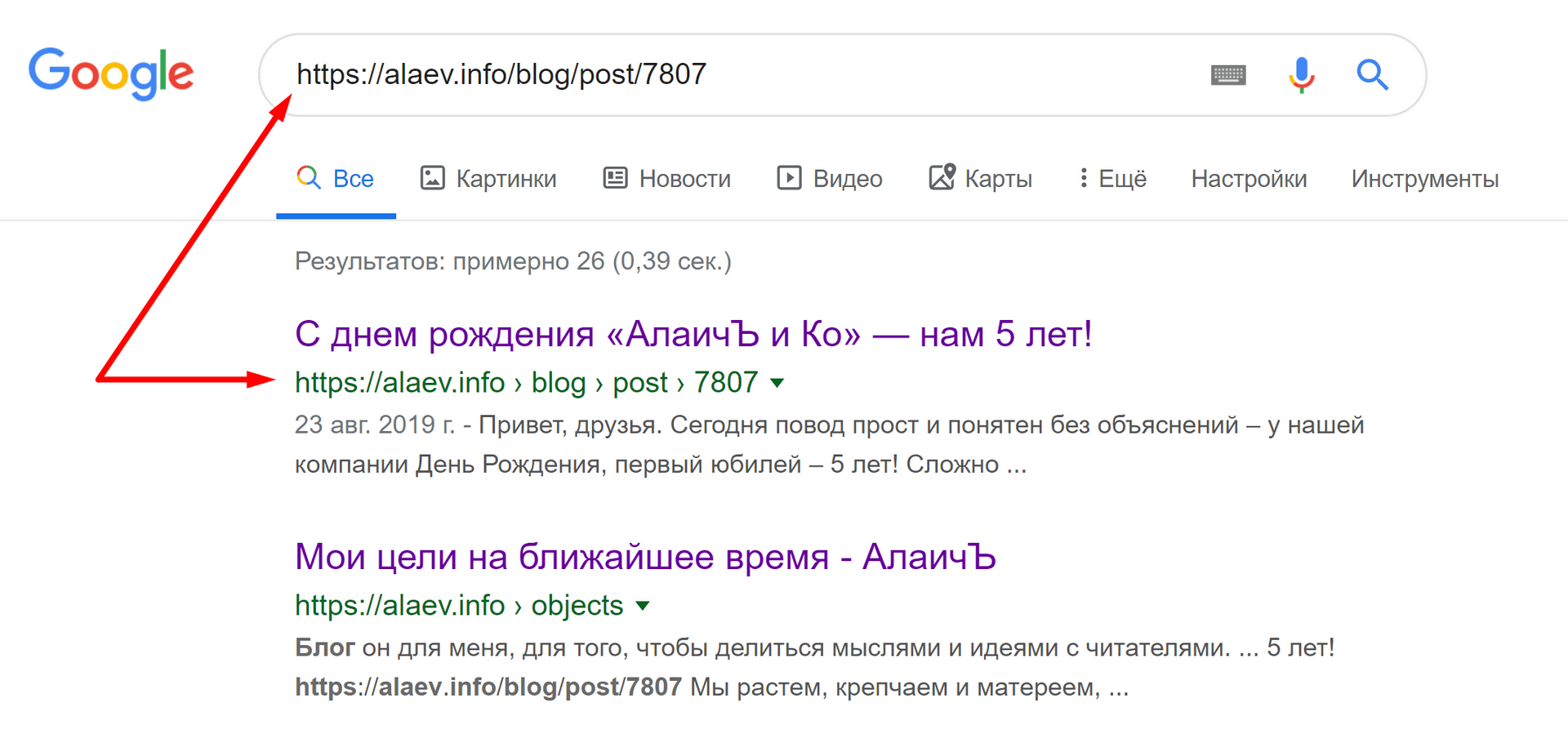

Проверка количества проиндексированных страниц в ПС при помощи операторов

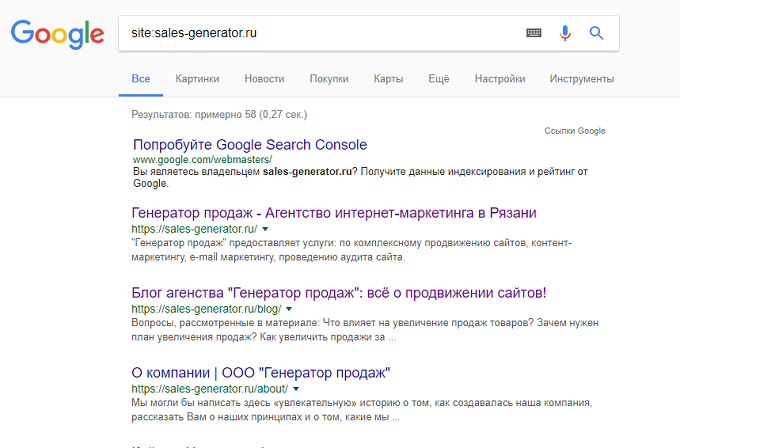

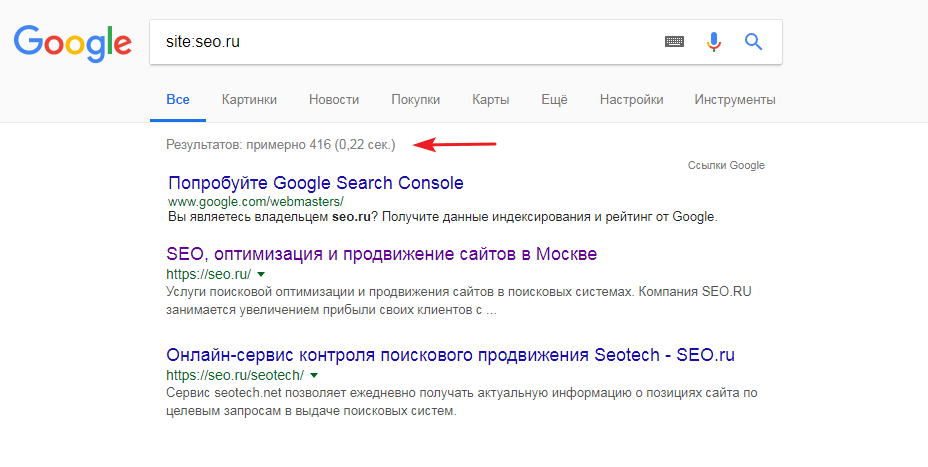

Проверка количества проиндексированных страниц в ПС при помощи операторовПрименяя документный оператор «site» возможно увидеть примерное количество страниц в индексе. Для использования этого параметра введите в строке поиска «site:адрес_интересующего_сайта», например «site:https://www.bordur32.ru».

Пример использования оператора «site» в Яндексе

Пример использования команды «site» в Гугле

3. Анализ индексации сайта при помощи плагинов и расширений

Чтобы не вводить операторы в строке браузера перед url используется данный автоматизированный способ. Скачиваем бесплатный букмарклет для браузера (небольшой по размеру скрипт, сохраняемый в закладках) и кликаем на специальную иконку находясь на сайте.

Пример использования плагина SEO-tools

Установить расширение вы можете по ссылке

Пример использования расширения RDS bar

Установить расширение вы можете по ссылке

4.

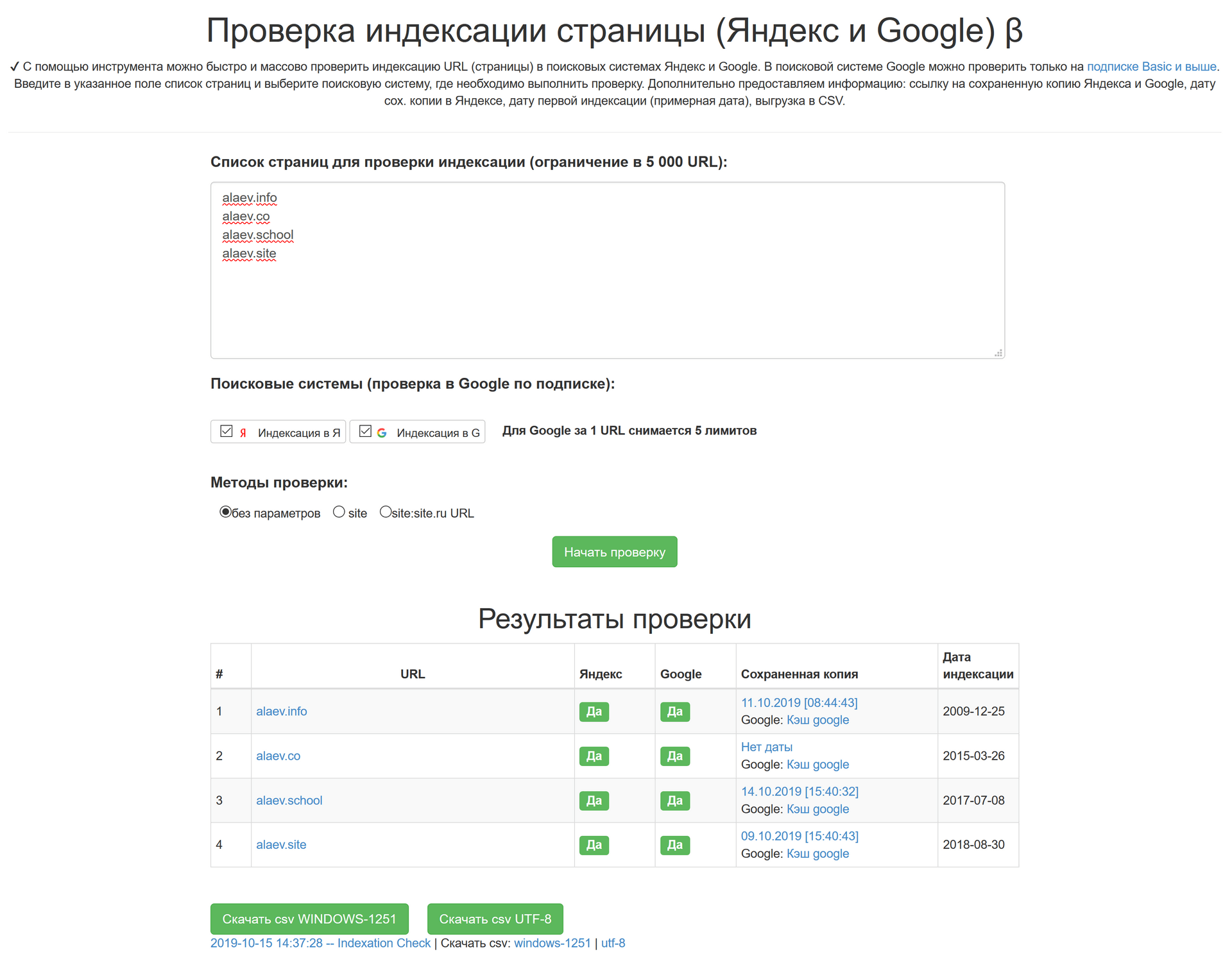

Отслеживание проиндексированных страниц с помощью online сервисов

Отслеживание проиндексированных страниц с помощью online сервисовЕще один способ проверки индексации это использование сторонних ресурсов. Например, переходим на сайт a.pr-cy.ru вводим url и нажимаем «Анализировать».

Скриншот проверки индексации сайта в a.pr-cy.ru

Индексацию сайта можно проверить и в других сервисах, например: seogadget.ru, xseo.in и других.

5. Программы для контроля индексации сайта

Существуют бесплатные (Site-Auditor) и платные программы (Semonitor) для анализа сайта и проверки страниц в индексе. Выбранное программное обеспечение скачиваем и устанавливаем на ПК. В строку ввода добавляем url проверяемого сайта.

Скриншот фрагмента анализа сайта в программе Site-Auditor

Проверка индексации страницы

Иногда требуется не только узнать сколько страниц проиндексировано в Яндексе и Google, но и нужно определить индексируется ли какая-то конкретная страница. Это можно сделать следующими способами:

Это можно сделать следующими способами:

1. В панели для вебмастеров:

-

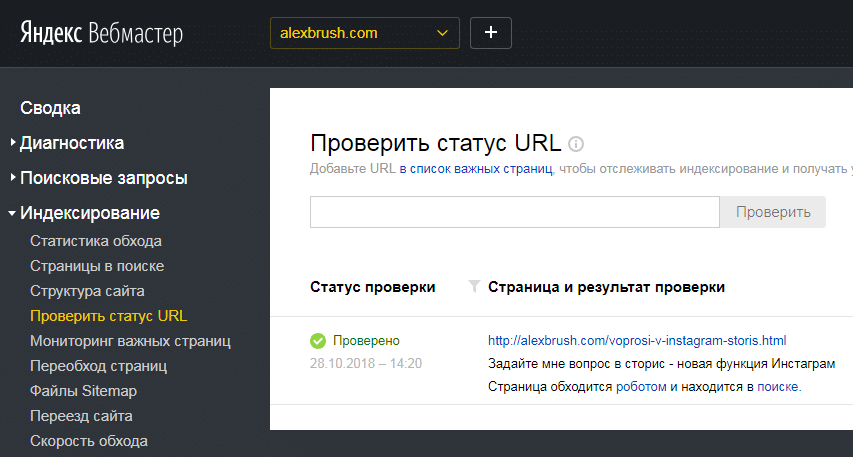

Яндекс – следовать по пути «Индексирование» – «Проверить статус URL». В поле для ввода данных ввести либо полный урл интересующей страницы, либо путь от корня сайта начинающийся с «/». Далее нажать кнопку «Проверить».

Проверяемая страница в поиске Яндекса

-

Google – перейти во вкладку «Проверка URL» и ввести урл интересующей страницы.

2. Оператор «url»

В строке поиска вводим специальный оператор. Запрос будет выглядеть так: «url:адрес_интересующей_страницы».

Пример использования оператора «url» в ПС Яндекс

3. Оператор «info»

В поисковой системе Google можно воспользоваться оператором «info». Запрос в строке поиска будет выглядеть следующим образом: «info:адрес_интересующей_страницы»

Запрос в строке поиска будет выглядеть следующим образом: «info:адрес_интересующей_страницы»

Пример использования оператора «info» в ПС Гугл

Почему сайт может не индексироваться

В идеале страницы ресурса должны быть проиндексированы и их количество в поисковых системах должно быть примерно одинаковым. Но так бывает далеко не всегда. Рассмотрим причины мешающие индексации сайта.

Ошибки в файле robots.txt

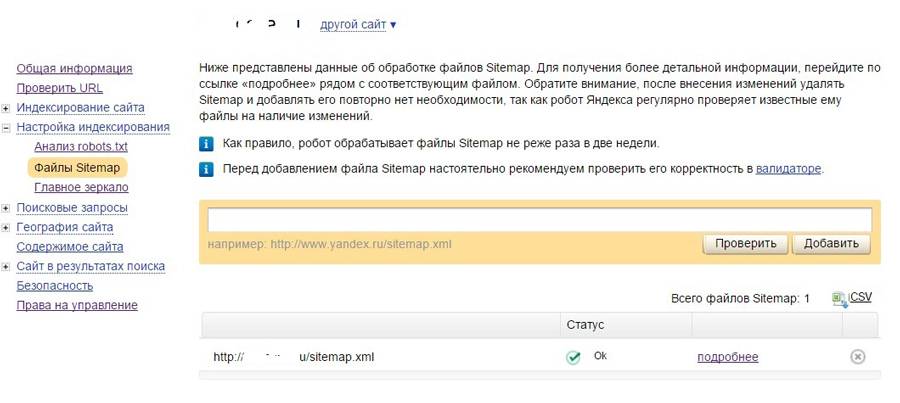

Файл robots.txt – это текстовый документ в формате .txt лежащий в корневом каталоге веб-сайта, запрещающий или разрешающий индексирование страниц роботам ПС. Поэтому неправильное использование директив может закрыть от индексации весь сайт или отдельные страницы ресурса.Отсутствие файла sitemap.xml

Карта сайта (файл sitemap.xml) – это специальный документ расположенный в корневом каталоге, содержащий ссылки на все страницы ресурса. Этот файл помогает поисковым роботам оперативно и качественно индексировать ресурс. Поэтому в него нужно добавлять только те страницы, которые должны попасть в индекс.

Этот файл помогает поисковым роботам оперативно и качественно индексировать ресурс. Поэтому в него нужно добавлять только те страницы, которые должны попасть в индекс.

Новый сайт

Процесс индексации нового ресурса занимает некоторое время. Поэтому в данном случае нужно просто подождать, не забывая контролировать процесс индексации.

Приватные настройки

В некоторых CMS, таких, как WordPress и Megagroup, существует возможность скрыть от индексации страницы через админку сайта, данные настройки могут стоять по умолчанию.

Тег «noindex»

Страницы могут быть закрыты от индекса в коде с помощью мета тега name=»robots» content=»noindex, nofollow» />. Нужно проверить его наличие и либо убрать из кода, либо заменить на «index» и «follow».

Мусорные страницы

Еще одной из причин может стать большое количество мусорных страниц, не предоставляющих полезного и уникального контента в рамках сайта. Такие страницы нужно закрывать от индексации, чтобы не возникали проблемы с индексированием ресурса и робот не тратил время на посещения этих страниц.

Такие страницы нужно закрывать от индексации, чтобы не возникали проблемы с индексированием ресурса и робот не тратил время на посещения этих страниц.

Также причиной не индексации страниц ресурса могут быть ошибки сканирования, блокировка сайта в файле .htaccess, дубли страниц, не уникальный контент, низкий uptime хостинга, медленная скорость загрузки сайта, баны и фильтры ПС.

Выводы SEO-специалиста Веб-центра

Главная цель как владельца сайта так и SEO-специалиста добиться индексирования нужных страниц ресурса. Для этого нужно регулярно контролировать страницы в поиске Яндекса и Google, проверять сервисы для вебмастеров на наличие ошибок на сайте, наполнять его уникальным и полезным контентом, следить и оптимизировать скорость загрузки ресурса.

Для ускорения процесса индексации нужно подтвердить права на сайт в Яндекс.Вебмастер и Google Search Console и разместить в них ссылку на файл sitemap. xml, также можно отправлять на переобход важные страницы ресурса.

xml, также можно отправлять на переобход важные страницы ресурса.

Подробно эту тему мы разобрали в видео на нашем Ютуб-канале

что это такое, как происходит, как ускорить и проверить индексацию

Нравится статья?

Понравится и работать с нами.

НачатьИндексация сайта в поисковых системах – это то, без чего SEO продвижение невозможно. Если страниц вашего сайта нет в индексе, они не выводятся в поисковой выдаче, а значит, в конкуренции за верхние позиции вы пока не участвуете, и пользователи из поиска не могут перейти к вам.

Разбираемся, как Яндекс и Google индексируют сайты, можно ли ускорить и проконтролировать процесс и каким страницам индексация не нужна.

Что такое индексация и как она происходит

Поисковые системы по запросу выдают пользователям подходящие страницы за пару секунд. Естественно, в это время роботы не перебирают реальные сайты – такой поиск тянулся бы часами. Для ускорения поисковики обращаются к собственной, заранее собранной базе данных. Эта база – и есть индекс.

Естественно, в это время роботы не перебирают реальные сайты – такой поиск тянулся бы часами. Для ускорения поисковики обращаются к собственной, заранее собранной базе данных. Эта база – и есть индекс.

Поисковики индексируют сайт автоматически, с помощью поисковых роботов – их называют пауками или краулерами. Упрощенно это выглядит так:

- Пауки постоянно отслеживают новые сайты и страницы в интернете.

- Попав на сайт, робот сканирует его. Если в корневой папке лежит правильно заполненный файл robots.txt (а мы настоятельно советуем его прописать и поместить туда), краулер быстрее поймет, какие страницы нужно индексировать, а какие – нет.

- На каждой странице робот в автоматическом режиме оценивает важнейшие элементы, от которых зависит позиция при ранжировании (ключевые запросы, текст, структуру, метатеги и пр.).

- Проиндексированные страницы передаются в базу данных.

В каждый визит робот обрабатывает не так много страниц, до 30 штук, чтобы не перегружать ваш сервер.

В каждый визит робот обрабатывает не так много страниц, до 30 штук, чтобы не перегружать ваш сервер. - После индексации сайта страницы начинают отображаться в выдаче, ведь теперь поисковая система знает о них.

- В дальнейшем робот продолжает посещать ваш сайт, чтобы просканировать и добавить в базу новые страницы. Также поисковики могут удалять страницы из индекса, обнаружив на них технические ошибки. Если вы ежедневно публикуете контент, робот может заходить к вам несколько раз в день, а если сайт долго остается без изменений, то и поисковики будут реже обращать на него внимание (до 3 раз в месяц).

Индексация сайта в Яндексе сразу после запуска может занять до 1 месяца, а в Гугл – до 1 недели.

Как быстрее попасть в индекс

Для успешного продвижения в Яндексе и Google важно, чтобы новые страницы как можно скорее попадали в индекс и начинали ранжироваться. Поэтому советуем использовать возможности для ускоренной индексации сайта.

Как привлечь внимание поисковиков и быстрее занять место в выдаче:

- Обязательно составить служебный файл robots.

txt и карту сайта Sitemap в помощь поисковым ботам.

- Войти в панели управления Google Search Console и «Яндекс.Вебмастер» и оставить заявку на индексацию конкретных страниц.

- Обеспечить надежность и скорость работы сайта – робот при обнаружении проблем на сайте снижает частоту обхода.

- Позаботиться о качественных внешних ссылках, которые добавят вам «веса» и повысят шансы на быструю индексацию сайта по ключевым словам.

- Регулярно добавлять новые страницы и публиковать свежие материалы – тогда поисковики будут чаще обращать внимание на ваш ресурс. Обязательно добавлять новые материалы в «Оригинальные тексты» в Яндекс.Вебмастере.

- Оптимизировать сайт в плане удобства для пользователей – юзабилити. В первую очередь, важны понятный каталог и система навигации, сеть перекрестных внутренних ссылок (перелинковка) – всё, что ускоряет перемещение бота по вашему сайту и помогает ему проиндексировать больше страниц за один раз.

Кстати, быстро индексировать страницы нужно не только новым сайтам. Если вы обновили цены или описания в каталоге, прописали привлекательные метатеги Description или загрузили в блог горячую новость, вам тоже важно, чтобы индексацию не пришлось ждать месяцами.

Если вы обновили цены или описания в каталоге, прописали привлекательные метатеги Description или загрузили в блог горячую новость, вам тоже важно, чтобы индексацию не пришлось ждать месяцами.

Как проверить индексацию сайта

В первые недели после запуска нового сайта важно проверить, попали ли нужные страницы в индекс поисковых систем и сколько вообще страниц проиндексировано. Но и в дальнейшем советуем держать руку на пульсе.

Вот основные способы проверить индексацию сайта в поисковых системах:

- Вручную через брендовые запросы

- Через оператор site в поисковой строке

- В Яндекс.Вебмастере или Search Console в Гугл

- Автоматически с помощью плагинов, скриптов или специальных сервисов

Вводим в строке поиска название компании и просматриваем первую пару страниц выдачи. Способ самый простой, без технических сложностей, но не быстрый и не очень удобный.

Чуть сложнее, но точнее: вбиваем в поиске Яндекса или Гугл оператор site, а после него – адрес сайта.

Например, наберем URL zamkitut.ru для проверки индексации сайта. В результатах поиска будут только проиндексированные страницы заданного сайта, и ничего не придется выбирать вручную.

Способ для тех, у кого есть доступ к панели вебмастера. В Гугл нужно открыть вкладку «Индекс Google» и выбрать «Статус индексирования», а в Яндекс.Вебмастере развернуть меню «Индексирование сайта», а затем «Страницы в поиске». Здесь можно посмотреть не только текущее количество страниц в индексе, но и динамику.

Сервисы и программы – быстрый и надежный способ проверить индексацию сайта онлайн. Не вручную вбивать запросы: небольшие программы для проверки обычно можно сохранить в браузере, как закладки, и запускать при необходимости.

Советуем попробовать плагин RDS bar для разных браузеров, а также программы наподобие Netpeak Spider или Netpeak Checker.

Так выглядит рабочее окно Netpeak Spider: программа выдает много дополнительной информации, помимо количества страниц в индексе.

3 и 4 способ – самые информативные и удобные, мы советуем мониторить индексацию по ходу продвижения сайта именно так. В специальной программе или на панели вебмастера вы увидите, когда последний раз Яндекс индексировал сайт, какие именно страницы попали в индекс, какие проблемы выявили поисковики и т.д.

Почему сайт не индексируется и как это исправить

Иногда с индексацией возникают проблемы: сайт целиком или отдельные страницы перестают выводиться в поисковой выдаче. Почему Яндекс не индексирует сайт и как это исправить:

- Прошло недостаточно времени. Если сайт или группа страниц появились недавно, поисковой робот мог просто не успеть их проиндексировать – используйте наши приемы ускорения из списка выше.

- Неправильно заполнен файл robots.txt. Лучше доверить работу с этим служебным файлом программистам, потому что случайная ошибка в нем может запретить индексировать сайт без вашего ведома.

- Критичные для поисковиков ошибки на сайте – их важно находить и вовремя исправлять.

- Нет карты сайта (SiteMap). Обязательно пропишите ее и добавьте в корневую папку – карта поможет ускорить индексацию сайта.

- На сайте есть дубли страниц или контент, полностью скопированный с других ресурсов – такие страницы принципиально не индексируются.

- Сервер работает с перебоями. Если сайт периодически недоступен или загружается слишком медленно, могут быть проблемы с индексацией, так что есть смысл переехать на более надежный хостинг.

Как закрыть сайт от индексации и когда это нужно

Иногда бывает нужно запретить индексацию сайта или отдельных страниц.

Зачем это делается:

- Чтобы в выдачу не попадали служебные страницы сайта: личный кабинет пользователя, корзина, панель управления и прочее.

- Чтобы поисковой робот быстрее добрался до целевых страниц и проиндексировал их, а не тратил время на малозначительный контент, который не нужно продвигать.

- Чтобы в индекс не попали дубли страниц (поисковики это не любят).

Пример страницы, которую нужно закрыть от индексации – корзина в интернет-магазине дверной фурнитуры.

Основные способы «спрятать» ненужные страницы или разделы от поисковиков:

- В файле robots.txt закрыть сайт от индексации позволяет директива Disallow – она прописывается рядом с адресами страниц, которые не должны попасть в выдачу.

- В коде страницы можно использовать тег «noindex» – он закрывает от индексации не ссылки, а только часть текста, заключенную внутри тега.

- Атрибут rel=«nofollow» – применяется к конкретной ссылке и указывает поисковым роботам, что по ней не нужно переходить. Этот атрибут понимают все поисковики.

- Мета-тег robots – он дает поисковым системам указания насчет индексации. Если в содержимом этого мета-тега прописать «noindex, nofollow», страница не будет индексироваться.

Важно: «noindex» считывает и понимает только Яндекс. Для управления индексацией в Google применяйте другие способы из этого списка.

Что такое индексация — самый полный гайд

Часто происходит путаница в терминологии: под индексацией иногда подразумевают сканирование сайта или совокупность и сканирования и индексации. В этом нет большой ошибки, часто путаницу вносят сами мануалы поисковых систем. Иногда в текстах Яндекса и Гугла можно увидеть использование термина индексация в разных контекстах, например:

Индексация сайта простыми словами

Так что же такое индексация: если кратко, то индексация (или индексирование, indexing) – один из процессов работы поисковых систем по построению поисковой базы в результате которого содержимое страниц попадает в индекс поисковой системы.

Для большей ясности приведу терминологию, а потом опишу все процессы.

Терминология

Планировщик (Scheduler) – программа, которая выстраивает маршрут обхода интернета роботами исходя из характеристик страниц, таких как частота обновления документов, востребованность этих страниц, цитируемость.

Crawler, Spider (Паук) Googlebot, YandexBot. Робот, ответственный за обход и скачивание страниц из интернета в порядке очередности, который задается планировщиком. Подразделяются на:

- Основной робот, обходящий контент в порядке общей очереди.

- Быстрый робот (быстроробот или быстробот). Робот, который использует свежий индекс, на основе группы заданных хабовых страниц с важной, часто обновляемой информацией, например, с новостями популярных СМИ.

Сканирование (Crawling) – процесс загрузки страниц краулером в результате чего они попадают в хранилище, в виде сохраненных копий.

Краулинговый спрос: это то, как часто и в каком объеме робот бы хотел сканировать конкретные страницы.

Краулинговый лимит: ограничения скорости сканирования на стороне сайта, связанные с производительностью сайта или заданным вручную ограничением.

Краулинговый бюджет – это совокупность краулингового спроса и доступной скорости сканирования сайта (краулингового лимита). Простыми словами – это то сколько робот хочет и может скачать страниц.

Сохраненная копия – необработанная копия документа на момент последнего сканирования.

Поисковый индекс – информация со страниц, приведенная в удобный для работы поисковых алгоритмов формат. Список всех терминов и словопозиций где и на каких страницах они упоминаются. Информация хранится в базе в виде инвертированного индекса. Схематический пример:

Индексация – процесс загрузки, анализа содержимого документа документа с последующим включением в поисковый индекс.

Поисковая база – это совокупность поискового индекса, сохраненных страниц и служебной информации о документах, таких как заголовки, типы и кодировка документов, коды ответов страниц, мета теги и др.

Как происходит сканирование сайта

Так как ресурсы поисковых систем не безграничны, планировщик составляет очередь обхода страниц, исходя критериев их полезности, востребованности, популярности и др. Каждый сайт получает свой краулинговый бюджет исходя из скоростных характеристик сайта и таких критериев как:

- Доля полезных/мусорных страниц на сайте, дубликаты

- Спамные и малополезные страницы

- Наличие бесконечной генерации страниц, например, некорректной фасетной навигации

- Популярность страниц

- Насколько актуальные версии страниц сайта, содержащиеся в поисковой базе

Робот в постоянном режиме скачивает страницы и помещает их в хранилище, заменяя старые версии. Мы можем увидеть их в виде сохраненных копий. Далее уже происходит индексация страниц.

Как проходит индексация сайта

Индексацию можно условно разбить на следующие процессы:

- Загрузка и разбор страницы по элементам: текст, мета-теги, микроразметка, изображения, видео и другой контент и служебные данные.

- Анализ страницы по определенным параметрам, например: разрешена ли она к индексации, сканированию, является ли неглавной копией другой страницы, содержит ли страница малополезный, спамный контент и др.

- Если страница успешно прошла все проверки, она добавляется в индекс.

Как проходит индексация сайта в Яндексе

Все описанное в предыдущем пункте справедливо и для Яндекса и для Google. Какие есть особенности индексации у Яндекса?

У Google обновление поисковой базы – непрерывный процесс. В Яндексе обновление происходит во время Апдейтов, примерно раз в три дня. О том что произошло обновление можно узнать по уведомлениям в Яндекс.Вебмастере

Как проверить индексацию

Есть разные способы для проверки статуса индексации сайтов и отдельных его страниц:

- Вебмастер Яндекса

- Панель Google Search Console

- API панели для вебмастеров Yandex/Google

- SEO-сервисы, например Rush Analytics

- Плагины и расширения для браузеров

- Поисковые операторы ПС

- GA/Метрика

- Серверные логи

Выбор сервиса зависит от поисковой системы, а также задачи: узнать сколько страниц всего в индексе, получить список проиндексированных страниц или проверить статус индексации конкретной страницы или списка страниц. Подробнее расписано ниже.

Как узнать сколько страниц проиндексировано на сайте

Расширения для браузера

Быстрые способы проверить статус индексации сайта – расширения и букмарклеты для браузера, например RDS-бар

Сервисы для анализа сайтов

Так же можно проверить с помощью сервисов, таких как pr-cy.ru

Яндекс.Вебмастер и Google Search Console

Если есть доступы к панелям вебмастеров, можно получить количество проиндексированных страниц в панелях вебмастеров:

Яндекс Вебмастер – http://webmaster.yandex.ru

Google Search Console – https://search.google.com/search-console/

С помощью специализированных программ для SEO, например Allsubmitter, Netpeak Checker.

Это может понадобиться когда нужна пакетная проверка параметров чужих сайтов.

Пример проверки числа проиндексированных страниц в Netpeak Checker.

Проверка индексации сайтов в Яндекс:

Проверка индексации сайтов в Google:

Пример проверки индексации сайтов в Яндекс и Google в Allsubmitter.

Как выгрузить список проиндексированных страниц сайта в Яндексе и Google

Яндекс Вебмастер: Отчет индексирование -> Страницы в поиске -> Все страницы

Внизу страницы ссылки на скачивание файла – cуществует ограничение в 50 000 страниц.

Google Search Console: в отчете Покрытие – выбираем нужные типы страниц

Переходим в нужный отчет и скачиваем список страниц в удобном формате. Google отдает только 1 000 страниц.

Поисковые операторы Яндекса

Запрос для поиска страниц в пределах одного домена – url:www.site.ru/* | url:site.ru/* | url:site.ru | url:www.site.ru.

Запрос для поиска с учетом всех поддоменов – site:site.ru

Список операторов и инструкцию по работе с ними можно посмотреть в справке Яндекса.

Ограничение: можно получить только 1000 результатов. Нужны специальные инструменты чтобы скопировать список страниц SERP: расширения браузера, букмарклеты или программы для парсинга выдачи.

Поисковые операторы Google

Запрос для поиска страниц в пределах одного сайта – site:site.ru

Получение списка страниц входа из систем веб-аналитики

Списки страниц входа из органики Яндекса в системах аналитики Яндекс.Метрика и Google.Analytics. Страницы по которым идут переходы с органической выдачи с большой вероятностью индексируются, но для точности рекомендуется проверять индексацию собранных страниц – индекс не статичен и страницы могут выпадать из индекса.

Список страниц по которым сайт показывается в выдаче в Яндекс.Вебмастере

Для выгрузки большого списка страниц из Яндекс.Вебмастера потребуется специальный скрипт.

Плагин для API Google Webmasters: Google Search Analytics for Sheets

Отображает страницы по которым были показы сайта в выдаче.

Преимущества выгрузки списка страниц через API в том что можно получить десятки тысяч страниц, которые с большой вероятностью проиндексированы, в отличие от веб-интерфейса где установлено ограничение по выгрузкам в 1000 страниц.

Серверные логи сайта

Получить список страниц которые посещает робот можно из логов, например с помощью программы SEO Log File Analyser от создателей Screaming Frog.

Как проверить индексацию конкретной страницы в Яндексе и Google

Сервис Яндекс.Вебмастер: Индексирование -> Проверить статус URL

Проверка с помощью оператора: пример запроса url:https://site.com/page/

Сервис Google Search Console: инструмент “Покрытие”

Нужно ввести в указанной на скрине строке поиска URL-адрес своего сайта и откроется отчет о статусе страницы.

Проверка с помощью оператора: пример запроса site:https://habr.com/ru/news/t/468361/

После отмены оператора info остался оператор site, но он выдает не всегда точные данные, можно сократить список результатов с помощью указания уникального текста проверяемой страницы.

Как массово проверить индексацию списка страниц

Для проверки можно использовать SEO-сервисы, например Rush Analytics.

Это позволяет массово проверить индексацию до десятков-сотен тысяч страниц

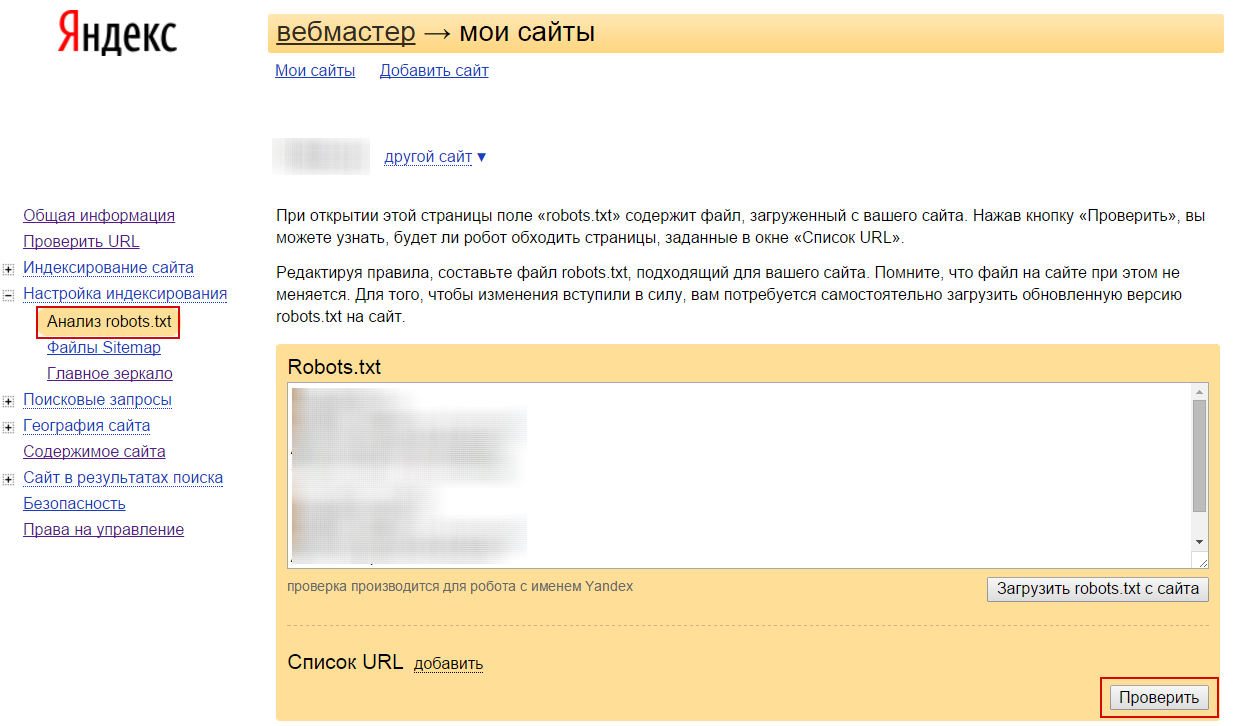

Как проверить разрешена индексация/сканирование страницы в Robots.txt

В Яндексе

Проверить доступна ли роботам страница или содержит запрет можно через. Инструменты -> Анализ robots.txt

В Google

Инструмент проверки файла robots.txt

Важно: если файл robots.txt отдает 404 ошибку, боты считают что разрешено сканирование всего сайта без ограничений. Если файл отдает ошибку 5хх, то Googlebot считает это полным запретом на сканирование сайта, но если ошибка отдается более 30 дней – считает что разрешено сканировать весь сайт без ограничений. Яндекс любые серверные ошибки считает отсутствием файла robots.txt и отсутствием ограничений на обход и индексацию сайта.

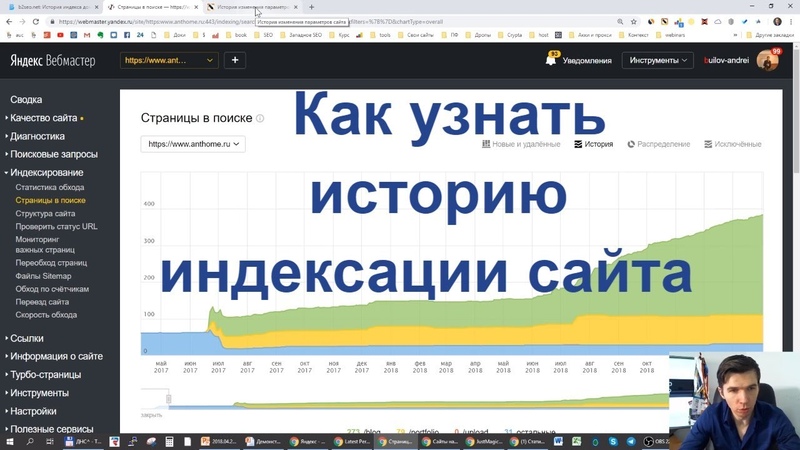

Как узнать динамику числа проиндексированных страниц

С помощью специализированных сервисов, например: https://be1.ru/

С помощью Яндекс Вебмастера: в разделе Индексирование -> Страницы в поиске.

С помощью Google Search Console: в отчете Покрытие.

Почему число проиндексированных страниц может отличаться в разных сервисах?

Нужно понимать что проиндексированные страницы и страницы в поиске это разные сущности. Не все проиндексированные страницы будут включены в поиск и не все страницы в поиске будут показываться через операторы поиска – операторы лишь выводят результаты пустого поиск по сайту а не список всех страниц. Но этого в большинстве случаев достаточно чтобы оценить порядок числа проиндексированных страниц сайта.

Запрет индексации страниц

Запрет индексации с помощью Meta Noindex/X-Robots-Tag

Для гарантированного исключения попадания страниц в индекс можно использовать атрибут Noindex Мета Тега Robots или HTTP-заголовка X-Robots-Tag. Подробнее про этот атрибут можно прочитать тут.

Важно: Использование запрета индексации в через Meta/X-Robots-Tag Noindex вместе с запретом в Robots.txt

При добавлении директивы Noindex в мета-тег Robots и http-заголовок X-Robots-Tag, чтобы ее прочитать, робот должен просканировать страницу, поэтому она должна быть разрешена в файле Robots.txt. Следовательно для точечного запрета индексации страниц иногда требуется снять запрет в robots.txt или добавить директиву Allow, чтобы робот смог переобойти эти страницы.

Несмотря на вышеописанное, запрет в robots.txt в большинстве случаев все таки приведет к тому, что страницы не будут индексироваться, но его нельзя использовать для закрытия персональных данных или страниц с конфиденциальной информацией.

Как запретить индексацию страницы в robots.txt

Стоит сразу упомянуть что запрет в robots.txt не является надежным методом закрытия страниц от индексации.

В файле robots.txt указываются основные директивы для запрета или разрешения обхода/индексации отдельных страниц или разделов сайта.

Важно: Многие ошибочно считают что директива Disallow в Robots.txt служит для запрета индексации страниц, это не совсем так. Основная цель файла Robots.txt – управление трафиком поисковых роботов на сайте, а не индексацией / переиндексацией и разные поисковые системы по разному интерпретируют запрет.

Многие вебмастера не понимают почему после запрета страницы в robots.txt она продолжает находиться в индексе и приносить трафик. Запрет посещения и обновления страницы роботом не означает, что он обязан удалить уже присутствующую в индексе страницу. К тому же для индексации не всегда обязательно физически сканировать страницу, информацию о ней можно собирать из различных источников, например, из анкоров входящих ссылок.

Почему заблокированные в robots.txt страницы отображаются в выдаче?

В Яндексе и Google различается механизм обработки директив файла Robots.txt. Для Google директива Disallow в robots.txt запрещает лишь обход страниц, но не их индексацию из-за чего часто появляются страницы со статусом:

Для запрета индексации в Google через файл Robots.txt ранее использовалась незадокументированная директива Noindex в Robots.txt, но с сентября 2019 года Google перестал поддерживать ее.

На данный момент для надежного запрета индексации страниц в Google рекомендуется использовать атрибут Noindex Мета Тега Robots и HTTP-заголовка X-Robots-Tag.

Яндекс же, наоборот, воспринимает запрет в Robots.txt Disallow: как сигнал к запрету и сканирования и индексирования сайта и после добавления директивы Disallow: страницы будут удалены из индекса.

Использование атрибута canonical для запрета индексации дубликатов

Для консолидации дубликатов или похожих страниц страниц используется атрибут canonical, который указывает поисковикам по какому адресу рекомендуется индексировать страницу.Yandex” search_bot

Запрет сканирования, индексации с помощью кодов ответа сервера 3хх/4хх

Чтобы гарантированно запретить роботам скачивать страницы, можно отдавать ботам при сканировании страниц коды:

- 301 редирект: особенно подходит для запрета дубликатов и склейки их с основными страницами;

- 403 Forbidden: доступ запрещен;

- 404 Not Found: не найдено;

- 410 Gone: удалено;

Удаление страниц из индекса

Удаление страниц или каталогов через Search Console

Инструмент не запрещает страницы к индексации или сканированию – он лишь временно скрывает страницы из поисковой выдачи. Рекомендуется использовать только для экстренного удаления страниц, случайно попавших в выдачу, после этого уже физически удалить их или запретить сканирование/индексацию.

Ускоренное удаление из индекса страниц в Яндексе

На сайт должны быть подтверждены права. Можно удалить только страницы, которые недоступны для робота: запрещенные в robots.txt или отдавать код 3хх, 4хх.

Для удаления из индекса Яндекса страниц чужого сайта можно воспользоваться формой – https://webmaster.yandex.ru/tools/del-url/.

Требования к URL-адресам такие же: запрет в robots.txt или коды ответа 301, 403, 404, 410 и т.п.

Как добавить страницы в индекс Яндекса или Google

Роботы постоянно ходят по ссылкам на сайтах. Для ускорения добавления существуют инструменты:

- Sitemap.xml. Добавьте и регулярно обновляйте актуальный список страниц в сайтмапах сайта.

- В Яндексе: инструменты -> переобход страниц

- В Google: Проверка URL -> Запросить индексирование

Как проверить обход / сканирование сайта поисковыми системами

Яндекс:

Общее количество загруженных (просканированных) Яндексом страниц можно увидеть на главной странице вебмастера.

Динамику обхода страниц можно увидеть на странице Индексирование -> Статистика обхода.

Google: отчет: статистика сканирования сайта.

Также можно проверить обход сайта всеми поисковыми роботами с помощью анализа серверных логов сайта (Access logs). Например, через программу SEO Log File Analyser.

Как часто происходит индексация сайта

Поисковые боты постоянно равномерно загружают страницы сайта, далее выкладывая их в обновленный индекс: Google обновляет индекс в постоянном режиме, Яндекс во время апдейтов поисковой базы, примерно раз в три дня.

Частота сканирования и переиндексации каждого отдельного сайта различается, и зависит от факторов:

- объем контента/страниц сайта

- краулинговый спрос поисковой системы для текущего сайта

- настройки скорости сканирования в вебмастерах

- скорость работы сайта

Как улучшить и ускорить индексацию сайта

Рекомендации для увеличения охвата страниц индексом поисковых систем:

- качественный уникальный контент, востребованный пользователями

- все основные страницы должны быть в валидных сайтмапах sitemap.xml

- оптимизация вложенности страниц

- оптимизация краулингового спроса/бюджета

- хорошая скорость сайта

- закрывать лишние страницы, чтобы не тратить на них ресурсы роботов

- внутренняя перелинковка

- создание ротарора на сайте (Ловец ботов)

Как ограничить скорость сканирования сайта

Обычно если требуется ограничить нагрузку, которую создают роботы, то у сайта большие проблемы и это негативно скажется на его индексации. Боты стараются быть “хорошими” юзерами и сканируют сайт равномерно, стараясь не перегружать сервера.

То что сайт от этого испытывает проблемы с нагрузкой, в 90% случаев может быть сигналом к смене хостинга/сервера или оптимизации производительности CMS. Но в случае крайней необходимости все таки можно задать рекомендуемую скорость сканирования сайта.

Для ограничения скорости обхода сайта можно воспользоваться инструментами Яндекс.Вебмастер и Google

Яндекс:

Google:

В старой версии консоли можно было временно ограничить максимальную скорость сканирования сайта

В обновленной консоли такой возможности нет, но можно отправить сообщение о проблеме с активностью GoogleBot’а на сайте – https://www.google.com/webmasters/tools/googlebot-report

Как добавить сайт в Яндекс.Вебмастер: подтверждение прав и настройка

Довольно часто новый сайт не получается найти в Яндексе. Даже если набрать в поисковой строке его название. Причины этого могут быть разные. Иногда поисковики просто еще не знают о том, что появился новый ресурс. Чтобы разобраться, в чём дело и решить проблему, нужно зарегистрировать сайт в Яндекс.Вебмастере.

Что такое индексация сайта в Яндексе

Сначала разберёмся, как поисковики вообще узнают о новых сайтах или изменениях на них. У Яндекса есть специальная программа, которая называется поисковым роботом. Этот робот гуляет по интернету и ищет новые страницы. Иногда он заходит на старые – проверяет, не появилось ли на них что-то новое.

Когда робот находит полезную страницу, он добавляет её в свою базу данных. Эта база называется поисковым индексом. Когда мы ищем что-то в поиске, мы видим сайты из этой базы. Индексирование – это когда робот добавляет туда новые документы.

Робот не может каждый день обходить весь интернет. Ему на это не хватит мощности. Поэтому ему нужно помогать – сообщать о новых страницах или изменениях на старых.

Что такое Яндекс.Вебмастер и зачем он нужен

Яндекс.Вебмастер – это официальный сервис от Яндекса. В него нужно добавить сайт, чтобы робот узнал о его существовании. С его помощью владельцы ресурсов (веб-мастера) могут доказать, что это именно их сайт.

Ещё в Вебмастере можно посмотреть:

- когда и куда заходил робот;

- какие страницы он проиндексировал, а какие – нет;

- по каким ключевым словам приходят люди из поиска;

- есть ли технические ошибки.

Через этот сервис можно настроить сайт: задать регион, цены товаров, защитить свои тексты от воровства. Можно попросить робота заново зайти на страницы, на которых вы внесли изменения. Яндекс.Вебмастер упрощает переезд на https или другой домен.

Как добавить новый сайт в Яндекс.Вебмастер

Зайдите в панель Вебмастера. Нажмите «Войти». Логин и пароль можно ввести те, которые вы используете для входа на почту Яндекса. Если у вас еще нет учетной записи, придётся зарегистрироваться.

После входа вы попадёте на страницу со списком добавленных ресурсов. Если вы ранее не пользовались сервисом, то список будет пуст. Для добавления нового ресурса нажмите кнопку «+».

На следующей странице введите адрес вашего сайта и подтвердите его добавление.

На последнем этапе нужно подтвердить права – доказать Яндексу, что вы являетесь владельцем. Есть несколько способов это сделать.

Как подтвердить права на сайт в Яндекс.Вебмастер

Самый простой способ подтверждения прав в Яндекс.Вебмастер – добавить файл на сайт. Для этого нажмите на вкладку «HTML-файл».

Нажмите на ссылку, выделенную красным прямоугольником на скриншоте ниже:

Скачается небольшой файл. Этот файл сейчас понадобится, поэтому сохраните его куда-нибудь на видное место. Например, на Рабочий стол. Не переименовывайте файл! В нём ничего менять не нужно.

Теперь загрузите этот файл на ваш сайт. Обычно для этого используют файловые менеджеры, но для пользователей InSales ничего этого делать не нужно. Просто зайдите в бэк-офис, нажмите «Файлы». Затем наверху страницы – «Добавить файл». Выберите скачанный ранее файл.

Затем вернитесь в панель Яндекс.Вебмастер и нажмите кнопку «Проверить». После успешного подтверждения прав доступа ваш сайт появится в списке добавленных. Таким образом, вы сообщили в Яндекс.Вебмастер о новом сайте.

Мета-тег Яндекс.Вебмастер

Иногда описанный выше способ не срабатывает, и владельцы не могут подтвердить права на сайт в Вебмастере. В таком случае можно попробовать другой способ: добавить строку кода в шаблон.

В Вебмастере перейдите на вкладку «Мета-тег». Вы увидите строчку, которую нужно добавить в HTML-код.

Пользователи InSales могут обратиться в техподдержку и попросить вставить этот код. Это будет выполнено в рамках бесплатной доработки.

Когда они сделают это, в Вебмастере нажмите кнопку «Проверить». Поздравляем, вы зарегистрировали сайт в поисковике!

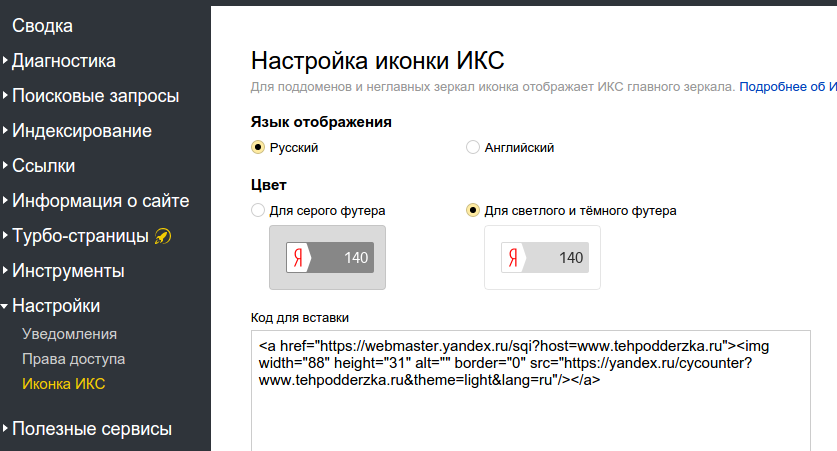

Предварительная настройка Яндекс.Вебмастер

Сайт добавлен в поиск, теперь робот точно зайдёт к вам и проиндексирует его. Обычно это занимает до 7 дней.

Но что делать дальше? Предлагаем ознакомиться с краткой инструкцией о том, как настроить Вебмастер, что делать в первую очередь.

Добавьте ссылку на sitemap

Для того чтобы робот быстрее индексировал ресурс, добавьте в Вебмастер файл sitemap.xml. В этом файле содержатся адреса всех страницах ресурса.

У интернет-магазинов на InSales этот файл уже настроен и должен добавляться в Вебмастер автоматически. Если этого не произошло, добавьте ссылку на sitemap.xml в разделе «Индексирование» — «Файлы Sitemap».

Проверьте robots.txt

В файле robots.txt указывают страницы, на которые роботу заходить не нужно. Это корзина, оформление заказа, бэк-офис и другие технические документы.

InSales по умолчанию создаёт robots.txt, в который не нужно вносить изменения. На всякий случай рекомендуем проверить, нет ли ошибок в robots. Для этого зайдите в «Инструменты» — «Анализ robots.txt».

Задайте регион сайта

На странице «Информация о сайте» — «Региональность» вы можете задать регион сайта. Для интернет-магазинов это те города, регионы и страны, по которым доставляются купленные товары. Если у вас не магазин, а справочник или блог, то регионом будет весь мир.

Задайте регион продаж как показано на скриншоте:

Чем ещё полезен Вебмастер?

На странице «Поисковые запросы» можно видеть фразы, по которым попадают к вам из поиска.

В разделе «Индексирование» выводится информация о том, когда робот был на сайте и сколько страниц он нашёл. Подраздел «Переезд сайта» поможет вам, если вы решили установить SSL сертификат и перейти на https. Также крайне полезен подраздел «Переобход страниц». В нём вы можете указать роботу страницы, на которых изменилась информация. Тогда при следующем визите робот проиндексирует их в первую очередь.

На странице «Товары и Цены» раздела «Информация о сайте» можно предоставить информацию о вашем интернет-магазине. Для этого на ресурсе должна быть настроена выгрузка данных о товарах и ценах в формате YML. При правильной настройке в поисковой выдаче страниц товаров будут отображаться цены и информация о доставке.

Если вы хотите улучшить видимость вашей компании в сервисах Яндекса, следует воспользоваться разделом «Полезные сервисы». В Яндекс.Справочнике можно указать телефон и адрес вашего магазина, часы работы. Эта информация будет отображаться прямо в выдаче Яндекса. Также это добавит вас на Яндекс.Карты.

Яндекс.Метрика — еще один важный инструмент владельца интернет-ресурса, показывающий данные о посещаемости. Статистика и динамика посещаемости сайта отображается в удобных для анализа таблицах, диаграммах и графиках.

После подключения к сервисам Яндекс.Вебмастер и Яндекс.Метрика вы будете получать достаточное количество информации для управления позициями сайта и его посещаемостью. Это незаменимые инструменты для владельцев сайтов, желающих продвинуть свои ресурсы в самом популярном в России поисковике.

Следующий шаг в продвижении сайта — добавить его в Гугл через аналогичный сервис Search Console. На этом все, удачи в продвижении!

Как проверить индексацию страниц сайта в Google и Яндекс

Главная • Блог • Как проверить, ускорить и закрыть индексацию страниц сайта в Google и Яндекс

Термин «индексация сайта» сегодня знаком каждому веб мастеру и практически каждому владельцу онлайн-бизнеса. Она влияет на позицию, занимаемую вашим ресурсом в поисковых системах, и, разумеется, когда она выше, пользователи, пребывающие в поисках нужной информации, товаров, услуг, окажутся в числе ваших клиентов с большей вероятностью, ведь увидят вас в числе первых.

Соответственно, неточности индексирования скажутся негативно на рейтинг в ТОП выдачи, или вовсе приведут к тому, что предложение компании окажется за пределами пользовательских запросов. Компания Idea Digital Agency составила краткий гайд для владельцев онлайн-бизнеса. Мы расскажем, как проверить индексацию сайта, и что делать, если он оказался вне поля зрения ботов.

Что такое индексация сайта?

Это процедура, проводящаяся алгоритмами с использованием принципов искусственного интеллекта, с целью определить релевантность данных, их важность для пользователей и актуальность. Проводится она автоматически, а робот в ходе проведения производит определенный порядок действий:

- Находит вас благодаря СЕО-продвижению или при помощи внешних ссылок;

- Переходит по линку и отправляет запрос на получение контента серверу;

- Изучает и оценивает важность содержимого, затем принимает решение об индексировании;

- Отправляет отчет.

В случае положительного решения рейтинг повышается. Если данные признаны неважными, повторной процедуры ждать не придётся до момента исправления недостатков, помешавших роботу выполнить работу.

Зачем нужна индексация сайтов в Google, спросите вы. Ответ прост: только отсканированное и получившее индекс от бота содержимое отображается в пользовательской выдаче на нужных вам позициях. Если по каким-либо причинам аналитика ботов прошла мимо или же URL попали под анализ частично, каким бы замечательным ни был контент, или насколько полезными не оказались товары, клиенты останутся в неведении и получат в выдаче своих запросов ссылки на магазины конкурентов.

Путать понятия сканирование и индекс неправильно. Бот проводит обе процедуры. Сканировать робот может достаточно быстро, а индексирование – более длительный процесс.

Как ускорить индексацию сайта, рассмотрим подробно далее, но главное в принципе работы ботов-пауков – сканирование HTML-кода. Поэтому важно не только подготовить релевантный контент для страницы, но и правильно прописать основные теги, включая заголовки разных уровней, метатеги Title и Description. Эту задачу лучше доверить профессиональным оптимизаторам, если важен 100% результат.

Как проверить индексацию сайта

Если вы не уверены, прошел ли URL сканирование, отмечаете низкую посещаемость, ищете причины невысокой конверсии, стоит запустить проверку URL в Гугл и Яндексе на правильность обработки и ее наличие. Доступны несколько способов, как это сделать, и любой способ имеет свои преимущества. Рассмотрим каждый подробнее.

Проверка в панели вебмастеров

Индексация сайта в Гугле и Яндексе возможна стандартным инструментом – Панелью Вебмастера. Для каждой популярной системы существует прописанный алгоритм действий. Мы рассмотрим его для двух основных, используемых в нашей стране.

- Проверка в Google проводится через Search Console. Выберите раздел «Обзор» в консоли, откройте графический отчёт «Покрытие». На графике вы сможете увидеть количество проиндексированных безошибочно объектов (зеленый график) и те, с которыми возникла ошибка (красный график). Увидеть подробный отчёт об основных файлах можно переходом в соседнюю вкладку с отчетом.

- Как проиндексировать сайт в Яндекс? Понадобится авторизоваться в сервисе Яндекс.Паспорт. Заходите непосредственно в сервис вебмастеров «Яндекс. Вебмастер», выбирайте параметр «Индексирование», далее – два пути: либо выбрать параметр «Страницы в поиске», либо его же в истории вебмастера. На полученном графике вы сможете отследить историю. График идёт по экспоненте без резких колебаний – это хороший признак: SEO продвижение сайта идёт правильно. Если график неровный, напоминающий кардиограмму, это явный признак ошибок в анализе: их обязательно нужно исправить.

В случае, когда проверка сайта Гуглом или Яндексом показывает нелицеприятные результаты, стоит удостовериться, что он не закрыт для их внимания и устранены базовые проблемы.

Материал по теме: Google Search Console: как добавить сайт и лайфхаки для SEO

Проверка через операторы в поисковых запросах

Индексация сайтов в Google отображается и в самом поисковике. Для изучения количества проиндексированных данных в целом можно использовать оператор site:. Алгоритм в этом случае проще простого: нужно добавить точный линк или доменное имя в Гугл, проставив перед адресом site:. После него без пробелов скопируйте полный линк. Посмотрите на выдачу.

Кстати, нелишним будет выполнить сравнение: запустите поиск в Яндекс и Гугл одновременно, если количество результатов выдачи будет существенно различаться, это признак того, что есть не выявленные ошибки, требующие исправления.

Чтобы получить более детальный анализ в Google можно зайти в раздел «Инструменты поиска»: так вы сможете увидеть, какое число линков было обработано с присвоением индекса за определенный период времени.

Параллельно рассмотрим, как проверить индексацию сайта операторами по каждому разделу.

- Стандартная схема – всё тот же site:. Вставьте после него полную ссылку и просмотрите результат. Отсутствие результата – верный признак того, что страница не индексируется.

- В этом случае можно задействовать специальные операторы. Для Гугл это – inurl:. Для Яндекса – url:. При обработке запроса с этими операторами положительный результат означает, что раздел всё же проиндексирован, отрицательный – его отсутствие в аналитике ПС.

С этой же целью можно выполнить такое простое действие, как посмотреть кэш Гугла. Для этого достаточно находясь на выбранной странице в поисковой строке перед URL прописать оператор cache и нажать энтер.

Проверка через плагины и букмарклеты

Узнать информацию можно и без непосредственного взаимодействия с поисковыми системами и их Консолями. Достаточно задействовать плагины или букмарклеты – небольшие приложения, которые устанавливаются непосредственно в браузер. Можно использовать такие плагины, как RDS bar или SEO Magic. Кроме них, существуют и другие микро-программы, с которыми массовая проверка индексации страниц будет минутным делом.

Анализ через сервисы для проверки индексации

Некоторые разработчики софта предлагают готовые решения, как узнать статус в ПС. Часть из них предлагается на платной основе и позволяет вытянуть сразу множество данных для анализа. Есть и более простые, shareware сервисы. В них может присутствовать ограничение по количеству линков, либо они могут иметь ограниченный функционал, но базовые данные они вполне могут вам предоставить. К таким сервисам относятся serphunt.ru и raskruty.ru. Для их применения достаточно перейти по адресу и следовать простым инструкциям.

Платные версии сервисов предлагают такие компании, как serpstat, Netpeak, Se Ranking (у последних сервис условно бесплатный, но только при условии, что вы уже подписаны на один из платных тарифов).

Как проверить индексацию конкретной страницы

Как и в случае с аналитикой в целом, проанализировать каждую страницу по отдельности можно через Search Console Гугла. Сделать это очень просто: скопируйте линк и вставьте в строку поиска Консоли. При положительном ответе появится соответствующее информационное окно.

Если ответ отрицательный, вы можете отправить ее повторно при помощи кнопки «Запросить индексирование».

Также определенные URL можно протестировать через поисковик с оператором site:, url/inurl. И, конечно, такая опция присутствует в платных сервисах или плагинах для анализа.

Почему не индексируется сайт, основные ошибки

Предупреждён – значит, вооружён, считаем мы. Поэтому важно знать и о главных причинах, по которым поисковые боты игнорируют вас и не индексируют целиком или отдельные разделы.

- Часто проблема банальна: онлайн-проект только создан, и поисковые пауки ещё не добрались до него. При статистике создания новых объектов в интернете, такая ситуация не редкость. Поэтому иногда не стоит паниковать, достаточно проявить терпение и регулярно просматривать, не появились ли ваши страницы в индексе.

- Отсутствие sitemap – не критичный, но не лучший вариант. Если вы не предоставили роботам готовый гайдлайн, они могут выборочно проиндексировать несколько рандомных страниц, а остальные упустить из виду или проигнорировать.

- Ошибки в страницах: отчеты Google Search Console игнорировать не стоит. Они показывают текущие ошибки страниц, которые, в свою очередь, могут привести к сбоям обработки поисковыми роботами.

- Недостаток контента – повод для отклонения. Контент – это не только текстовое наполнение, но и всевозможные медиа-объекты, расположенные на странице.

- Проблемы с robots.txt. Если для мета-тега случайно был присвоен атрибут noindex, поисковые пауки его не смогут найти. Аналогично с тегом X-Robots, который мог быть проставлен, как Noindex при тестировании или выставлен случайно. В общем, файл «роботов» стоит тщательно изучить на наличие лишних символов или атрибутов.

- Низкая уникальность контента – тоже провоцирует на отказ. Если даже вы выступаете первоисточником контента, но при этом ваши конкуренты «слизали» его и ускоренно проиндексировали свой ресурс, приоритет получат они, а не вы.

- Наличие дублей страниц для Search robots – тоже тревожный сигнал.

Также для отслеживания причин игнорирования ботами можно посмотреть статистику: возможно, причина в низкой скорости загрузки.

Инструкция по ускорению индексации сайта

Индекс поисковиками – насущный вопрос. И ускорить его стоит всеми возможными способами. А их существует не так уж и мало. Перечислим наиболее эффективные:

- Обязательно создайте sitemap – это путеводитель для роботов-поисковиков.

- Если карта уже есть, не забывайте ее регулярно обновлять, чтобы новые страницы и обновленный контент тоже оказывался проиндексированным.

- Следите за уникальностью контента. Удаляйте тот, который показывает низкую уникальность.

- Следите, не осталось ли дублей страниц после разработки.

- Сбои при переходе по линкам и ошибочные редиректы только запутывают “пауков”.

- Постоянный контроль robots.txt – это практически профилактика здоровья вашего бизнеса онлайн.

- Отладка страниц на предмет скорости поможет ускорить процесс. Поэтому займитесь этим тоже.

- Разумное распределение ссылок на ресурсах-донорах и внутри самого ресурса позволит алгоритмам попасть к вам быстро и точно. Для этого обновлённые разделы анонсируйте в социальных сетях, выбирайте подходящих доноров и логичную перелинковку на ресурсе.

- Регулярные обновления – это сигнал роботам, что вы живёте и развиваетесь. Запомните это.

Материал по теме: Как проверить и увеличить скорость загрузки сайта?

Как закрыть сайт от индексации?

Есть ситуации, когда необходимо выполнить и обратное действие – не дать индексировать вас. Удалить страницу из поиска Гугл и закрыть ее от внимания ботов можно при помощи внесения соответствующих команд в robots.txt.

Для этого используется команда Disallow.

С её помощью можно закрыть как все целиком, так и отдельные директории, картинки или медиа-контент.

Аналогично можно установить запрет и через кабинет веб-мастера. В различных CMS это может быть реализовано в разных позициях меню, но в целом вполне реализуемо.

И, конечно, можно запросить доступ по паролю на уровне настроек сервера.

Заключение

Загадочная процедура, о которой мы рассказали, не так уж страшна, как кажется на первый взгляд. Она полезна для всех ресурсов, за исключением еще не запущенных в работу или уже устаревших. И поэтому отследить отсутствие файлов, очень важно. Мы надеемся, что наша статья окажется для вас полезной, и ваш онлайн-проект будет точно индексироваться и отображаться на самых верхних позициях выдачи в поисковиках.

Как бороться с недостаточно качественными страницами | MIVOKS group

Любой SEO-специалист, продвигающий сайт в Яндексе в 2020 году, может в один прекрасный день обнаружить, что из поиска исключена пара десятков (или сотен) страниц с пометкой «недостаточно качественные». Расскажем о том, как с этим бороться!

- Что значит недостаточно качественная страница

- Как посмотреть

- Влияние на позиции в выдаче

- Как исправить

- Бонус: «Яндекс-шторм»

Что значит недостаточно качественная страница

Страницы низкого качества не дают подходящего ответа на запрос пользователя (интент запроса, если по-умному) и не содержат ничего полезного для него.Сюда попадают разные типы документов:Представьте, что вы хотите купить телевизор и открываете любимый поисковик. Зашли на понравившийся ресурс, а там нет ни фотографий, ни цены, ни характеристик… Сомнительно, что вы совершите покупку на этом ресурсе. Вот поисковые системы и пытаются оградить людей от подобных недоразумений и убрать из выдачи сайты, которые не способны решить их проблему.

- Служебные, структурные или тестовые, проиндексированные по ошибке

- Карточки товаров или категории в интернет-магазинах

- Статьи из блога или новости

- Информационные блоки, такие как отзывы, контакты, гарантии и т.п.

Причины попадания в блок тоже разнятся, но эффект один и он не самый приятный!

Как посмотреть

Давайте разберемся где же искать НКС. Заходим в Яндекс.Вебмастер и выбираем нужный сайт.

Находим пункт меню Индексирование → Страницы в поиске

Здесь вы сможете отследить все изменения индексации: добавление, изменение, удаление. Нам потребуется вкладка Исключенные

Нажимаем на фильтр Статус → Недостаточно качественная → Применить

И вот мы находим полный список НКС.

Ссылки кликабельны и с ними можно начинать работать. Если хотите выгрузить весь список, то Вебмастер позволяет это сделать. Промотайте вниз страницы и найдете кнопки для скачивания в формате XLS и CSV

Влияние на позиции в выдаче

Яндекс уверяет, что переживать по этому поводу не стоит. Нужно «улучшать сайт, ориентируясь на посетителей – тогда страницы станут более удобными и востребованными, и алгоритм сможет включить их в поиск.»

Однако, на практике алгоритм работает иначе: поисковик «выставляет» среднюю оценку всему домену. Поэтому, если будет много некачественных страниц с низким рейтингом, то и «доверие» к сайту будет ниже. Как следствие – снижение позиций даже по трафиковым запросам.

Иными словами, НКС негативно влияют на сайт целиком, включая наиболее мощные его документы.

Как исправить

Прежде, чем исправить поломку, ее нужно найти. Рассмотрите внимательно файлы, которые помечены «BAD_QUALITY» и определите что в них общего. Помимо этого задайте себе вопрос: «а нужно ли конкретно это в поисковике?»

Общие рекомендации

На странице обязательно должны быть:

- Прописанные уникальные метатеги title, description

- Структура заголовков. Ровно один h2, а остальные – при необходимости разбить информацию на логические разделы.

- Информация, которая является основной для нее.

Служебные страницы

Часто сюда попадают пагинация, результаты поиска или добавления в корзину. По-хорошему, они и не нужны в индексе и закрываются в robots.txt или им прописываются canonical.

Сюда же относятся «сырые» документы, которые создали, например, желая написать статью, а потом отложили в долгий ящик. Забыв, при этом, запретить роботам ее индексировать.

Переживать о подобных пропажах точно не стоит, это больше сигнал еще раз провести технический аудит – скорее всего, получится «поймать» еще много таких маленьких ошибок и исправить их.

Карточки товаров в интернет-магазине

К магазину применяются четкие требования, которые однозначно должны быть выполнены, если его владелец хочет не только занимать хорошие позиции в поисковой выдаче, но и успешно торговать в сети. К ним относят:

- Цену с указанием валюты

- Фото в хорошем качестве

- Описание, чем больше полезной информации «без воды», тем лучше

- Технические характеристики (в зависимости от тематики они разные)

- Данные о наличии или сроках поставки

- Условия оплаты, доставки, возврата и т.п.

- Отзывы покупателей

- Возможность покупки

Проверьте, что эти требования выполнены по максимуму, на сколько это возможно в вашей тематике.

Категории в интернет-магазине

Обычно это происходит с категориями, в которых мало позиций. Поисковик сравнивает между собой конкурентов. Если у других в категории в среднем 50 наименований, а у вас – 10, то вы в зоне риска. Однако, есть очень узкие ниши, например, специализированное оборудование. В этом случае у всех конкурентов будет примерно равное число товаров в листинге и это вполне нормально.

В любом случае, для интернет-магазинов мы всегда советуем расширять ассортимент. И никогда не удаляйте карточки товара, который больше не продаете. Лучше поставить статус «не поставляется» и предложить альтернативы.

Новости и статьи

Самое важное здесь – полезный, актуальный и интересный контент. При этом, уникальный, либо со ссылками на авторов, если используете сторонние материалы.

Информационные разделы

Из индекса пропала страницы «Оплата и доставка» и «Отзывы»? Покажите их нескольким случайным людям. Всем респондентам понятно что там написано, достаточно ли информации?

Поймите, что эти разделы созданы с целью ответить на вопросы пользователей, а не рождать у них новые!

Сквозные блоки

Часто страницы помечаются некачественными из-за схожести в рамках одного сайта. Иногда это происходит из-за сквозных блоков: меню, футер и т.п. Если вы попробовали уже все средства и ничего не помогает, то закройте в noindex эти элементы и посмотрите на реакцию поисковиков.

«Яндекс-шторм»

В 2020 году Яндекс активно работает над своими алгоритмами. Поэтому происходят абсолютно непрогнозируемые вещи. Например, ресурсы, годами висящие в ТОПе вылетают «со свистом» от туда.А потом благополучно возвращаются назад. Но не всегда…

И это же происходит и с НКС! На половине наших проектов внезапно стали некачественными десятки страницы. Однако, они не только не пропали из поиска (да-да, мы проверили), но и спустя пару дней проиндексировались опять, на этот раз без проблем! В отдельных случаях, они отправлялись на переобход вручную и тоже становились «качественными» При этом, никаких изменений на них не проводилось.

Поэтому совет всем: не спешите ничего менять, если увидели подобные изменения в Вебмастере. Иногда следует немного подождать и все станет как прежде.

Статья на Яндекс.Дзен

Подписывайтесь на канал – публикуем там уникальный контент, которого нет в блоге!

Проверить статус URL — Webmaster. Справка

Проверить статус URL — это инструмент для отслеживания индексации вашего сайта Яндексом. Он позволяет узнать статус страницы в результатах поиска: просканирована ли она, участвует ли она в поиске, а также почему она была исключена из результатов поиска.

- Проверка страницы

- Просмотр отчетов

- Фильтрация данных

Чтобы получить информацию об индексации страниц, выполните следующие действия в Яндекс.Вебмастере:

Выберите из списка сайт, страницу которого необходимо проверить.

Перейти в раздел.

Введите URL-адрес страницы и нажмите Проверить.

Примечание. В поле вы можете ввести полный URL или относительный путь от корня сайта, начинающийся с «/». Например, если вы введете URL-адрес

http://example.com, система обработает информацию о странице с URL-адресомhttp://example.com. Если ввести/ новости, система обработает информацию о странице с URLhttp: // my-website.com / news.

Система собирает данные о странице и формирует отчет.

Во время сбора данных отчет имеет статус «Проверяется». Сбор и обработка информации занимает несколько минут. В некоторых случаях это может занять несколько часов. Как только система закончит обработку данных, статус отчета изменится на «Завершено». Статус «Не удалось создать отчет» указывает на то, что на стороне сервиса произошла ошибка. В этом случае попробуйте проверить страницу позже.

Чтобы просмотреть отчет, нажмите кнопку «Подробнее».

Отчет основан на текущем состоянии поисковой базы данных и на последних данных, полученных от индексирующего робота:

Статус страницы в поиске.

Состояние страницы во время последнего сканирования.

Дата и время последнего построения базы данных поиска и последнего сканирования.

URL страницы.

Заголовок страницы (содержимое элемента заголовка HTML).

Вы можете использовать фильтры для просмотра отчета, созданного для определенной страницы.

Чтобы удалить отчет, щелкните значок рядом с адресом страницы, затем щелкните «Удалить».

Примечание. Если содержимое страницы было изменено, робот автоматически отслеживает это. Данные результатов поиска будут обновлены при следующем создании базы поиска.

Вы можете быстро найти отчеты о проверках определенных страниц. Вы можете фильтровать данные по адресу страницы, щелкнув значок:

- Введите часть URL-адреса.

Чтобы составить список страниц с определенным текстом в адресе, выберите URL-адрес, содержащий значение, из списка и введите фрагмент адреса.

Используйте специальные символы.Вы можете использовать специальные символы, чтобы соответствовать началу строки или подстроки, и устанавливать более сложные условия с помощью регулярных выражений. Для этого выберите совпадения URL-адресов из списка и введите условие в поле. Вы можете добавить несколько условий, поместив каждое из них в новую строку.

Для условий доступны следующие правила:

| Символ | Описание | Пример |

|---|---|---|

| * | Соответствует любому количеству любых символов | Показать данные для всех страниц, начинающихся с https: // example.com / тариф /, включая указанную страницу:

Символ * может быть полезен при поиске URL-адресов, содержащих два или более определенных элемента. Например, вы можете найти новости или объявления за определенный год: |

| @ | Отфильтрованные результаты содержат указанную строку (но не обязательно строго соответствуют ей) | Отображение информации для всех страниц с URL-адресами, содержащими указанную строку: @tariff |

| ~ | Условие — это регулярное выражение. | Отображение данных для страниц с URL-адресами, соответствующими регулярному выражению.Например, вы можете отфильтровать все страницы с адресом, содержащим фрагмент ~ таблица | диван | кровать , повторяющийся один или несколько раз. |

| ! | Отрицательное условие | Исключить страницы с URL-адресами, начинающимися с https://example.com/tariff/: ! / Тариф / * |

Использование символов не чувствительно к регистру.

Символы @,!, ~ Можно использовать только в начале строки. Доступны следующие комбинации:

| Оператор | Пример |

|---|---|

| ! @ | Исключить страницы с URL-адресами, содержащими тариф: ! @Tariff |

| ! ~ | Исключить страницы с URL-адресами, соответствующими регулярному выражению |

Индексирование сайта с помощью Яндекс.Метрика tag

Внимание. Этот метод не подходит для индексации:Робот Яндекса узнает о страницах сайта из разных источников. Один из них — тег отслеживания Яндекс.Метрики. Вы можете указать Яндексу индексировать страницы с тегом.

Для ускорения сканирования свяжите тег Яндекс.Метрики с сайтом, который вы проверили в Яндекс.Вебмастере, и включите индексацию сайта с данными тегов.

- Кто может запросить и подтвердить привязку

| Откуда отправляется запрос | Кто отправляет запрос | Кто подтверждает запрос |

|---|---|---|

| Яндекс.Веб-мастер. | Пользователь с правами управления сайтом. | Пользователь Яндекс.Метрики с правами редактирования тегов или представительским доступом. |

| Яндекс.Метрика. Узнайте больше о том, как отправить запрос в Яндекс.Метрике. | Пользователь с правами редактирования тега или с репрезентативным доступом. | Пользователь Яндекс.Вебмастера с правами управления сайтом. |

Когда робот завершает сканирование сайта, страницы могут быть включены в результаты поиска, если им не запрещено индексировать.Чтобы помочь роботу найти все страницы, также используйте файл Sitemap.

Вы можете связать несколько доменов с одним тегом или несколько тегов на сайте. Например, вы можете связать один и тот же тег с основным доменом и субдоменом. Для этого добавьте оба сайта в Яндекс.Вебмастер и подтвердите свои права на управление сайтом.

Выберите сайт для ссылки на тег.

Перейти в раздел.

Нажмите кнопку Добавить тег.

Укажите идентификатор тега для ссылки на сайт.Обратите внимание, что сайт должен быть указан в Яндекс.Метрике в настройках тега.

После того, как вы отправите запрос на подтверждение привязки, владелец тега Яндекс.Метрики получит уведомление по электронной почте.

Перейти к.

Рядом с тегом Яндекс.Метрики, который вы связали с сайтом, включите индексацию.

Робот сможет сканировать страницы, на которых установлен тег. Этот параметр применяется ко всем версиям сайта: по протоколу HTTP или HTTPS, с префиксом www или без него.

Во время индексации робот ищет на сайте страницы, которые могут быть включены в результаты поиска. В некоторых случаях индексация может остановиться, чтобы вы могли проверить страницы. Робот может найти много страниц, но Яндекс.Вебмастер показывает вам только примеры. Эти примеры помогут вам понять, какие группы страниц следует включать, а какие нет.

Вы получите уведомление о том, что список готов к проверке. В зависимости от ваших настроек, уведомление будет иметь следующий вид:Чтобы проверить примеры, перейдите и щелкните Примеры страниц рядом с тегом, который вы связали с сайтом.

Если вы считаете, что список включает:

- Внимательно посмотрите на список — он может включать следующие типы страниц:

Тип страницы Что мне делать? Страницы действий. Например, добавление товара в корзину или сравнение товаров. Запретить индексацию страниц Корзина с товаром. Личная информация.Например, адрес доставки и номер телефона покупателя. Ограничить доступ к данным путем аутентификации пользователей на сайте . Например, URL с дополнительными параметрами (https://example.com/page?id=1). Укажите, какая страница предпочтительнее для включения в результаты поиска Подождите, пока служба обновит список. Вы получите электронное письмо об этом на адрес, указанный в настройках уведомлений.

Еще раз проверьте образцы страниц.

Включить индексацию.

- Проверьте, готовы ли ваши страницы к показу в результатах поиска. (Содержимое завершено? Правильно ли заданы титровальный элемент и метатег Описание?)

Включите индексирование.

Кроме того, мы рекомендуем добавлять страницы, которые могут участвовать в поиске, в файл Sitemap, чтобы ускорить их появление в результатах поиска.

Вы можете проверить, какие страницы появляются в результатах поиска, на страницах в разделе поиска.

Когда опция выключена, робот перестает получать информацию о новых страницах сайта от Яндекс.Метрики. Однако он может проиндексировать страницы, если узнает о них из других источников. Мы рекомендуем запретить индексирование непубличного содержания. Чтобы узнать, включены ли страницы, которые вы не хотите индексировать, в результаты поиска, перейдите в раздел «Страницы» в разделе поиска.

Также имейте в виду, что отключение индексации не удаляет страницы из результатов поиска.См. Как мне исключить страницы из поиска ?.

| Низкое качество | BAD_QUALITY | Страница считается некачественной. | См. Рекомендации. |

| Исключено Clean-param | CLEAN_PARAMS | Страница была исключена из поиска после того, как робот обработал директиву Clean-param. | Чтобы страница проиндексировалась, отредактируйте файл robots.txt. |

| Дубликат | ДУПЛИКАТ | Страница дублирует страницу сайта, которая уже находится в поиске. | Укажите предпочтительный URL-адрес для робота, используя перенаправление 301 или атрибут rel = «canonical». Если содержимое страниц отличается, отправьте их на переиндексирование, чтобы ускорить обновление поисковой базы. |

| Ошибка подключения к серверу | HOST_ERROR | При попытке доступа к сайту робот не смог подключиться к серверу. | Проверьте ответ сервера, убедитесь, что робот Яндекс не заблокирован хостинг-провайдером. Сайт автоматически индексируется, когда становится доступным для робота. |

| Ошибка HTTP | HTTP_ERROR | Произошла ошибка при доступе к странице. | Проверьте ответ сервера. Если проблема не исчезнет, обратитесь к администратору сайта или администратору сервера. Если страница в данный момент доступна, отправьте ее на переиндексацию. |

| Запрещено элементом noindex. | META_NO_INDEX | Страница была исключена из поиска, потому что ей запрещено индексировать (с помощью метатега robots, который содержит директиву content = «noindex» или content = «none»). | Чтобы страница отображалась в поиске, снимите бан и отправьте на переиндексацию. |

| Неканонический | NOT_CANONICAL | Страница индексируется каноническим URL-адресом, указанным в атрибуте rel = «canonical» в ее исходном коде. | Исправьте или удалите атрибут rel = «canonical», если он указан неправильно. Робот автоматически отслеживает изменения. Для ускорения обновления информации о странице отправьте страницу на переиндексацию. |

| Вторичное зеркало | NOT_MAIN_MIRROR | Страница принадлежит вторичному зеркалу сайта, поэтому была исключена из поиска. | |

| Неизвестный статус | ДРУГОЕ | У робота нет актуальных данных на странице. | Проверить ответ сервера или запрещающие элементы HTML. Если робот не может получить доступ к странице, обратитесь к администратору вашего сайта или сервера. Если страница в данный момент доступна, отправьте ее на переиндексацию. |

| Не удалось загрузить страницу | PARSER_ERROR | При попытке доступа к странице робот не смог получить ее содержимое. | Проверить ответ сервера или запрещающие элементы HTML. Если проблема не исчезнет, обратитесь к администратору сайта или администратору сервера.Если страница в данный момент доступна, отправьте ее на переиндексацию. |

| В поиске | REDIRECT_SEARCHABLE | Страница перенаправляется на другую страницу, но включается в поиск. | |

| Перенаправление | REDIRECT_NOTSEARCHABLE | Страница перенаправляется на другую страницу. Целевая страница проиндексирована. | Проверьте индексацию целевой страницы. |

| Запрещено в robots.txt (весь сайт) | ROBOTS_HOST_ERROR | В robots запрещено индексирование сайта.txt файл. Робот автоматически начнет сканирование страницы, когда сайт станет доступен для индексации. | При необходимости внесите изменения в файл robots.txt. |

| Disallowed robots.txt (page) | ROBOTS_TXT_ERROR | Индексирование сайта запрещено в файле robots.txt. Робот автоматически начнет сканирование страницы, когда сайт станет доступен для индексации. | При необходимости внесите изменения в файл robots.txt. |

| В поиске | ПОИСК | Страница включена в поиск и может отображаться в результатах поиска по запросам. |

Статистика сканирования — веб-мастер. Справка

Робот-индексатор Яндекса регулярно сканирует страницы сайта и загружает их в поисковую базу. Робот может не загрузить страницу, если она недоступна.