одновременный доступ и работа в excel Online от Yandex диск

- О сайте

- Контакты

войти в систему

Добро пожаловат!Войдите в свой аккаунт

Ваше имя пользователя

Ваш пароль

Вы забыли свой пароль?

завести аккаунт

Зарегистрироваться

Добро пожаловат!Зарегистрируйтесь для создания учетной записи

Ваш адрес электронной почты

Ваше имя пользователя

Пароль будет выслан Вам по электронной почте.

восстановление пароля

Восстановите свой пароль

Ваш адрес электронной почты

Изменена:

Всем привет!

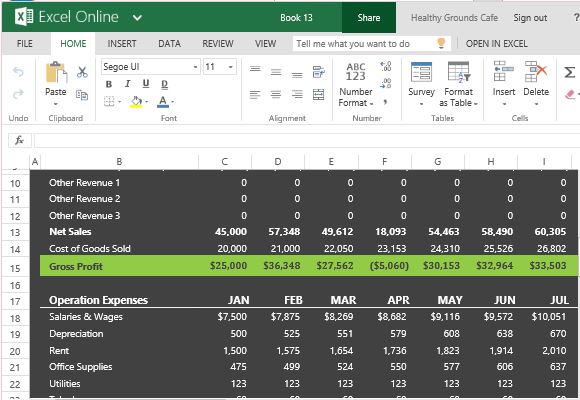

На работе поставили задачу организовать общий доступ к таблицам Excel для одновременного редактирования несколькими сотрудниками предприятия, возможность оперативно посмотреть информацию если это потребуется, а так же внести поправки и другую важную информацию. К слову не все сотрудники сидят в одном здании, а на разных объектах и площадках, которым необходимо видеть информацию занесенную коллегами. В связи с этим было рассмотрено несколько вариантов для реализации доступа:

К слову не все сотрудники сидят в одном здании, а на разных объектах и площадках, которым необходимо видеть информацию занесенную коллегами. В связи с этим было рассмотрено несколько вариантов для реализации доступа:

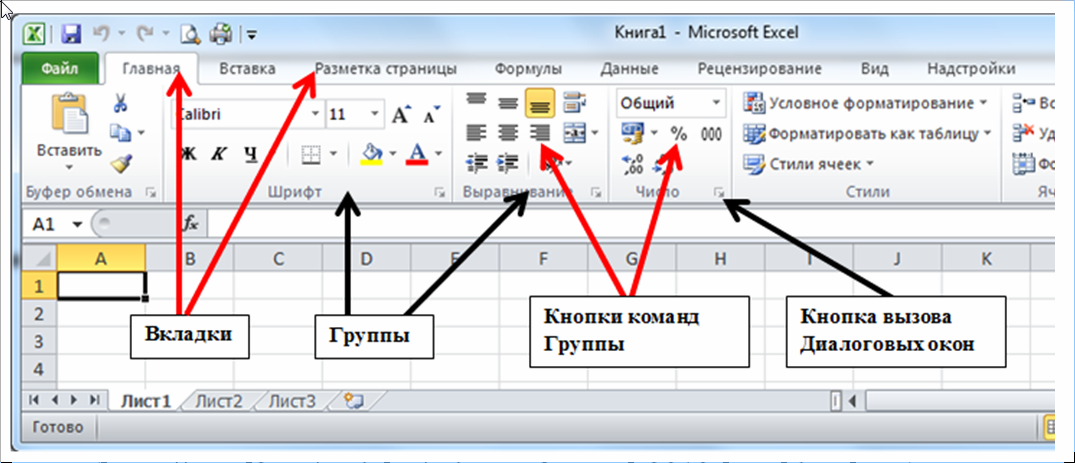

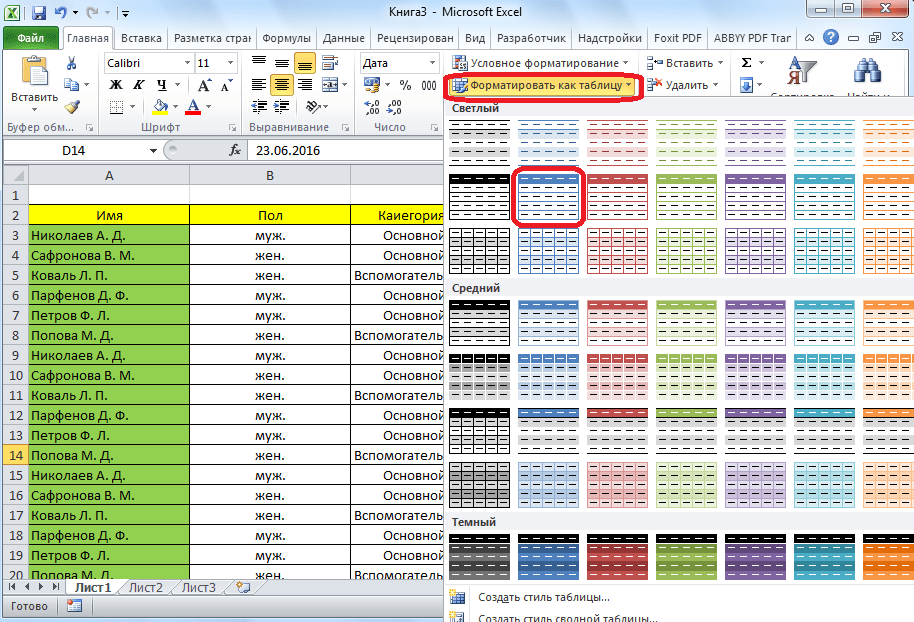

Microsoft Excel

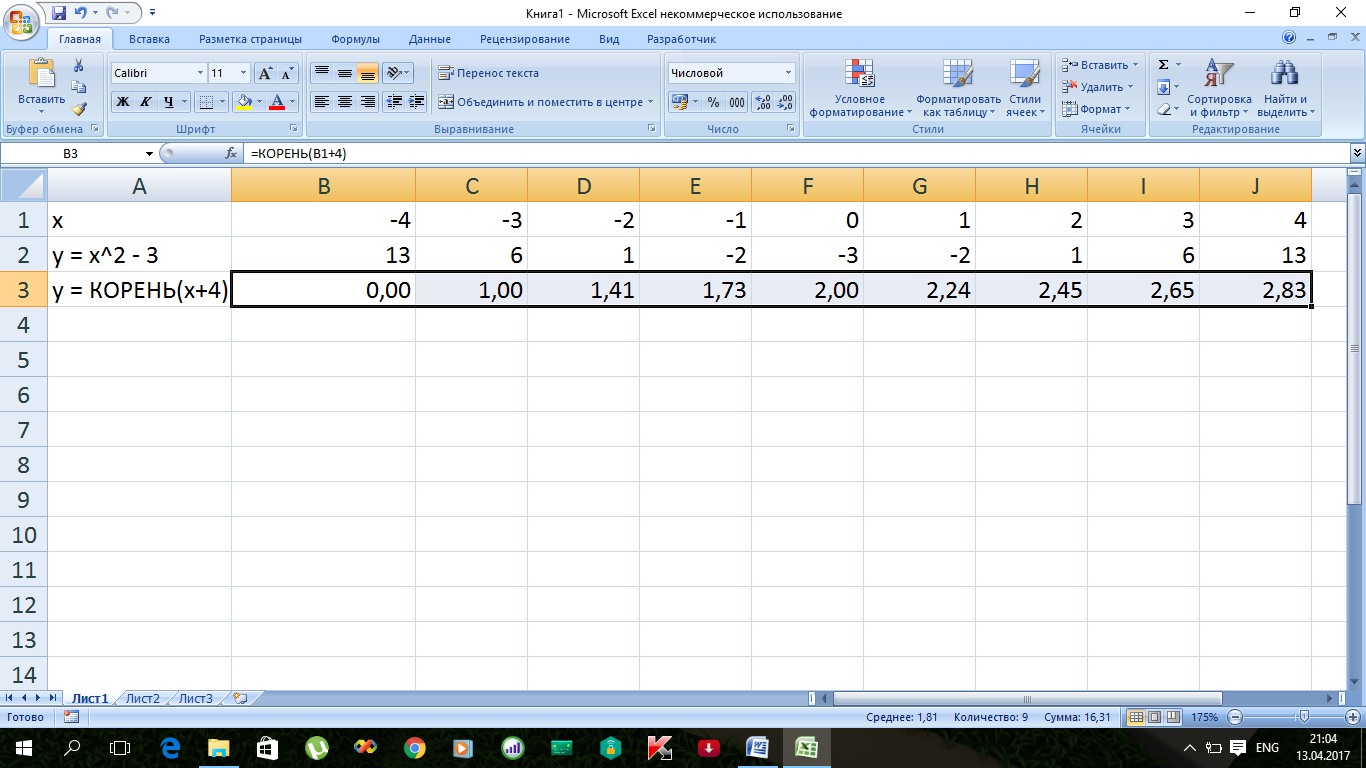

Непосредственно штатным Excel который установлен у всех,но есть некоторые нюансы:

– Файл должен находится в одной сети (у нас все пользователи раскиданы по разным объектам)

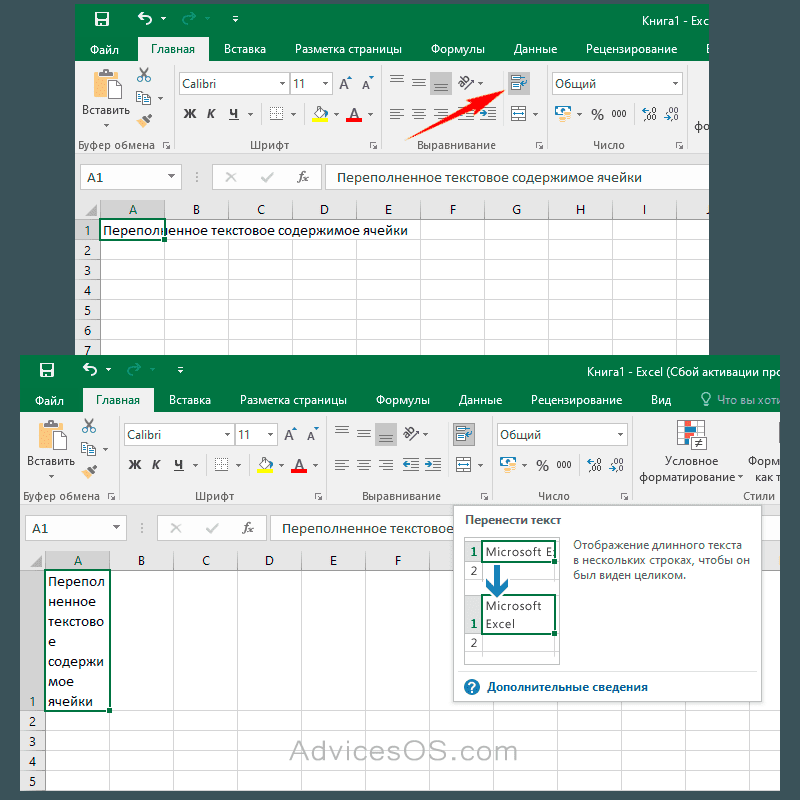

– Некоторые задачи становятся недоступны (создавать таблицы Excel;создавать, менять или просматривать сценарии; удалять листы; объединять либо разделять ячейки.)

– Частая “блокировка” файла

– Не видно кто что делает, т.е. информация будет доступна только после сохранения файла. Один не приятный момент при работе с файлом – если вы записываете информацию в одну и ту же ячейку, при сохранении файла работает правило “кто последний тот и папа”)))))

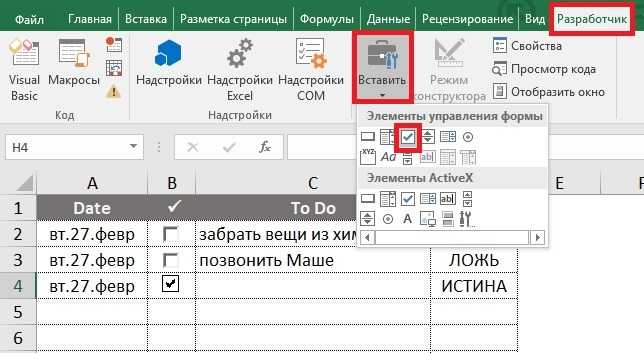

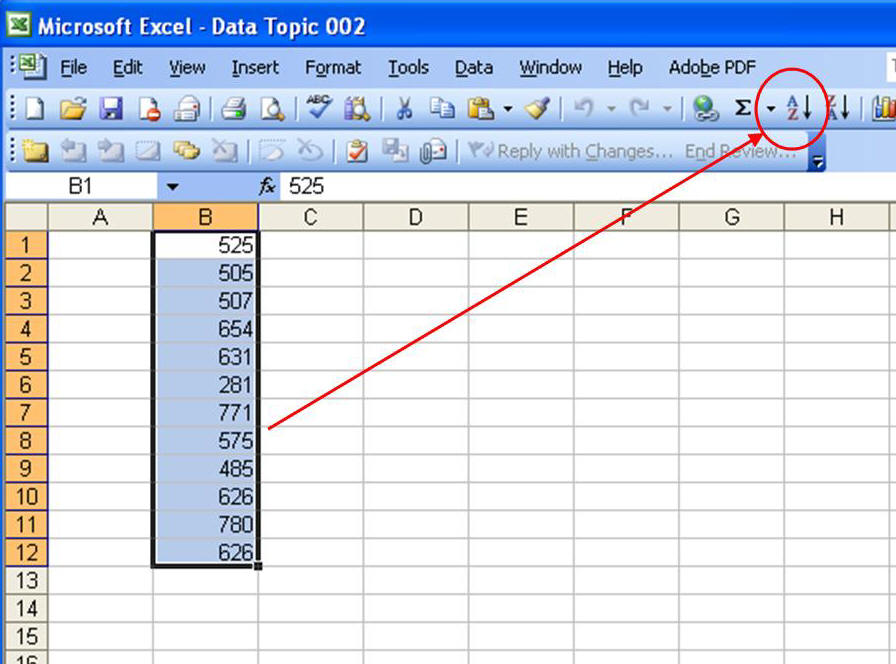

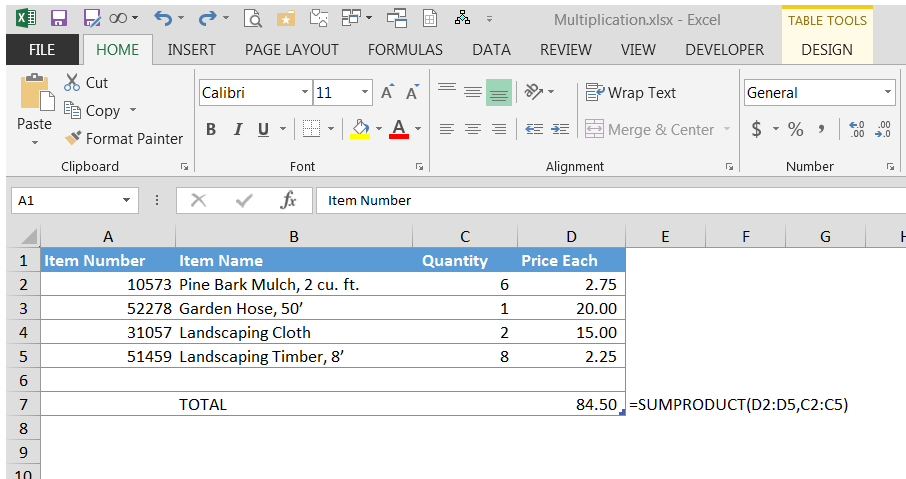

Реализация делается следующим образом, заходим в “Рецензирование” и щелкаем по значку “Доступ к книге”.

После этих действий файл станет общим и даёт пользователям одновременное редактирование. В названии файла появится приписка [Общий]

При нажатии кнопки “Доступ к книге” может возникать ошибка:

Достаточно сделать по шагам что написано в диалоговом окне ошибки и она пропадёт!

И так что же мы увидим когда нажмем кнопку “Доступ к книге”?!

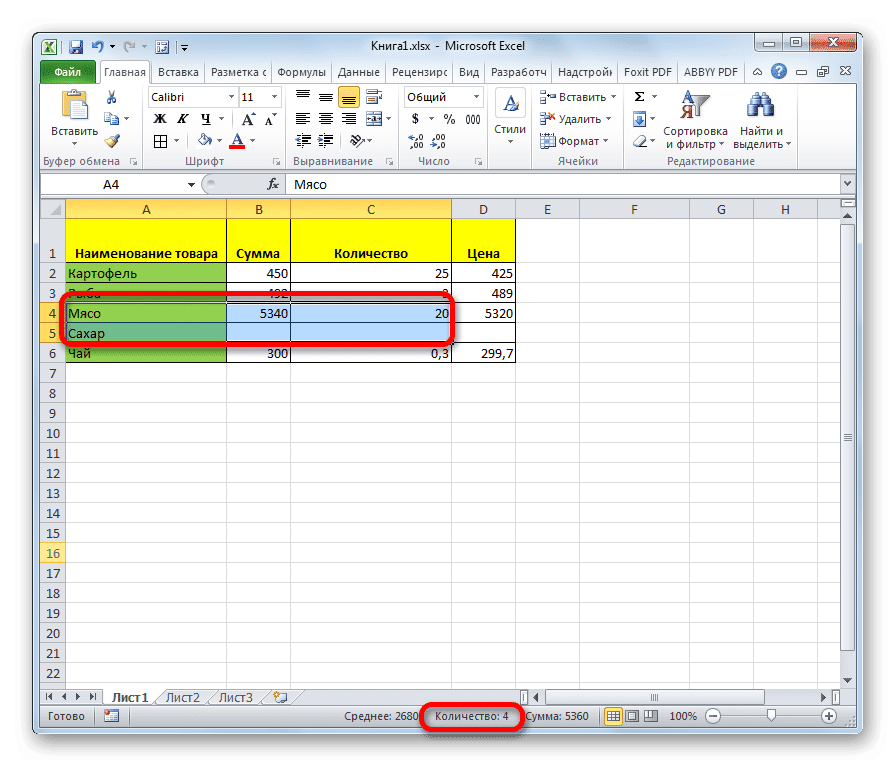

А увидим список пользователей которые работают в данный момент и не забудем так же поставить галочку «Разрешить изменять файл нескольким пользователям одновременно»

Excel настроен для работы с общими документами 🙂

OneDrive

Стандартное облачное хранилище семейства Windows 8.0\8.1\10. Отказались сразу из-за:

- отличие операционных систем (большинство пользователей работают на windows 7)

- каждому пользователю необходимо было бы регистрировать учетную запись Microsoft

- различные версии Microsoft Office которые могут при неправильном использовании конфликтовать

- сложный механизм аутентификации для понимания конечного пользователя.

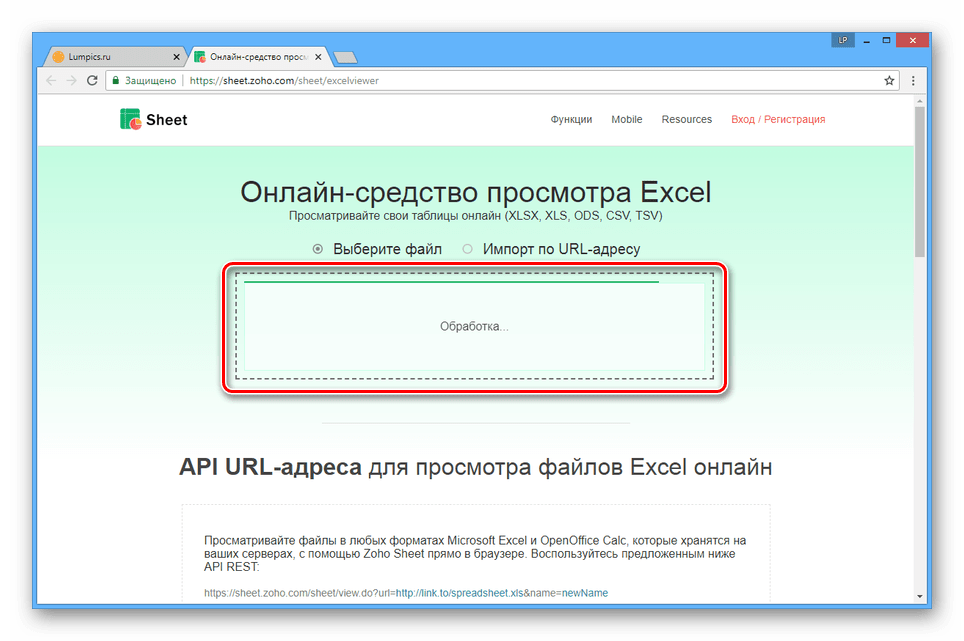

Google Docs (Гугл документы)

В Google многие моменты схожи с OneDrive, но еще есть и некоторые “подводные камни” которые усложняют настройку общего доступа, а именно:

- для каждого пользователя необходимо устанавливать расширение Chrome “Редактирование файлов Office”

- создание google аккаунта

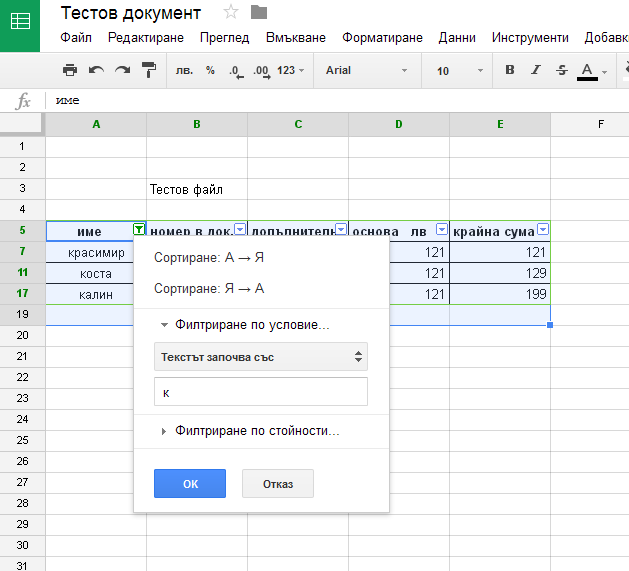

Google первая компания которая запустила office online из которого можно выделить online excel который позволяет работать в реальном режиме большому кол-ву пользователей многие компании уже давно работают в нем и в этом есть ряд преимуществ:

- разграничение прав доступа на документ, страницу, столбцы

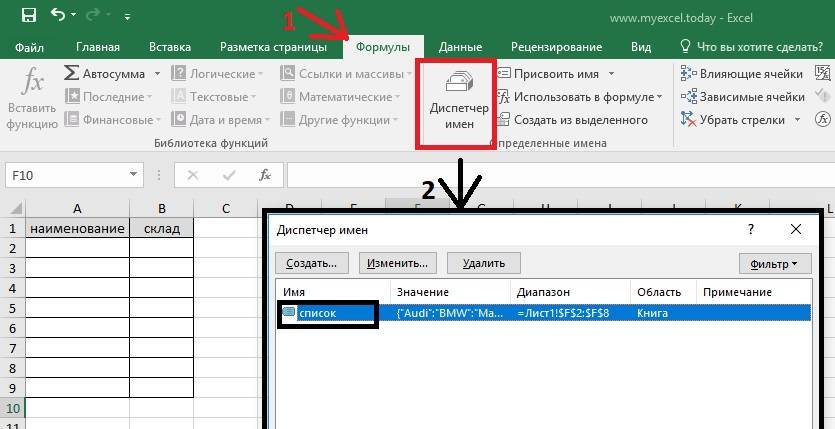

- использование сложных формул и своих доработок

И мы склонялись конечно к легкому варианту (Google), но использования на работе яндекс сервисы как часть нашей внутренней инфраструктуры решили пойти по сложному пути и использовать то что предлагает яндекс.

У нас вся почта завязана на Яндекс. Коннект, у всех есть корпоративная почта, стоит Яндекс.Диск, всё между собой синхронизируется, нет необходимости быть в одной сети (достаточно иметь доступ к интернету), бэкапы можно сделать на раз два (просто сохранить файл на диск).

Коннект, у всех есть корпоративная почта, стоит Яндекс.Диск, всё между собой синхронизируется, нет необходимости быть в одной сети (достаточно иметь доступ к интернету), бэкапы можно сделать на раз два (просто сохранить файл на диск).

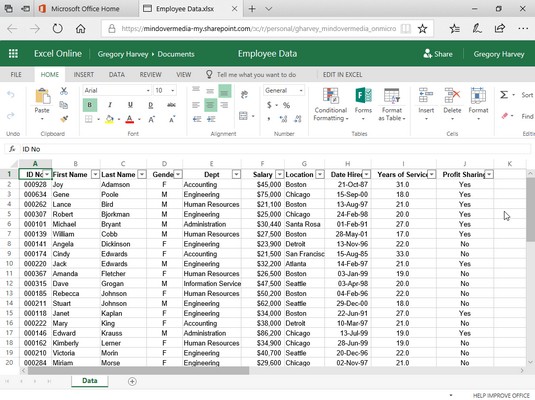

Настройка и получение общего доступа с помощью Excel Online через Яндекс

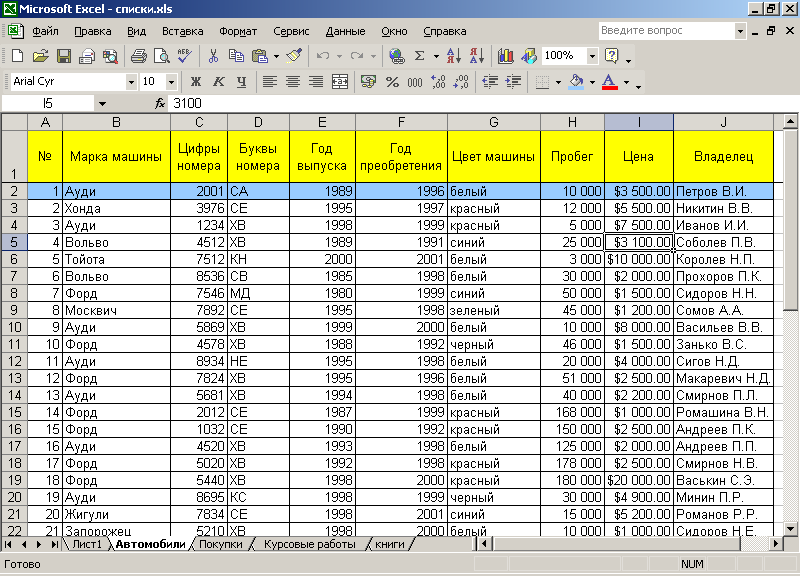

Изначально в яндекс диске создаем папку в какой будет лежать файлы для общего доступа и одновременной работы

и настраиваем доступ к этой папке путем ввода логина яндекс почты и ставим права на просмотр или полные права

после того как вы человека добавили к документу ему на почту придёт письмо с принятием приглашения :

Нажимаем “Принять соглашение” и попадаем в веб-интерфейс Яндекс.Диска, в ту самую папку которую создал сисадмин , щелкаем два раза по папке и внутри папки Excel’ский файл

Далее просто нажимаем на файл, вверху появится черная полоска с функциями ,что можно сделать с данным файлом. Нас интересует функция “Редактировать” (в зависимости от прав доступа, та или иная функция может отсутствовать)

Нас интересует функция “Редактировать” (в зависимости от прав доступа, та или иная функция может отсутствовать)

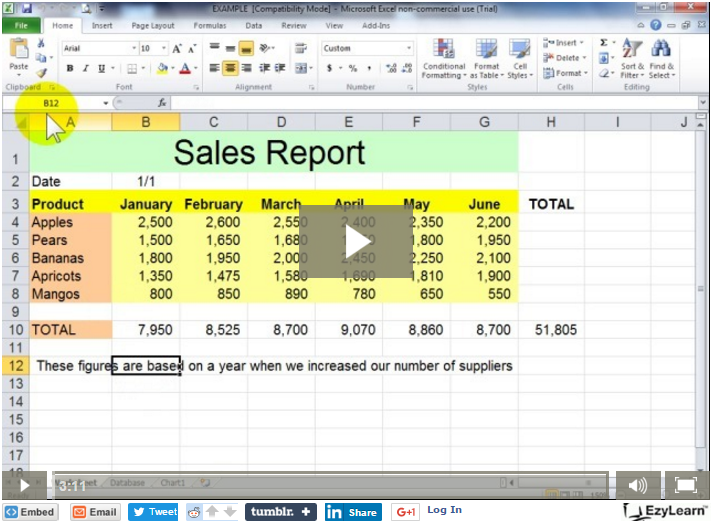

При нажатии данной функции попадаем в тело документа и можно начинать работать как в привычном Excel’е. Сохранение файла происходит автоматически и достаточно просто закрыть вкладку с названием таблицы.

Общий доступ настроен, все пользователи видят и могут редактировать Excel-таблицы!

Всем пока и хорошего дня!

UP 27.03.2019

Заметка от nibbl – первые проблемы при работе с Yandex Excel:

- разграничение прав доступа очень “топорные” они даются только на папку, а не на документ (надеюсь в скором времени они это поправят потому как ОЧЕНЬ не удобно)

- заметные тормоза при работе (хотя чему тут удивлять они используют пакет Microsoft 🙂 )

- пока не хочу переходить на Гугл но если люди будут возмущаться то придется перейти. (камень в огород Яндекса, сырые продукты выпускают на рынок, один ямб чего стоит( ладно ждем и надеемся что все будет хорошо.

)

)

Popular

«Яндекс.Диск» мог вернуться на Microsoft Office Online из-за наплыва клиентов: Санкт-Петербург

21.03.2022 |

Игорь Новиков.

Облачный сервис Яндекс.Диск случайно показал, что пользуется сервисом Microsoft Office Online, хотя официально перешел в прошлом году на российское решение «Р7-Офис».17 марта пользователи облачного сервиса «Яндекс.Диск» столкнулись с проблемой загрузки своих документов из облака. В ответ им приходило сообщение: «Microsoft Word. К сожалению, произошла ошибка». Сервис отказывал в загрузке документа. Все остальные функции облачного сервиса (хранение и передача файлов) работали нормально, т.е. атаки DDoS не было.

На следующий день (18 марта) пользователи сообщили, что все ошибки пропали, все функции, доступные через интерфейс, заработали нормально. Реакция пользователей была неоднозначной. Больше всего у них вызвало недоумение упоминание «Microsoft Word».

Опытные пользователи высказали мнение, что речь идет о проблеме, возникающей при работе серверного приложения «Microsoft Word» при загрузке документа с хранилища «Яндекс. Диск». С учетом событий последних дней, когда многие мировые вендоры заявили о приостановке поддержки своих сервисов для российских компаний, у многих возникло подозрение, что это могло иметь связь с данным инцидентом.

Диск». С учетом событий последних дней, когда многие мировые вендоры заявили о приостановке поддержки своих сервисов для российских компаний, у многих возникло подозрение, что это могло иметь связь с данным инцидентом.

Ошибка в работе «Яндекс.Диск». Источник: Facebook

Яндекс.Диск и Microsoft Office Online

В описании «Яндекс.Диска» упоминается только о «полноценной поддержке функций работы с документами Microsoft Office». Сервис поддерживает приложения Word, Excel, PowerPoint, документы можно загружать с собственного локального диска, с облачного хранилища «Яндекс.Диск» или создавать новый документ непосредственно внутри сервиса.

Это описание было сделано еще в ноябре 2015 года, когда Яндекс сообщил о подключении функций редактирования Microsoft Office в состав своего облачного продукта «Яндекс.Диск». Яндекс не скрывал, что внутри выстроенной им платформы «Яндекс.Диск» используется условно-бесплатная версия облачной платформы Microsoft Office Online (ранее Office Web Apps), называя ее «web-версия Microsoft Office».

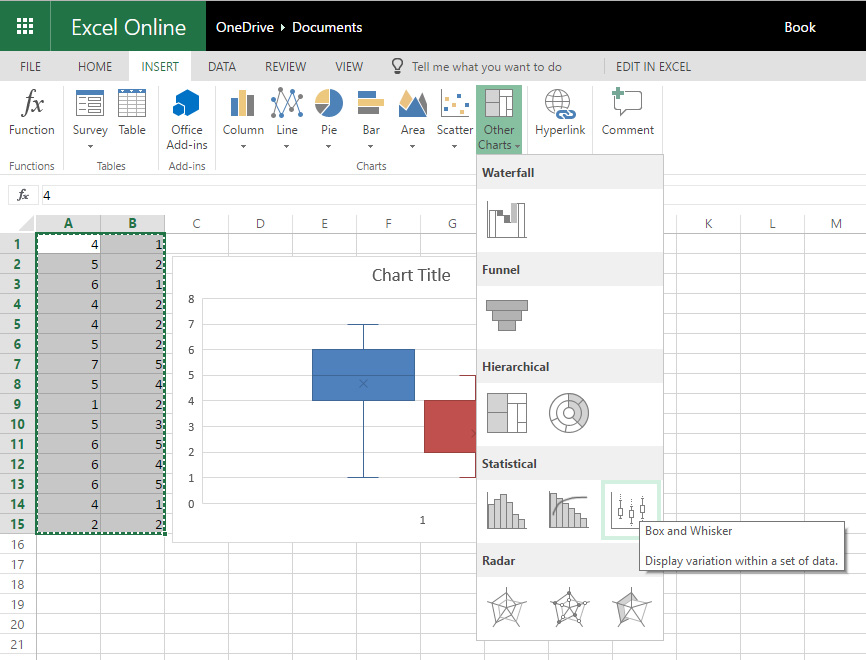

Платформа Office Web Apps впервые была показана в октябре 2008 года. Она была выстроена на базе популярного офисного пакета Microsoft Office, разработка которого велась с 1983 года. В Office Web Apps вошли облегченные версии приложений Word, Excel, PowerPoint и OneNote, которые позволяли создавать, редактировать и обмениваться документами Office через обычный браузер.

Было анонсировано, что Office Web Apps могут работать через механизм AJAX, ставший стандартом для динамического обмена данными между серверной и клиентской частями системы. Благодаря этой поддержке в браузерах, стало возможным использовать офисные приложения удаленно, в онлайн-формате.

При разработке Office Web Apps компания Microsoft не только переписала весь программный код, но и провела полный набор тестовых стресс-испытаний платформы. Они гарантировали масштабируемость сервиса при большом количестве клиентов.

Яндекс.Диск и «Р7-Офис»

Курс на импортозамещение, взятый российскими компаниями, был поддержан и в Яндекс. В 2018 году он объявил о своих планах перевода собственной сети сервисов на российские разработки. Яндекс заявил, что впредь будет работать только с резидентами Российской Федерации (для физических лиц) и бизнес-организациями, имеющими действующие представительства на территории России.

В 2018 году он объявил о своих планах перевода собственной сети сервисов на российские разработки. Яндекс заявил, что впредь будет работать только с резидентами Российской Федерации (для физических лиц) и бизнес-организациями, имеющими действующие представительства на территории России.

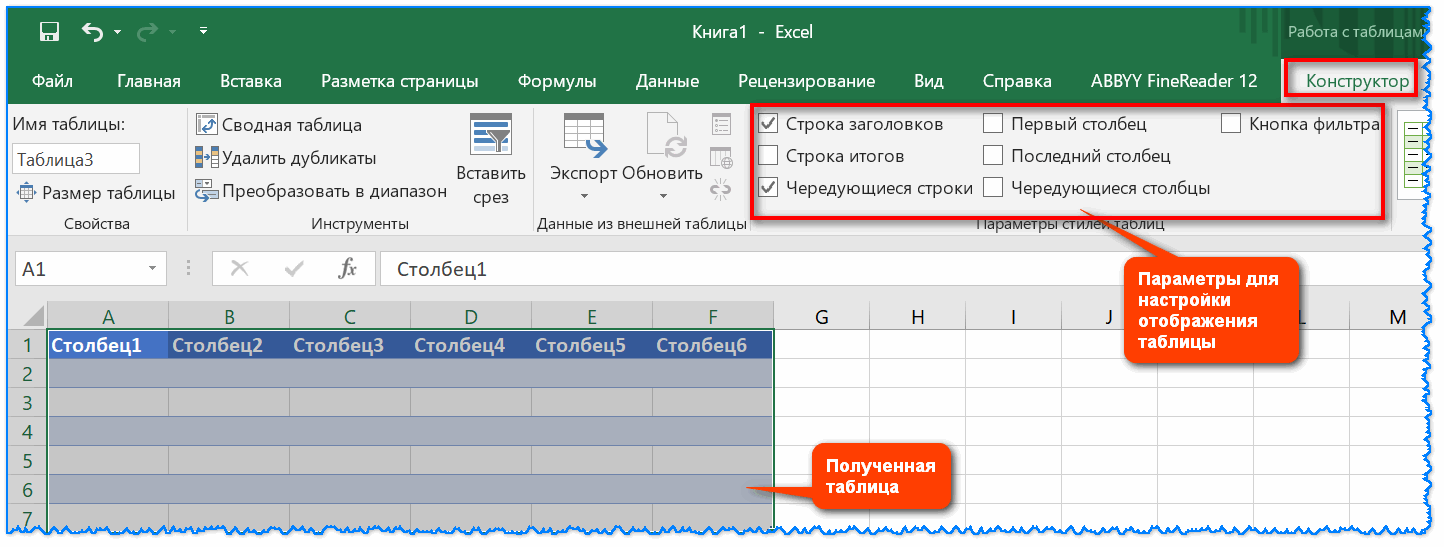

В апреле 2021 года Яндекс анонсировал запуск обновленного облачного сервиса «Яндекс.Диск» для работы с документами взамен Microsoft Office Online. Новый сервис использовал прежний интерфейс, как и раньше позволял работать с документами прямо в браузере. В отличие от прежней версии, появилась возможность совместной работы над документами.

Новый набор сервисов получил название «Яндекс 360». В основу разработки легло инструментальное решение российской компании «Р7-Офис» из Нижнего Новгорода. Офисный пакет «Р7-Офис» позиционировался как достойное альтернативное решение взамен наработок Microsoft. Он включал в себя редакторы документов, таблиц и презентаций.

Пакет «Р7-Офис» создавался как самостоятельное ответвление офисного пакета OnlyOffice (прежнее название — Teamlab). Его разработка велась нижегородской компанией «Новые коммуникационные технологии» с 2009 года. Но это был пакет офисных программ для локального применения. Он был ориентирован на госучреждения и для сферы образования.

Его разработка велась нижегородской компанией «Новые коммуникационные технологии» с 2009 года. Но это был пакет офисных программ для локального применения. Он был ориентирован на госучреждения и для сферы образования.

В конце 2018 года была выпущена серверная версия пакета «Р7-Офис». В нем появились инструменты для совместной работы онлайн, почта, календарь и корпоративная соцсеть. Одновременно компания подала заявку на включение разработки в реестр отечественного ПО. Тогда же Яндекс принял решение о переходе на новый инструмент взамен Microsoft Office Online.

Локальный сбой в Яндексе или проблемы роста «Р7-Офис»?

Яндекс не отреагировал на вчерашний инцидент с недоступностью функции работы с документами сервиса «Яндекс.Диск». Упоминание в заголовке «Microsoft Word» могло указывать, что компания могла столкнуться с проблемой масштабирования «Р7-Офис».

Разработчик «Р7-Офис» не дает информацию о возможностях своего пакета. Неизвестно ничего о проведенных им стресс-тестах. По всей видимости, доработка «Р7-Офис» по масштабированию выполнялась силами «Яндекс». Очевидно, что задача была успешно решена к апрелю 2021 года, когда состоялся анонс нового решения.

По всей видимости, доработка «Р7-Офис» по масштабированию выполнялась силами «Яндекс». Очевидно, что задача была успешно решена к апрелю 2021 года, когда состоялся анонс нового решения.

После 24 февраля многое изменилось в стране. После ухода из российского сегмента мировых брендов пользователи могли «испугаться» отключения популярного в России облачного инструмента Google.Docs и резко перейти на работу с «Яндекс.Диск».

В новых условиях Яндексу пришлось бы столкнуться с проблемой масштабирования своего сервиса. Возникшая ошибка могла стать причиной отказа «Р7-Офис», который мог не выдержать возросшего наплыва клиентов. Это могло заставить Яндекс отказаться от российского решения и временно (или постоянно) вернуться на Microsoft Office Online, пока ведется доработка «Р7-Офис».

Это – возможная версия случившегося. К сожалению, «Яндекс» не давал своих комментариев по инциденту, которые могли бы опровергнуть данную версию.

Автор: Игорь Новиков.

Тематики: Web

Ключевые слова: Яндекс, Microsoft, облачные услуги

Свежее по теме

ВТБ Онлайн стал лидером в рейтинге лучших банковских веб-приложений

Гуд лак хэв фан: начались съемки молодежного сериала о киберспорте «Политех»

МТС объявляет о партнерстве с сервисом ментального здоровья Meditopia

Один штраф помножился на два

Загрузить данные из Яндекса в Excel Power Query

Что такое Яндекс?

Яндекс — ведущая интернет-компания в России, предоставляющая различные онлайн-услуги, такие как поиск, электронная почта и электронная коммерция. Многие корпоративные компании пользуются рекламной платформой Яндекса, Яндекс.Директ, для целевых рекламных кампаний и анализа эффективности. Используя данные Яндекса, эти компании могут оптимизировать свои маркетинговые усилия и добиться лучших результатов.

Многие корпоративные компании пользуются рекламной платформой Яндекса, Яндекс.Директ, для целевых рекламных кампаний и анализа эффективности. Используя данные Яндекса, эти компании могут оптимизировать свои маркетинговые усилия и добиться лучших результатов.

Что такое Excel Power Query?

Excel Power Query — это расширенный инструмент преобразования данных для Microsoft Excel. Это позволяет корпоративным компаниям подключать, извлекать, очищать и манипулировать данными из нескольких источников. С помощью Excel Power Query предприятия могут анализировать большие наборы данных, создавать настраиваемые отчеты и принимать обоснованные решения на основе данных в режиме реального времени. Интеграция данных Яндекса в Excel Power Query может обеспечить глубокое понимание эффективности маркетинга и способствовать развитию бизнеса.

Подключение Яндекса к Excel Power Query

Чтобы подключить Яндекс к Excel Power Query, выполните следующие действия:

- Создайте учетную запись Яндекс.

Директа и настройте доступ к API

Директа и настройте доступ к API - Получите учетные данные API Яндекс.Директа (Client ID, Client Secret и Token)

- Откройте Excel и перейдите на вкладку Данные

- Нажмите «Получить данные» и выберите «Из других источников»

- Выберите «Из Интернета»

- Введите URL-адрес конечной точки API Яндекса и укажите свои учетные данные API

- Используйте редактор Power Query для фильтрации, сортировки и обработки данных Яндекса по мере необходимости

- Загрузите преобразованные данные в Excel для дальнейшего анализа и визуализации.

- Рассмотрите возможность использования коннектора данных, такого как Improvado, чтобы упростить процесс извлечения и загрузки данных. Альтернативным решением является использование Improvado, мощной платформы маркетинговой аналитики, которая автоматизирует весь поток данных, от извлечения до визуализации.

Подключение Яндекса к Excel Power Query с помощью Improvado

Improvado — идеальное решение для подключения Яндекса к Excel Power Query благодаря своим надежным функциям и возможностям.

С Improvado вы можете легко извлекать данные из Яндекса и загружать их в Excel Power Query без ручного вмешательства. Платформа поддерживает широкий спектр метрик и измерений, которые могут быть автоматически извлечены из Яндекса, обеспечивая всесторонний и точный анализ.

С Improvado вы можете легко извлекать данные из Яндекса и загружать их в Excel Power Query без ручного вмешательства. Платформа поддерживает широкий спектр метрик и измерений, которые могут быть автоматически извлечены из Яндекса, обеспечивая всесторонний и точный анализ.Кроме того, Improvado предлагает варианты настройки, которые позволяют пользователям создавать собственные показатели и параметры в соответствии со своими конкретными потребностями. Его способность обрабатывать большие объемы данных и централизовать данные о маркетинге и продажах обеспечивает бесперебойную и эффективную передачу данных для корпоративных компаний. Кроме того, поддержка клиентов Improvado является первоклассной, предоставляя помощь и рекомендации на протяжении всего процесса подключения к данным.

Теперь мы полностью полагаемся на Improvado для нескольких информационных панелей, которые мы используем для повседневных маркетинговых операций и стратегии, а также для презентаций для высшего руководства.

Краткий обзор подключения Яндекса к Excel Power Query

Таким образом, подключение Яндекса и Excel Power Query — это отличный способ для корпоративных компаний получить ценную информацию о своей маркетинговой эффективности. Используя Improvado, предприятия могут сэкономить время, усилия и ресурсы, получая выгоду от масштабируемого, настраиваемого решения, которое занимается извлечением, преобразованием и визуализацией данных. Improvado предлагает качественную поддержку клиентов, возможность обработки больших объемов данных и централизованную платформу для управления данными о маркетинге и продажах. Чтобы узнать больше о том, как Improvado может помочь вашему бизнесу, закажите звонок с экспертом сегодня.

Поисковые роботы — 10 самых популярных

Бен Итон

Обновлено 16 декабря 2022 г.

Во всемирной паутине есть как плохие, так и хорошие боты. Вы определенно хотите избежать плохих ботов, поскольку они потребляют вашу пропускную способность CDN, занимают ресурсы сервера и крадут ваш контент.

С другой стороны, с хорошими ботами (также известными как поисковые роботы) следует обращаться с осторожностью, поскольку они являются жизненно важной частью индексации вашего контента поисковыми системами, такими как Google, Bing и Yahoo. В этом сообщении блога мы рассмотрим десятку самых популярных поисковых роботов.

С другой стороны, с хорошими ботами (также известными как поисковые роботы) следует обращаться с осторожностью, поскольку они являются жизненно важной частью индексации вашего контента поисковыми системами, такими как Google, Bing и Yahoo. В этом сообщении блога мы рассмотрим десятку самых популярных поисковых роботов.Что такое поисковые роботы?

Веб-сканеры — это компьютерные программы, которые методично и автоматически просматривают Интернет. Их также называют роботами, муравьями или пауками.

Поисковые роботы посещают веб-сайты и читают их страницы и другую информацию, чтобы создать записи для индекса поисковой системы. Основная цель поискового робота — предоставить пользователям полный и актуальный индекс всего доступного онлайн-контента.

Кроме того, поисковые роботы также могут собирать определенные типы информации с веб-сайтов, например контактную информацию или данные о ценах. Используя поисковые роботы, компании могут поддерживать актуальность и эффективность своего присутствия в Интернете (например, SEO, оптимизация внешнего интерфейса и веб-маркетинг).

Поисковые системы, такие как Google, Bing и Yahoo, используют сканеры для правильного индексирования загруженных страниц, чтобы пользователи могли быстрее и эффективнее находить их при поиске. Без поисковых роботов не было бы ничего, что могло бы сказать им, что на вашем сайте есть новый и свежий контент. Карты сайта также могут играть роль в этом процессе. Так что поисковые роботы, по большей части, это хорошо.

Однако иногда возникают проблемы с планированием и загрузкой, поскольку поисковый робот может постоянно опрашивать ваш сайт. И здесь в игру вступает файл robots.txt. Этот файл может помочь контролировать сканирующий трафик и гарантировать, что он не перегрузит ваш сервер.

Поисковые роботы идентифицируют себя для веб-сервера с помощью заголовка запроса

User-Agentв HTTP-запросе, и каждый сканер имеет свой уникальный идентификатор. В большинстве случаев вам нужно будет просматривать журналы реферера вашего веб-сервера, чтобы просмотреть трафик поискового робота.

Robots.txt

Поместив файл robots.txt в корень вашего веб-сервера, вы можете определить правила для поисковых роботов, например разрешить или запретить сканирование определенных ресурсов. Поисковые роботы должны следовать правилам, определенным в этом файле. Вы можете применить общие правила ко всем ботам или сделать их более детализированными и указать их конкретные

User-Agentстрока.Пример 1

Этот пример предписывает всем роботам поисковых систем не индексировать содержимое веб-сайта. Это определяется путем запрета доступа к корневому каталогу

Агент пользователя: * Запретить: /

Пример 2

В этом примере достигается противоположность предыдущему. В этом случае инструкции по-прежнему применяются ко всем пользовательским агентам. Однако в инструкции Disallow ничего не определено, а это означает, что все может быть проиндексировано.

Агент пользователя: * Запретить:

Чтобы увидеть больше примеров, обязательно ознакомьтесь с нашим подробным сообщением о том, как использовать файл robots.

txt.

txt.10 лучших поисковых роботов и поисковых роботов

В Интернете прочесывают сотни поисковых роботов и поисковых роботов, но ниже приведен список из 10 популярных поисковых роботов и поисковых роботов, которые мы собрали на основе тех, которые мы регулярно видим в журналах нашего веб-сервера.

1. GoogleBot

Являясь крупнейшей в мире поисковой системой, Google использует поисковые роботы для индексации миллиардов страниц в Интернете. Googlebot — это поисковый робот, который Google использует именно для этого.

Googlebot — это два типа поисковых роботов: настольный поисковый робот, который имитирует человека, просматривающего компьютер, и мобильный поисковый робот, который выполняет те же функции, что и iPhone или телефон Android.

Строка пользовательского агента запроса может помочь вам определить подтип Googlebot. Googlebot Desktop и Googlebot Smartphone, скорее всего, будут сканировать ваш веб-сайт. С другой стороны, оба типа сканеров принимают один и тот же токен продукта (токен пользовательского агента) в файле robots.

txt. Вы не можете использовать robots.txt для выборочного таргетинга Googlebot Smartphone или Desktop.

txt. Вы не можете использовать robots.txt для выборочного таргетинга Googlebot Smartphone или Desktop.Googlebot — очень эффективный поисковый робот, который может быстро и точно индексировать страницы. Однако у него есть некоторые недостатки. Например, робот Googlebot не всегда сканирует все страницы веб-сайта (особенно если веб-сайт большой и сложный).

Кроме того, робот Googlebot не всегда сканирует страницы в режиме реального времени, а это означает, что некоторые страницы могут быть проиндексированы только через несколько дней или недель после их публикации.

User-AgentGooglebot

Полный

User-AgentstringMozilla/5.0 (совместимый; Googlebot/2.1; +http://www.google.com/bot.html)

Пример робота Googlebot в файле robots.txt

В этом примере заданные инструкции немного более детализированы. Здесь инструкции относятся только к Googlebot. В частности, он говорит Google не индексировать определенную страницу (

/no-index/your-page.). html

html Агент пользователя: Googlebot Запретить: /no-index/your-page.html

Кроме сканера веб-поиска Google, на самом деле у них есть 9дополнительные поисковые роботы:

Поисковый робот User-AgentstringGooglebot News Googlebot-New s Googlebot Images Googlebot-Image/1.0 Googlebot Video Googlebot-Video/1.0 Google Mobile (feat. телефон) SAMSUNG-SGH-E250/1.0 Profile/MIDP-2.0 Configuration/CLDC-1.1 UP.Browser/6.2.3.3.c.1.101 (GUI) MMP/2.0 (совместимый; Googlebot-Mobile/2.1; +http://www.google.com/bot.html) Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, например Gecko) Chrome/41.0.2272.96 Mobile Safari/537.36 (совместимый; Googlebot) /2.1; +http://www.google.com/bot.html) Google Mobile Adsense (совместимо; Mediapartners-Google/2.  1; +http://www.google.com/bot.html)

1; +http://www.google.com/bot.html)Google Adsense 90 150 Mediapartners-GoogleGoogle AdsBot (качество целевой страницы PPC) AdsBot-Google (+http://www.google.com/adsbot.html) Поисковый робот Google (извлечение ресурсов для мобильных устройств) AdsBot-Google-Mobile-Apps Вы можете использовать инструмент Fetch в Google Search Console, чтобы проверить, как Google сканирует или отображает URL-адрес на вашем сайте. Узнайте, может ли робот Googlebot получить доступ к странице на вашем сайте, как он отображает страницу и заблокированы ли какие-либо ресурсы страницы (например, изображения или сценарии) для робота Googlebot.

Вы также можете просмотреть статистику сканирования Googlebot за день, количество загруженных килобайт и время, затраченное на загрузку страницы.

См. документацию robots.txt для робота Google.

2. Bingbot

Bingbot — это поисковый робот, развернутый Microsoft в 2010 году для предоставления информации их поисковой системе Bing.

Это замена того, что раньше было ботом MSN.

Это замена того, что раньше было ботом MSN.User-AgentBingbot

Полный

User-AgentstringMozilla/5.0 (совместимый; Bingbot/2.0; +http://www.bing.com/bingbot.htm)

У Bing также есть очень похожий на Google инструмент, называемый Fetch as Bingbot, в Инструментах для веб-мастеров Bing. Fetch As Bingbot позволяет запросить сканирование страницы и показать ее вам так, как ее увидит наш сканер. Вы увидите код страницы так, как его увидит Bingbot, что поможет вам понять, видят ли они вашу страницу так, как вы предполагали.

См. документацию Bingbot robots.txt.

3. Slurp Bot

Результаты поиска Yahoo поступают от поискового робота Yahoo Slurp и поискового робота Bing, так как многие Yahoo работают на базе Bing. Сайты должны разрешать доступ Yahoo Slurp, чтобы они отображались в результатах поиска Yahoo Mobile.

Кроме того, Slurp делает следующее:

- Собирает контент с партнерских сайтов для включения в такие сайты, как Yahoo News, Yahoo Finance и Yahoo Sports.

- Доступ к страницам сайтов в Интернете для подтверждения точности и улучшения персонализированного контента Yahoo для наших пользователей.

User-AgentSlurp

Полный

User-AgentstringMozilla/5.0 (совместимый; Yahoo! Slurp; http://help.yahoo.com/help/us/ysearch/slurp)

См. документацию Slurp robots.txt.

4. DuckDuckBot

DuckDuckBot — это веб-сканер для DuckDuckGo, поисковой системы, которая стала довольно популярной, поскольку известна своей конфиденциальностью и отсутствием слежки за вами. Теперь он обрабатывает более 93 миллионов запросов в день. DuckDuckGo получает результаты из разных источников. К ним относятся сотни вертикальных источников, предоставляющих нишевые мгновенные ответы, DuckDuckBot (их поисковый робот) и краудсорсинговые сайты (Википедия). У них также есть более традиционные ссылки в результатах поиска, которые они получают от Yahoo! и Бинг.

Агент пользователяDuckDuckBot

Полный

User-AgentстрокаDuckDuckBot/1.

0; (+http://duckduckgo.com/duckduckbot.html)

0; (+http://duckduckgo.com/duckduckbot.html)

Он соответствует WWW::RobotRules и происходит со следующих IP-адресов:

- 72.94.249.34

- 72.94.249.35

- 72.94.249.36 90 016 72.94.249.37

- Собирает контент с партнерских сайтов для включения в такие сайты, как Yahoo News, Yahoo Finance и Yahoo Sports.

- 72.94.249.38

5. Baiduspider

Baiduspider — официальное название поисковой системы китайской Baidu. Он сканирует веб-страницы и возвращает обновления в индекс Baidu. Baidu — ведущая китайская поисковая система, на долю которой приходится 80% всего рынка поисковых систем материкового Китая.

Агент пользователя Baiduspider

Полный

User-Agent stringMozilla/5.0 (совместимый; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)

Помимо поискового робота Baidu, у них есть еще 6 поисковых роботов:

| Поисковый робот | User-Agent string | Поиск изображений | Baiduspider-image |

|---|---|---|

| Поиск видео | Baiduspider-video | |

| Поиск новостей | Baiduspider-новости | |

| Списки желаний Baidu | Baiduspider-favo 90 | Baiduspider-ads |

| Другие поисковые страницы | 9 0150 Baiduspider

См. документацию Baidu robots.txt.

документацию Baidu robots.txt.

6. Яндекс Бот

YandexBot — поисковый робот для одной из крупнейших российских поисковых систем Яндекс.

User-Agent ЯндексБот

Full

User-Agent stringMozilla/5.0 (совместимо; YandexBot/3.0; +http://yandex.com/bots)

Существует множество различных строк User-Agent, которые ЯндексБот может отображать в логах вашего сервера.

7. Sogou Spider

Sogou Spider — поисковый робот для Sogou.com, ведущей китайской поисковой системы, запущенной в 2004 году.

Примечание: Веб-паук Sogou не соблюдает стандарт исключения роботов и поэтому запрещен на многих веб-сайтах из-за чрезмерного сканирования.

User-Agent Sogou Pic Spider/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Головной паук Sogou/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Веб-паук Sogou/4.0 (+http://www.sogou.com/docs/help/webmasters.htm#07) Паук Sogou Orion/3.0 (http://www.sogou.com/docs/help/webmasters.htm#07) Sogou-Test-Spider/4.0 (совместимый; MSIE 5.5; Windows 98)

8. Exabot

Exabot — поисковый робот для Exalead, поисковой системы, базирующейся во Франции. Он был основан в 2000 году и имеет более 16 миллиардов проиндексированных страниц.

User-Agent Mozilla/5.0 (совместимый; Konqueror/3.5; Linux) KHTML/3.5.5 (как Gecko) (Exabot-Thumbnails) Mozilla/5.0 (совместимо; Exabot/3.0; +http://www.exabot.com/go/robot)

См. документацию Exabot robots.txt.

9. Facebook external hit

Facebook позволяет своим пользователям отправлять ссылки на интересный веб-контент другим пользователям Facebook. Часть того, как это работает в системе Facebook, включает временное отображение определенных изображений или деталей, связанных с веб-контентом, таких как название веб-страницы или встроенный тег видео. Система Facebook извлекает эту информацию только после того, как пользователь предоставит ссылку.

Одним из основных сканирующих ботов является Facebot, предназначенный для повышения эффективности рекламы.

User-Agent фейсбот facebookexternalhit/1.0 (+http://www.facebook.com/externalhit_uatext.php) facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)

См. документацию Facebot robots.txt.

10. Applebot

Бренд компьютерных технологий Apple использует поисковый робот Applebot, в частности Siri и Spotlight Suggestions, для предоставления персонализированных услуг своим пользователям.

User-Agent Applebot

Полный

User-Agent stringMozilla/5.0 (Device; OS_version) AppleWebKit/WebKit_version (KHTML, как Gecko) Версия/Safari_версия Safari/WebKit_версия (Applebot/Applebot_version)

Другие популярные поисковые роботы

Apache Nutch

Apache Nutch — поисковый робот с открытым исходным кодом, написанный на Java. Он выпущен под лицензией Apache и управляется Apache Software Foundation.

Nutch может работать на одной машине, но чаще используется в распределенной среде. На самом деле, Nutch был разработан с нуля, чтобы быть масштабируемым и легко расширяемым.

Он выпущен под лицензией Apache и управляется Apache Software Foundation.

Nutch может работать на одной машине, но чаще используется в распределенной среде. На самом деле, Nutch был разработан с нуля, чтобы быть масштабируемым и легко расширяемым.

Орех очень гибкий и может использоваться для различных целей. Например, Nutch можно использовать для сканирования всего Интернета или только определенных веб-сайтов. Кроме того, Nutch можно настроить на индексацию страниц в режиме реального времени или по расписанию.

Одним из основных преимуществ Apache Nutch является его масштабируемость. Nutch можно легко масштабировать для обработки больших объемов данных и трафика. Например, большой веб-сайт электронной коммерции может использовать Apache Nutch для сканирования и индексации своего каталога продуктов. Это позволит клиентам искать продукты на своем веб-сайте с помощью внутренней поисковой системы компании.

Кроме того, Apache Nutch можно использовать для сбора данных о веб-сайтах. Компании могут использовать Apache Nutch для сканирования веб-сайтов конкурентов и сбора информации об их продуктах, ценах и контактной информации. Затем эта информация может быть использована для улучшения их присутствия в Интернете.

Однако у Apache Nutch есть некоторые недостатки. Например, это может быть сложно настроить и использовать. Кроме того, Apache Nutch не так широко используется, как другие поисковые роботы, а это означает, что для него доступна меньшая поддержка.

Компании могут использовать Apache Nutch для сканирования веб-сайтов конкурентов и сбора информации об их продуктах, ценах и контактной информации. Затем эта информация может быть использована для улучшения их присутствия в Интернете.

Однако у Apache Nutch есть некоторые недостатки. Например, это может быть сложно настроить и использовать. Кроме того, Apache Nutch не так широко используется, как другие поисковые роботы, а это означает, что для него доступна меньшая поддержка.

Screaming Frog

Screaming Frog SEO Spider — это настольная программа (ПК или Mac), которая сканирует ссылки, изображения, CSS, скрипты и приложения веб-сайтов с точки зрения SEO.

Он извлекает ключевые элементы сайта для SEO, представляет их на вкладках по типам и позволяет вам фильтровать общие проблемы SEO или нарезать данные так, как вам нравится, экспортируя их в Excel.

Вы можете просматривать, анализировать и фильтровать данные сканирования по мере их сбора и извлечения в режиме реального времени с помощью простого интерфейса.

Программа бесплатна для небольших сайтов (до 500 URL). Для больших сайтов требуется лицензия.

Screaming Frog использует Chromium WRS для обхода динамических веб-сайтов с большим количеством JavaScript, таких как Angular, React и Vue.js. Создание карты сайта WordPress, извлечение XPath и визуализация архитектуры сайта — другие важные функции.

Платформа обслуживает такие корпорации, как Apple, Amazon, Disney и даже Google. Screaming Frog также является популярным инструментом среди владельцев агентств и SEO-специалистов, которые управляют SEO для нескольких клиентов.

Deepcrawl

Deepcrawl — это облачный поисковый робот, который позволяет пользователям сканировать веб-сайты и собирать данные об их структуре, содержании и производительности.

DeepCrawl предоставляет пользователям несколько функций и опций, включая возможность сканирования веб-сайтов на основе JavaScript, настройку процесса сканирования и создание подробных отчетов.

Одной из самых уникальных функций Deepcrawl является его способность сканировать веб-сайты, созданные с помощью JavaScript. Это возможно, потому что Deepcrawl использует безголовый браузер (например, Chrome) для отображения содержимого веб-сайта перед его сканированием.

Это возможно, потому что Deepcrawl использует безголовый браузер (например, Chrome) для отображения содержимого веб-сайта перед его сканированием.

Это означает, что Deepcrawl может сканировать и собирать данные о веб-сайтах, которые не всегда могут быть доступны другим поисковым роботам.

Помимо гибких API, данные Deepcrawl интегрируются с Google Analytics, Google Search Console и другими популярными инструментами. Это позволяет пользователям легко сравнивать данные своего веб-сайта с данными конкурентов. Это также позволяет им связывать бизнес-данные (например, данные о продажах) с данными своего веб-сайта, чтобы получить полное представление о том, как работает их веб-сайт.

Deepcrawl лучше всего подходит для компаний с большими веб-сайтами с большим количеством контента и страниц. Платформа менее подходит для небольших веб-сайтов или тех, которые не меняются очень часто.

Deepcrawl предлагает три разных продукта:

- Центр автоматизации: этот продукт интегрируется с конвейером CI/CD и автоматически сканирует ваш веб-сайт с более чем 200 правилами тестирования SEO QA.

- Центр аналитики: этот продукт позволяет вам получать полезную информацию из данных вашего веб-сайта и улучшать SEO вашего веб-сайта.

- Концентратор мониторинга: этот продукт отслеживает изменения на вашем веб-сайте и предупреждает вас о появлении новых проблем.

Предприятия используют эти три продукта для улучшения SEO своего веб-сайта, отслеживания изменений и сотрудничества с командами разработчиков.

Octoparse

Octoparse — это удобное клиентское программное обеспечение для сканирования веб-страниц, которое позволяет извлекать данные со всего Интернета. Программа специально разработана для людей, не являющихся программистами, и имеет простой интерфейс «укажи и щелкни».

С Octoparse вы можете запускать запланированные облачные извлечения для извлечения динамических данных, создавать рабочие процессы для автоматического извлечения данных с веб-сайтов и использовать его API парсинга веб-страниц для доступа к данным.

Его прокси-серверы IP позволяют сканировать веб-сайты без блокировки, а встроенная функция Regex автоматически очищает данные.

А благодаря готовым шаблонам скрейпера вы можете начать извлекать данные с популярных веб-сайтов, таких как Yelp, Google Maps, Facebook и Amazon, за считанные минуты. Вы также можете создать свой собственный парсер, если его нет в наличии для ваших целевых веб-сайтов.

HTTrack

Вы можете использовать бесплатное ПО HTTrack для загрузки целых сайтов на свой компьютер. Благодаря поддержке Windows, Linux и других систем Unix этот инструмент с открытым исходным кодом может использоваться миллионами.

Средство копирования веб-сайтов HTTrack позволяет загружать веб-сайты на компьютер, чтобы вы могли просматривать их в автономном режиме. Программу также можно использовать для зеркалирования веб-сайтов, что означает, что вы можете создать точную копию веб-сайта на своем сервере.

Программа проста в использовании и имеет множество функций, в том числе возможность возобновлять прерванные загрузки, обновлять существующие веб-сайты и создавать статические копии динамических веб-сайтов.

Вы можете получить файлы, фотографии и HTML-код с зеркального веб-сайта и возобновить прерванную загрузку.

Хотя HTTrack можно использовать для загрузки веб-сайтов любого типа, он особенно полезен для загрузки веб-сайтов, которые больше не доступны в сети.

HTTrack — отличный инструмент для всех, кто хочет загрузить веб-сайт целиком или создать его зеркальную копию. Однако следует отметить, что программу можно использовать для загрузки нелегальных копий веб-сайтов.

Таким образом, вы должны использовать HTTrack только в том случае, если у вас есть разрешение от владельца веб-сайта.

SiteSucker

SiteSucker — это приложение для macOS, которое загружает веб-сайты. Он асинхронно копирует веб-страницы сайта, изображения, PDF-файлы, таблицы стилей и другие файлы на ваш локальный жесткий диск, дублируя структуру каталогов сайта.

Вы также можете использовать SiteSucker для загрузки определенных файлов с веб-сайтов, таких как файлы MP3.

Программу можно использовать для создания локальных копий веб-сайтов, что делает ее идеальной для просмотра в автономном режиме.

Это также полезно для загрузки целых сайтов, чтобы вы могли просматривать их на своем компьютере без подключения к Интернету.

Одним из недостатков SiteSucker является то, что он не может работать с Javascript (хотя может работать с Flash). Тем не менее, он по-прежнему полезен для загрузки веб-сайтов на ваш Mac.

Webz.io

Пользователи могут использовать веб-приложение Webz.io для получения данных в режиме реального времени путем сканирования онлайн-источников по всему миру в различных удобных форматах. Этот поисковый робот позволяет вам сканировать данные и извлекать ключевые слова на нескольких языках на основе многочисленных критериев из различных источников.

Архив позволяет пользователям получать доступ к историческим данным. Пользователи могут легко индексировать и искать структурированные данные, просканированные Webhose, используя его интуитивно понятный интерфейс/API. Вы можете сохранять очищенные данные в форматах JSON, XML и RSS. Кроме того, Webz.io поддерживает до 80 языков с результатами сканирования данных.

Вы можете сохранять очищенные данные в форматах JSON, XML и RSS. Кроме того, Webz.io поддерживает до 80 языков с результатами сканирования данных.

Бизнес-модель Webz.io freemium должна подойти для предприятий с базовыми требованиями к сканированию. Для предприятий, которым требуется более надежное решение, Webz.io также предлагает поддержку мониторинга СМИ, угроз кибербезопасности, анализа рисков, финансового анализа, веб-аналитики и защиты от кражи личных данных.

Они даже поддерживают решения API даркнета для бизнес-аналитики.

UiPath

UiPath — это приложение Windows, которое можно использовать для автоматизации повторяющихся задач. Это полезно для парсинга веб-страниц, поскольку оно может автоматически извлекать данные с веб-сайтов.

Программа проста в использовании и не требует знаний в области программирования. Он имеет визуальный интерфейс перетаскивания, который упрощает создание сценариев автоматизации.

С помощью UiPath вы можете извлекать табличные данные и данные на основе шаблонов с веб-сайтов, PDF-файлов и других источников. Программу также можно использовать для автоматизации таких задач, как заполнение онлайн-форм и загрузка файлов.

Программу также можно использовать для автоматизации таких задач, как заполнение онлайн-форм и загрузка файлов.

Коммерческая версия инструмента предоставляет дополнительные возможности сканирования. При работе со сложными пользовательскими интерфейсами этот подход очень эффективен. Инструмент очистки экрана может извлекать данные из таблиц как по отдельным словам, так и по группам текста, а также по блокам текста, таким как RSS-каналы.

Кроме того, вам не нужны навыки программирования для создания интеллектуальных веб-агентов, но если вы хакер .NET, вы сможете полностью контролировать их данные.

Плохие боты

Хотя большинство поисковых роботов безопасны, некоторые из них могут использоваться в злонамеренных целях. Эти вредоносные веб-сканеры, или «боты», могут использоваться для кражи информации, проведения атак и совершения мошенничества. Также все чаще обнаруживается, что эти боты игнорируют директивы robots.txt и переходят непосредственно к сканированию веб-сайтов.

Некоторые известные плохие боты перечислены ниже:

- PetalBot

- SEMrushBot

- Majestic

- DotBot

- AhrefsBot

Защита вашего сайта от вредоносных поисковых роботов

Чтобы защитить свой сайт от вредоносных ботов, вы можете использовать брандмауэр веб-приложений (WAF) для защиты вашего сайта от ботов и других угроз. WAF — это часть программного обеспечения, которое находится между вашим веб-сайтом и Интернетом и фильтрует трафик до того, как он попадет на ваш сайт.

CDN также может помочь защитить ваш сайт от ботов. CDN — это сеть серверов, которые доставляют контент пользователям в зависимости от их географического положения.

Когда пользователь запрашивает страницу с вашего веб-сайта, CDN направляет запрос на сервер, ближайший к местоположению пользователя. Это может помочь снизить риск атаки ботов на ваш сайт, поскольку им придется нацеливаться на каждый сервер CDN в отдельности.

У KeyCDN есть отличная функция, которую вы можете включить на своей панели инструментов, которая называется «Блокировать плохих ботов».